图片|OpenAI官网

图片|OpenAI官网

©自象限原创

作者丨罗辑、程心

和OpenAI分道扬镳以后,Ilya“神秘而伟大”的事业终于揭开了面纱。

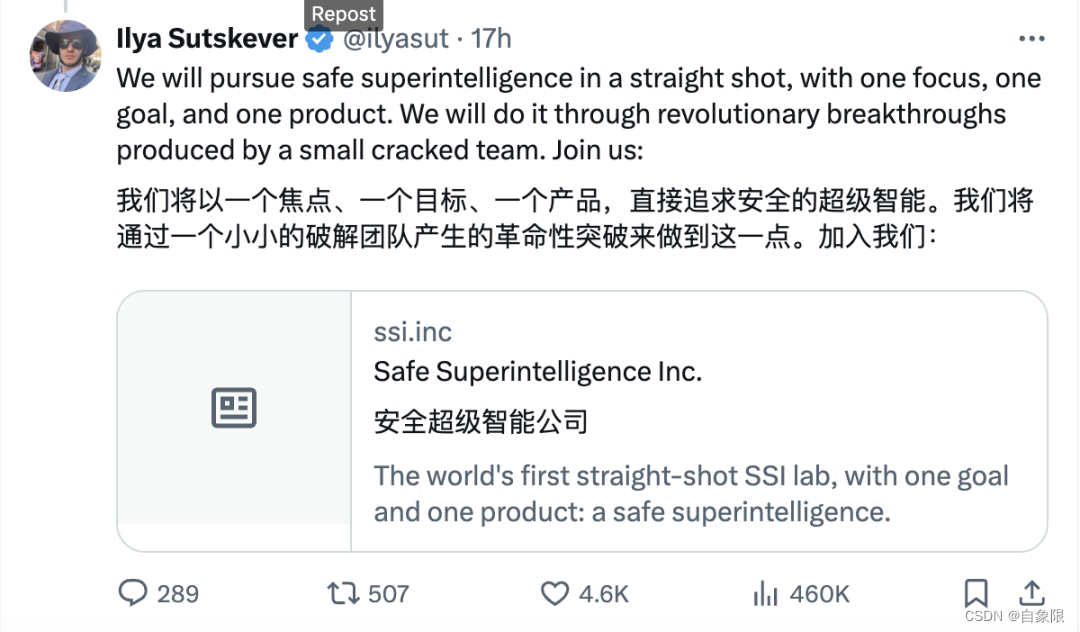

6月20日,前OpenAI核心创始人 Ilya Stuskever,在官宣离职一个月后,Ilya在社交媒体平台公开了最新的动向:将成立新的实验室Superintellgence(以下简称SSI),构建安全的超级智能。

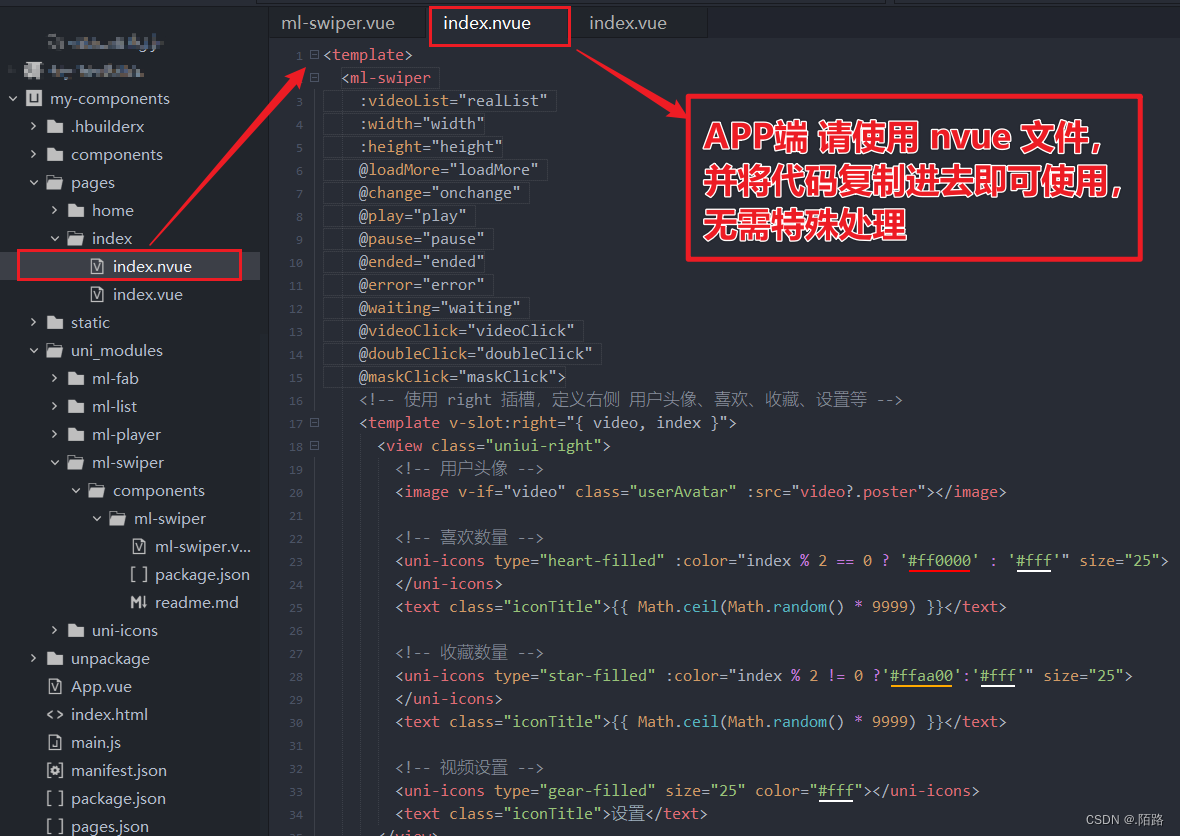

▲图源:社交媒体X截图

这个名,明眼人一看就知道是冲着OpenAI去的。

2023年12月,在OpenAI十年的Ilya官宣离职引起了整个AI圈的轩然大波。虽然离职的具体原因扑朔迷离,但在Ilya离职前后,OpenAI负责模型安全的由Ilya主导的超级对齐(Superalignment)实验室宣布解散,外界纷纷推测,Ilya一直以来的理念是谨慎地发展人工智能,与Altman大刀阔斧地推进技术的战略相左。

而SSI,首先坚持了OpenAI成为非营利组织独立实验室的初衷,其次践行了Ilya一直以来对模型安全的谨慎态度。并且Ilya还补充道:我们将以一个焦点、一个目标、一个产品,直接追求安全的超级智能。

▲图源:社交媒体X截图

截至发稿前,Sam Altman并未回应,并没有让吃瓜群众们预想的“Altman假惺惺的表示祝福”成真。

而之所以业内如此重视Ilya在这个节点成立SSI,并不只是因为这个人,更是大模型的发展已经到了不得不重视模型安全的重要节点。

在刚刚过去的北京智源大会上,杨植麟、张鹏等一线创业者也曾讨论过这个问题,我们对模型安全的重视程度远远小于它的重要程度,而SSI的成立,或许会开辟一条与OpenAI完全相反的路。

用Ilya的眼睛,看AI的危险

似乎Ilya对模型安全是执拗的,甚至被人暗指“没必要”。“如果不是因为他是OpenAI的技术首脑,曾一手打造了GPT、DALLE-E等明星产品,SSI根本不会受到如此大的关注。”

但他们却忽略了,Ilya对人工智能技术的重要性,并不是从OpenAI开始的,而是从他的老师辛顿就奠定了他的话语权。

从80年代就开始战斗在人工智能最前线的辛顿,被誉为“深度学习之父”。作为教授的他桃李满天下(包括吴恩达),在他年轻一代的学生中,Ilya是最得意的门生之一。

▲图源:辛顿和Ilya合影

2023年5月初,辛顿辞去他在谷歌担任了十多年的职位,表示作出这个决定是为了可以自由讨论“人工智能的危险”。此后,他频繁接受媒体采访,不遗余力地对人工智能可能操纵人类发出警报。

尽管人类可以赋予人工智能一些伦理原则,但辛顿仍然感到紧张,“因为到目前为止,我还想象不到更智能的事物被一些没它们智能的事物所控制的例子。打个比方,假设青蛙创造了人类,那么你认为现在谁会占据主动权,是人,还是青蛙?”

师从辛顿的Ilya,几乎完全继承了被辛顿“蒸馏”过的,对于人工智能的谨慎,以及在谨慎之下的小心翼翼。

Ilya之于OpenAI,许多网友都认为他的个人贡献要大于Sam Altman。如果说SamAltman是OpenAI的面子,那Ilya就是OpenAI的里子,或者说是技术灵魂。

私底下的Ilya很内向但却并不胆怯。他之所以如此,很多人好奇,他作为影响这个世界技术变革的人,一定看到了什么。

但却没有人知道。

Ilya在OpenAI打造的超级对齐实验室,目的就是为了通过可控的技术手段使得AI发展的路径可控,确保AGI的发展符合人类利益。

一些前OpenAI员工透露,Ilya对超级对齐实验室的工作非常重视,并亲自参与其中。他希望通过这一实验室的工作,为未来的AGI系统设计出可靠的对齐方案。

想要理解何为“超级对齐”,就要演示一下现在的对齐技术,通过RHLF注入,能够实现两种对齐:一种是价值观的对齐:比如不要建立男女的性别对立、不要歧视同性恋等等;另一种是话题层面的对齐:明确国家的边界、不让搞黄色、不能诈骗等等。但Ilya所谓的超级对齐,却并不是这么简单。

有人还记得人工智能的三原则么?

其中之一便是“无条件服从人类”,而价值观和话题的对齐是远远不足以完成这个目标的,Ilya他认为技术的本质类似于人类的生物进化,如果进化的开始,是一个没有“无条件对人类的爱”的 AI,那等它长成AGI以后,也一定不可控。

对应了他在X中发表的:直接追求安全的超级智能。

没错,超级对齐的本质其实是通过让大模型产生“对人类无条件的爱”。

这听起来似乎很扯淡,但或许SSI的本质就是如此。

人,AI安全的最后一道防线

那么问题来了,大部分人做不到。

是的,可能大部分公司都是OpenAI而非SSI。那么除了大模型公司在内部致力于构建一个安全、可信的大模型之外,这两年随着技术和应用的发展,社会各界也对AI和大模型的安全作出了许多努力。

2021年11月,联合国教科文组织就曾通过《人工智能伦理问题建议书》,希望为人工智能的发展,以及预防其潜在风险提供建议。

今年3月份,联合国教科文组织总干事奥德蕾·阿祖莱还在公开呼吁,希望各国尽快实施这项建议,为人工智能发展设立伦理标准。

而随着中国AI大模型的蓬勃发展,中国企业也越来越多地参与到了这类国际AI安全准则的制定中。

比如今年4月在日内瓦召开的联合国科技大会上,世界数字技术院(WDTA)发布了《生成式人工智能应用安全测试标准》和《大语言模型安全测试方法》两项国际标准。

而这两项标准,由来自百度、腾讯、蚂蚁集团、科大讯飞等众多中国企业的专家学者共同参与编制而成。

在国际组织通过编制规范指导AI安全发展的同时,各地政府的法案也在相继落地。

5月21日,欧洲的《人工智能法案》正式获得了欧洲理事会的批准。这项法案最早由欧盟委员会在2021年提出,作为全球首个AI法案,它通过构建广泛适用的人工智能监管机制,为人工智能技术的发展提供了法律框架,为全球的AI监管提供了可借鉴的法律基础。

国内AI安全相关的政策则落地在2023年7月,国家网信办联合国家发改委、工信部等七部门,公布了《生成式人工智能服务管理暂行办法》,该办法就生成式人工智能可能面临的安全问题提出了一系列明确的约束规范。

当然,法律规定的社会的下限,大模型安全的上线仍然需要在产业界寻找答案。

我们前面提到,大模型在公司内部训练的过程中,需要通过数据、算法、学习框架等多个维度保证大模型的安全可靠。

但其实在公司外部,完成训练的大模型要推向市场,还存在一套由第三方完成的大模型安全测试评估框架,目前主流的安全性测评方法主要有固定数据集测评和红队模型测评两类。

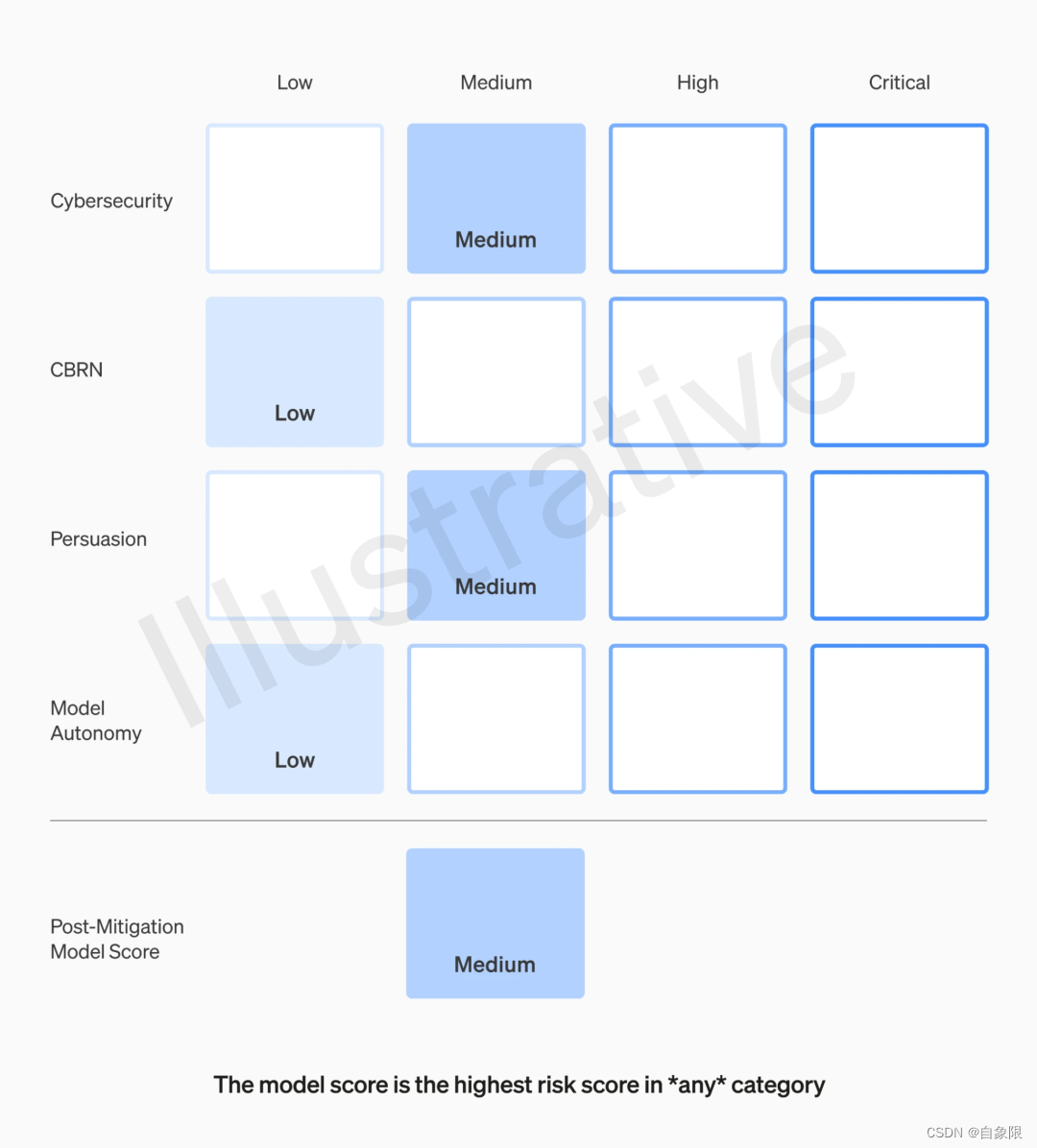

2023年,OpenAI在GPT-4发布之前就曾对其进行了六个多月的评估、测试及改进。在这轮测试中,OpenAI就邀请了AI领域专家参与红队测试(Red Teaming)以识别安全风险。

固定数据集测评,则是由研究人员针对大模型的各类安全风险制定风险评估矩阵,类似绩效考核打分。

研究人员通过人类标注数据的方式采集安全性评估数据,然后以测试模型在这些数据集上的表现评估模型的安全程度。

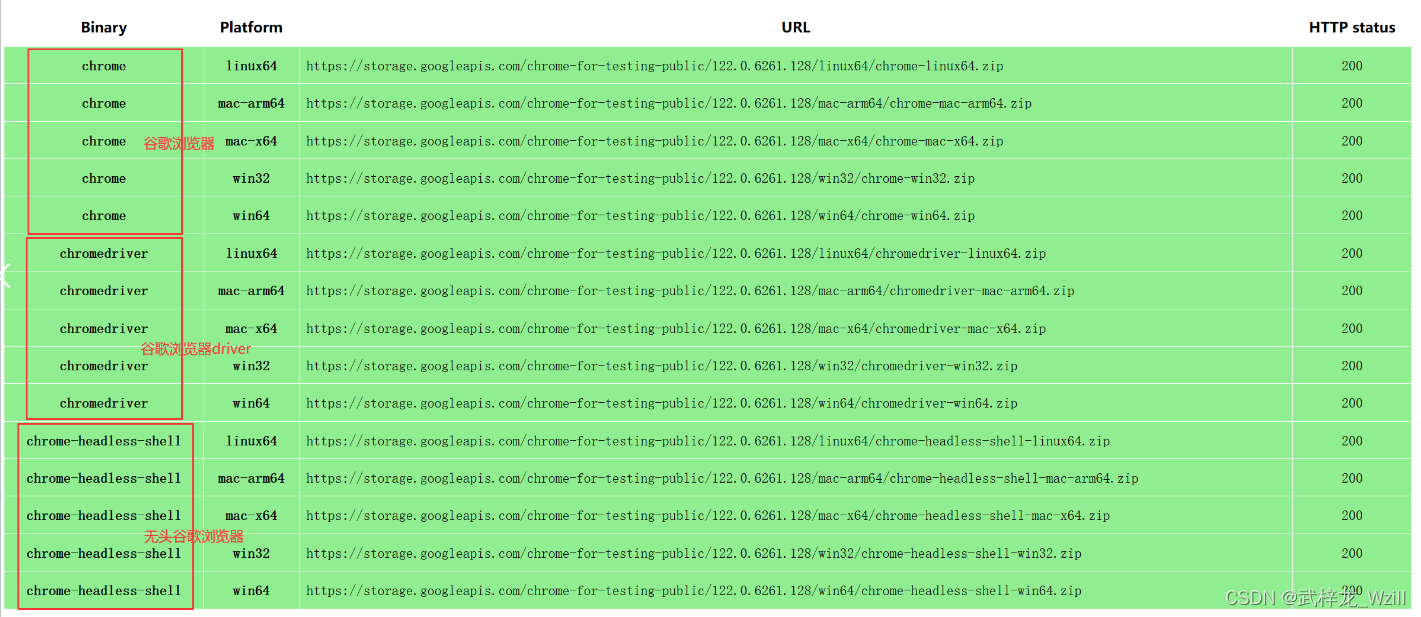

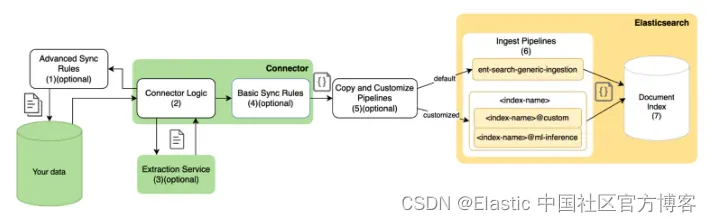

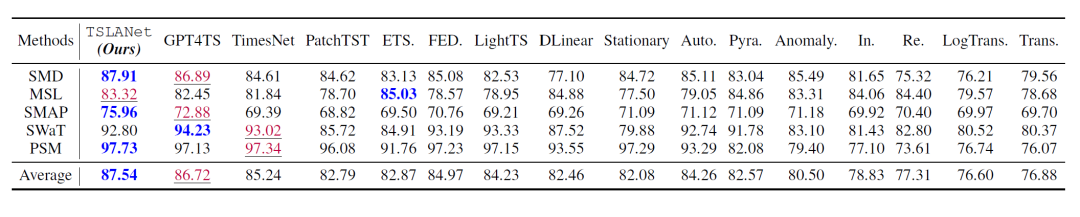

2023年底,OpenAI在官网公布了名叫“Preparedness Framework”的安全评估框架,是这类固定数据集测评的范本之一。

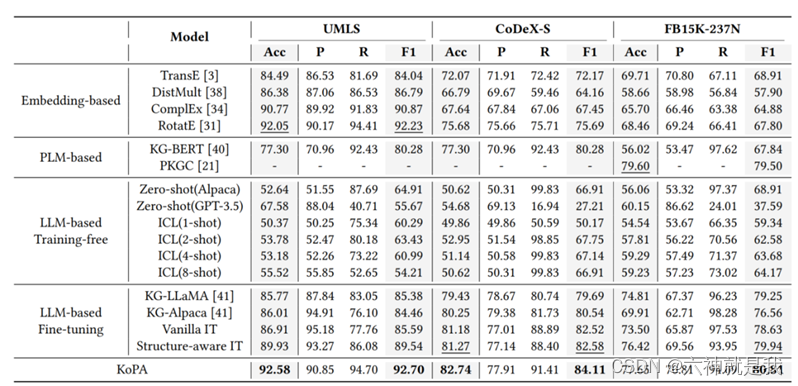

▲OpenAI安全评估模型的计分卡,图源:OpenAI官网

在国内,清华大学计算机系的黄民烈研究团队在2023年3月就发布了大模型安全分类体系,该团队从系统层面和模型层面出发,打造更可控、可信的大模型安全框架,是国内较早参与到模型安全评估体系的团队之一。

除此之外,蚂蚁安全实验室也推出了大模型安全检测平台“蚁鉴2.0”和大模型风险防御平台“天鉴”两大产品。

在具体能力上,风险监测平台可以诊疗检测、定位问题;风险防御平台可以对风险进行防治。

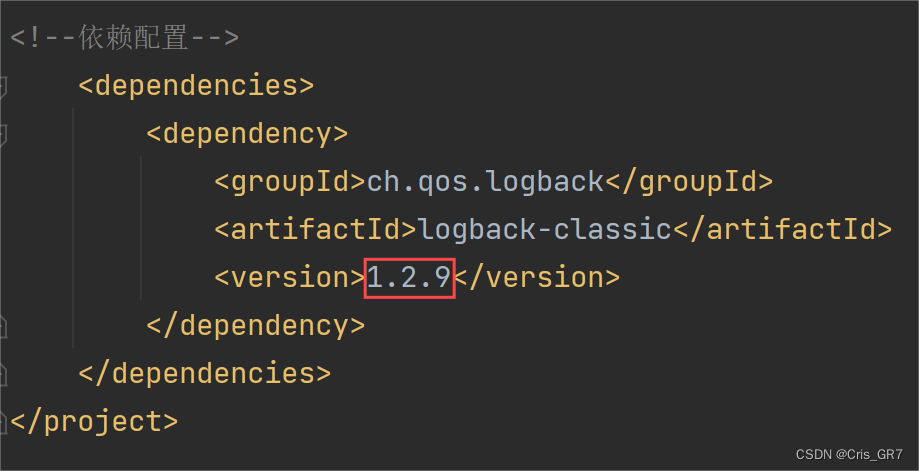

比如在大模型生成可控问题上,蚂蚁安全实验室提出了如通过SFT、RLHF/RRHF、RLAIF等技术和高质量标注做人类对齐;在图像方面做风险抑制,进行可控调试;为大模型外挂千万级安全知识库生成和检索等等方式。

在模型层面的问题之外,使用模型带来的安全问题也同样重要。

6月11日,苹果在WWDC上推出了其全新的 AI 系统“Apple Intelligence”。为了保护用户隐私和数据安全,苹果将大模型的工作分为两类。

其中简单的任务在手机设备端执行,保证数据不离开手机。如果是需要调用云端算力的复杂任务,苹果打造了一套具备芯片级别隐私和安全保护的服务器——“Private Cloud Compute”。这套服务器可以实现加密传输,服务器只识别数据,不收集数据,且在任务完成后,该数据也会被立即删除。

其中关键的一点是,Apple Intelligence集成了GPT-4o作为第三方大模型支持。为了保证数据安全和用户的知情权,苹果设置Siri启用Chat GPT时会向用户提出申请。

也就是说,在苹果的安全框架里,虽然企业会做好一切前期准备,但用户自己才是安全防范的最后一道防火墙。

就像OpenAI一直都在官网提醒用户,“在使用 GPT-4 输出的内容时应格外小心,特别是在高风险场景下(如医学、化学等领域),需要人工核查事实准确性或者避免使用 AI 给出的答案。”

所以,虽然身处AI时代,工具已经如此强大,但在一切工具就绪之后,我们仍应记住,我们自己才是保护自己的最后一道防线。