其实就是通过求偏导的方式,求出各个权重大小

loss函数是找最小值的,要求导,在计算机里面计算导数是倒着来的,所以叫反向传播。

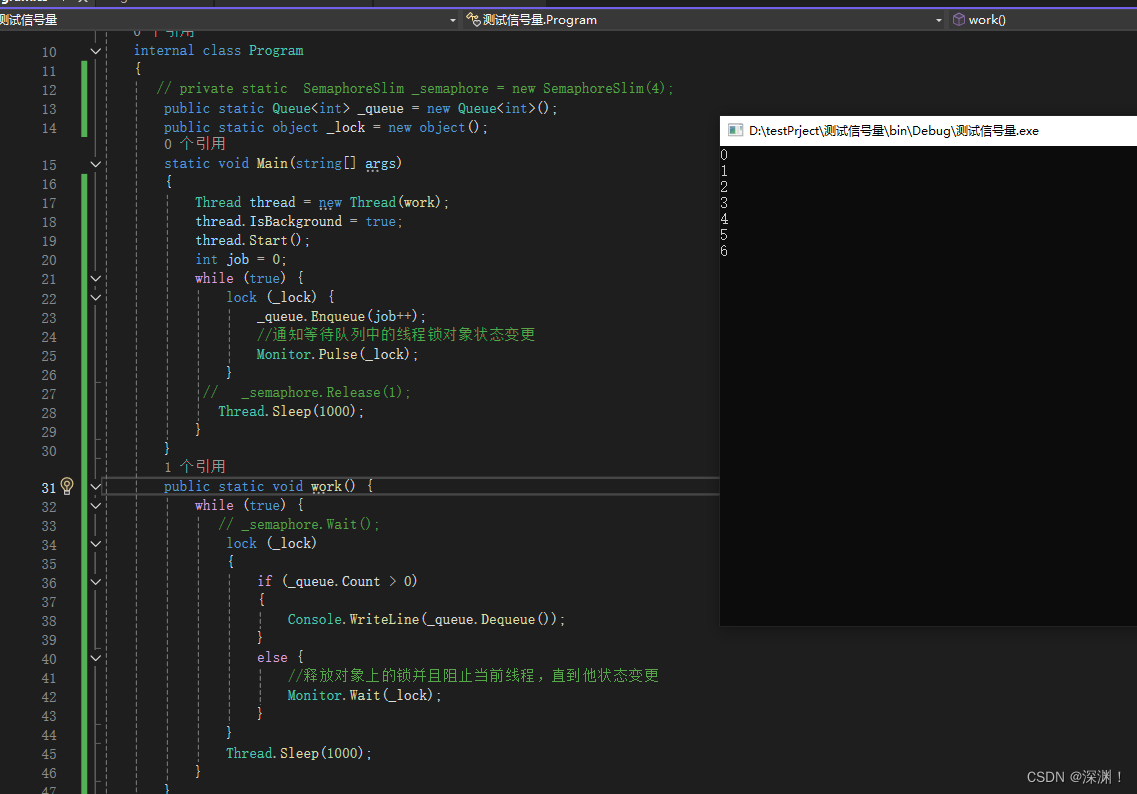

import torch

from torch.nn import L1Lossinputs=torch.tensor([1,2,3],dtype=torch.float32)

target=torch.tensor([1,2,5],dtype=torch.float32)inputs=torch.reshape(inputs,(1,1,1,3))#这里rershape的目的是增加batch_size这一数据

target=torch.reshape(target,(1,1,1,3))

loss=L1Loss()

result=loss(inputs,target)

print(result)

对以上的一个简单设计

loss的默认reduction是mean即平均值

我们需要的是相加

import torch

from torch.nn import L1Lossinputs=torch.tensor([1,2,3],dtype=torch.float32)

target=torch.tensor([1,2,5],dtype=torch.float32)inputs=torch.reshape(inputs,(1,1,1,3))#这里rershape的目的是增加batch_size这一数据

target=torch.reshape(target,(1,1,1,3))

loss=L1Loss(reduction='sum')

result=loss(inputs,target)

print(result)

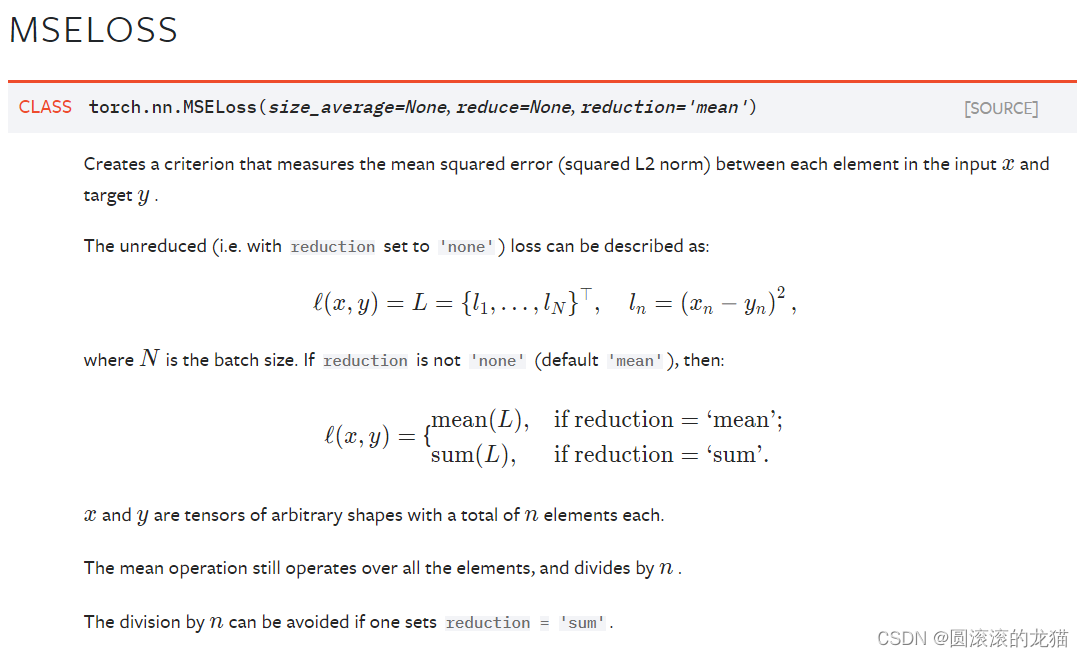

均方差

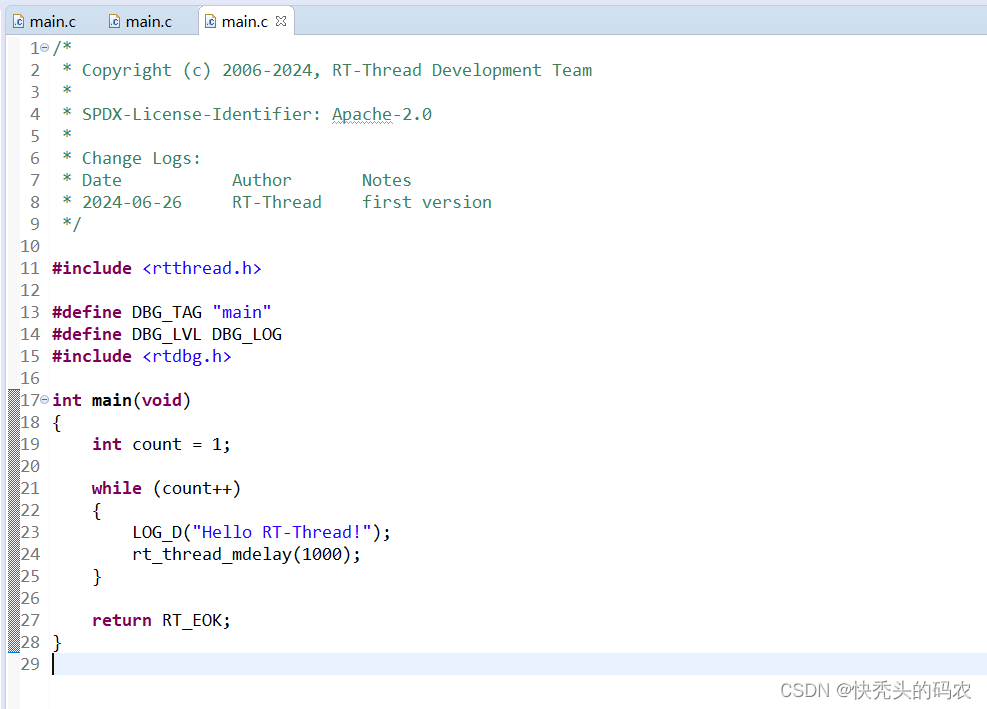

反向传播