Python爬虫解密:如何快速抓取网站数据

在当今信息时代,人们越来越依赖互联网获取信息。不同的网站提供了大量数据,但是手动去抓取这些数据十分困难,效率也很低。Python爬虫技术是解决这一问题的有效工具之一,它可以帮助我们快速抓取网站的数据。本文将介绍如何使用Python爬虫进行数据抓取,并给出实用的技巧和建议。

Python爬虫是什么?

Python爬虫是一种自动化获取网页数据的技术。它可以像人一样访问网页,提取需要的信息,然后存储在数据库中,以供进一步处理。Python爬虫可以模拟浏览器行为,自动填写表单、点击按钮等。它能够访问互联网上的几乎所有网站,提取各种类型的数据,如文本、图片、视频等。

Python爬虫的基本原理

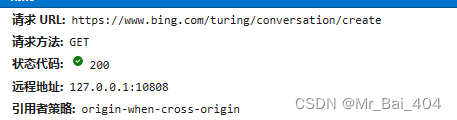

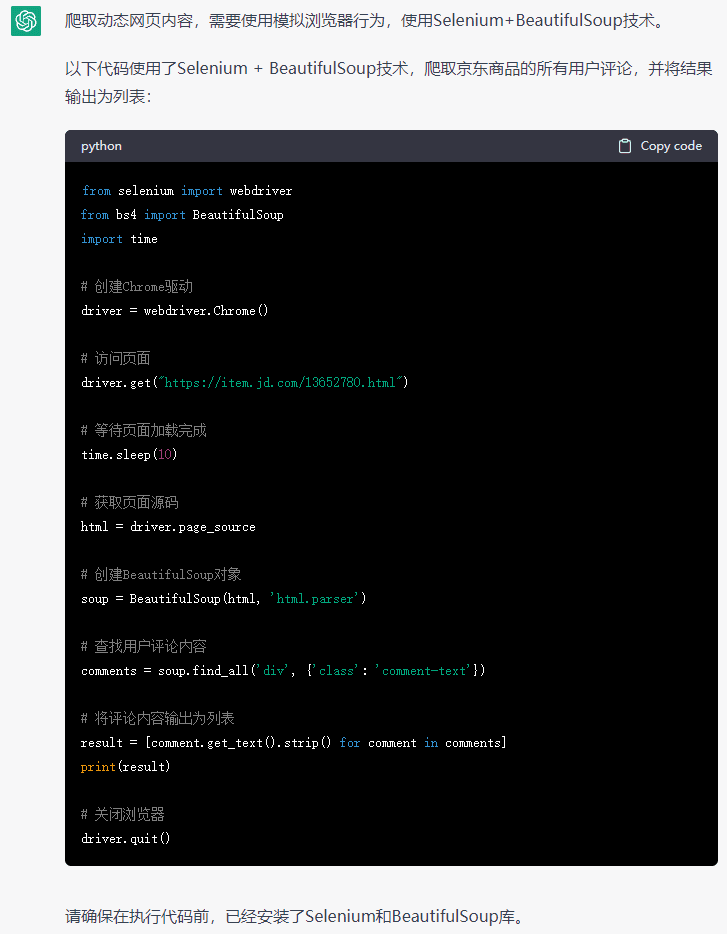

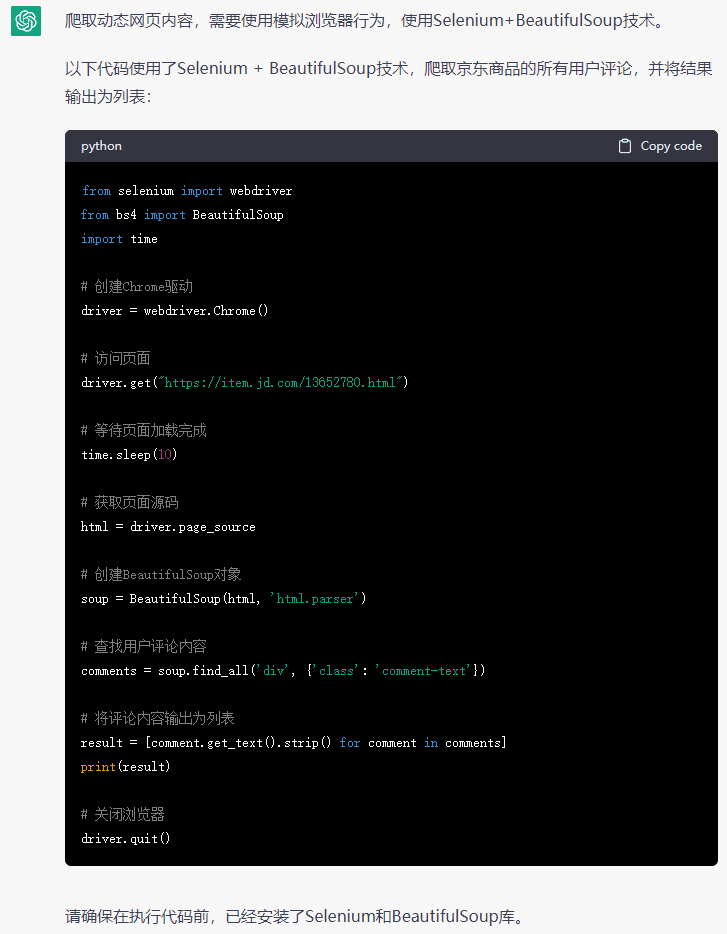

Python爬虫的基本原理是通过HTTP协议向服务器发起请求,获取服务器响应的HTML页面,然后利用Python库对页面进行解析,提取需要的数据。Python爬虫的核心工具是HTTP库、HTML解析库和数据库。下面我们将介绍一些常用的Python库。

Requests库

Requests库是Python中的一个HTTP库,它可以模拟浏览器向网站发起请求,获取响应。使用Requests库,我们可以轻松地发送GET和POST请求,并处理服务器返回的数据。比如下面的代码可以向百度发起GET请求,并将响应页面内容输出:

import requestsresponse = requests.get('https://www.baidu.com')

print(response.text)

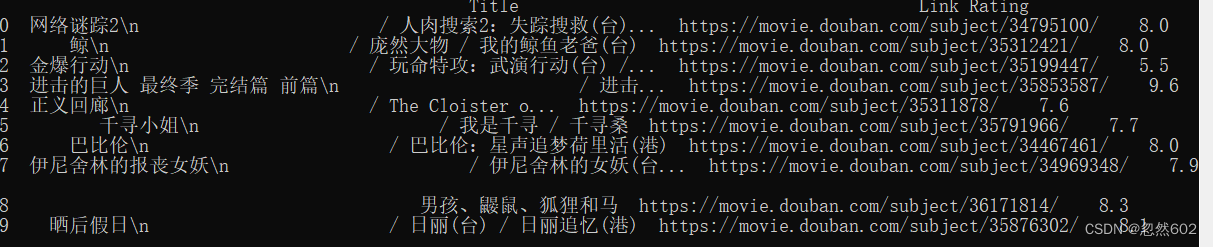

Beautiful Soup库

Beautiful Soup库是Python中的一个HTML解析库,它可以将HTML页面解析为Python对象,并提供一系列方法处理HTML元素。我们可以使用Beautiful Soup来提取页面中的各种信息,如元素、属性、文本等。例如下面的代码可以提取百度页面中的所有链接:

from bs4 import BeautifulSoup

import requestsresponse = requests.get('https://www.baidu.com')

soup = BeautifulSoup(response.text)

links = soup.find_all('a')

for link in links:print(link['href'])

MySQL库

MySQL库是Python中的一个数据库驱动,它可以连接MySQL数据库,并提供一系列方法操作数据库。我们可以使用MySQL库将抓取的数据存储到数据库中,以便后续使用。例如下面的代码可以连接MySQL数据库,并创建一个表:

import mysql.connectormydb = mysql.connector.connect(host="localhost",user="root",password="",database="test"

)mycursor = mydb.cursor()mycursor.execute("CREATE TABLE customers (name VARCHAR(255), address VARCHAR(255))")

Python爬虫的实用技巧和建议

设置请求头信息

有些网站会对HTTP请求进行检查,如果发现请求不是由浏览器发送的,就会拒绝请求。为了避免这种情况,我们应该在请求中设置User-Agent等头信息,以模拟浏览器的行为。例如:

import requestsheaders = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/58.0.3029.110 Safari/537.3'

}response = requests.get('https://www.baidu.com', headers=headers)

处理cookies信息

有些网站会使用cookies来记录用户信息,如果我们希望自己的爬虫程序在这些网站上正常工作,我们需要处理好cookies信息。Requests库提供了一个CookiesJar对象,可以用来保存和发送cookies信息。例如:

import requestss = requests.Session()

s.get('http://httpbin.org/cookies/set/sessioncookie/123456789')

response = s.get('http://httpbin.org/cookies')

print(response.text)

使用代理IP

有些网站会对同一个IP地址的频繁访问进行限制,如果我们的爬虫程序被检测到了,就可能会被禁止访问。为了避免这种情况,我们可以使用代理IP进行访问。Requests库提供了一个proxies参数,可以用来设置代理IP。例如:

import requestsproxies = {'http': 'http://10.10.1.10:3128','https': 'http://10.10.1.10:1080',

}response = requests.get('https://www.baidu.com', proxies=proxies)

防止被反爬虫

有些网站会通过反爬虫技术来限制爬虫程序的访问,如设置IP访问次数限制、设置登录验证等。为了避免被反爬虫技术限制,我们可以在爬虫程序中使用一些技巧和工具,如使用多个IP地址轮流访问、使用代理IP进行访问、避免频繁访问同一个网站等。

结论

Python爬虫技术是获取网站数据的有效工具之一,它可以帮助我们快速抓取网站数据,并进行后续处理。本文介绍了Python爬虫的基本原理,以及常用的Python库和实用技巧。通过学习本文,读者可以了解Python爬虫的基本原理和应用,掌握一些实用的技巧和建议,从而更好地进行数据抓取和处理。

最后的最后

本文由chatgpt生成,文章没有在chatgpt生成的基础上进行任何的修改。以上只是chatgpt能力的冰山一角。作为通用的Aigc大模型,只是展现它原本的实力。

对于颠覆工作方式的ChatGPT,应该选择拥抱而不是抗拒,未来属于“会用”AI的人。

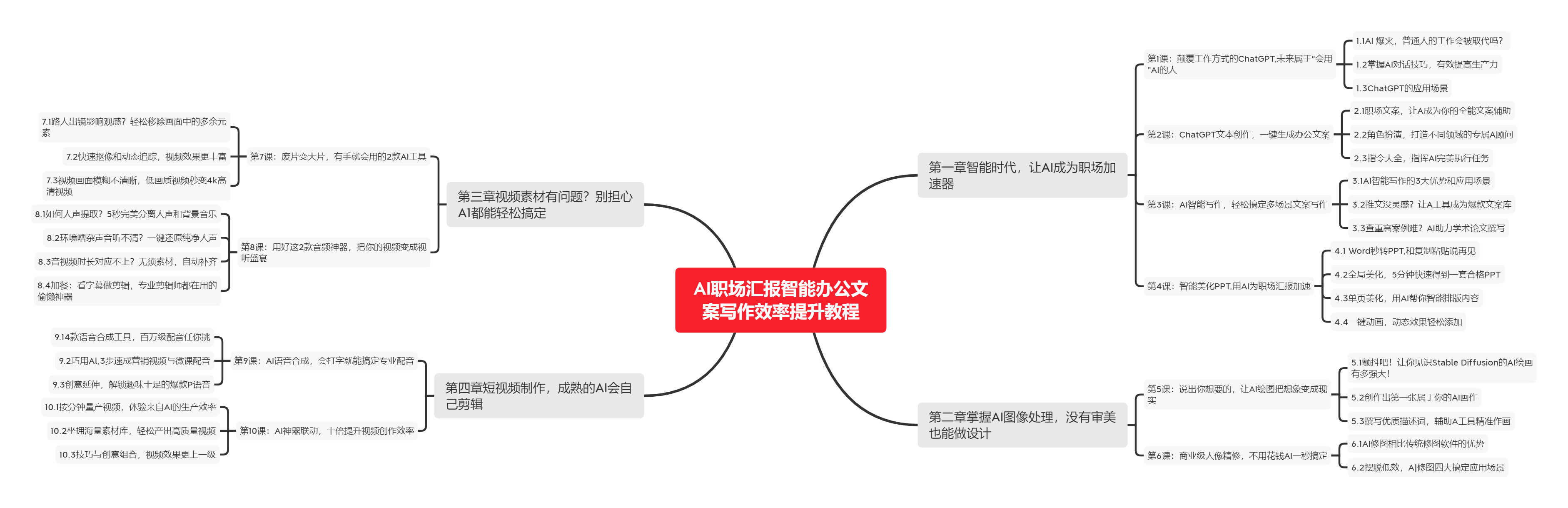

🧡AI职场汇报智能办公文案写作效率提升教程 🧡 专注于AI+职场+办公方向。

下图是课程的整体大纲

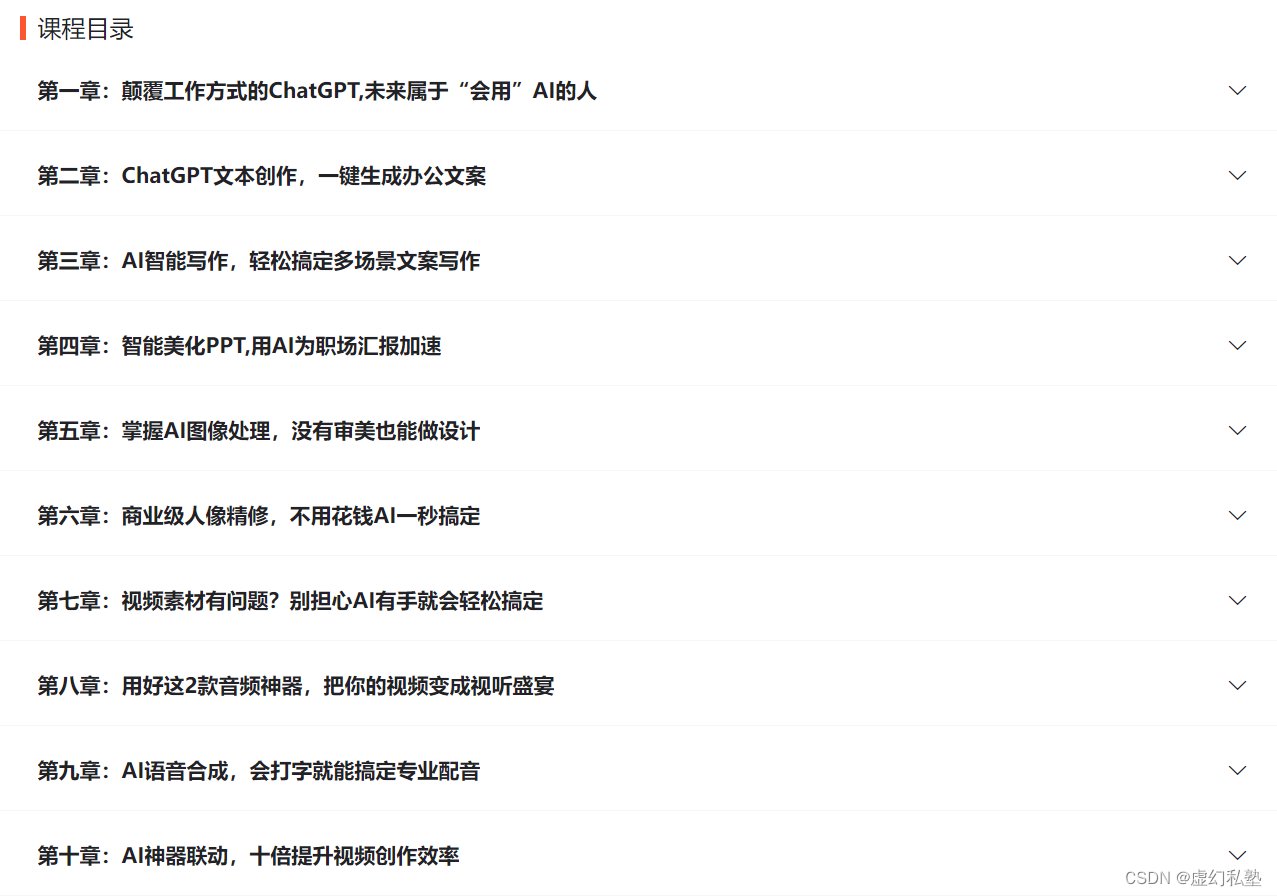

下图是AI职场汇报智能办公文案写作效率提升教程中用到的ai工具

🚀 优质教程分享 🚀

- 🎄可以学习更多的关于人工只能/Python的相关内容哦!直接点击下面颜色字体就可以跳转啦!

| 学习路线指引(点击解锁) | 知识定位 | 人群定位 |

|---|---|---|

| 🧡 AI职场汇报智能办公文案写作效率提升教程 🧡 | 进阶级 | 本课程是AI+职场+办公的完美结合,通过ChatGPT文本创作,一键生成办公文案,结合AI智能写作,轻松搞定多场景文案写作。智能美化PPT,用AI为职场汇报加速。AI神器联动,十倍提升视频创作效率 |

| 💛Python量化交易实战 💛 | 入门级 | 手把手带你打造一个易扩展、更安全、效率更高的量化交易系统 |

| 🧡 Python实战微信订餐小程序 🧡 | 进阶级 | 本课程是python flask+微信小程序的完美结合,从项目搭建到腾讯云部署上线,打造一个全栈订餐系统。 |