Hadoop物流可视化系统的开题报告

一、课题名称

Hadoop物流可视化系统设计与实现

二、研究背景与意义

随着信息技术的飞速发展,物流行业产生了海量的数据,这些数据包含了订单信息、运输路线、仓储状态等丰富的信息和价值。然而,传统的数据处理和分析方法在处理如此庞大的数据量时显得力不从心,无法满足物流行业对实时性和准确性的需求。因此,开发一个高效的物流数据可视化系统显得尤为重要。Hadoop作为一种分布式计算框架,以其强大的数据处理能力成为处理大数据的理想选择。本研究旨在设计并实现一个基于Hadoop的物流数据可视化系统,通过对物流数据的深度挖掘和分析,为物流行业提供更高效、更精准的决策支持。

2.1 研究背景

物流行业在运营过程中积累了大量的数据,这些数据是宝贵的资源,但目前尚未得到充分的利用。传统的数据处理方法在处理海量数据时存在处理速度慢、分析结果不准确等问题,无法满足物流行业对实时性和准确性的需求。Hadoop分布式计算框架以其高可扩展性、高容错性和高效的数据处理能力,成为处理大数据的理想选择。

2.2 研究意义

- 提高数据处理能力:通过利用Hadoop的分布式处理技术,实现对海量物流数据的快速处理和分析,提高分析的准确性和效率。

- 优化数据可视化效果:通过采用先进的可视化技术,将复杂的物流数据以直观、易懂的方式呈现给用户,提高用户对分析结果的理解和应用能力。

- 提高系统灵活性:设计灵活的分析模型和界面,根据用户需求灵活地调整和优化分析模型,扩大系统的应用范围。

三、国内外研究现状

目前,虽然有一些物流数据可视化分析系统,但它们主要存在以下问题:

- 数据处理能力不足:无法有效处理和分析海量的物流数据,导致分析结果不准确。

- 数据可视化效果差:无法将复杂的物流数据通过直观、易懂的方式呈现给用户,使得用户难以理解和应用分析结果。

- 系统灵活性低:无法根据用户需求灵活地调整和优化分析模型,使得系统的应用范围受到限制。

相比之下,基于Hadoop的物流数据可视化系统能够充分利用Hadoop的分布式计算能力,解决上述问题,为物流行业提供更高效、更精准的数据分析支持。

四、研究内容与方法

4.1 研究内容

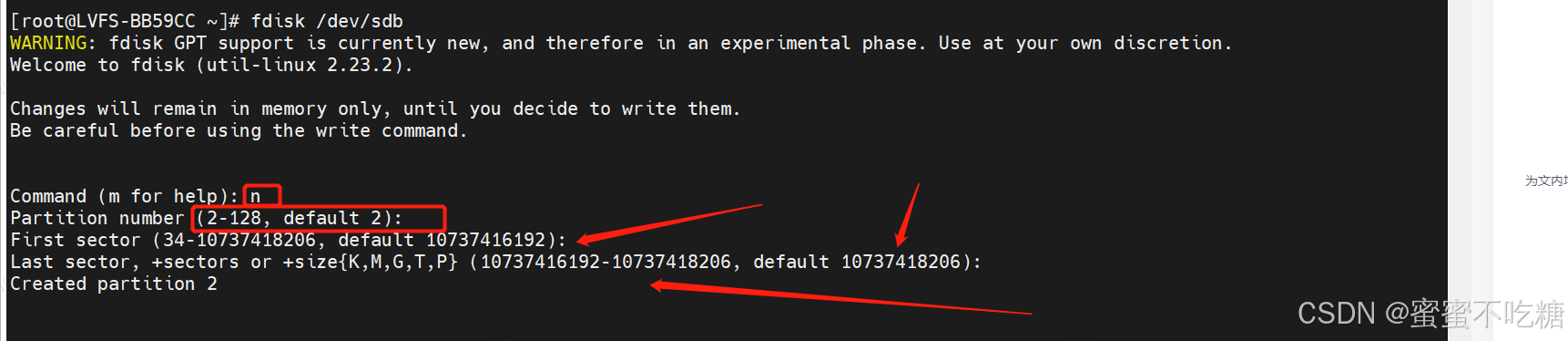

- Hadoop集群的搭建与配置:包括Hadoop的安装、配置以及集群的部署,确保系统能够高效运行。

- 物流数据收集与预处理:设计并实现数据收集模块,从物流系统中获取数据,并进行必要的预处理,如数据清洗、转换和存储。

- 数据分析模型设计:基于Hadoop和Spark等大数据技术,设计并实现适合物流数据分析的模型,包括数据挖掘、关联分析、聚类分析等。

- 数据可视化界面设计:采用Vue、Echarts等前端技术,设计并实现一个直观、易用的数据可视化界面,方便用户查看和分析物流数据。

4.2 研究方法

- 文献研究法:通过查阅相关文献,了解Hadoop、大数据处理、数据可视化等领域的最新研究成果和技术进展。

- 系统开发法:采用软件工程的方法,按照需求分析、系统设计、系统实现、系统测试等阶段进行系统的开发。

- 实证研究法:通过实际物流数据对系统进行测试和验证,评估系统的性能和效果。

五、研究进度安排

- 第一阶段(1-2个月):完成Hadoop集群的搭建与配置,确保系统能够正常运行。

- 第二阶段(3-4个月):设计并实现物流数据收集与预处理模块,收集并处理物流数据。

- 第三阶段(5-6个月):设计并实现数据分析模型,进行数据挖掘和关联分析等工作。

- 第四阶段(7-8个月):设计并实现数据可视化界面,完成系统的集成和测试。

- 第五阶段(9-10个月):撰写论文,准备答辩。

六、预期成果

- 技术成果:完成Hadoop物流数据可视化系统的设计与实现,包括Hadoop集群的搭建、物流数据收集与预处理模块、数据分析模型和数据可视化界面的设计与实现。

- 理论成果:撰写一篇关于Hadoop物流数据可视化系统的学术论文,总结研究成果和技术创新点。

- 应用成果:将系统应用于实际物流场景,提高物流企业的数据处理能力和决策支持能力。

七、参考文献

(此处列出相关文献,由于篇幅限制,不具体列出)

以上是Hadoop物流可视化系统的开题报告,希望能为课题的顺利开展提供有力支持。

核心算法代码分享如下:

from flask import Flask, render_template, request, redirect, url_for

import json

from flask_mysqldb import MySQL

from flask import Flask, send_from_directory,render_template, request, redirect, url_for, jsonify

import csv

import os

import pymysql

# 创建应用对象

app = Flask(__name__)

app.config['MYSQL_HOST'] = 'bigdata'

app.config['MYSQL_USER'] = 'root'

app.config['MYSQL_PASSWORD'] = '123456'

app.config['MYSQL_DB'] = 'hive_chinawutong'

mysql = MySQL(app) # this is the instantiation@app.route('/tables01')

def tables01():cur = mysql.connection.cursor()cur.execute('''SELECT replace(REPLACE(REPLACE(from_province, '区', ''), '省', ''),'市','') from_province,num FROM table01''')#row_headers = [x[0] for x in cur.description] # this will extract row headersrow_headers = ['from_province','num'] # this will extract row headersrv = cur.fetchall()json_data = []#print(json_data)for result in rv:json_data.append(dict(zip(row_headers, result)))return json.dumps(json_data, ensure_ascii=False)@app.route('/tables02')

def tables02():cur = mysql.connection.cursor()cur.execute('''SELECT pub_time,num,LENGTH(pub_time) len_time FROM table02 ORDER BY len_time desc ''')#row_headers = [x[0] for x in cur.description] # this will extract row headersrow_headers = ['pub_time','num'] # this will extract row headersrv = cur.fetchall()json_data = []#print(json_data)for result in rv:json_data.append(dict(zip(row_headers, result)))return json.dumps(json_data, ensure_ascii=False)@app.route('/tables03')

def tables03():cur = mysql.connection.cursor()cur.execute('''SELECT * FROM table03 order by rztime asc''')#row_headers = [x[0] for x in cur.description] # this will extract row headersrow_headers = ['rztime','num'] # this will extract row headersrv = cur.fetchall()json_data = []#print(json_data)for result in rv:json_data.append(dict(zip(row_headers, result)))return json.dumps(json_data, ensure_ascii=False)@app.route('/tables04')

def tables04():cur = mysql.connection.cursor()cur.execute('''SELECT * FROM table04''')#row_headers = [x[0] for x in cur.description] # this will extract row headersrow_headers = ['yslx','num'] # this will extract row headersrv = cur.fetchall()json_data = []#print(json_data)for result in rv:json_data.append(dict(zip(row_headers, result)))return json.dumps(json_data, ensure_ascii=False)@app.route("/getmapcountryshowdata")

def getmapcountryshowdata():filepath = r"D:\\wuliu_hadoop_spark_spider2025\\echarts\\data\\maps\\china.json"with open(filepath, "r", encoding='utf-8') as f:data = json.load(f)return json.dumps(data, ensure_ascii=False)@app.route('/tables05')

def tables05():cur = mysql.connection.cursor()cur.execute('''SELECT * FROM table05 order by num asc''')#row_headers = [x[0] for x in cur.description] # this will extract row headersrow_headers = ['hwlx','num'] # this will extract row headersrv = cur.fetchall()json_data = []#print(json_data)for result in rv:json_data.append(dict(zip(row_headers, result)))return json.dumps(json_data, ensure_ascii=False)@app.route('/tables06')

def tables06():cur = mysql.connection.cursor()cur.execute('''SELECT * FROM table06''')#row_headers = [x[0] for x in cur.description] # this will extract row headersrow_headers = ['weight_union','num'] # this will extract row headersrv = cur.fetchall()json_data = []#print(json_data)for result in rv:json_data.append(dict(zip(row_headers, result)))return json.dumps(json_data, ensure_ascii=False)@app.route('/tables07')

def tables07():cur = mysql.connection.cursor()cur.execute('''SELECT * FROM table07 order by num asc''')#row_headers = [x[0] for x in cur.description] # this will extract row headersrow_headers = ['recieve_province','num'] # this will extract row headersrv = cur.fetchall()json_data = []#print(json_data)for result in rv:json_data.append(dict(zip(row_headers, result)))return json.dumps(json_data, ensure_ascii=False)@app.route('/tables08')

def tables08():cur = mysql.connection.cursor()cur.execute('''SELECT * FROM table08''')#row_headers = [x[0] for x in cur.description] # this will extract row headersrow_headers = ['end_time','num'] # this will extract row headersrv = cur.fetchall()json_data = []#print(json_data)for result in rv:json_data.append(dict(zip(row_headers, result)))return json.dumps(json_data, ensure_ascii=False)@app.route('/tables09')

def tables09():cur = mysql.connection.cursor()cur.execute('''SELECT * FROM table09''')#row_headers = [x[0] for x in cur.description] # this will extract row headersrow_headers = ['wlmc','num'] # this will extract row headersrv = cur.fetchall()json_data = []#print(json_data)for result in rv:json_data.append(dict(zip(row_headers, result)))return json.dumps(json_data, ensure_ascii=False)@app.route('/data',methods=['GET'])

def data():limit = int(request.args['limit'])page = int(request.args['page'])page = (page-1)*limitconn = pymysql.connect(host='bigdata', user='root', password='123456', port=3306, db='hive_chinawutong',charset='utf8mb4')cursor = conn.cursor()if (len(request.args) == 2):cursor.execute("select count(*) from ods_chinawutong");count = cursor.fetchall()cursor = conn.cursor(cursor=pymysql.cursors.DictCursor)cursor.execute("select * from ods_chinawutong limit "+str(page)+","+str(limit));data_dict = []result = cursor.fetchall()for field in result:data_dict.append(field)else:weight_union = str(request.args['weight_union'])wlmc = str(request.args['wlmc']).lower()if(weight_union=='不限'):cursor.execute("select count(*) from ods_chinawutong where wlmc like '%"+wlmc+"%'");count = cursor.fetchall()cursor = conn.cursor(cursor=pymysql.cursors.DictCursor)cursor.execute("select * from ods_chinawutong where wlmc like '%"+wlmc+"%' limit " + str(page) + "," + str(limit));data_dict = []result = cursor.fetchall()for field in result:data_dict.append(field)else:cursor.execute("select count(*) from ods_chinawutong where wlmc like '%"+wlmc+"%' and weight_union like '%"+weight_union+"%'");count = cursor.fetchall()cursor = conn.cursor(cursor=pymysql.cursors.DictCursor)cursor.execute("select * from ods_chinawutong where wlmc like '%"+wlmc+"%' and weight_union like '%"+weight_union+"%' limit " + str(page) + "," + str(limit));data_dict = []result = cursor.fetchall()for field in result:data_dict.append(field)table_result = {"code": 0, "msg": None, "count": count[0], "data": data_dict}cursor.close()conn.close()return jsonify(table_result)if __name__ == "__main__":app.run(debug=False)