引言

在电商数据分析中,爬虫技术的应用日益广泛。通过爬虫技术,我们可以高效地获取大量的电商平台数据,这些数据对于市场分析、竞争情报、价格监控等有着极其重要的意义。亚马逊作为全球最大的电商平台之一,是数据采集的重要目标。然而,亚马逊为了保护其网站的安全性和正常运营,设置了验证码机制,这对爬虫技术提出了巨大的挑战。本文将详细介绍如何在数据采集中绕过亚马逊验证码的限制,帮助读者了解相关技术和注意事项。

一、亚马逊验证码概述

定义与技术实现

验证码(CAPTCHA, Completely Automated Public Turing test to tell Computers and Humans Apart)是一种用于区分用户是计算机还是人的验证技术。亚马逊常用的验证码包括图像验证码、字符验证码等,通过要求用户输入特定的字符或选择特定的图像,以此来验证用户的身份。

验证码出现的原因分析

保护网站安全

验证码的主要目的是保护网站免受恶意攻击,确保网站的安全性。通过设置验证码,可以有效阻止自动化的恶意爬取和攻击行为。

防止恶意爬取

验证码还用于防止恶意爬虫大量爬取数据,影响网站的正常运营。恶意爬虫可能会导致服务器负载过高,影响正常用户的访问体验。

维护网站正常运营

通过验证码机制,亚马逊可以维护网站的正常运营,避免因为爬虫带来的流量负载和数据泄露问题。

二、验证码的识别与绕过策略

验证码的类型与特点

亚马逊常见的验证码类型包括图像验证码和字符验证码。图像验证码通常要求用户选择特定的图像,而字符验证码则要求用户输入图像中显示的字符。这些验证码具有随机性和多样性,增加了识别和绕过的难度。

常见的验证码绕过技术

图像识别技术

图像识别技术是通过训练机器学习模型,识别验证码图像中的内容。这种技术需要大量的验证码样本进行训练,以提高识别的准确率。

代理IP的使用

通过使用代理IP,可以避免频繁请求同一IP地址,降低被检测和封禁的风险。代理IP的使用需要合理配置和管理,以确保爬虫的稳定运行。

浏览器自动化工具

浏览器自动化工具(如Selenium)可以模拟真实用户的操作,自动完成验证码的识别和输入。这种方法通过模拟用户行为,降低被检测的可能性。

三、技术实现详解

环境准备

选择合适的编程语言(Python)

Python是一种功能强大且易于使用的编程语言,非常适合用于编写爬虫程序。它有丰富的库和框架,可以大大简化爬虫的开发过程。

安装必要的库

在开始编写爬虫程序之前,需要安装一些必要的库,如Selenium、BeautifulSoup等。这些库提供了强大的功能,方便进行网页数据的抓取和处理。

pip install selenium beautifulsoup4 requests

Python代码实现

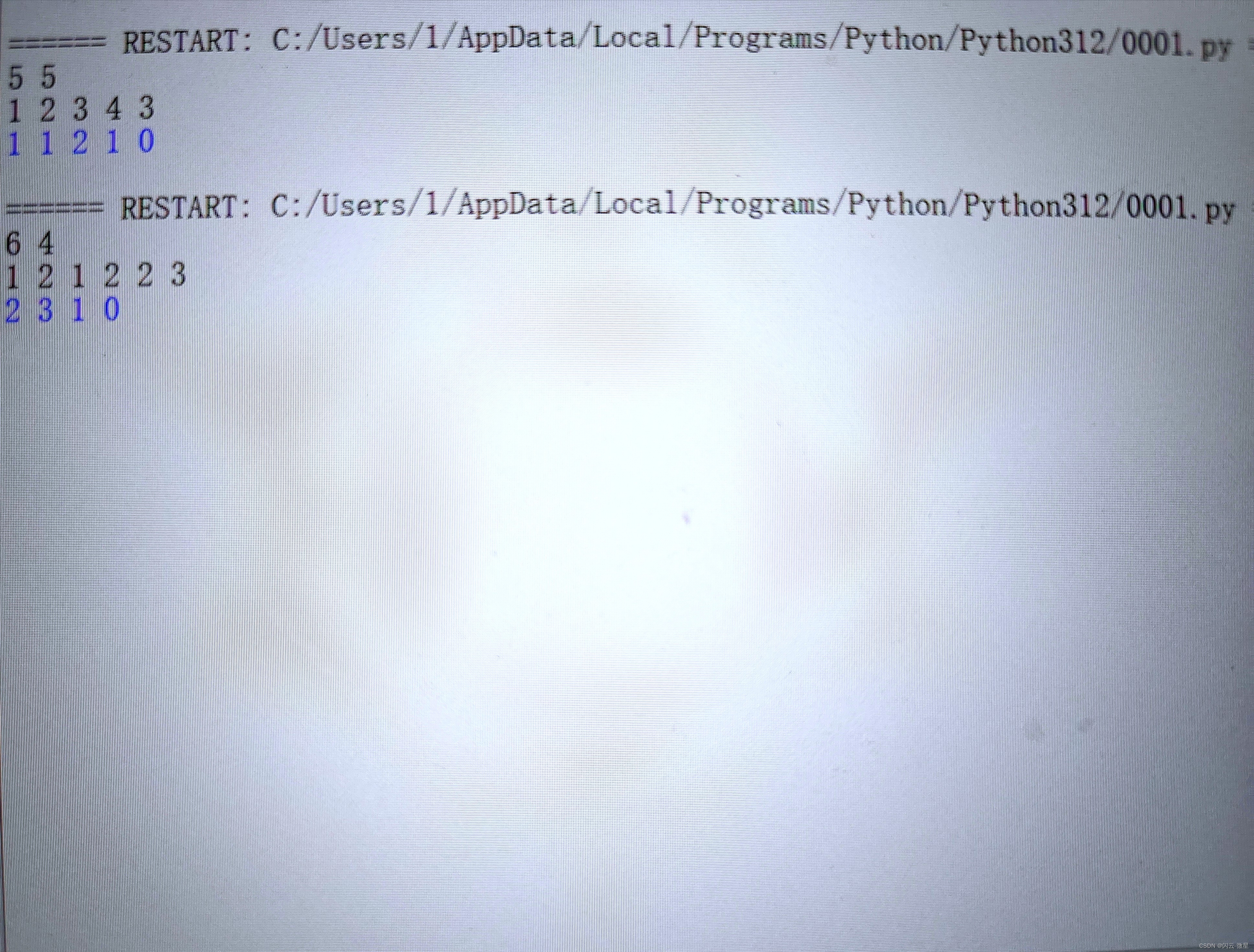

爬虫基础代码框架

首先,我们需要搭建一个基本的爬虫框架,包含请求发送、页面解析等基本功能。

from selenium import webdriver

from bs4 import BeautifulSoup

import time# 初始化WebDriver

driver = webdriver.Chrome()# 访问目标页面

driver.get('https://www.amazon.com')# 等待页面加载

time.sleep(3)# 获取页面内容

html = driver.page_source# 解析页面内容

soup = BeautifulSoup(html, 'html.parser')# 提取所需数据

data = soup.find_all('div', class_='example-class')# 关闭WebDriver

driver.quit()# 打印提取的数据

for item in data:print(item.text)

验证码识别与处理逻辑

为了绕过验证码,我们可以使用图像识别技术。以下是一个简单的示例,演示如何使用Selenium自动化处理验证码。

from selenium import webdriver

from selenium.webdriver.common.by import By

import time

import pytesseract

from PIL import Image# 初始化WebDriver

driver = webdriver.Chrome()# 访问目标页面

driver.get('https://www.amazon.com')# 等待页面加载

time.sleep(3)# 找到验证码图片并截图

captcha_image = driver.find_element(By.ID, 'captcha-image')

captcha_image.screenshot('captcha.png')# 使用pytesseract识别验证码

captcha_text = pytesseract.image_to_string(Image.open('captcha.png'))# 输入识别出的验证码

captcha_input = driver.find_element(By.ID, 'captcha-input')

captcha_input.send_keys(captcha_text)# 提交表单

submit_button = driver.find_element(By.ID, 'submit-button')

submit_button.click()# 关闭WebDriver

driver.quit()

代理IP的配置与管理

使用代理IP可以有效避免频繁请求同一IP导致的封禁风险。以下是一个简单的示例,演示如何在Selenium中配置代理IP。

from selenium import webdriver

from selenium.webdriver.common.proxy import Proxy, ProxyType# 配置代理IP

proxy = Proxy()

proxy.proxy_type = ProxyType.MANUAL

proxy.http_proxy = 'http://your-proxy-ip:port'

proxy.ssl_proxy = 'http://your-proxy-ip:port'capabilities = webdriver.DesiredCapabilities.CHROME

proxy.add_to_capabilities(capabilities)# 初始化WebDriver并使用代理

driver = webdriver.Chrome(desired_capabilities=capabilities)# 访问目标页面

driver.get('https://www.amazon.com')# 关闭WebDriver

driver.quit()

注意事项

遵守亚马逊的使用条款

在进行数据采集时,必须遵守亚马逊的使用条款,避免侵犯其合法权益。

避免频繁请求导致的IP被封

使用代理IP和设置合理的请求频率,避免因频繁请求导致IP被封禁。

代码的健壮性与异常处理

编写健壮的代码,处理可能出现的异常情况,确保爬虫的稳定运行。

四、案例代码说明

以下是一个完整的爬虫案例,详细解释代码的每一步。

from selenium import webdriver

from selenium.webdriver.common.by import By

from bs4 import BeautifulSoup

import time

import pytesseract

from PIL import Imagedef fetch_amazon_data():# 初始化WebDriverdriver = webdriver.Chrome()try:# 访问目标页面driver.get('https://www.amazon.com')# 等待页面加载time.sleep(3)# 验证码处理if "captcha" in driver.page_source:captcha_image = driver.find_element(By.ID, 'captcha-image')captcha_image.screenshot('captcha.png')captcha_text = pytesseract.image_to_string(Image.open('captcha.png'))captcha_input = driver.find_element(By.ID, 'captcha-input')captcha_input.send_keys(captcha_text)submit_button = driver.find_element(By.ID, 'submit-button')submit_button.click()time.sleep(3)# 获取页面内容html = driver.page_sourcesoup = BeautifulSoup(html, 'html.parser')# 提取所需数据data = soup.find_all('div', class_='example-class')for item in data:print(item.text)except Exception as e:print(f"An error occurred: {e}")finally:# 关闭WebDriverdriver.quit()# 运行爬虫

fetch_amazon_data()

在这个案例中,我们通过Selenium和BeautifulSoup结合,实现了对亚马逊页面的访问和数据提取。同时,利用pytesseract对验证码进行识别,成功绕过了验证码限制。

五、绕过验证码的难点与突破

难点分析

验证码的复杂性与多样性

验证码的复杂性和多样性使得识别变得困难。亚马逊不断更新验证码机制,增加了识别和绕过的难度。

动态更新的验证码机制

亚马逊的验证码机制是动态更新的,这要求我们的识别算法需要不断迭代和更新,以适应新的验证码格式。

突破策略

使用高级图像识别技术

利用深度学习和高级图像识别技术,可以提高验证码识别的准确率。通过大量的训练数据和优化的模型,可以有效应对复杂的验证码。

多IP策略与IP池管理

采用多IP策略和IP池管理,可以有效避免因频繁请求同一IP导致的封禁风险。合理配置和管理IP池,可以提高爬虫的稳定性和成功率。

人工辅助识别的可能性

在某些情况下,可以结合人工辅助识别,提高验证码的处理效率。这种方法适用于验证码复杂且识别率较低的场景。

六、抓取亚马逊站点数据的风险分析

法律风险

在进行数据采集时,需要注意遵守相关法律法规,避免侵犯亚马逊的知识产权和用户隐私。

技术风险

由于亚马逊不断更新其防爬机制,技术风险较高。需要不断更新和优化爬虫算法,以应对新的挑战。

商业道德风险

在数据采集过程中,需要注意商业道德,避免恶意竞争和不正当手段获取数据。

七、更好的选择 - Pangolin Scrape API

Pangolin Scrape API简介

Pangolin Scrape API是一种专为数据采集设计的高效、安全的解决方案。它提供了一系列强大的功能,帮助用户轻松实现数据采集任务。

特点与优势

指定邮区采集

Pangolin Scrape API支持指定邮区采集,用户可以根据需要采集特定区域的数据,灵活性强。

SP广告采集

该API还支持SP广告采集,用户可以获取亚马逊平台上的广告数据,为市场分析提供有力支持。

热卖榜、新品榜采集

Pangolin Scrape API可以高效采集亚马逊热卖榜和新品榜的数据,帮助用户了解市场趋势和新产品信息。

关键词或ASIN采集的灵活性

用户可以根据关键词或ASIN进行数据采集,操作简便,灵活性高。

性能优势与数据管理系统集成

Pangolin Scrape API具有高性能优势,能够快速处理大量数据,并且可以与用户的数据管理系统无缝集成,提高工作效率。

八、总结

爬虫技术在数据采集中的重要性

爬虫技术在电商数据采集中具有重要意义,可以帮助用户高效获取大量有价值的数据。

合理、合法使用爬虫技术的必要性

在进行数据采集时,必须遵守相关法律法规和平台的使用条款,合理、合法地使用爬虫技术。

推荐使用Pangolin Scrape API作为数据采集的高效、安全选择

Pangolin Scrape API作为一种高效、安全的数据采集解决方案,具有强大的功能和灵活性,推荐用户使用。

结尾

通过本文的介绍,希望读者能够了解如何在爬虫数据采集中绕过亚马逊验证码的限制。数据采集在电商分析中具有重要意义,但在实际操作中,必须遵守相关法律法规和平台的使用条款,合理、合法地进行数据采集。如果您有更多关于数据采集的疑问或需要进一步讨论,欢迎与我们联系。让我们一起探索更多数据采集的可能性。