关键词:对抗性攻击、医学图像、深度神经网络、模型安全、鲁棒性

机器学习(ML)是医学领域快速发展的一个分支,它利用计算机科学和统计学的方法来解决医学问题。众所周知,攻击者可能通过故意为机器学习分类器创建输入来引起误分类。在计算机视觉应用领域,对抗性样本的研究已经得到了广泛的开展。由于包含安全和生死考虑,以及性能精度的重要性,人们认为医疗系统非常难以应对,因此对医学图像分析(MedIA)技术进行对抗性攻击的可能性引起了关注,因为这些攻击与伴随的技术基础设施和强大的财务激励有关。由于诊断将作为重要决策的基础,因此评估医学深度神经网络(DNN)任务对对抗性攻击的抵抗力是至关重要的。

在早期的研究中,已经考虑了简单的对抗性攻击。然而,DNN对更危险和现实的攻击也很敏感。本文涵盖了针对医学成像的DNN的最新提出的对抗性攻击策略以及对策。

1 概述

对抗性攻击是指故意对输入数据做出微小且通常难以察觉的修改,以欺骗机器学习模型,使其产生错误的分类或预测。这类攻击对机器学习系统的可靠性和安全性构成了严重威胁,尤其是在网络安全、自动驾驶汽车和医疗诊断等关键领域。

1.1 对抗性攻击类型

根据攻击者对模型的了解程度:

- 白盒攻击 (White-box Attacks): 攻击者完全了解模型的参数、结构和训练数据,可以针对模型的特点设计攻击策略。

- 黑盒攻击 (Black-box Attacks): 攻击者对模型知之甚少,只能通过观察模型的输入输出结果来推断模型的内部机制,攻击难度更大。

- 灰盒攻击 (Gray-box Attacks): 攻击者对模型有一定了解,但不如白盒攻击者了解得深入。

根据攻击的目的:

- 目标攻击 (Targeted Attacks): 攻击者希望模型将特定样本分类为特定的类别。

- 非目标攻击 (Non-targeted Attacks): 攻击者希望模型将特定样本分类为任何与原始类别不同的类别。

-

1.2 对抗性攻击目标

1.2.1 毒化攻击 (Poisoning Attacks)

- 攻击目标: 训练数据集

- 攻击方式: 攻击者通过添加或修改大量虚假样本到训练数据集中,使模型在训练过程中学习到错误的知识,导致模型在测试阶段性能下降或做出错误的预测。

- 攻击示例:向医疗诊断模型中添加经过篡改的医学图像,使模型将良性肿瘤误诊为恶性肿瘤。

1.2.2 逃避攻击 (Evasion Attacks)

- 攻击目标: 测试数据

- 攻击方式: 攻击者生成一些经过精心设计的样本,使模型无法正确识别这些样本,从而造成错误的分类或预测。

- 攻击示例:在医学图像中添加微小的噪声或改变图像的某些特征,使模型无法正确诊断疾病。

1.3 对抗性攻击防御策略

为了提高医学图像分析系统中深度学习模型的安全性和可靠性,研究人员提出了多种对抗性攻击的防御策略。以下是一些主要的防御方法:

1.3.1 对抗性训练(Adversarial Training)

对抗性训练是一种流行的防御方法,它通过向训练数据集中添加对抗性样本来增强卷积神经网络(CNN)模型的鲁棒性。这种方法旨在使模型在面对对抗性扰动时更加健壮。

1.3.2 对抗性检测(Adversarial Detection)

对抗性检测的目标是在应用阶段从输入样本中识别出对抗性案例,而不是在计算机辅助诊断模型的训练阶段发展鲁棒性。这可以通过结合可解释性方法来解决异常检测问题。

1.3.3 图像级预处理(Image-level Pre-processing)

通常,对抗性图像由干净的图像和相关的对抗性扰动组成。去噪对抗性示例以移除扰动部分可以帮助使后续的网络诊断更容易。图像级预处理在生物医学图像分析的背景下可能是有用和安全的,因为它不需要重新训练或修改医学模型。

1.3.4 特征增强(Feature Improvement)

人类和机器视觉在鲁棒性方面的差异归因于与数据分布中特定模式相关的非鲁棒特征的对抗性示例。因此,增强特征表示对于发展鲁棒推理系统至关重要。在这项研究中,我们将特征增强描述为架构或映射函数的修改。旨在改进特征的各种技术显著提高了医学分类模型的鲁棒性。

1.3.5 知识蒸馏(Knowledge Distillation)

在机器学习领域,知识蒸馏是一种有用的技术,用于将从复杂(教师)模型学到的信息传递给简单(学生)模型。特别地,当教师和学习者的网络结构相同时,这种情况被称为自蒸馏。此外,使用对抗性知识蒸馏在自然图像领域的研究已经取得了进展,这种方法将对抗性鲁棒性从重型教师模型转移到视图学生模型。

2 实验

2.1 数据集

- Messidor1 数据集:包含 1,200 张眼底彩色图像,用于根据视网膜病变等级检测糖尿病视网膜病变。

- ISIC 数据集:包含 2,750 张皮肤镜图像,分为三类,用于皮肤病变的分类和分割。

- ChestX-ray14 数据集:包含 112,120 张胸部 X 射线图像,代表 14 种胸部疾病。

- COVID-19 数据库:包含 21,165 张胸部 X 射线图像,并附带可分割的肺脏掩模。

2.2 实验采用的对抗性攻击方法

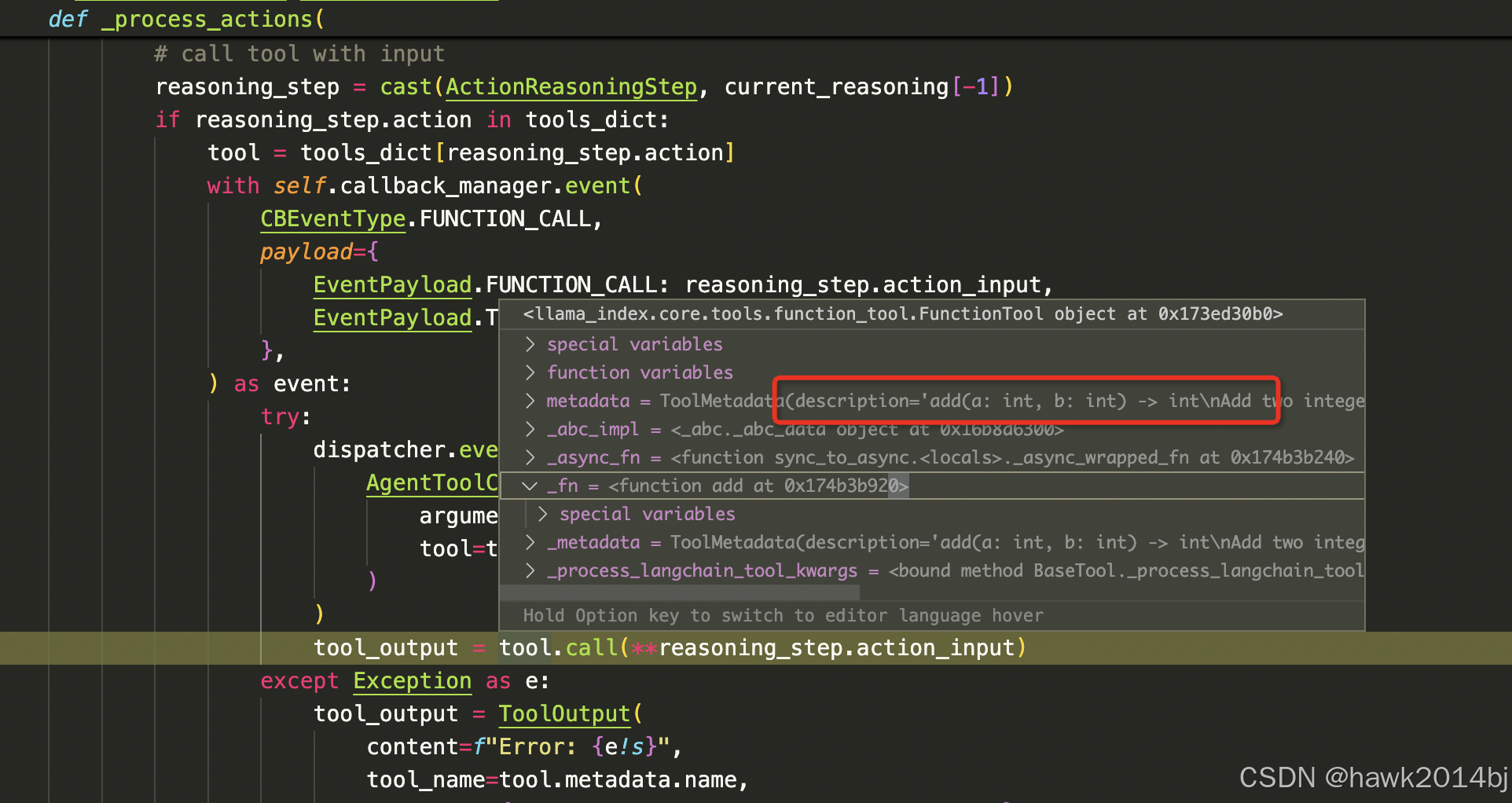

实验采用 FGSM 和 PGD 这两种常用的对抗攻击方法,生成具有不同扰动程度的对抗样本,可以评估模型的鲁棒性。它们都属于白盒攻击,因为攻击者需要知道模型的参数和梯度信息。

- FGSM:计算输入样本相对于损失函数的梯度,然后沿着梯度的反方向进行一步更新,生成对抗性样本。

- PGD: 将 FGSM 的思想扩展到多步更新,通过多次迭代生成对抗性样本,使攻击效果更强。

- 选择 FGSM 还是 PGD:当需要快速生成对抗性样本时,可以选择 FGSM;当需要更强的攻击效果时,可以选择 PGD。

2.3 实验采用的对抗性攻击防御策略

UAD 和 SSAT 是两种有效的对抗防御策略,可以增强模型对抗攻击的鲁棒性。

- UAD (Unsupervised Adversarial Detection):将对抗性样本检测视为异常检测问题,通过分析对抗性样本的特征,将其与正常样本区分开来。

- SSAT (Supervised Segmentation Adversarial Training):将对抗性样本添加到训练数据集中,使模型学习识别对抗性样本,提高模型的鲁棒性。

- 选择 UAD 还是 SSAT:当需要应对未知攻击场景时,可以选择 UAD;当需要针对特定的对抗性攻击进行防御时,可以选择 SSAT。

2.4 评估指标

- 对抗性风险(Adversarial Risk):这是一个综合评估指标,用来衡量对抗性攻击对模型预测准确性的影响。它可能结合了多种因素,如攻击成功率和模型信心水平。

- 模型准确度(Model Accuracy):评估模型在对抗性攻击下的表现,即在面对对抗性样本时模型做出正确预测的能力。

- 攻击成功率(Attack Success Rate, ASR):表示对抗性攻击成功导致模型误分类的比例。这通常用来衡量对抗性样本的有效性。

- 平均成功率(Average Success Rate):在不同的攻击条件下,模型被对抗性样本欺骗的平均比例。

- 区域下面积(Area Under the Curve, AUC):特别是在接收者操作特征曲线(ROC)下,AUC用来衡量模型区分对抗性和非对抗性样本的能力。

- 结构相似性指数(Structural Similarity Index Measure, SSIM):SSIM是一个图像质量评估指标,用来衡量原始图像和对抗性图像之间的相似度。在本文中,它用于评估对抗性扰动对图像的影响程度。

- Dice分数(Dice Score):在医学图像分割任务中,Dice分数用来衡量模型分割结果和真实标注之间的一致性。

- 交并比(Intersection over Union, IoU):同样用于评估图像分割任务的性能,IoU衡量预测分割区域与真实分割区域的交集与并集的比例。

- 模型信心水平(Model Confidence Level):评估模型对其预测结果的确信程度,尤其在对抗性攻击的上下文中,模型信心水平可能会被用来衡量攻击的隐蔽性。

- 转移攻击的成功率(Transferability Success Rate):衡量对抗性样本从一个模型转移到另一个模型时,保持其对抗性效果的能力。

2.5 实验结果

- SSAT 模块:该模块能够显著提高模型的对抗性鲁棒性,同时不会降低干净图像的分类精度。

- UAD 模块:该模块能够有效地识别和排除大多数成功的对抗性示例。

- UAD + SSAT:与现有的 AI 系统相比,该解决方案将对抗性攻击的风险降至最低。

- GAN 生成图像:研究发现,GAN 生成的对抗性图像能够有效地欺骗 AI-CAD 模型,即使是经验丰富的放射科医生也很难识别。

- SSIM 值:不同模态的图像对相同扰动水平的对抗性扰动的可感知性不同。放射学图像最清楚地显示了对抗性扰动,而眼科学和病理学图像的扰动则几乎无法察觉。

- 黑盒攻击:研究发现,黑盒攻击对深度学习在医疗成像中的脆弱性提出了挑战。FGSM 生成的扰动在所有三个数据集中都显示出比 PGD 更低的 SSIM 值。

- 迁移性:研究发现,FGSM 生成的扰动具有比 PGD 更高的迁移性。