在数据爬虫这个领域,我早已不再是新手,而是一位经验丰富的老手。长期以来,我通过不断实践和探索,掌握了一系列高效的爬虫技术,特别是在应对复杂网页和动态数据时,更是积累了独特的经验。

初识爬虫,快速成长

当初我进入这个领域时,就已经意识到传统爬虫方法的局限性。简单的请求-解析流程在面对现代复杂的Web环境时,显得力不从心。经过大量实战,我逐步掌握了分布式爬虫架构的设计,通过并行处理大幅度提升数据获取的效率。这不是简单的速度提升,而是让整个数据抓取流程更加流畅、可靠。

解决IP封禁,打造智能代理池

在不断提升爬虫性能的过程中,我也深知频繁访问同一网站容易导致IP封禁。面对这种情况,我开发了一套智能代理池系统。通过动态切换高质量代理并结合代理检测机制,我有效解决了IP封禁问题,确保了爬虫的稳定性和数据抓取的成功率。这种高效的解决方案,也成为了我在各大项目中屡试不爽的利器。

深入逆向工程,突破动态数据障碍

面对一些使用JavaScript动态加载内容的网站,我没有退缩,而是选择深入研究其背后的加载逻辑。通过分析和逆向工程,我不仅破解了这些复杂的加密算法,还能够精准地获取到网页中所有隐藏的数据。这个过程中,我的技术能力和对细节的把握得到了进一步提升。

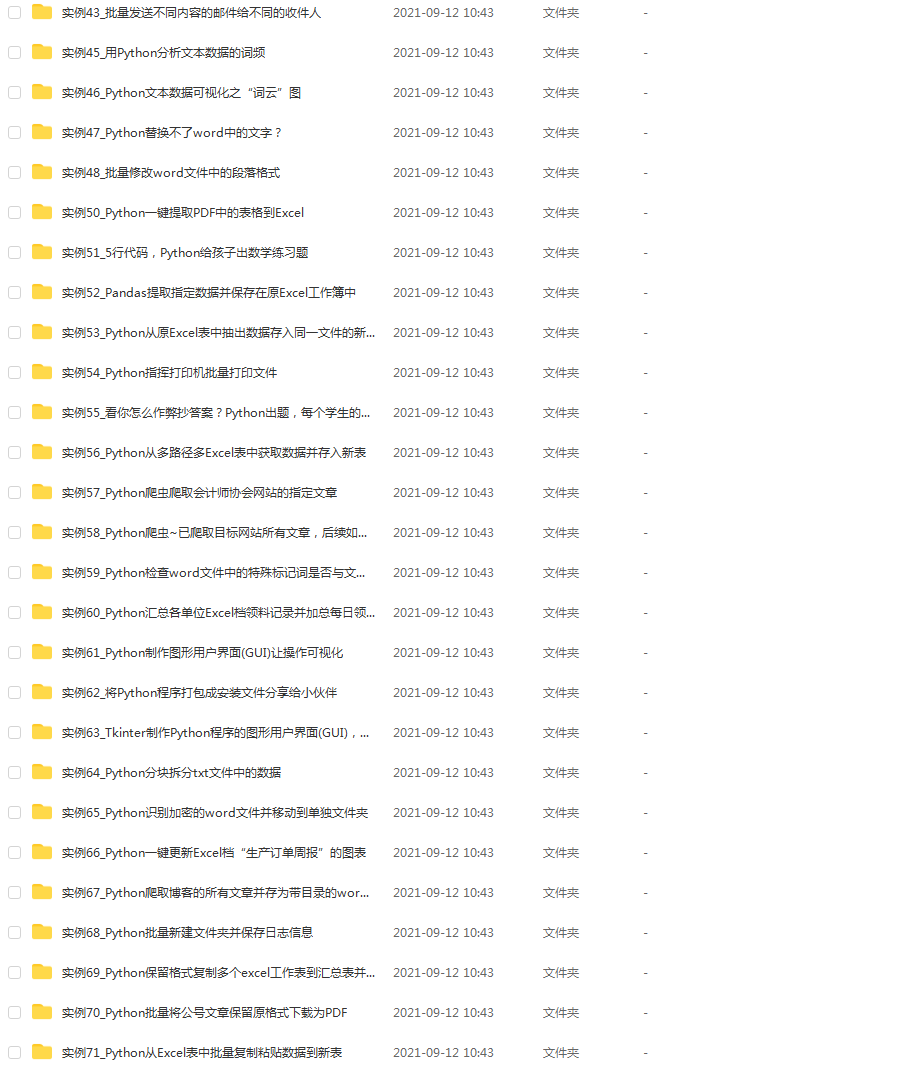

实战中的成果展示

经过这些技术的融合与应用,我成功构建了一个高效的工商数据爬虫系统,不论面对多么复杂的网页,都能快速获取到我所需要的数据。以下是我在项目中使用的核心代码片段,展示了我如何将这些技术集成到爬虫系统中,实现了前所未有的效率和精确度。

import requests

from bs4 import BeautifulSoup

import random

from fake_useragent import UserAgent

proxies = [

"http://12.34.56.78:8080",

"http://23.45.67.89:8080",

]

def get_random_proxy():

return random.choice(proxies)

ua = UserAgent()

headers = {

"User-Agent": ua.random,

}

def fetch_data(url):

try:

proxy = get_random_proxy()

response = requests.get(url, headers=headers, proxies={"http": proxy, "https": proxy}, timeout=10)

if response.status_code == 200:

soup = BeautifulSoup(response.content, 'html.parser')

data = parse_data(soup)

return data

else:

print(f"请求失败,状态码: {response.status_code}")

except Exception as e:

print(f"出现错误: {e}")

def parse_data(soup):

name = soup.find('div', class_='company_name').text.strip()

business_scope = soup.find('div', class_='business_scope').text.strip()

return {

"name": name,

"business_scope": business_scope,

}

url = "https://example.com/company-info"

data = fetch_data(url)

print(data)

![react-antive 項目報錯 [CXX1429] error when building with cmake using](https://i-blog.csdnimg.cn/direct/9bc8da16651c4e77a9184f3e75b971ff.png)