时间:2024年08月17日

作者:小蒋聊技术

邮箱:wei_wei10@163.com

微信:wei_wei10

音频地址:https://xima.tv/1_ZRh54d?_sonic=0

希望大家帮个忙!如果大家有工作机会,希望帮小蒋内推一下,小蒋希望遇到一个认真做事的团队。需要简历可以加我微信。

大家好,欢迎来到小蒋聊技术,小蒋准备和大家一起聊聊技术的那些事。

今天小蒋准备和大家一起聊的技术就厉害了!那就是大数据时代的SQL魔法师Hive!

第一章:挑战的到来——大数据的崛起

在互联网的浪潮下,电商平台如雨后春笋般涌现。每一天,用户在平台上浏览、点击、购买,海量的数据不断生成。面对这些庞大的数据,传统的数据库系统显得力不从心,尤其是在数据存储、处理和查询方面。如何快速高效地处理这些海量数据,成为了一个亟待解决的问题。

第二章:Hive的诞生——简化大数据分析

1. 出现的背景

为了应对大数据带来的挑战,Apache Hadoop应运而生。Hadoop通过分布式存储和计算,解决了海量数据处理的问题。然而,Hadoop的编程模型——MapReduce,对很多数据分析人员来说是复杂且低级的。他们需要一个更简单、更直观的工具来执行数据查询和分析任务。

这时,Hive作为一种解决方案出现了。Hive的目标是简化Hadoop的使用,让用户可以像写SQL一样进行数据查询。它提供了HiveQL语言,这是一种类似SQL的查询语言,使得数据分析变得更加直观和高效。

2. Hive的强大之处

- 易用性:通过类似SQL的HiveQL语言,用户无需掌握复杂的编程技能,即可对数据进行操作。

- 扩展性:Hive能够处理海量数据,适合大规模数据分析任务。

- 与Hadoop的无缝集成:Hive依托Hadoop的分布式存储和计算能力,可以高效处理海量数据。

- 支持多种数据格式:Hive支持各种数据格式,如文本文件、ORC(Optimized Row Columnar)格式等,优化了存储和查询性能。

第三章:Hadoop与Spark——双剑合璧

1. Hadoop与Hive的协作

Hadoop是Hive的基础平台,提供了分布式存储和计算能力。Hive将用户的查询转换为Hadoop的MapReduce作业,然后由Hadoop执行。这样的设计使得Hive能够处理大规模的数据集,并将结果提供给用户,满足了高效分析的需求。

2. Spark的加入——加速数据处理

尽管Hadoop的MapReduce在处理大数据方面表现出色,但在性能上却有一定的局限。Spark的出现弥补了这一不足。Spark以内存计算为核心,能够显著提高数据处理速度,尤其在复杂查询和实时数据分析中表现优越。

Hive与Spark的结合,形成了Hive on Spark的架构。这意味着用户可以利用Hive进行查询,而Spark负责执行这些查询任务,从而大幅提升数据处理的速度。

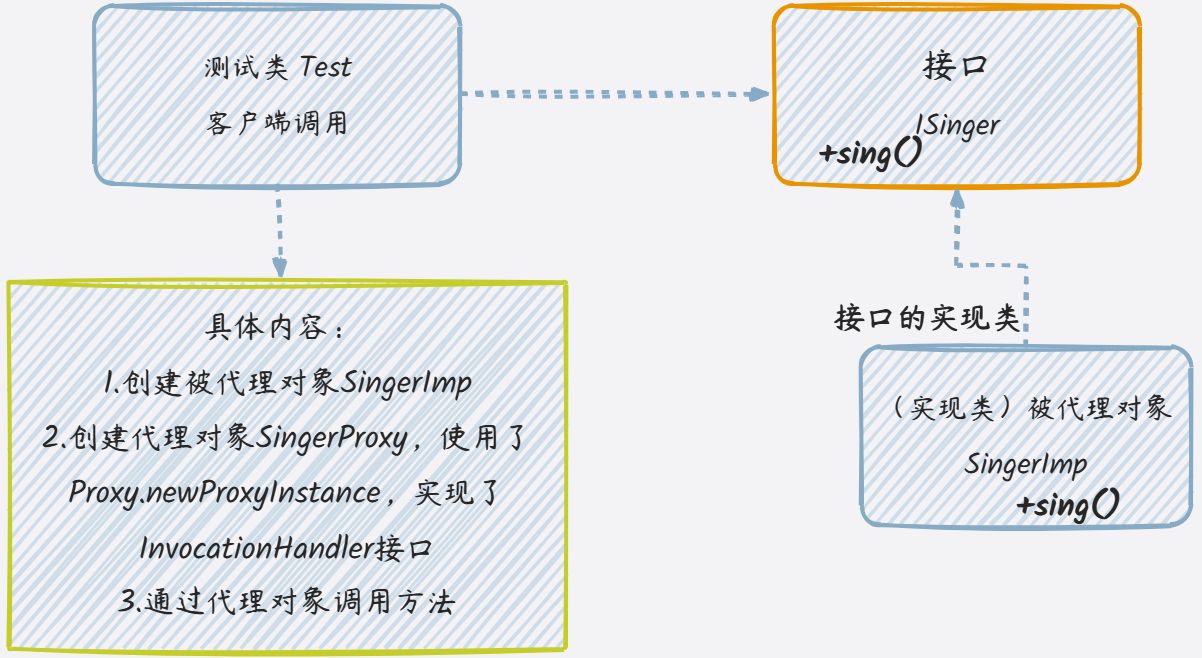

图1:Hive、Hadoop与Spark的协作

3. 强大的协同作用

- 性能提升:Spark的内存计算能力使得Hive查询速度大幅提升,尤其在处理复杂的数据分析任务时表现尤为突出。

- 资源优化:Hadoop负责数据存储和管理,Spark负责高效计算,二者的协作实现了资源的最佳利用。

- 灵活性:根据业务需求,用户可以选择使用Hive on Hadoop或者Hive on Spark,以获得最佳的性能和灵活性。

第四章:电商大数据系统中的应用——赋能业务

为了更好地理解Hive的实际应用场景,让我们来看一个京东的实际案例。京东每天都会产生海量的用户行为数据,比如用户的浏览、点击、搜索和购买记录。这些数据对于京东来说极其宝贵,能够帮助公司分析用户行为、优化商品推荐、并提升整体用户体验。

在没有Hive之前,这些数据通常通过编写复杂的MapReduce程序来进行处理。虽然这种方法可以完成任务,但编写和维护这些程序需要大量时间和技术投入。而且,随着数据规模的增长,编写和优化MapReduce代码的工作变得越来越困难。

引入Hive后,京东的数据分析师和开发者可以通过编写HiveQL查询,快速处理和分析这些海量数据。例如,数据工程师可以用简单的SQL语句将用户的点击行为按商品分类汇总,并生成易于分析的报告。这种方式不仅降低了开发的复杂性,还显著提高了数据处理的效率。

在另一个场景中,京东使用Hive来聚合分析用户的购买行为数据。这些数据经过Hive的处理后,可以为个性化推荐算法提供输入,帮助京东更精准地推送用户感兴趣的商品,从而提升销售转化率。

通过与Hadoop和Spark的结合,京东不仅可以高效地存储和处理海量数据,还能通过Hive快速生成各种分析报告,为业务决策提供及时支持。特别是在面对实时数据分析需求时,Hive结合Spark的使用,能够在短时间内完成复杂的数据处理任务,帮助京东快速响应市场变化。

第五章:结语——从数据到价值的转化

Hive、Hadoop和Spark作为大数据技术中的核心工具,各自承担着重要的角色。Hive简化了数据查询和分析过程,Hadoop提供了强大的存储和计算能力,而Spark则加速了数据处理的速度。在电商大数据系统中,它们的协同工作,不仅提升了数据处理的效率,也为业务决策提供了强大的支持。

小蒋给大家分享的这些内容,希望大家对Hive、Hadoop和Spark的作用有了深入的了解,并能够在实际业务中有效应用这些技术,推动数据驱动决策的成功实施。数据不仅仅是信息的堆积,更是驱动商业价值的关键资产。掌握这些工具,我们将将会由更好地挖掘数据的能力,创造出更大的商业价值。

今天小蒋先和咱们先聊这么多,谢谢大家!