自编码器(Autoencoder, AE):深入理解与应用

引言

自编码器(Autoencoder, AE)是一种通过无监督学习方式来学习数据有效表示的神经网络模型。其核心思想是通过编码器将输入数据压缩成低维潜在表示,然后通过解码器从该表示中重构出原始输入数据。自编码器在数据降维、特征提取、数据去噪、异常检测以及生成模型等领域均展现出卓越的性能。本文将深入探讨自编码器的原理、结构、变体、应用场景、实践案例和面临的挑战与机遇。

背景知识

神经网络基础

神经网络由输入层、隐藏层和输出层组成,通过神经元之间的权重连接进行信息的传递与处理。在训练过程中,利用反向传播算法调整权重以最小化损失函数,从而提升模型的性能。

无监督学习

无监督学习是指在缺乏标签信息的情况下,从数据中学习数据的内在结构和规律。自编码器作为无监督学习的一种重要工具,通过重构输入数据来学习数据的表示。

传送门: 机器学习中的自监督学习与无监督学习是什么意思?

自编码器的历史与发展

自编码器的概念最早可追溯到20世纪80年代,但真正引起广泛关注是在深度学习兴起之后。随着计算能力的提升和大数据的涌现,自编码器逐渐发展成为一种强大的无监督学习模型,并衍生出多种变体以适应不同的应用场景。

自编码器的原理与结构

原理

自编码器由编码器和解码器两部分组成。编码器负责将输入数据映射到低维潜在空间,而解码器则负责从潜在空间重构出原始数据。训练过程旨在最小化重构误差,即原始输入与重构输出之间的差异。

结构

- 编码器:通常包含多个全连接层(或卷积层用于图像数据),用于逐步压缩输入数据到低维潜在空间。

- 解码器:结构通常与编码器相反,负责将潜在表示扩展回原始数据维度,以尽可能接近原始输入。

公式

设输入数据为 x ∈ R D x \in \mathbb{R}^D x∈RD,潜在空间表示为 z ∈ R d z \in \mathbb{R}^d z∈Rd(通常 d < D d < D d<D),重构数据为 x ′ ∈ R D x' \in \mathbb{R}^D x′∈RD。编码器和解码器的操作可以表示为:

- 编码器: z = f ( W x + b ) z = f(Wx + b) z=f(Wx+b),其中 W W W是权重矩阵, b b b是偏置项, f f f是激活函数(如ReLU或sigmoid)。

- 解码器: x ′ = g ( W ′ z + b ′ ) x' = g(W'z + b') x′=g(W′z+b′),其中 W ′ W' W′和 b ′ b' b′分别是解码器的权重矩阵和偏置项, g g g是解码器的激活函数。

训练目标是最小化重构误差,常用的损失函数是均方误差(MSE):

L ( x , x ′ ) = 1 n ∑ i = 1 n ( x i − x i ′ ) 2 L(x, x') = \frac{1}{n} \sum_{i=1}^{n} (x_i - x'_i)^2 L(x,x′)=n1i=1∑n(xi−xi′)2

传送门: 工作中经常听到的Encoder-Decoder结构框架是什么?

激活函数与正则化

- 激活函数:常用的有ReLU和sigmoid。ReLU适用于缓解梯度消失问题,而sigmoid适用于处理概率问题但易导致梯度消失。

- 正则化:为防止过拟合,常采用L2正则化、稀疏正则化或dropout等技术。

自编码器的变体

收缩自编码器(Contractive Autoencoder)

通过在损失函数中添加对编码器输出关于输入的雅可比矩阵的惩罚项,约束编码器的局部变化,学习更稳定的特征表示。

正则自编码器(Regularized Autoencoder)

通过引入L1或L2正则化项限制模型复杂度,防止过拟合。

变分自编码器(Variational Autoencoder, VAE)

在潜在空间引入随机性,使生成的样本具有多样性。通过优化变分下界(ELBO)实现潜在空间的连续采样。

去噪自编码器(Denoising Autoencoder, DAE)

通过向输入数据添加噪声并训练模型去重构原始无噪声数据,提高模型的鲁棒性和泛化能力。

卷积自编码器(Convolutional Autoencoder)

利用卷积层替代全连接层,有效处理图像等具有空间结构的数据,捕获空间层级特征。

稀疏自编码器(Sparse Autoencoder)

通过在激活层上施加稀疏性约束,使编码器只激活少量神经元,学习稀疏且有意义的特征表示。

生成对抗自编码器(Adversarial Autoencoder, AAE)

结合自编码器和生成对抗网络(GAN)的思想,通过对抗训练使潜在空间表示逼近真实数据分布,适用于数据生成和半监督学习。

应用场景

数据降维与特征提取

自编码器通过无监督学习的方式,能够将高维数据有效地压缩到低维潜在空间,实现数据降维和特征提取。这些低维特征不仅减少了数据的计算复杂度,还保留了原始数据的关键信息,为后续的机器学习任务如分类、聚类等提供了有力支持。在图像处理领域,自编码器特别有用,它能够学习图像的低维表示,这些表示可以作为卷积神经网络(CNN)的输入,提升模型的训练速度和性能。

数据去噪

去噪自编码器(Denoising Autoencoder, DAE)是自编码器的一种变体,它通过引入噪声到输入数据,并训练模型以恢复原始无噪声数据的方式工作。这种机制使得去噪自编码器能够学习到数据的更加鲁棒的特征表示,从而有效地从受噪声污染的数据中恢复出原始数据。在语音处理和图像修复中,去噪自编码器展现了强大的能力,能够去除图像噪声、恢复清晰图像,提升语音信号的清晰度。

异常检测

自编码器在异常检测领域同样表现出色。由于自编码器能够学习到数据的正常模式,当输入数据与这些正常模式差异较大时,重构误差会显著增加。这种特性使得自编码器能够识别出异常数据点。在工业监控、金融欺诈检测和网络安全等领域,自编码器已经成为一种重要的异常检测工具。

数据生成

变分自编码器(Variational Autoencoder, VAE)和生成对抗自编码器(Adversarial Autoencoder, AAE)等变体进一步扩展了自编码器的能力,使其能够生成与原始数据分布相似的新数据。在自然语言处理(NLP)中,VAE可以生成新的文本段落;在图像生成领域,AAE和GAN结合的自编码器模型能够生成高质量的图像,为艺术创作、数据增强等领域提供了新的可能性。

医学图像处理

医学图像处理是自编码器应用的另一重要领域。通过对医学图像进行特征提取和降维,自编码器不仅提高了诊断的准确性和效率,还帮助医生更好地理解和分析复杂的医学图像。在肿瘤检测、病变识别等任务中,自编码器展现了其独特的优势,为医学研究和临床实践提供了有力支持。

实践案例:用卷积自编码器进行图像压缩

以下是一个基于卷积自编码器的图像压缩案例,该案例使用TensorFlow框架实现。

import tensorflow as tf

from tensorflow.keras.layers import Conv2D, MaxPooling2D, UpSampling2D

from tensorflow.keras.models import Model, Sequential# 构建卷积自编码器模型

input_img = tf.keras.layers.Input(shape=(28, 28, 1)) # 假设输入图像大小为28x28x1# 编码器部分

x = Conv2D(16, (3, 3), activation='relu', padding='same')(input_img)

x = MaxPooling2D((2, 2), padding='same')(x)

x = Conv2D(8, (3, 3), activation='relu', padding='same')(x)

x = MaxPooling2D((2, 2), padding='same')(x)

x = Conv2D(8, (3, 3), activation='relu', padding='same')(x)

encoded = MaxPooling2D((2, 2), padding='same')(x) # 编码后的潜在表示# 解码器部分

x = Conv2D(8, (3, 3), activation='relu', padding='same')(encoded)

x = UpSampling2D((2, 2))(x)

x = Conv2D(8, (3, 3), activation='relu', padding='same')(x)

x = UpSampling2D((2, 2))(x)

x = Conv2D(16, (3, 3), activation='relu')(x)

decoded = Conv2D(1, (3, 3), activation='sigmoid', padding='same')(x) # 解码后的重构图像# 创建自编码器模型

autoencoder = Model(input_img, decoded)

autoencoder.compile(optimizer='adam', loss='binary_crossentropy')# 打印模型架构

autoencoder.summary()# 注意:此处未包含单独的编码器和解码器模型的创建和训练过程,

# 实际应用中可以根据需要分别训练或使用这些部分。

自编码器的挑战与机遇

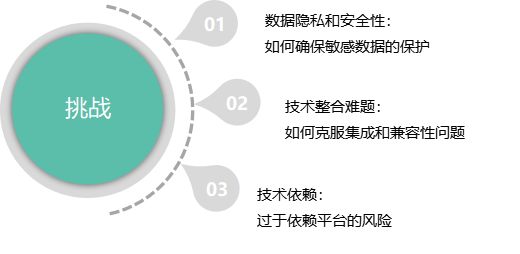

挑战

-

训练困难:深层自编码器在训练过程中容易陷入局部最优解,尤其是在数据量有限的情况下。此外,梯度消失和梯度爆炸问题也可能影响训练效果。

-

超参数调整复杂:自编码器的性能受多种超参数影响,如层数、节点数、激活函数、优化器等。合理地调整这些超参数需要大量的实验和试错,增加了模型开发的复杂性和时间成本。

-

解释性不足:尽管自编码器能够学习到数据的低维表示,但这些表示往往缺乏明确的物理意义或可解释性。特别是在处理复杂数据(如图像、文本)时,理解潜在空间的含义变得尤为困难。

-

计算资源需求大:对于大规模数据集或高维数据,自编码器的训练过程可能需要大量的计算资源,包括高性能的GPU和大量的内存。这限制了在一些资源受限环境中的应用。

机遇

-

更高效的训练方法:随着深度学习算法的不断发展,新的优化算法和训练技巧不断涌现。这些方法如自适应学习率、梯度裁剪、批量归一化等,可以有效提高自编码器的训练效率和稳定性。

-

结合其他模型:将自编码器与其他深度学习模型(如GAN、Transformer、RNN等)结合,可以形成更加强大的复合模型,解决更加复杂的问题。例如,将自编码器与GAN结合可以生成更高质量的图像和文本;与Transformer结合可以处理序列数据中的复杂依赖关系。

-

无监督学习的突破:自编码器作为无监督学习的代表模型之一,其性能的提升将推动整个无监督学习领域的发展。未来,随着无监督学习算法的进一步突破,自编码器有望在更多领域实现创新应用。

-

应用领域的拓展:随着自编码器在数据降维、特征提取、去噪、异常检测、数据生成等方面的不断应用和优化,其应用领域也将不断拓展。除了传统的图像处理、语音识别等领域外,自编码器在生物信息学、物联网、智能制造等新兴领域也将发挥重要作用。

结论

自编码器作为一种强大的无监督学习模型,在数据降维、特征提取、去噪、异常检测和数据生成等方面展现了其独特的优势。尽管面临训练困难、超参数调整复杂、解释性不足和计算资源需求大等挑战,但随着深度学习技术的不断发展和优化方法的不断涌现,自编码器有望在更多领域实现创新应用。未来,我们期待看到更多关于自编码器的研究和应用成果,为数据科学和人工智能领域的发展贡献更多力量。

![BaseCTF [第一周]UPX 迷你](https://i-blog.csdnimg.cn/direct/97ef3dd68fe34c339b231e7d9def5544.png)