NLP之TEA:基于python编程(jieba库)实现中文文本情感分析(得到的是情感评分)

目录

输出结果

设计思路

相关资料

1、关于代码

2、关于数据集

关于留言

1、留言内容的注意事项

2、如何留言?

2.1、第一种方法——在对应的博客下留言

2.2、备用第二种方法——论坛发帖

后续补充发放资料的说明

主要部分代码实现

输出结果

1、测试对象

data1= '今天上海的天气真好!我的心情非常高兴!如果去旅游的话我会非常兴奋!和你一起去旅游我会更加幸福!'

data2= '今天上海天气真差,非常讨厌下雨,把我冻坏了,心情太不高兴了,不高兴,我真的很生气!'

data3= '美国华裔科学家,祖籍江苏扬州市高邮县,生于上海,斯坦福大学物理系,电子工程系和应用物理系终身教授!'

2、输出结果

很明显,data1情感更加积极!data2情感消极!data3情感中等!

[[240.0, 104.0, 8.3, 3.6, 8.0, 2.4]]

[[0.0, 134.0, 0.0, 4.8, 0.0, 3.2]]

[[2, 66, 0.1, 3.3, 0.4, 1.7]]

[[2, 2, 0.1, 0.1, 0.4, 0.4]]

设计思路

后期更新……

相关资料

1、关于代码

NLP之情感分析:基于python编程(jieba库)实现中文文本情感分析(得到的是情感评分)之全部代码

2、关于数据集

如需数据集,请留言向博主索取。

注:当前为学生身份的网友,可留言向博主索取。非学生身份的社会人士,请靠积分下载!

关于留言

1、留言内容的注意事项

- 1、请新增评论,不要直接回复,折叠后,我容易看不到,会漏掉。

- 2、请在前缀加一个索取资料的当天日期。

- 3、切记要留下邮箱!!!

比如留言:“20200307,早上10.11,你好,博主,我的邮箱是,我想索取……”

2、如何留言?

2.1、第一种方法——在对应的博客下留言

即在本博客下直接留言即可!

2.2、备用第二种方法——论坛发帖

在我的论坛中发帖即可,我会及时回复。

地址:https://bbs.csdn.net/topics/395531480

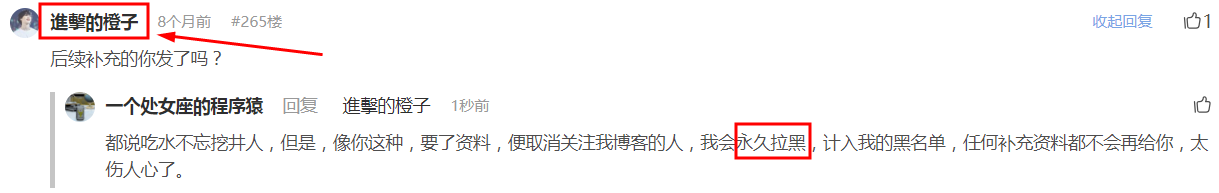

后续补充发放资料的说明

此类网友,太伤人心,这位网友,一定不是大学生,当代大学生的素质肯定比这位网友高的多。

主要部分代码实现

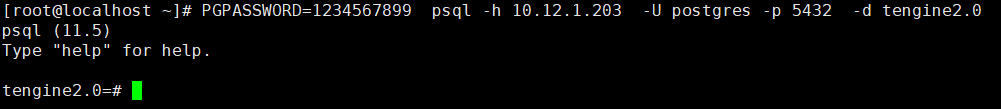

import jieba

import numpy as np……def sentiment_score_list(dataset):seg_sentence = dataset.split('。')count1 = []count2 = []for sen in seg_sentence: #循环遍历每一个评论segtmp = jieba.lcut(sen, cut_all=False) #把句子进行分词,以列表的形式返回i = 0 #记录扫描到的词的位置a = 0 #记录情感词的位置poscount = 0 #积极词的第一次分值poscount2 = 0 #积极词反转后的分值poscount3 = 0 #积极词的最后分值(包括叹号的分值)negcount = 0negcount2 = 0negcount3 = 0for word in segtmp:if word in posdict: # 判断词语是否是情感词poscount += 1c = 0for w in segtmp[a:i]: # 扫描情感词前的程度词if w in mostdict:poscount *= 4.0elif w in verydict:poscount *= 3.0elif w in moredict:poscount *= 2.0elif w in ishdict:poscount *= 0.5elif w in deny_word:c += 1if judgeodd(c) == 'odd': # 扫描情感词前的否定词数poscount *= -1.0poscount2 += poscountposcount = 0poscount3 = poscount + poscount2 + poscount3poscount2 = 0else:poscount3 = poscount + poscount2 + poscount3poscount = 0a = i + 1 # 情感词的位置变化elif word in negdict: # 消极情感的分析,与上面一致negcount += 1d = 0for w in segtmp[a:i]:if w in mostdict:negcount *= 4.0elif w in verydict:negcount *= 3.0elif w in moredict:negcount *= 2.0elif w in ishdict:negcount *= 0.5elif w in degree_word:d += 1if judgeodd(d) == 'odd':negcount *= -1.0negcount2 += negcountnegcount = 0negcount3 = negcount + negcount2 + negcount3negcount2 = 0else:negcount3 = negcount + negcount2 + negcount3negcount = 0a = i + 1elif word == '!' or word == '!': ##判断句子是否有感叹号for w2 in segtmp[::-1]: # 扫描感叹号前的情感词,发现后权值+2,然后退出循环if w2 in posdict or negdict:poscount3 += 2negcount3 += 2breaki += 1 # 扫描词位置前移# 以下是防止出现负数的情况pos_count = 0neg_count = 0if poscount3 < 0 and negcount3 > 0:neg_count += negcount3 - poscount3pos_count = 0elif negcount3 < 0 and poscount3 > 0:pos_count = poscount3 - negcount3neg_count = 0elif poscount3 < 0 and negcount3 < 0:neg_count = -poscount3pos_count = -negcount3else:pos_count = poscount3neg_count = negcount3count1.append([pos_count, neg_count])count2.append(count1)count1 = []return count2def sentiment_score(senti_score_list):score = []for review in senti_score_list:score_array = np.array(review)Pos = np.sum(score_array[:, 0])Neg = np.sum(score_array[:, 1])AvgPos = np.mean(score_array[:, 0])AvgPos = float('%.1f'%AvgPos)AvgNeg = np.mean(score_array[:, 1])AvgNeg = float('%.1f'%AvgNeg)StdPos = np.std(score_array[:, 0])StdPos = float('%.1f'%StdPos)StdNeg = np.std(score_array[:, 1])StdNeg = float('%.1f'%StdNeg)score.append([Pos, Neg, AvgPos, AvgNeg, StdPos, StdNeg])return scoredata1= '今天上海的天气真好!我的心情非常高兴!如果去旅游的话我会非常兴奋!和你一起去旅游我会更加幸福!'

data2= '今天上海天气真差,非常讨厌下雨,把我冻坏了,心情太不高兴了,不高兴,我真的很生气!'

data3= '美国华裔科学家,祖籍江苏扬州市高邮县,生于上海,斯坦福大学物理系,电子工程系和应用物理系终身教授!'

print(sentiment_score(sentiment_score_list(data1)))

print(sentiment_score(sentiment_score_list(data2)))

print(sentiment_score(sentiment_score_list(data3)))