在今天的数字化时代,机器学习和人工智能领域的不断发展为数据处理和预测提供了强大的工具。其中,BP神经网络(反向传播神经网络)作为一种经典的网络模型,因其能够处理复杂的非线性问题而备受关注。然而,传统的BP神经网络在参数优化方面存在局限性,如慢速收敛和易陷入局部最优。为此,本文介绍了一种新的优化算法——秘书鸟优化算法(SBOA),并将其应用于BP神经网络的回归预测中,以改善其性能。

一、SBOA-BP算法概述

1.SBOA秘书鸟算法

秘书鸟优化算法(SBOA)是一种受秘书鸟在自然环境中的生存行为启发的元启发式算法。秘书鸟在捕食和躲避捕食者的过程中展现出卓越的生存能力,这些能力被用来解决现实世界的优化问题。SBOA算法分为两个阶段:探索阶段和利用阶段。探索阶段模拟秘书鸟捕食蛇的过程,而利用阶段则模拟它们逃离捕食者的行为。通过这两个阶段的反复迭代,SBOA能够找到优化问题的最优解。

2.BP神经网络(BP)

BP神经网络通过多层结构和反向传播算法学习数据的复杂模式。其主要优势在于能够处理高维、非线性的任务。尽管BP网络功能强大,但其依赖梯度下降法更新权重的方式,常导致其陷入局部最优解。此外,学习速率的选择对模型的收敛速度和精度有很大影响,因此,改进传统BP网络的方法显得尤为重要。

二、实验步骤

GA-ACO-BP神经网络回归预测步骤:

1.初始化 BP 神经网络

定义 BP 神经网络的结构(如输入层、隐藏层、输出层的神经元数量)。初始化网络参数(权重和偏置)。

2.定义适应度函数

使用 BP 神经网络的误差(如均方误差 MSE)作为适应度函数。目标是最小化这个误差。

3.初始化 SBOA 种群

在搜索空间内随机生成一组候选解,每个解对应于 BP 神经网络的一组权重和偏置。

4.优化过程

(1)计算适应度:对种群中的每个个体,计算其适应度值(即 BP 神经网络的预测误差)。

(2)更新个体位置:使用 SBOA 更新公式调整每个个体的位置,以探索更优的解。

(3)全局最优解更新:在每次迭代后,检查是否找到了更优的全局解,如果有,则更新全局最优解。

5.迭代

继续执行该过程,直至达到设定的最大迭代次数或误差收敛。

6.训练 BP 神经网络

使用 SBOA 优化后的权重和偏置,进一步使用传统的反向传播算法对 BP 神经网络进行微调。对 BP 神经网络进行训练和测试,评估其回归预测性能。

7.模型验证

在训练集和测试集上评估 BP 神经网络的预测性能,计算常见的回归指标(如 R²、MAE、RMSE)。

三、代码部分

import numpy as np

import pandas as pd

import torch

import matplotlib.pyplot as plt

from sklearn.metrics import mean_squared_error, r2_score, mean_absolute_error

import torch.nn as nn

from sklearn.preprocessing import MinMaxScaler

import matplotlib

device = torch.device('cuda' if torch.cuda.is_available() else 'cpu')

matplotlib.rcParams['font.sans-serif'] = ['SimHei']

matplotlib.rcParams['axes.unicode_minus'] = False

from scipy.special import gamma

# 导入数据

data = pd.read_csv('数据集.csv').values# 划分训练集和测试集

np.random.seed(0)

temp = np.random.permutation(len(data))

P_train = data[temp[:80], :7]

T_train = data[temp[:80], 7]

P_test = data[temp[80:], :7]

T_test = data[temp[80:], 7]# 数据归一化

scaler_input = MinMaxScaler(feature_range=(0, 1))

scaler_output = MinMaxScaler(feature_range=(0, 1))

p_train = scaler_input.fit_transform(P_train)

p_test = scaler_input.transform(P_test)

t_train = scaler_output.fit_transform(T_train.reshape(-1, 1)).ravel()

t_test = scaler_output.transform(T_test.reshape(-1, 1)).ravel()# 转换为 PyTorch 张量

p_train = torch.tensor(p_train, dtype=torch.float32).to(device)

t_train = torch.tensor(t_train, dtype=torch.float32).view(-1, 1).to(device)

p_test = torch.tensor(p_test, dtype=torch.float32).to(device)

t_test = torch.tensor(t_test, dtype=torch.float32).view(-1, 1).to(device)# 初始化网络

class BPNetwork(nn.Module):def __init__(self, input_size, hidden_size, output_size):super(BPNetwork, self).__init__()self.hidden = nn.Linear(input_size, hidden_size)self.relu = nn.ReLU()self.output = nn.Linear(hidden_size, output_size)def forward(self, x):x = self.relu(self.hidden(x))x = self.output(x)return xinput_size = p_train.shape[1]

hidden_size = 13

output_size = t_train.shape[1]

model = BPNetwork(input_size, hidden_size, output_size).to(device)# 损失函数

criterion = nn.MSELoss()class SBOA:def __init__(self, model, population_size, max_generations, bounds, device):self.model = modelself.population_size = population_sizeself.max_generations = max_generationsself.bounds = boundsself.device = device四、实验与结果

1.数据集准备

为了验证SBOA-BP算法的有效性,我们选择了某领域的一组数据集进行实验。数据集包括多个输入特征和对应的目标输出,用于训练和测试模型。下面所示我们本次采用的数据集(部分)。

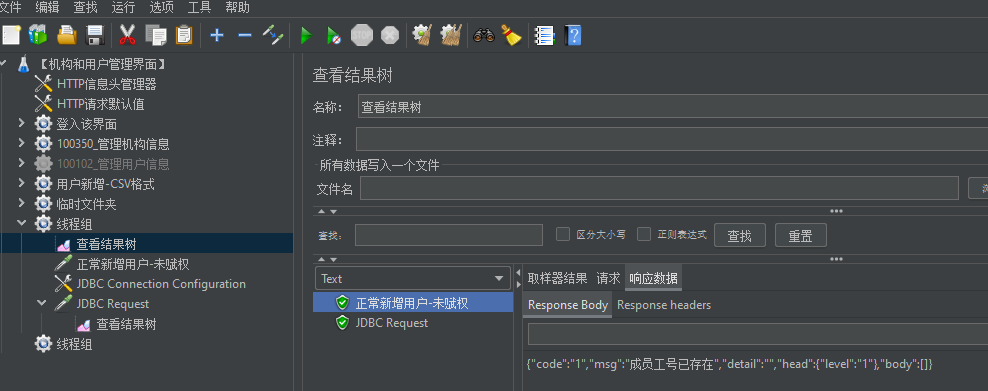

2.结果分析

在实验过程中,我们使用波士顿房价数据集对SBOA-BP神经网络进行了训练和验证。结果表明,SBOA-BP神经网络在预测精度和收敛速度方面均优于传统BP神经网络。以下是部分实验结果的展示:

五、结论

本文介绍了一种基于SBOA-BP神经网络的回归预测方法,并通过实验验证了其优越性。SBOA算法通过模拟秘书鸟的生存行为,为BP神经网络的参数优化提供了一种高效的替代方案。在未来的研究中,可以进一步探索SBOA算法在其他领域的应用,并不断优化其性能。

![[数据集][目标检测]玻璃瓶塑料瓶检测数据集VOC+YOLO格式8943张2类别](https://i-blog.csdnimg.cn/direct/4fe096af5d024754a1a8c35559c28738.png)