第二篇章 Dify接入 Xinference 部署的本地模型

1. 安装Dify

克隆 Dify 源代码至本地。

git clone https://github.com/langgenius/dify.git2. 启动Dify

进入 Dify 源代码的 docker 目录,执行一键启动命令:

cd dify/docker

cp .env.example .env

docker compose up -d如果您的系统安装了 Docker Compose V2 而不是 V1,请使用

docker compose而不是docker-compose。通过$ docker compose version检查这是否为情况。在这里信息。

3. 检查Dify是否成功运行

最后检查是否所有容器都正常运行:

docker compose ps

4. 访问Dify

在浏览器中输入 http://localhost 访问 Dify。

5. 单独启动前端 Docker 容器

ps:由于默认端口是80,很可能与我们部署的其他服务冲突。所以可以使用下面方法修改端口

当单独开发后端时,可能只需要源码启动后端服务,而不需要本地构建前端代码并启动,因此可以直接通过拉取 docker 镜像并启动容器的方式来启动前端服务,以下为具体步骤(方式二选一即可):

方式一:直接使用 DockerHub 镜像

docker run -it -p 3000:3000 -e CONSOLE_API_URL=http://127.0.0.1:5001 -e APP_API_URL=http://127.0.0.1:5001 langgenius/dify-web:latest方式二:源码构建 Docker 镜像

-

构建前端镜像

cd web && docker build . -t dify-web -

启动前端镜像

docker run -it -p 3000:3000 -e CONSOLE_API_URL=http://127.0.0.1:5001 -e APP_API_URL=http://127.0.0.1:5001 dify-web -

当控制台域名和 Web APP 域名不一致时,可单独设置

CONSOLE_URL和APP_URL

本地访问 http://127.0.0.1:3000

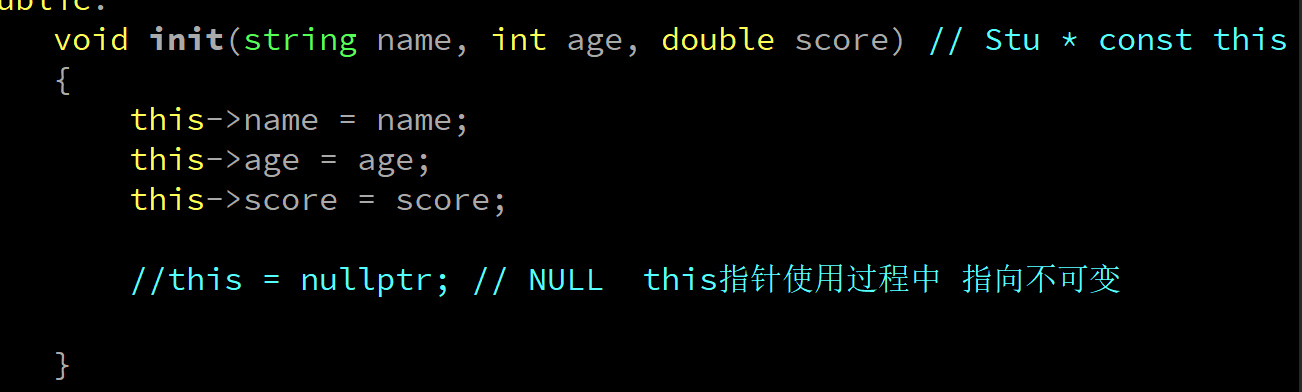

6. Dify接入Xinference

模型部署完毕,在 Dify 中使用接入模型(点击头像->设置->模型供应商->Xorbits Inference)

在 设置 > 模型供应商 > Xinference 中填入:

-

模型名称:

vicuna-v1.3 -

服务器 URL:

http://<Machine_IP>:9997替换成您的机器 IP 地址 -

模型 UID:

2c886330-8849-11ee-9518-43b0b8f40bea

"保存" 后即可在应用中使用该模型。

注意:因为我们的Dify是部署到了Docker中,而Xinference服务是在宿主机上,所以Dify是无法直接访问宿主机上的localhost的,需要通过:host.docker.internal:9997 访问

参考文章:

① https://docs.dify.ai/v/zh-hans/guides/model-configuration/xinference

② Docker Compose 部署 | 中文