在容器化环境中打包CUDA和PyTorch基础环境,可以将所有相关的软件依赖和配置封装在一个Docker镜像中。这种方法确保了在不同环境中运行应用程序时的一致性和可移植性:

-

Docker:提供了容器化技术,通过将应用程序及其所有依赖打包在一个镜像中,确保不同环境下的运行一致性。

-

CUDA:NVIDIA的并行计算平台和编程模型,用于加速计算密集型应用程序,如深度学习。

-

PyTorch:流行的深度学习框架,提供灵活的模型构建和训练功能,支持GPU加速。

-

NVIDIA Docker:利用

nvidia-docker工具,允许Docker容器访问宿主机上的GPU资源,实现CUDA加速。 -

Dockerfile:定义镜像内容的文本文件,指定如何安装CUDA、PyTorch及其依赖。

意义:

-

一致性:容器确保在不同开发和生产环境中使用相同的CUDA和PyTorch版本,减少了因环境差异导致的问题。

-

可移植性:Docker镜像可以在任何支持Docker的系统上运行,包括本地机器、云服务和集群环境,提高了应用程序的可移植性。

-

隔离:通过容器隔离运行环境,避免了不同应用程序之间的依赖冲突和系统污染。

-

简化部署:预配置的Docker镜像简化了部署流程,减少了配置和安装的复杂性,特别是在涉及多个版本和依赖时。

-

版本管理:方便管理和切换不同版本的CUDA和PyTorch环境,以适应不同的需求或测试要求。

通过这些技术和方法,可以在Docker容器中创建一个稳定、可移植的深度学习环境,显著提升开发和部署效率。

一、拉取cuda11.8基础镜像

docker pull nvidia/cuda:11.8.0-cudnn8-devel-ubuntu22.04

docker images

docker run -ti --name work nvidia/cuda:11.8.0-cudnn8-devel-ubuntu22.04 bash

二、环境配置

安装python和pip:

apt-get updateapt-get install wget安装Anaconda3

wget https://repo.anaconda.com/archive/Anaconda3-2023.07-1-Linux-x86_64.sh

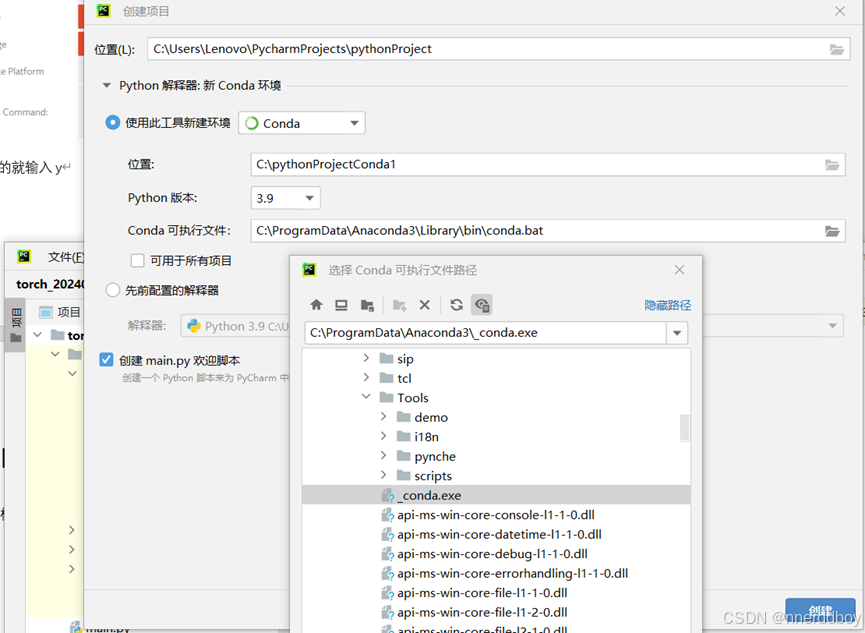

bash Anaconda3-2023.07-1-Linux-x86_64.shconda create -n f python=3.9conda install pytorch==2.3.1 torchvision==0.18.1 torchaudio==2.3.1 pytorch-cuda=11.8 -c pytorch -c nvidia至此,cuda11.8,cudnn,python3.9,pytorch安装完成。

Ctrl+D退出镜像。

三、镜像打包

docker commit -a "work" -m "cuda118" fd83c27fa8f5 cuda118:v1docker save cuda118 -o cuda118.tarsave将docker镜像保存为tar格式,放入服务器后,使用load,镜像就在服务器中了。

docker load -i cuda118.tar