文章目录

- 摘要

- Abstract

- 数据挖掘

- 数据挖掘的目标

- 数据挖掘的过程

- 数据挖掘的技术

- 应用领域

- 工具与平台

- 代码示例

- 总结

摘要

智慧水务项目中,需要对采集的总氮、氨氮、化学需氧量、硝态氮、总磷、硝态氮等数据进行数据处理与挖掘,因此本周对数据挖掘相关内容进行初步学习,数据挖掘是指从大量的数据中通过算法和模型发现有用信息和知识的过程。

Abstract

In the Intelligent Water project, it is necessary to process and mine the collected data such as total nitrogen, ammonia nitrogen, chemical oxygen demand, nitrate nitrogen, total phosphorus, and nitrate nitrogen. Therefore, this week we will conduct preliminary learning on data mining related content. Data mining refers to the process of discovering useful information and knowledge from a large amount of data through algorithms and models.

数据挖掘

数据挖掘(Data Mining)是从大量数据中提取有用信息的过程,这些信息以人类可理解的模式呈现出来,可以用来做出决策或发现知识。数据挖掘涉及多种技术和方法,它融合了统计学、机器学习、数据库技术等多个领域的知识。以下是数据挖掘的一些关键概念和步骤:

数据挖掘的目标

- 知识发现:从大量的数据中发现隐藏的、有效的、新颖的、潜在有用的信息和知识。

- 预测建模:建立模型来预测未来的趋势或行为。

- 描述性建模:总结数据的主要特征,以便更好地理解数据集。

数据挖掘的过程

- 业务理解:明确业务目标,确定需要解决的问题。

- 数据理解:收集和探索数据,理解其结构和内容。

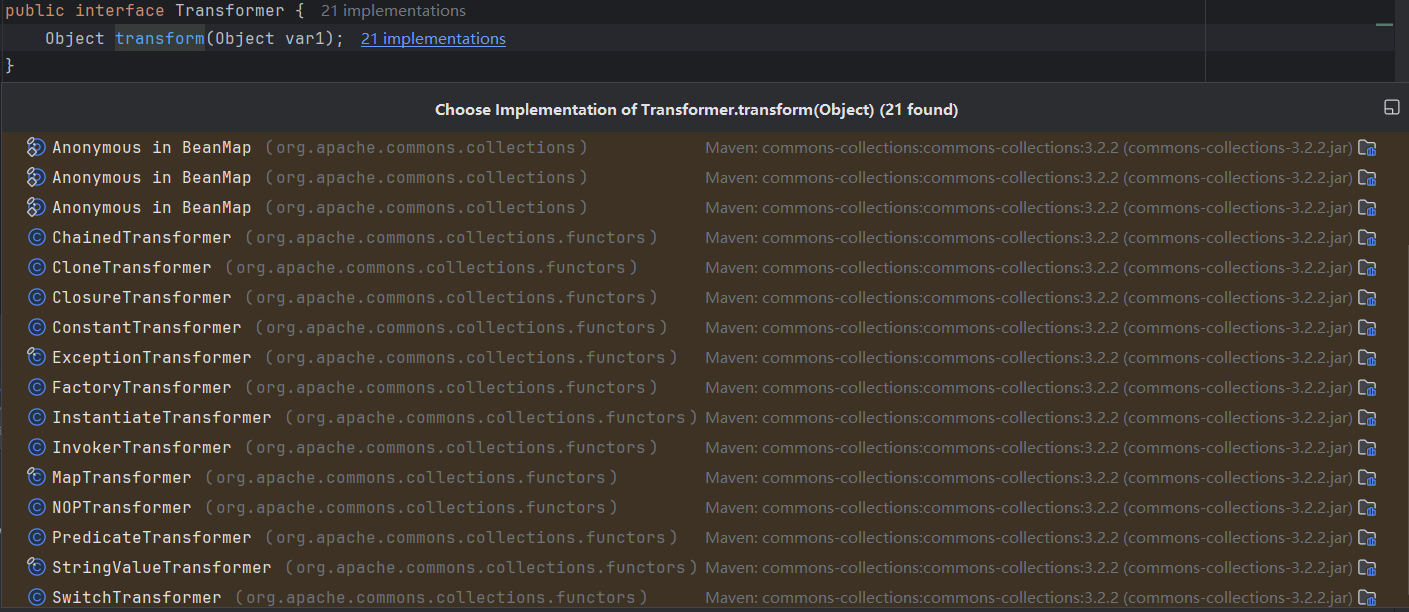

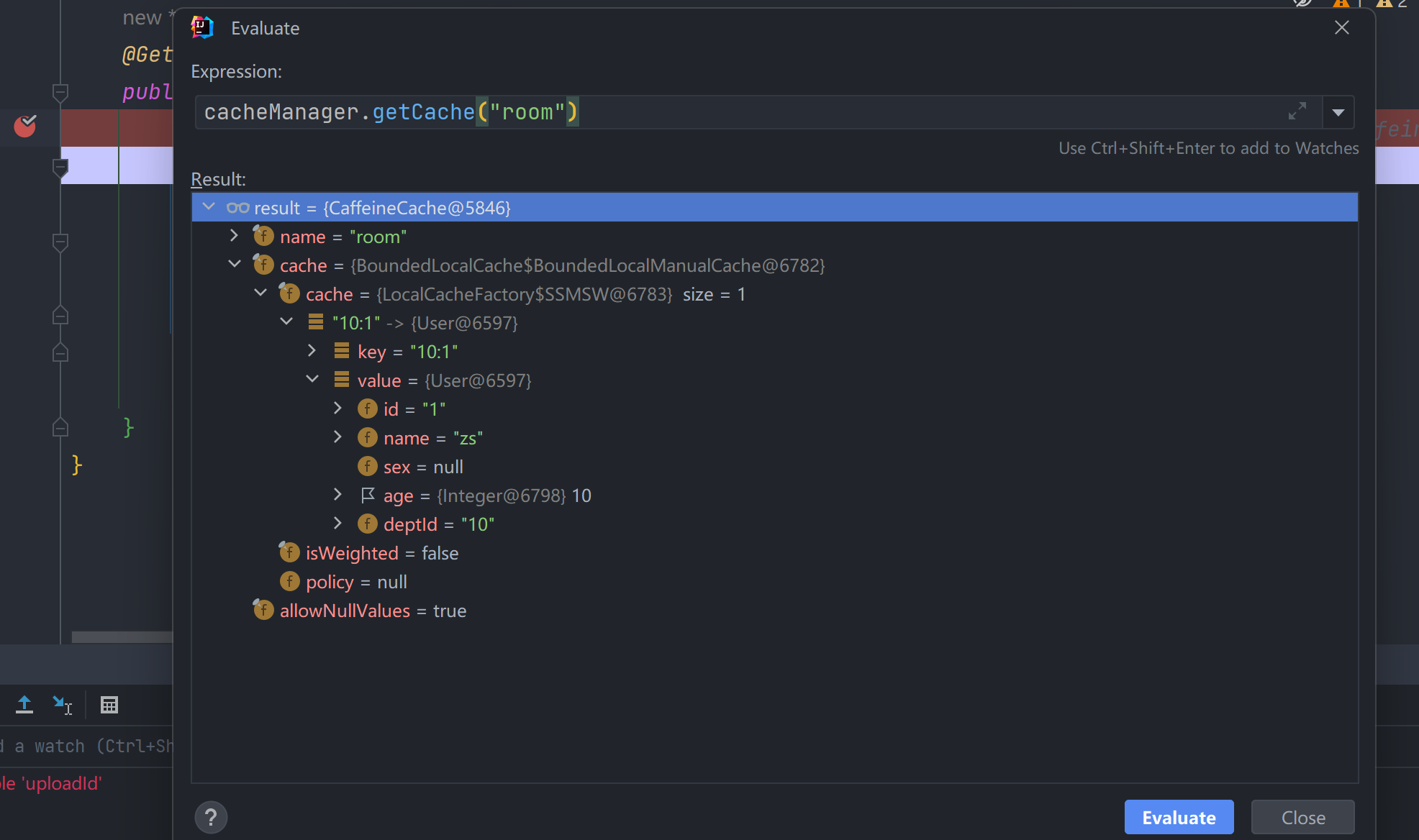

- 数据准备:清洗数据,处理缺失值、异常值,转换数据格式等。

- 建模:应用统计和机器学习算法来构建模型。

- 评估:验证模型的有效性和实用性。

- 部署:将模型应用于实际业务场景,获取商业价值。

数据挖掘的技术

- 分类:预测数据属于某个特定类别的概率。

- 回归:预测一个连续值的结果。

- 聚类:将相似的数据点分组在一起。

- 关联规则学习:发现数据集中项目的相关性或依赖性。

- 异常检测:识别不符合预期模式的数据点。

- 降维:减少数据的维度,简化分析过程。

应用领域

数据挖掘广泛应用于各个行业,包括但不限于金融(信用评分)、零售(购物篮分析)、医疗(疾病预测)、电信(客户流失预测)、营销(客户细分)等。

工具与平台

有许多工具和技术可用于数据挖掘,如Python的Pandas、NumPy、SciPy、Scikit-Learn,R语言,SQL数据库,以及专门的数据挖掘软件如Weka、RapidMiner、KNIME等。

数据挖掘是一个跨学科的领域,它不仅需要掌握技术知识,还需要具备一定的业务洞察力,以便能够正确解释挖掘出的知识并将其转化为实际的应用价值。

代码示例

- 分类 (Classification)

分类是一种监督学习方法,任务是将数据分为预定义的类别。常见的算法包括决策树、支持向量机、K近邻等。

例子:用决策树进行分类

假设我们有一组关于鸢尾花的数据集,目标是根据花的特征预测它的种类。

# 导入必要的库

from sklearn.datasets import load_iris

from sklearn.model_selection import train_test_split

from sklearn.tree import DecisionTreeClassifier

from sklearn.metrics import accuracy_score# 加载数据集

iris = load_iris()

X = iris.data # 特征

y = iris.target # 目标# 拆分训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.3, random_state=42)# 创建决策树分类器

clf = DecisionTreeClassifier()# 训练模型

clf.fit(X_train, y_train)# 预测测试集

y_pred = clf.predict(X_test)# 计算准确率

accuracy = accuracy_score(y_test, y_pred)

print(f'决策树分类的准确率: {accuracy:.2f}')运行结果如下:

2. 聚类 (Clustering)

聚类是一种无监督学习方法,任务是将数据点根据相似性分成若干簇。常见算法有K均值(K-Means)、层次聚类等。

例子:使用K-Means进行聚类

我们可以用K-Means算法将鸢尾花数据集分成三类。

# 导入必要的库

from sklearn.cluster import KMeans

import matplotlib.pyplot as plt# 加载数据集

X = iris.data# 创建K-Means模型,假设有3类

kmeans = KMeans(n_clusters=3, random_state=42)# 训练模型

kmeans.fit(X)# 获取聚类结果

y_kmeans = kmeans.predict(X)# 可视化聚类结果

plt.scatter(X[:, 0], X[:, 1], c=y_kmeans, cmap='viridis')

plt.title('K-Means聚类结果')

plt.xlabel('特征1')

plt.ylabel('特征2')

plt.show()运行结果如下:

- 关联规则挖掘 (Association Rule Mining)

关联规则挖掘的目的是找出数据集中项目之间的有趣关系,常用于市场购物篮分析。常见算法包括Apriori和FP-growth。

例子:使用Apriori算法进行关联规则挖掘

假设我们有一组购物交易数据,目标是找出产品之间的关联规则。

# 导入必要的库

from mlxtend.frequent_patterns import apriori, association_rules

import pandas as pd# 构造一个简单的购物篮数据

data = {'牛奶': [1, 0, 1, 1, 0],'面包': [1, 1, 0, 1, 0],'啤酒': [0, 1, 1, 0, 1],'鸡蛋': [1, 0, 0, 1, 0],'苹果': [0, 1, 1, 0, 1]}

df = pd.DataFrame(data)# 使用Apriori算法找到频繁项集

frequent_itemsets = apriori(df, min_support=0.6, use_colnames=True)# 生成关联规则

rules = association_rules(frequent_itemsets, metric="lift", min_threshold=1.0)print(frequent_itemsets)

print(rules)运行结果如下:

- 异常检测 (Anomaly Detection)

异常检测是识别数据中不符合预期模式的异常点的过程,常用于信用卡欺诈检测、网络安全等。

例子:使用Isolation Forest进行异常检测

我们可以使用Isolation Forest来检测数据集中的异常点。

# 导入必要的库

from sklearn.ensemble import IsolationForest

import numpy as np# 生成随机数据,其中一部分是异常点

rng = np.random.RandomState(42)

X = 0.3 * rng.randn(100, 2)

X = np.r_[X + 2, X - 2] # 正常点

X = np.r_[X, rng.uniform(low=-4, high=4, size=(20, 2))] # 添加一些异常点# 训练Isolation Forest模型

clf = IsolationForest(random_state=42)

clf.fit(X)# 预测数据中的异常点

y_pred = clf.predict(X)# 正常点为1,异常点为-1

print(y_pred)运行结果如下:

5.降维

常用的降维方法包括主成分分析(PCA)、线性判别分析(LDA)和t-SNE等。

例子:使用PCA进行降维

假设我们有一个包含多个特征的二维数据集,我们可以使用PCA将数据从多维降到二维或者一维。

import numpy as np

import matplotlib.pyplot as plt

from sklearn.decomposition import PCA

from sklearn.datasets import load_iris# 加载示例数据集(Iris数据集)

data = load_iris()

X = data.data # 特征

y = data.target # 标签# 使用PCA进行降维(将数据从4维降到2维)

pca = PCA(n_components=2)

X_pca = pca.fit_transform(X)# 可视化降维后的数据

plt.figure(figsize=(8, 6))

plt.scatter(X_pca[:, 0], X_pca[:, 1], c=y, cmap='viridis', edgecolor='k', s=100)

plt.title('PCA on Iris Dataset')

plt.xlabel('First Principal Component')

plt.ylabel('Second Principal Component')

plt.colorbar(label='Class')

plt.show()运行结果如下:

总结

智慧水务项目中需要对采集的数据进行预处理和挖掘特征,通过实时数据进行大数据处理,形成目标数据集,这是进行下一步的基础,故对数据挖掘也进行学习。