LLM的核心是通过对语言进行建模来生成自然语言输出或理解输入,两个重要的概念在其中发挥关键作用:Tokenizer 和 Embedding。本篇文章将对这两个概念进行入门级介绍,并提供了针对前端的js示例代码,帮助读者理解它们的基本原理/作用和如何使用。

1. 什么是Tokenizer?

Tokenizer 是一种将自然语言文本转化为模型可以处理的数字表示的工具。自然语言是由词、子词或字符组成的,而模型无法直接处理这些符号,它们只能处理数字。因此,Tokenizer的主要任务就是将文本转换为一系列数字。

1.1 Tokenizer的工作原理

Tokenizer通过查表的方式,将每个单词、子词或者字符映射为一个唯一的整数ID。这些整数ID作为模型的输入,帮助模型将语言处理为结构化的形式。

以句子“我喜欢学习”为例,一个简单的Tokenizer可能将其分解为每个汉字,并为每个汉字分配一个唯一的整数ID,如下:

- “我” -> 1

- “喜欢” -> 2, 3

- “学习” -> 4, 5

在实际应用中,很多语言模型使用更复杂的分词方式,如子词分割。子词分割允许模型将罕见词分割为多个子词单元,从而提升泛化能力。例如,常见的子词分割方法包括BPE(Byte Pair Encoding)和WordPiece,这些方法可以将长词拆分为更小的、频率更高的子词,增强模型处理罕见词汇的能力。

1.2 Tokenizer的种类

- 词级别(Word-level)Tokenizer:将每个词作为一个Token。适用于语言如英文等分隔明确的文本,但对于中文等无空格分隔的语言不太适合。

- 子词级别(Subword-level)Tokenizer:基于统计方法,将文本分割为高频子词单元。BPE和WordPiece是常见的子词分割算法。

- 字符级别(Character-level)Tokenizer:将每个字符视为一个Token。这种方法适用于字符构成较复杂的语言(如中文),但会导致较长的序列输入。

1.3 为什么需要Tokenizer?

- 将文本转化为数字:语言模型需要处理的是数字而不是文本。Tokenizer将文本符号转换为数字ID,是进入模型的第一步。

- 词汇管理:通过分词,Tokenizer建立了一个词汇表,其中每个词或子词都对应一个唯一的ID。这让模型可以在推理时迅速查找词的表示。

- 提升模型的泛化能力:通过分词,特别是子词分词,模型能够处理罕见词和新词,因为它可以将新词拆解为更小的子词单元,避免出现完全未知的词。

1.4 Tokenizer 示例代码

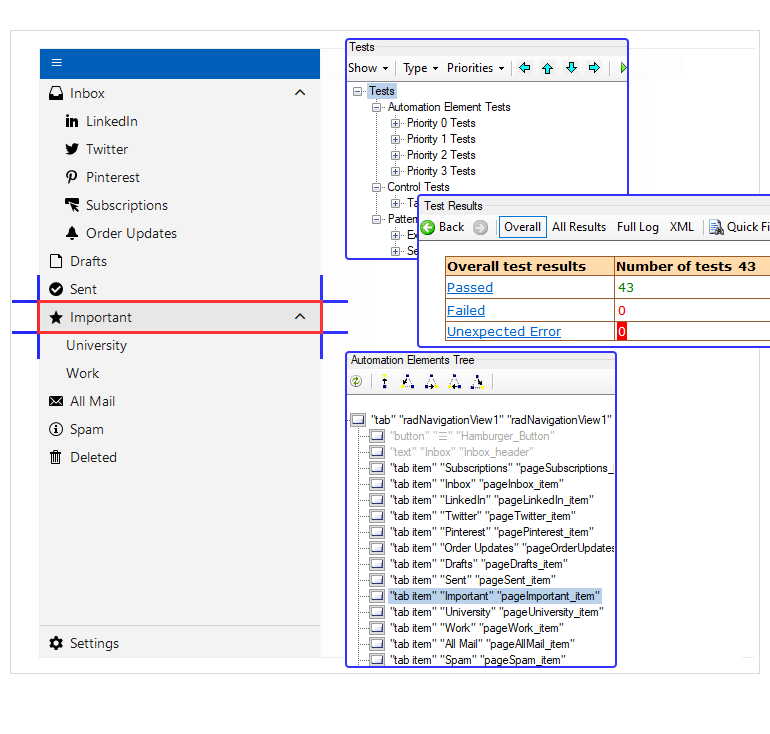

其实python相关的库比较多,这里就用一个0依赖的js库来测试,自己也可以子串匹配实现。

npm install @lenml/tokenizersimport { fromPreTrained } from "@lenml/tokenizer-llama3";

const tokenizer = fromPreTrained();

const tokens = tokenizer.apply_chat_template([{role: "system",content: "你是一个有趣的ai助手",},{role: "user",content: "好好,请问怎么去月球?",},]

) as number[];// 转化成token的数组

console.log(tokens);const chat_content = tokenizer.decode(tokens);// 还原了的数据

console.log(chat_content);2. 什么是Embedding?

Embedding 是将Tokenizer生成的整数ID转化为稠密的向量表示的过程。与Tokenizer将文本转换为离散的整数ID不同,Embedding生成的是连续的实数值向量,这些向量能够捕捉词之间的语义关系。

2.1 Embedding的工作原理

在Embedding阶段,语言模型通过查表的方式,将每个整数ID映射到一个高维向量空间中的向量。这个向量通常是一个固定维度的向量(例如,300维、512维或768维),用来表示单词或子词的语义特征。

例如,经过Tokenizer处理的文本“我喜欢学习”可能会生成整数ID序列 [1, 2, 3, 4, 5]。在Embedding阶段,这些ID会被转换为稠密向量表示,如:

- “我” ->

[0.25, -0.34, 0.15, ...] - “喜欢” ->

[0.12, 0.57, -0.22, ...], [0.11, -0.09, 0.31, ...] - “学习” ->

[0.33, -0.44, 0.19, ...], [0.09, 0.23, -0.41, ...]

这些向量并不是随机生成的,它们是在模型的训练过程中被学习得到的。Embedding向量的维度固定,但向量的数值根据模型对词语上下文的理解不断更新和优化,最终形成一个语义丰富的向量表示。

2.2 Embedding的种类

- 词向量(Word Embedding):如Word2Vec、GloVe等方法,通过静态词向量将词语映射到向量空间中。这些方法的Embedding是静态的,即同一个词在不同上下文中具有相同的向量。

- 上下文相关的Embedding:如BERT、GPT等方法生成的Embedding,是基于上下文的动态向量。同一个词在不同的上下文中可能有不同的向量表示,从而更加精准地捕捉语言中的多义性和语境变化。

2.3 为什么需要Embedding?

- 捕捉词之间的语义关系:通过Embedding,模型可以将语义相似的词表示为相近的向量。例如,“猫”和“狗”的向量在空间中可能非常接近,而“猫”和“车”的向量则会相距较远。

- 连续性表示:与离散的整数ID不同,Embedding向量是连续的。这使得模型能够更好地进行计算和优化,因为连续的数值表示可以更容易进行梯度计算和模型学习。

- 语义压缩:Embedding将高维的语言信息压缩到一个固定的向量空间中,这样模型就可以高效地处理输入并捕捉到其中的重要语义特征。

2.4 使用 TensorFlow.js实现一个嵌入层

接下来,我们用 TensorFlow.js 来实现一个简单的Embedding层。

首先安装 TensorFlow.js:

npm install @tensorflow/tfjs

然后我们创建一个简单的Embedding层,将Token IDs转换为对应的Embedding向量。

const tf = require('@tensorflow/tfjs');// 假设词汇表大小为10000,嵌入维度为300

const vocabSize = 10000;

const embeddingDim = 300;// 创建一个Embedding层

const embeddingLayer = tf.layers.embedding({inputDim: vocabSize, outputDim: embeddingDim});// 输入是之前Tokenizer的Token IDs

const tokenIds = tf.tensor([[1045, 2293, 4083]]); // Batch size为1,三个Token// 使用Embedding层将Token IDs转化为Embedding向量

const embeddings = embeddingLayer.apply(tokenIds);embeddings.print(); // 输出Embedding结果

在这个示例中,我们定义了一个词汇表大小为10000、嵌入维度为300的Embedding层。tokenIds代表之前从Tokenizer生成的Token ID序列,经过Embedding层后,生成对应的300维度的稠密向量。

注意下tfjs在浏览器和nodejs的时候不同的backend性能和表现有点差异,但基本可用,详细接口参考TensorFlow.js API

另外有时候进行向量化比较吃资源,或者需要处理大量文本和超高向量时,可使用各个AI平台提供的接口,一般叫做嵌入/向量化/句向量等

3. Tokenizer和Embedding的关系

在LLM中,Tokenizer和Embedding是文本处理的两个连续步骤:

- Tokenizer负责将文本分割为Token,并将这些Token映射为离散的整数ID。

- Embedding则将这些整数ID进一步转化为稠密的向量表示,以便模型能够进行深度学习和优化。

它们的关系可以简单总结为:Tokenizer将语言中的离散符号表示成模型可以识别的离散ID,而Embedding则将这些离散ID转化为连续的向量,以便捕捉词之间的语义关系。

4. 总结

在大规模语言模型(LLM)中,Tokenizer和Embedding是两个基础且关键的步骤。Tokenizer通过分词和映射,将文本转化为模型可以处理的数字序列。而Embedding则将这些数字序列进一步转化为语义丰富的向量表示。这两个步骤共同构成了LLM处理自然语言输入的基础,为模型的语义理解和生成提供了强大的支持。

对于初学者来说,理解Tokenizer和Embedding的作用及其背后的原理,将为深入学习LLM及其应用打下坚实的基础。

看了这么多,作为前端的你,还不赶紧npm install一下然后测试测试? ps: tfjs有cdn版本,简单测试可以直接用url引入,可能比安装更简单就是要等待