大家好,我是微学AI,今天给大家介绍一下计算机视觉必备模型YOLO系列模型的知识点,提供YOLOv1-v8模型结构与代码实例。本文全面介绍了计算机视觉领域中必备的YOLO系列模型,详细梳理了YOLOv1至YOLOv8模型的结构及其演变过程。文章内容涵盖了各个版本模型的核心知识点,并通过代码样例展示了模型的具体实现。本文旨在帮助读者深入理解YOLO系列模型,为相关研究和应用提供有价值的参考。

文章目录

- 一、YOLO 系列模型概述

- 1.1 YOLO 系列的重要性与背景

- 1.2 YOLO 发展历程概览

- 1.3 主要特点与应用

- 二、YOLOv1 模型详解

- 2.1 YOLOv1 模型结构概览

- 2.1.1 输入层与图像预处理

- 2.1.2 骨干网络:Darknet-19

- 2.1.3 颈部结构:特征融合

- 2.1.4 头部:多任务输出

- 2.2 核心思想与回归预测

- 2.2.1 损失函数详解

- 2.3 结构与性能评估

- 三、YOLOv2-v7 模型特点

- 3.1 YOLOv2: 更快速与精确的演进

- 3.2 YOLOv3: 多尺度检测的创新

- 3.3 YOLOv4: 性能与效率的极致平衡

- 3.4 YOLOv5: 实现与社区的互动

- 3.5 YOLOv6: 架构优化与轻量化探索

- 3.6 YOLOv7: 结构与算法的综合进化

- 四、YOLOv8 模型深度剖析

- 4.1 YOLOv8 模型结构与设计理念

- 4.1.1 结构革新

- 4.1.2 优势与亮点

- 检测精度与速度的平衡

- 实时性与轻量化

- 易用性与灵活性

- 4.2 与YOLO前代版本的差异

- 4.2.1 结构差异

- 4.2.2 性能跃进

- 4.3 新技术与方法的应用

- 五、YOLO 系列代码样例

- 5.1 使用YOLOv1进行目标检测

- 5.1.1 导入必要库与加载模型

- 5.1.2 数据预处理

- 5.1.3 进行预测

- 5.2 至 YOLOv7的代码示例简化展示

- 5.2.1 使用Darknet框架或相应库

- 5.3 YOLOv8的代码样例

- 5.3.1 代码解析

- 结语

一、YOLO 系列模型概述

计算机视觉作为人工智能领域的一个重要分支,近年来取得了飞速的发展,而目标检测作为其基础且关键的任务之一,更是吸引了众多研究者的关注。在这片技术热土上,YOLO(You Only Look Once)系列模型以其创新的设计理念和卓越的性能表现,成为了目标检测领域的明星算法,广泛应用于监控、自动驾驶、图像识别等多个场景。

1.1 YOLO 系列的重要性与背景

自2015年Joseph Redmon首次提出YOLO以来,这一系列模型便在计算机视觉界引起了轰动。不同于传统两阶段目标检测方法(如R-CNN系列),YOLO采取了一种端到端、实时的目标检测策略,革命性地将目标检测问题从分类和定位两个独立任务合并为一个统一的过程。这一大胆的设计不仅大幅提升了检测速度,同时也保持了相对较高的准确率,为实时性要求高的应用场景打开了新的大门。

1.2 YOLO 发展历程概览

从初代YOLOv1到最新的YOLOv8,这一系列模型经历了多次迭代与优化,每一代都在前代基础上有所突破:

-

YOLOv1(2015):奠定了YOLO系列的基础框架,首次实现了直接从全图输入到边界框输出的端到端学习,虽然精度略逊于当时顶尖的两阶段模型,但其超快的速度(接近实时处理)为其赢得了广泛关注。

-

YOLOv2(2016):通过引入批量归一化、高分辨率分类器预训练、多尺度训练等技术,显著提升了模型的精度,同时保持了高速度,标志着YOLO正式步入高性能模型行列。

-

YOLOv3至YOLOv7:这些年间,YOLO系列不断演进,通过引入特征金字塔网络(FPN)、锚框机制的改进、计算量的优化等措施,逐步提高了检测精度并降低了资源消耗,同时保持了快速响应的特点。

-

YOLOv8(最新):作为目前该系列的巅峰之作,YOLOv8采用了更为先进的训练策略和优化技术,如自适应 Anchors、注意力机制等,进一步提升了模型在检测精度和推理速度上的平衡,尤其在小目标检测方面展现出了优异性能。

1.3 主要特点与应用

YOLO系列模型的核心优势在于其高效、实时的特性,这得益于其统一的检测流程设计和持续的架构优化。这些模型能够处理不同大小和复杂度的目标,在实际应用中展现出了极高的灵活性和适应性。从安全监控到自动驾驶,从医疗影像分析到体育赛事直播,YOLO模型几乎渗透到了计算机视觉应用的每一个角落。

特别是在安防监控领域,YOLO系列因其实时处理大量视频流的能力而备受青睐;自动驾驶车辆依赖YOLO来即时识别行人、车辆等障碍物,保障行驶安全;而在医学成像方面,精确的目标检测能力有助于早期疾病的发现与诊断。

YOLO系列模型不仅是计算机视觉研究中的一个重要里程碑,也是推动众多行业智能化转型的关键技术。从YOLOv1的初次尝试到YOLOv8的极致优化,这一路的发展不仅体现了算法设计上的智慧,更反映了计算机视觉领域对于效率与准确性永恒的追求。未来,随着技术的不断进步,YOLO系列有望在更多领域绽放光彩,继续引领目标检测技术的创新与发展。

二、YOLOv1 模型详解

2.1 YOLOv1 模型结构概览

YOLOv1(You Only Look Once version 1),由Joseph Redmon等人于2016年提出,是计算机视觉领域中目标检测的一大里程碑。它革命性地将目标检测问题从复杂的多阶段处理简化为一个单一的神经网络,实现了端到端的实时物体检测。该模型的核心思想是直接从完整的输入图像预测边界框和类别概率,抛弃了传统方法中的提议区域生成步骤,从而大大提升了检测速度。

2.1.1 输入层与图像预处理

YOLOv1接收固定尺寸的图像作为输入,通常为448x448像素,以便于统一处理并适应网络结构。输入前会对图像进行归一化和调整大小,确保网络可以有效地学习特征。

2.1.2 骨干网络:Darknet-19

YOLOv1采用自定义的卷积神经网络架构Darknet-19作为其骨干网络。Darknet-19包含19个卷积层和5个最大池化层,设计精简但功能强大,能够在保持较高检测精度的同时,实现快速的推理速度。该网络通过连续的卷积和池化层逐步提取图像特征,为后续的目标定位和分类打下基础。

2.1.3 颈部结构:特征融合

虽然“颈部”这一术语在YOLOv1原文中并未明确提出,但可理解为其特征图的处理阶段。在经过一系列卷积后,网络输出多个尺度的特征图,每个特征图对应不同尺度的目标检测。这一设计允许YOLOv1能够同时处理不同大小的物体。

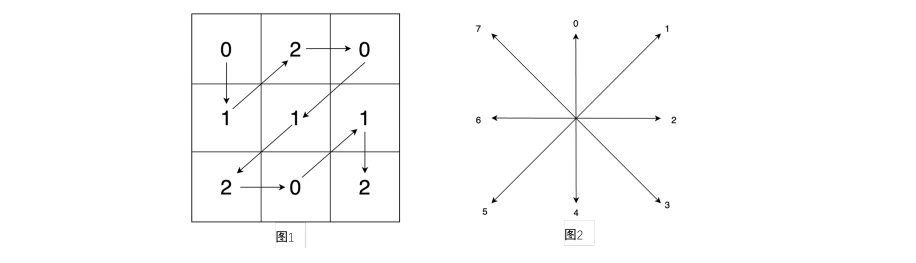

2.1.4 头部:多任务输出

YOLOv1的创新之一在于其独特的头部设计,它将最终的特征图划分为SxS个网格(grid cell),每个网格负责预测B个bounding boxes(默认为2),以及这些框内对象所属的C类概率。因此,每个网格总共输出Bx(5+C)个值,其中5代表每个边界框的中心坐标、宽度、高度以及一个置信度分数(表示是否存在对象以及预测框的准确性)。

2.2 核心思想与回归预测

YOLOv1的核心在于直接回归边界框和类别概率,这一策略显著提高了检测速度,但也带来了一些挑战,如边界框的重叠问题和类别不平衡。为解决这些问题,YOLOv1采用了多任务损失函数,将定位误差和分类误差结合考虑。

2.2.1 损失函数详解

YOLOv1的损失函数结合了定位误差和分类误差,具体分为以下几部分:

- 定位误差:包括边界框的位置误差(中心坐标偏移和宽高比例偏差)和置信度误差。

- 分类误差:预测类别概率与真实类别的交叉熵损失。

- 权重分配:为平衡分类和定位的重要性,损失函数中的各项会被赋予不同的权重系数。例如,位置误差的权重通常高于分类误差,以强调精确定位的重要性。

该损失函数设计旨在鼓励网络不仅准确地分类物体,还要精确地定位它们,确保了模型在实时应用中的实用性和准确性。

2.3 结构与性能评估

尽管YOLOv1在速度上取得了突破,但在检测精度上略逊于当时的两阶段方法,尤其是在小物体检测上。然而,它的出现标志着目标检测领域的一个重要转折点,为后续的YOLO系列以及其他单阶段检测器的发展奠定了基础。

通过本节的详细解析,我们深入了解了YOLOv1的模型结构、其创新性的回归预测思路,以及如何通过精心设计的损失函数来优化检测性能。这不仅为我们理解YOLO系列模型的发展奠定了基础,也展示了YOLOv1如何通过简化流程、提升效率,在计算机视觉目标检测领域树立了一个新的标杆。

三、YOLOv2-v7 模型特点

3.1 YOLOv2: 更快速与精确的演进

YOLOv2是YOLO系列的一个重要转折点,它在保持YOLOv1实时性的同时显著提升了检测精度。关键改进包括引入了批归一化(Batch Normalization)来加速训练过程并提高模型泛化能力,以及采用残差网络(ResNet)作为骨干网络以加深网络结构,增强特征表达能力。此外,YOLOv2还采用了多尺度预测策略,通过在不同分辨率下对图像进行处理,实现了对小物体检测的显著改善。空间金字塔池化(SPP)模块的加入,使得网络能够更好地处理不同尺寸的目标。

3.2 YOLOv3: 多尺度检测的创新

YOLOv3进一步优化了多尺度检测机制,通过构建一个具有多个输出层的网络,每个输出层对应不同的特征图尺度,从而能够同时预测不同大小的目标。这不仅提升了模型的检测范围,也进一步提高了检测精度。YOLOv3还首次提出了锚框(Anchor Boxes)概念,为每个网格预先定义了一系列预设的边界框比例和尺度,减少了预测难度并提高了效率。

3.3 YOLOv4: 性能与效率的极致平衡

YOLOv4重点在于结合当时最先进的优化技术,如Mish激活函数、CSPNet结构(跨阶段部分网络)、SPP-Block和PANet路径聚合网络,大大增强了模型的特征提取能力。通过这些创新,YOLOv4在不牺牲实时性的情况下,将检测精度提升到了前所未有的水平,成为了当时目标检测领域的一个重要里程碑。

3.4 YOLOv5: 实现与社区的互动

尽管YOLOv5并非由原作者Joseph Redmon开发,但它在社区内获得了广泛的认可和应用。YOLOv5通过简化YOLOv4的复杂性,使其更加易于理解和部署,同时保持了高效率和高精度的特点。该版本优化了网络架构,采用Focus层增强早期特征提取,并引入了自适应锚框分配策略,进一步提升了检测性能。

3.5 YOLOv6: 架构优化与轻量化探索

YOLOv6在追求更高精度的同时,也注重模型的轻量化,旨在实现更快的推理速度。通过采用跨级特征聚合(Cross Stage Partial Network, CSP)和高效通道注意力(ECA)模块,YOLOv6不仅提升了检测精度,还在移动端设备上实现了更优的运行效率。此外,该版本通过网络结构的细致调整,减少了计算量,使模型更加实用。

3.6 YOLOv7: 结构与算法的综合进化

YOLOv7结合了YOLOv5和YOLOX的优点,提出了一种新的网络架构——EvoNet,该架构能够自动演化出更高效的网络结构。通过集成SAM(Spatial Attention Module)和CAM(Channel Attention Module)等注意力机制,YOLOv7不仅在准确性上有了显著提升,还保持了良好的运行效率。此版本标志着YOLO系列在结构设计上的又一重大突破。

这一系列的演变不仅体现了YOLO家族在技术层面的不断进步,也反映了计算机视觉领域对于目标检测技术需求的持续增长。从YOLOv2到YOLOv7,每一版本都在原有基础上进行了针对性的优化,或是通过引入新技术,或是通过网络架构的革新,不断推动着目标检测技术的边界向前拓展。

四、YOLOv8 模型深度剖析

4.1 YOLOv8 模型结构与设计理念

YOLOv8,作为YOLO系列的最新成员,继承并超越了前辈们的诸多优点,成为目标检测领域的一颗璀璨新星。该模型的设计理念继续围绕着高效、实时的目标检测核心,但在架构优化、特征提取能力以及后处理策略上实现了显著的提升。YOLOv8基于PyTorch框架,利用了 ultralytics/yolov8 开源库的实现,这使得模型更加易用且便于定制。

4.1.1 结构革新

输入输出机制:YOLOv8保留了单阶段端到端检测框架,直接从全图输入预测边界框和类别概率,但在此基础上优化了特征金字塔网络(FPN)设计,引入了自适应特征汇聚和多尺度特征融合技术,以增强模型在不同尺度目标上的检测能力。

骨干网络升级:相较于前代,YOLOv8采用更高效的主干网络设计,如CSPDarknet,结合了通道分割和跨阶段部分信息传递的策略,不仅提高了计算效率,还有效减少了参数量,进一步加速推理速度而不牺牲精度。

4.1.2 优势与亮点

检测精度与速度的平衡

YOLOv8在不增加计算负担的前提下,通过改进的训练策略(如Mosaic数据增强、自对抗训练等)和更优化的损失函数设计,实现了精度与速度的完美平衡。特别是在小目标检测上,YOLOv8展示出了卓越的性能,归功于更精细的特征表达和更强大的上下文理解能力。

实时性与轻量化

借助于模型量化、知识蒸馏等技术,YOLOv8提供了从Nano到X的大规模模型变体,覆盖了从小型嵌入式设备到高端服务器的广泛应用场景,满足不同资源限制下的实时检测需求。

易用性与灵活性

YOLOv8的代码实现高度模块化,支持一键训练、评估、推理等功能,为开发者提供了极大的便利。此外,模型还融入了ONNX、TensorRT等后端优化方案,确保模型在各种硬件平台上的高效部署。

4.2 与YOLO前代版本的差异

4.2.1 结构差异

- 神经网络架构:YOLOv8采用了更新的网络架构,如CSPDarknet替换了早期版本中的Darknet-19,这在保持模型轻量的同时提升了特征表示能力。

- 损失函数创新:虽然沿用了YOLO系列特有的多任务损失函数,但YOLOv8对损失函数进行了细化调整,比如引入了GIoU损失来优化边界框预测,提高了定位准确性。

4.2.2 性能跃进

- 精度提升:受益于更先进的训练技巧和网络结构,YOLOv8在多个标准数据集上均实现了相比YOLOv7更高的mAP值,特别是在小物体和密集场景的检测上。

- 速度优化:通过算法层面和工程层面的双重努力,YOLOv8在保证精度的同时,推理速度进一步加快,特别适合于对延迟敏感的应用场景。

4.3 新技术与方法的应用

YOLOv8整合了一系列最新的计算机视觉技术,包括但不限于:

- 自注意力机制:在颈部或头部网络中引入自注意力模块,增强了模型对复杂场景中目标间关系的理解。

- 动态图优化:利用ONNX Runtime和TensorRT等工具,对模型进行动态图优化,减少了推理时的内存占用和提升了运行速度。

- 连续性学习与模型更新:支持模型微调和增量学习机制,允许用户在特定数据集上快速迭代模型,以应对新场景或类别的出现。

综上所述,YOLOv8不仅代表了目标检测技术的最新进展,更是对模型设计哲学的一次深化实践。它不仅在理论层面带来了创新,更为实际应用提供了强大的工具支持,进一步推动了计算机视觉技术的普及和发展。

五、YOLO 系列代码样例

在深入探讨了YOLO系列模型的发展历程、结构特点及最新进展之后,本部分将通过实际代码样例,展示如何利用YOLOv1至YOLOv8进行目标检测任务,以期让读者能够亲手实践并加深理解。以下样例基于Python语言,并采用流行深度学习框架如PyTorch或TensorFlow来实现。

5.1 使用YOLOv1进行目标检测

5.1.1 导入必要库与加载模型

import torch

from torchvision.models import yolo_v1

from PIL import Image

import torchvision.transforms as transforms# 加载预训练的YOLOv1模型

model = yolo_v1(pretrained=True)

model.eval()

5.1.2 数据预处理

transform = transforms.Compose([transforms.Resize((448, 448)), # YOLOv1要求的输入尺寸transforms.ToTensor(),

])image_path = 'your_image_path.jpg'

image = Image.open(image_path)

image = transform(image).unsqueeze(0) # 增加batch维度

5.1.3 进行预测

with torch.no_grad():predictions = model(image)# 对预测结果进行后处理,这里简略处理过程,实际应根据YOLOv1的输出格式解析

# 注意YOLOv1原版直接输出边界框和类别概率,需要进一步解码得到最终预测框

5.2 至 YOLOv7的代码示例简化展示

由于篇幅限制,对于YOLOv2至YOLOv7,我们将仅提供一个通用的使用流程框架,实际应用时需根据各版本的特定API调整。

5.2.1 使用Darknet框架或相应库

大多数YOLOv2以后的版本原生支持Darknet框架,或者有诸如ultralytics/yolov5等第三方库对新版YOLO进行了封装。以yolov5为例:

!pip install -qq ultralyticsfrom ultralytics.yolov5 import YOLO# 加载模型

model = YOLO('yolov5s.pt') # yolov5s是预训练模型的一个例子# 进行推理

results = model('your_image_path.jpg')

5.3 YOLOv8的代码样例

YOLOv8通过 Ultralytics 的YOLOv5库提供支持,尽管命名上跳跃至v8,但使用方式与上述YOLOv5类似。

from ultralytics import YOLO# 加载YOLOv8模型

model = YOLO('yolov8n.pt') # yolov8n是YOLOv8的一个轻量级模型# 推理

results = model('your_image_path.jpg')# 显示结果

results.show()

5.3.1 代码解析

上述代码首先导入必要的库,然后加载预先训练好的模型。通过简单的函数调用即可对图像执行目标检测。results对象包含了检测到的所有对象及其分类、置信度和边界框信息。通过.show()方法可以快速可视化检测结果,这对于快速验证模型效果非常有用。

结语

通过上述代码样例,我们不仅展示了如何加载YOLO系列的不同版本模型,还演示了如何进行基本的目标检测操作。为了深入实践,建议读者亲自运行这些代码,并查阅相应模型的官方文档,了解更详细的配置选项和高级功能。YOLO系列因其高效的检测能力,在安防监控、自动驾驶、医疗影像等多个领域展现了广泛的应用潜力,希望本文的代码示例能成为您探索计算机视觉技术道路上的有力工具。