在信息爆炸的时代,数据的价值日益凸显。Python作为一种强大的编程语言,与其丰富的库一起,为爬虫程序的开发提供了得天独厚的优势。本文将探讨如何使用Python构建一个爬虫APP程序,以及其背后的思维逻辑。

什么是Python爬虫APP程序?

Python爬虫APP程序是一个利用Python编写的应用程序,用于从互联网上自动获取数据。这些程序通常包含一个用户界面,允许用户指定爬取任务、查看进度和结果,并管理爬取到的数据。

为什么需要Python爬虫APP程序?

- 自动化:自动化的数据抓取可以节省大量时间和劳动力。

- 实时性:实时获取最新数据,对于市场分析和决策至关重要。

- 定制化:用户可以根据自己的需求定制爬虫任务。

- 数据挖掘:从大量非结构化数据中提取有价值的信息。

构建Python爬虫APP程序的思维逻辑

1. 需求分析

在开始编程之前,首先要明确APP的目标用户、功能需求和数据源。这包括确定要爬取的网站、数据类型和预期的使用场景。

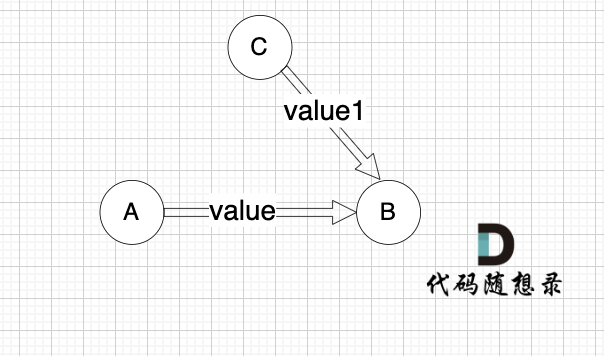

2. 设计架构

设计APP的整体架构,包括数据抓取、数据处理、数据存储和用户界面等模块。

3. 选择合适的工具和库

Python有许多库可以用来构建爬虫,如Requests、BeautifulSoup、Scrapy、Selenium等。选择合适的工具和库对于提高开发效率和爬虫性能至关重要。

4. 实现数据抓取

编写代码实现数据抓取逻辑,包括发送HTTP请求、解析HTML页面、提取数据等。

5. 数据处理和清洗

对抓取到的数据进行处理和清洗,以确保数据的准确性和可用性。

6. 数据存储

设计数据库模型,将清洗后的数据存储到数据库中,以便后续查询和分析。

7. 用户界面开发

开发用户界面,使用户能够方便地设置爬虫任务、查看进度和结果。

8. 测试和优化

对APP进行测试,确保其稳定性和性能。根据测试结果进行优化。

9. 部署和维护

将APP部署到服务器或云平台,进行日常维护和更新。

示例:简单的Python爬虫APP程序

以下是一个简单的Python爬虫APP程序的示例代码:

import requests

from bs4 import BeautifulSoup

import tkinter as tk

from tkinter import scrolledtextdef fetch_data(url):response = requests.get(url)soup = BeautifulSoup(response.text, 'html.parser')data = soup.find_all('div', class_='data-class')return datadef start_scraping():url = entry.get()data = fetch_data(url)text_area.delete('1.0', tk.END)for item in data:text_area.insert(tk.END, item.text + '\n')app = tk.Tk()

app.title('Python爬虫APP')entry = tk.Entry(app, width=50)

entry.pack()button = tk.Button(app, text='开始爬取', command=start_scraping)

button.pack()text_area = scrolledtext.ScrolledText(app, width=70, height=20)

text_area.pack()app.mainloop()在这个示例中,我们使用Python的Tkinter库创建了一个简单的用户界面,用户可以输入要爬取的URL,程序将显示爬取到的数据。

结论

Python爬虫APP程序可以帮助用户自动化地从互联网上获取数据,无论是用于市场研究、客户洞察还是内容监控。通过遵循上述思维逻辑,开发者可以构建出功能强大、用户友好的爬虫工具。随着技术的不断发展,Python爬虫APP程序将在数据驱动的决策中发挥越来越重要的作用。