TransFormer

- Basics

- Attention

- 单头注意力 single head attention

- Q: query 查寻矩阵 128*12288

- K key matrix 128*12288

- SoftMax 归一

- Value matrix 12288*12288

- MLP

Basics

接受一段文本,输出一个单词。

token -> (Embeding)-> high dimensional vector. 方向对应语义

最初的向量也包含位置信息。1万多维。

Attention

除以dk 是为了数值稳定

将上下文的信息传给当前token。

attention机制给最初的generic embedding加个向量,将其移动到上下文对应的具体方向上。

Attention不仅精细化了嵌入向量的定义,还能将嵌入向量的信息传给其他的向量。

经过多层attention后,预测下一个token的计算过程完全取决于最后一个向量。

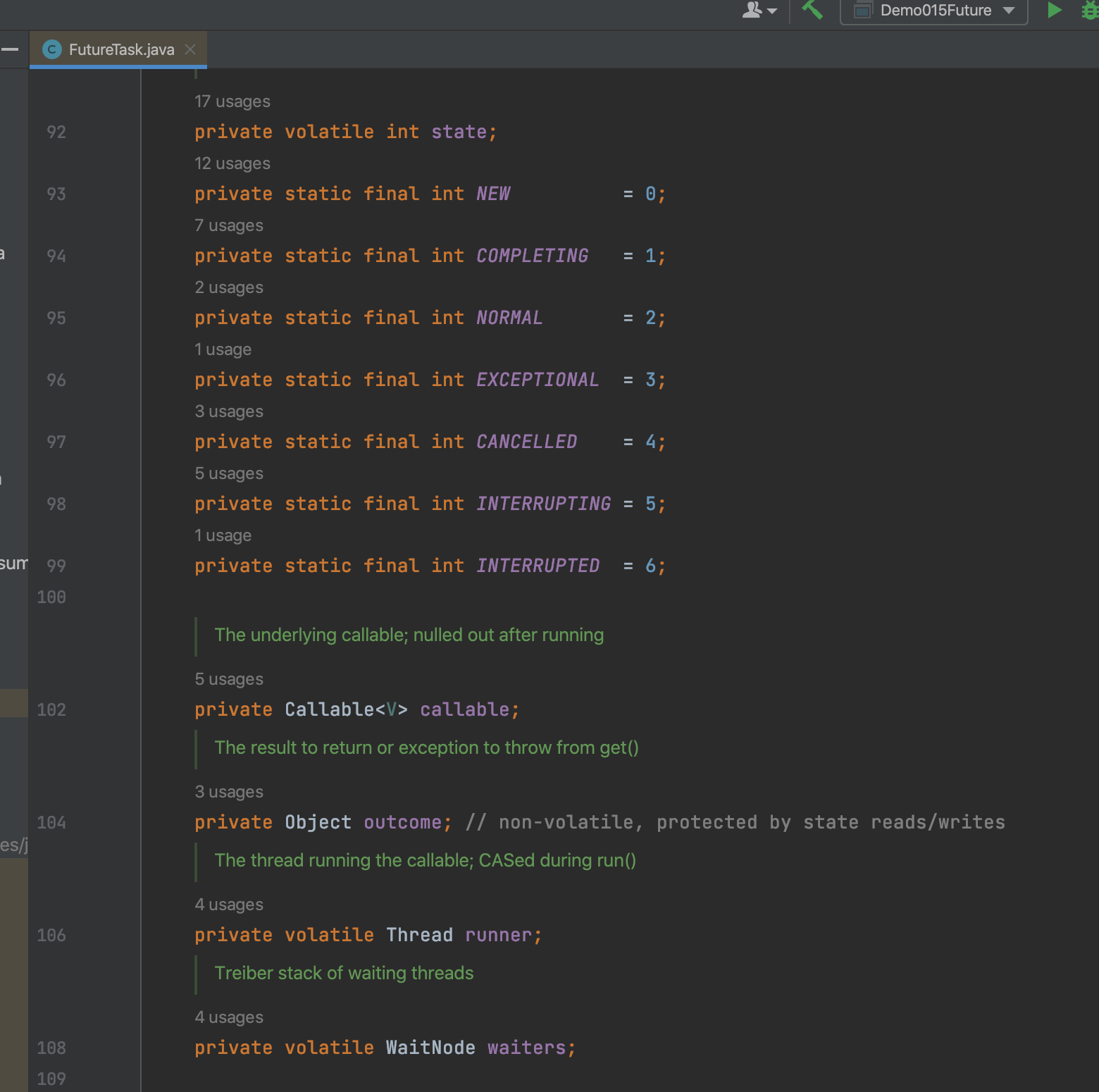

单头注意力 single head attention

Q: query 查寻矩阵 128*12288

WQ 将E(嵌入向量)映射低维空间中。Q是128*1

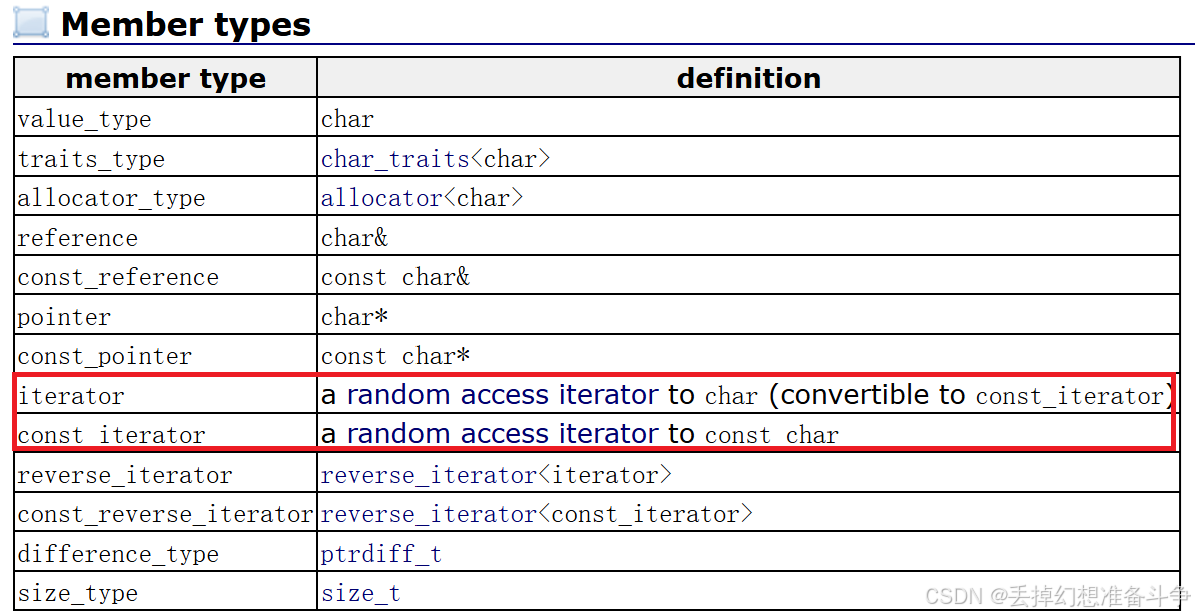

K key matrix 128*12288

Key矩阵同样将嵌入向量映射到低维空间中,得到第二个向量序列。当key与query的方向一致时(两个向量的点积越大越相关),就能认为他们匹配。

SoftMax 归一

Masking: 在训练时,不能提前知道答案,后级的信息不能传递给前级。为了避免后级token对前级的影响,将下半边矩阵设为-∞。

该pattern表明每个词与其他哪些词相关

Value matrix 12288*12288

MLP