ollama简介

ollama是一款开源的、轻量级的框架,它可以快速在本地构建及运行大模型,尤其是一些目前最新开源的模型,如 Llama 3, Mistral, Gemma等。

官网上有大量已经开源的模型,部分针对性微调过的模型也可以选择到,如llama2-chinese。

关键现在部署很简单,跨平台支持。

ollama特点

- 跨平台支持,windows、linux、mac都可以使用

- 支持大部分模型,包括我们熟悉的千问、llama3、phi3等

- 用户可以通过简单的命令快速启动和与 Llama 3 等模型进行交互。

- Ollama 允许用户通过 Modelfile 自定义模型,例如设置创造性参数或系统消息。

- Ollama 支持运行高达数十亿参数的模型,确保了处理大型模型的能力。

ollama如何快速开始

- 下载:用户可以根据自己的操作系统选择下载 macOS、Windows 预览版或使用 Linux 的安装脚本。

- 运行模型:通过简单的命令

ollama run <model_name>来启动模型。 - 自定义模型:用户可以创建一个名为

Modelfile的文件,并使用FROM指令导入模型,然后通过ollama create和ollama run命令来创建和运行自定义模型。

例如,要运行 Llama 3 模型,用户可以使用以下命令:

ollama run llama3

展示你的所有模型:

ollama list

拉取模型

ollama pull llama3

通过命令行去体验:

curl http://localhost:11434/api/chat -d '{"model": "llama3","messages": [{ "role": "user", "content": "why is the sky blue?" }]

}'

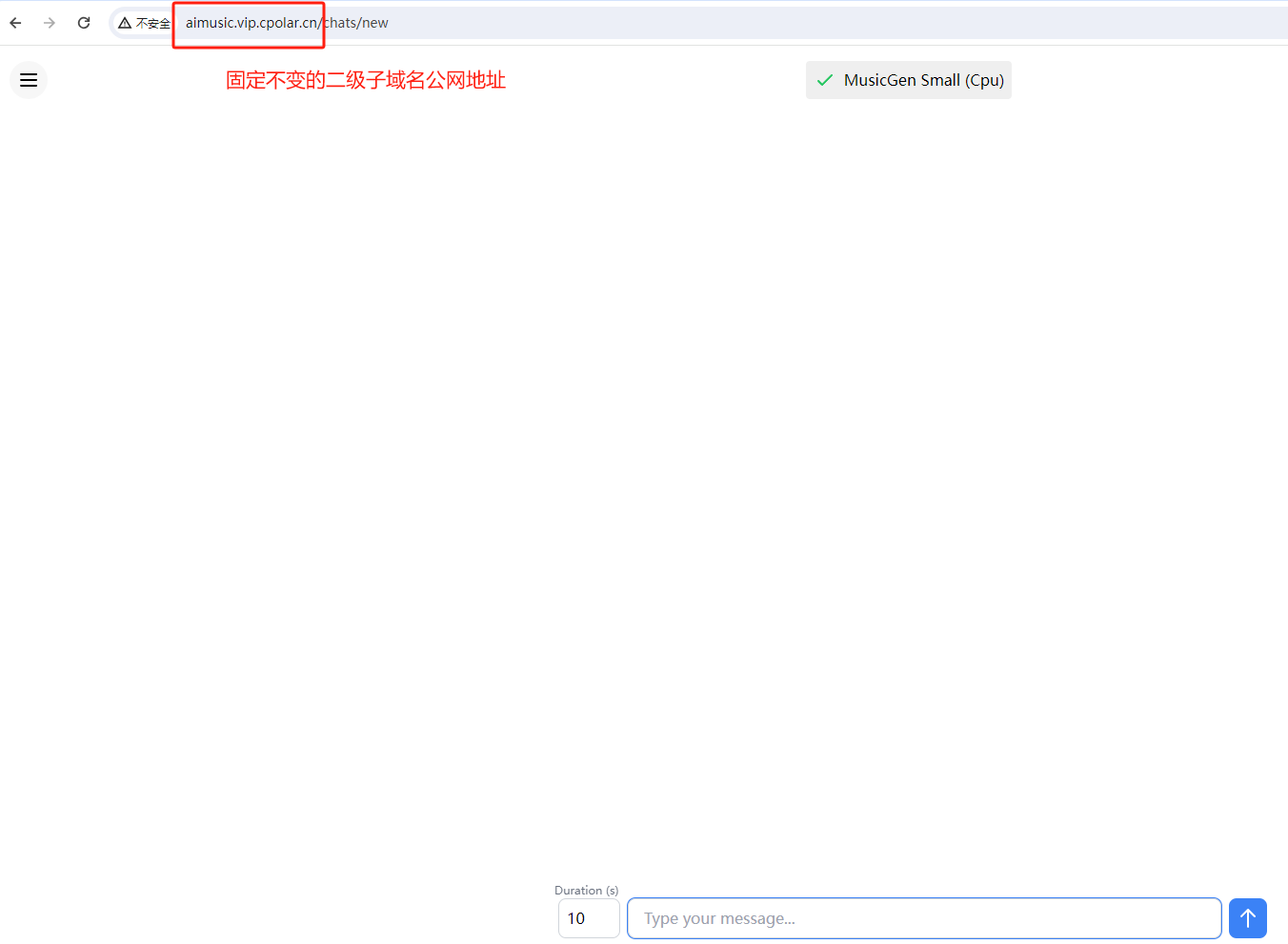

当然现在也有一些web页面可以直接使用,如open-webui,后面的文章会有具体的介绍。

结论

Ollama 提供了一个强大且易于使用的平台,让开发者能够在本地环境中轻松地运行和管理大型语言模型。

无论是快速开始还是深度定制,Ollama 都能满足用户的需求。

传送门:https://ollama.com/

👉CSDN大礼包🎁:全网最全《LLM大模型入门+进阶学习资源包》免费分享(安全链接,放心点击)👈