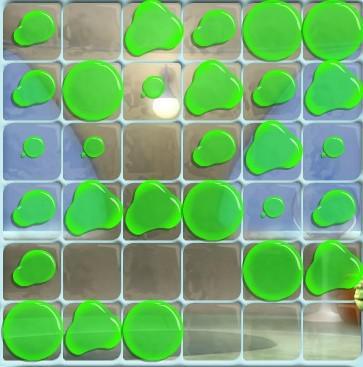

矿井人员数据集,用于目标检测,深度学习,采用txt打标签,即yolo格式,也有原文件可以自己转换。总共3500张图片的数据量,划分给训练集2446张:

### 矿井人员数据集用于目标检测的详细说明

#### 1. 数据集概述

矿井人员数据集是一个专门用于目标检测任务的数据集,旨在通过深度学习模型识别和定位矿井环境中的工作人员。该数据集包含3500张图片,每张图片中都有一个或多个矿工。为了训练和评估目标检测模型,这些图片已经被标注为YOLO(You Only Look Once)格式,这是一种广泛使用的对象检测框架。

#### 2. 数据集特点

- **图像数量**:总共3500张图片。

- **图像内容**:图片主要包含矿井环境中的工人,可能包括不同的工作场景、光照条件和背景。

- **标注格式**:采用YOLO格式进行标注,每个目标在图片中的位置用边界框表示,并附有类别标签。

- **数据划分**:

- **训练集**:2446张图片,用于训练模型。

- **验证集**:通常建议将剩余的图片(约1054张)划分为验证集和测试集。例如,可以将其中80%(约843张)作为验证集,20%(约211张)作为测试集。

#### 3. YOLO 标注格式

YOLO 标注格式是一种基于文本文件的标注方法,每个图片对应一个 `.txt` 文件。每个 `.txt` 文件中包含多行数据,每行代表一个目标,格式如下:

```

class_id x_center y_center width height

```

- **class_id**:目标类别的索引(从0开始)。

- **x_center, y_center**:边界框中心点相对于图片宽度和高度的归一化坐标(0到1之间)。

- **width, height**:边界框的宽度和高度相对于图片宽度和高度的归一化值(0到1之间)。

例如,如果一张图片的尺寸是640x480像素,且有一个矿工的边界框位于 (100, 150) 到 (300, 350),那么对应的标注可能是:

```

0 0.25 0.5 0.5 0.5

```

这里 `0` 表示矿工类别,`0.25` 和 `0.5` 分别是边界框中心点的归一化坐标,`0.5` 和 `0.5` 是边界框的宽度和高度的归一化值。

#### 4. 数据预处理

在使用数据集之前,需要进行一些预处理步骤,以确保数据的质量和一致性。

- **图像标准化**:将所有图像调整为相同的尺寸(例如640x480),以便于模型训练。

- **标签转换**:如果原始数据不是 YOLO 格式,需要编写脚本将其转换为 YOLO 格式。

- **数据增强**:为了增加模型的泛化能力,可以对图像进行旋转、缩放、翻转等增强操作。

- **数据清洗**:检查并删除标注错误或图像质量较差的数据。

#### 5. 数据集划分

为了训练和评估模型,需要将数据集划分为训练集、验证集和测试集。

- **训练集**:2446张图片,用于训练模型。

- **验证集**:843张图片,用于调优模型超参数和选择最佳模型。

- **测试集**:211张图片,用于最终评估模型性能。

可以使用以下代码来划分数据集:

```python

import os

import random

import shutil

# 数据集路径

dataset_path = 'path_to_dataset'

image_dir = os.path.join(dataset_path, 'images')

label_dir = os.path.join(dataset_path, 'labels')

# 创建输出目录

train_image_dir = os.path.join(dataset_path, 'train', 'images')

train_label_dir = os.path.join(dataset_path, 'train', 'labels')

val_image_dir = os.path.join(dataset_path, 'val', 'images')

val_label_dir = os.path.join(dataset_path, 'val', 'labels')

test_image_dir = os.path.join(dataset_path, 'test', 'images')

test_label_dir = os.path.join(dataset_path, 'test', 'labels')

os.makedirs(train_image_dir, exist_ok=True)

os.makedirs(train_label_dir, exist_ok=True)

os.makedirs(val_image_dir, exist_ok=True)

os.makedirs(val_label_dir, exist_ok=True)

os.makedirs(test_image_dir, exist_ok=True)

os.makedirs(test_label_dir, exist_ok=True)

# 获取所有图片文件名

image_files = [f for f in os.listdir(image_dir) if f.endswith('.jpg') or f.endswith('.png')]

random.shuffle(image_files)

# 计算分割点

train_split = int(0.7 * len(image_files))

val_split = int(0.9 * len(image_files))

# 划分数据集

train_files = image_files[:train_split]

val_files = image_files[train_split:val_split