起初,我想写这个博客是因为无意间看到了一个采访,无意间浏览才发现这段说的给我一种恍然大悟的感觉。

主持人提问:训练一个大模型,然后再将其压缩蒸馏成一个小模型,那和直接训练一个小模型, 这两者的区别是什么?

我的第一反应其实是懵的,从来没思考过这个问题。不过看到了王立威回答后我焕然大悟。蒸馏后的小模型就类似于见过了很多世面,有很多的人生经历的老者,然后将自己一生的有价值的经验和经历浓缩,传授给后辈,让其不走弯路。而直接训练一个小模型就类似一直在大山里生活,无论训练多久,始终见识到的是有限的、狭窄的,所以能力得不到提升。

参考:北大王立威:理论视角看大模型,为什么AI既聪明又愚蠢

建议仔细看看上面链接的内容,很多其实很有启发的。

嘉宾简介:

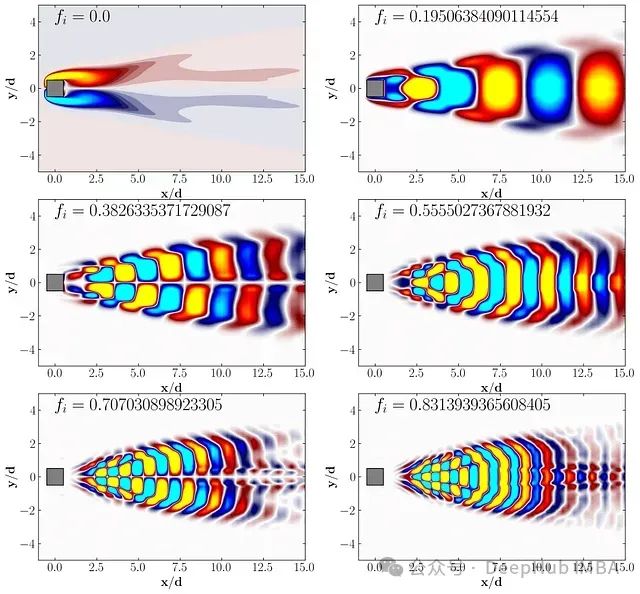

王立威,北京大学智能学院教授,研究兴趣为机器学习。长期从事机器学习基础理论研究,为设计更有效的新算法提供理论指导,并开发基于机器学习的医疗影像诊断算法与系统。近来致力于通过机器学习方法解决科学与数学领域重大基础问题。

王立威教授已在 NeurIPS、ICML、TPAMI 等国际顶级期刊和会议上发表论文 150 余篇,其中关于图神经网络表示理论的两篇工作分获 ICLR 杰出论文奖与提名奖。担任 TPAMI 编委,并长期担任 NeurIPS、ICML、ICLR 等机器学习顶会的领域主席/高级领域主席。此外,入选 AI’s 10 to Watch,是首位获此殊荣的亚洲学者。