关注公众号网络研究观获取更多内容。

据路透社获得的数据显示,领先的人工智能(AI)模型在网络安全弹性和防止歧视性输出等领域未能满足欧洲关键监管标准。

《欧盟人工智能法案》将在未来两年分阶段实施,旨在解决人们对这些技术在伦理、社会和安全方面影响日益增长的担忧,这些技术正日益融入日常生活的各个方面。

这是主要监管机构出台的第一部全面的人工智能立法。它将人工智能应用分为三个风险等级。

首先,被认为具有不可接受风险的应用,如政府运营的类似于使用的社会评分系统,将被禁止。其次,高风险应用,如对求职者进行排名的简历扫描工具,必须遵守特定的法律要求。最后,没有明确禁止或被归类为高风险的应用基本上不受监管。

不遵守《人工智能法案》可能导致 3500 万欧元(3800 万美元)的罚款或全球年营业额的 7%。

评估 GenAI 模型

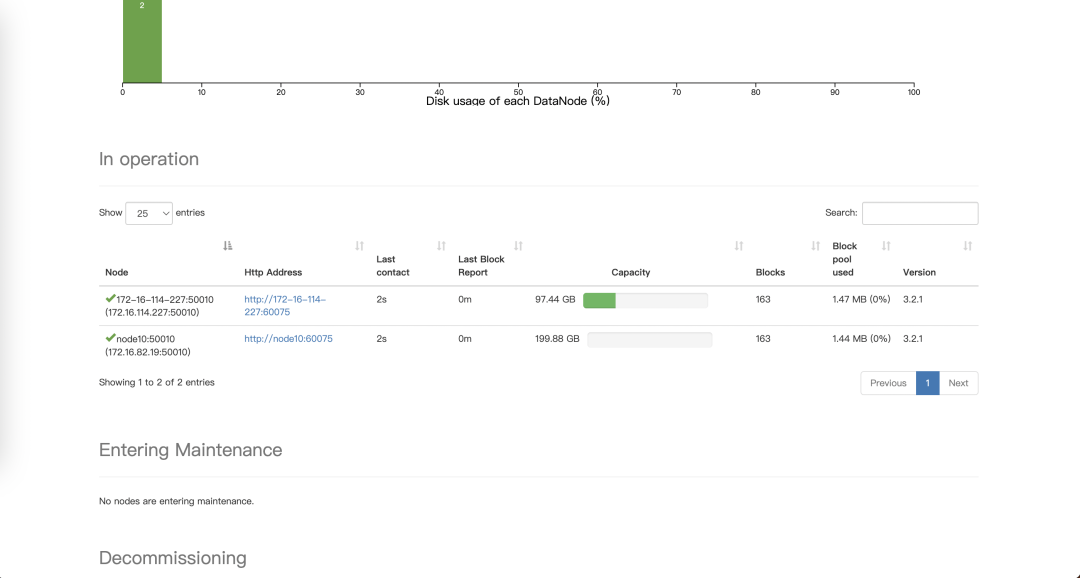

在欧盟官员的支持下,瑞士初创公司 LatticeFlow AI 与苏黎世联邦理工学院和保加利亚 INSAIT 合作开发了一种新工具,该工具根据欧盟的《人工智能法案》对 Meta 和 OpenAI 等公司生产的生成式人工智能模型进行了评估。

该框架在技术稳健性和安全性等类别中对模型进行从 0 到 1 的评分。

周三发布的 LatticeFlow 排行榜显示,阿里巴巴、Anthropic、OpenAI、Meta 和 Mistral 的模型平均得分为 0.75 或更高,但“大型语言模型 (LLM) 检查器”突出显示了需要改进合规性的地方。

随着欧盟最终确定《人工智能法案》的执行机制,专家们正在制定一套实践准则,预计将于 2025 年春季出台。

歧视性输出和网络安全挑战

LLM Checker 的初步测试揭示了诸如歧视性输出和网络安全等类别的挑战。

例如,OpenAI 的 GPT-4 Turbo 在歧视性输出方面的得分为 0.46,而阿里巴巴云的得分为 0.37。LatticeFlow 表示,随着更多监管措施的出台,它将在线提供 LLM Checker 供开发人员测试合规性。

该公司首席执行官兼联合创始人Petar Tsankov向路透社表示,测试结果总体上是积极的,并为企业提供了一份路线图,以便他们根据《人工智能法案》微调他们的模型。

“欧盟仍在制定所有合规基准,但我们已经看到模型中存在一些差距,”他说。“通过更加注重优化合规性,我们相信模型提供商可以做好充分准备来满足监管要求。”

GenAI 的前景黯淡

ImmuniWeb 首席执行官、Platt Law LLP 合伙人兼网络安全业务负责人、国会技术大学网络安全兼职教授 Ilia Kolochenko 博士评论道:“该报告优雅地总结了最大的 GenAI 模型中存在的大量隐私、安全和可靠性问题,这些问题自 2022 年底以来越来越多地被报道。”

他说,这份报告只是冰山一角:“对 LLM 模型进行全面的公开审计,可以完全访问 LLM 的训练数据、算法和护栏,可能会揭露数十项其他法律法规的大量违规行为,而不仅仅是欧盟人工智能法案或 GDPR,后者在现代 GenAI 相关诉讼中最常用。”

Kolochenko 表示,如果我们再加上培训或微调现代法学硕士所需的巨额财务成本和对环境可持续性造成的不可挽回的损害、日益严格的反垄断监管审查以及全球范围内不断升级的人工智能立法,“GenAI 的未来看起来很暗淡,至少可以这么说。”

蒙着眼睛追逐利润

在全球最大的科技巨头之间激烈的竞争中,GenAI 供应商盲目地争相盈利,部分原因是缺乏透明度、训练数据收集流程可疑以及安全控制不足。

尽管 GenAI 被宣称是下一个类似电力的重大技术,但大多数 GenAI 投资者都面临着失去资金的风险,因为供应商的许多承诺往往被夸大,甚至在技术上不可能实现,至少目前是这样。

话虽如此,GenAI 肯定会成为我们日常生活和社会不可或缺的一部分。然而,它不太可能引起一些供应商和支持它们的投资者所宣称的重大变化。”