目录

- 引言

- 一、GLM-4-Voice概述

- 二、GLM-4-Voice的架构

- 三、GLM-4-Voice的主要功能

- 四、GLM-4-Voice的技术原理

- 五、GLM-4-Voice的应用场景

- 六、GLM-4-Voice体验快速开始

- 结语

引言

在人工智能的不断进步中,语音交互技术正逐渐成为人机沟通的重要桥梁。它不仅极大地提升了我们的工作效率,还让机器更加自然地融入我们的日常生活。情感语音模型,作为这一领域的最新成果,不仅能够理解语音内容,还能够表达和感知情感,使得人机交互更加生动和贴近人类自然的交流方式。在这样的背景下,智谱AI推出了GLM-4-Voice,一款具有划时代意义的情感语音模型,它不仅提升了语音识别的准确性,还让机器的语音输出更加自然和富有表现力。

一、GLM-4-Voice概述

GLM-4-Voice是智谱AI推出的一款端到端情感语音模型,它通过先进的深度学习技术,实现了对中英文语音的直接理解和生成。这款模型的创新之处在于其能够模拟人类的情感和语调,从而在人机对话中提供更加真实和富有情感的语音回复。GLM-4-Voice的设计目标是减少信息损失,提高语音交互的自然度和流畅性,同时支持低延迟的实时对话,为用户提供更加丰富和自然的语音交互体验。

GLM-4-Voice的主要特点包括:

- 高度的自然性和流畅性,使得语音交互更加贴近人类的自然对话。

- 情感表达和情感共鸣的能力,让模型能够根据对话的上下文模拟不同的情感和语调。

- 支持实时打断和指令输入,使得对话更加灵活和符合人类的日常交流习惯。

- 多语言和方言的支持,使得模型能够服务于更广泛的用户群体。

GLM-4-Voice的推出,不仅是智谱AI在技术上的一次突破,也标志着人工智能在情感语音交互领域迈出了重要的一步。随着技术的不断发展和完善,GLM-4-Voice有望在未来的人机交互中发挥更加关键的作用。

二、GLM-4-Voice的架构

GLM-4-Voice的架构由三个核心部分组成,确保了其在语音交互上的高效性和灵活性。

1、 GLM-4-Voice-Tokenizer:这是一个语音分词器,它在Whisper的Encoder部分增加了Vector Quantization并在ASR数据上进行了有监督训练,能够将连续的语音输入转化为离散的token,平均每秒音频只需要用12.5个离散token表示。

2、 GLM-4-Voice-Decoder:这是一个基于CosyVoice的Flow Matching模型结构训练的语音解码器,支持流式推理。它将离散化的语音token转化为连续的语音输出,最少只需要10个语音token即可开始生成,有效降低了端到端对话的延迟。

3、 GLM-4-Voice-9B:在GLM-4-9B的基础上进行了语音模态的预训练和对齐,使其能够理解和生成离散化的语音token。在预训练方面,为了提升模型在语音模态下的智商和合成表现力,智谱AI将Speech2Speech任务解耦为两个子任务:“根据用户音频做出文本回复”和“根据文本回复和用户语音合成回复语音”,并设计了两种预训练目标。

三、GLM-4-Voice的主要功能

GLM-4-Voice的设计用端到端建模减少信息损失,提高语音交互的自然度和流畅性,且支持低延迟的实时对话,为用户提供更加丰富和自然的语音交互体验。

- 理解和生成语音:直接理解和生成中英文语音,实现流畅的人机交互。

- 情感表达:模拟不同的情感和语调,如高兴、悲伤、生气、害怕等,让语音回复更加自然。

- 调节语速:根据用户的指令调整语音的语速,适于不同的对话场景。

- 实时打断和指令输入:支持用户随时打断语音输出,输入新的指令调整对话内容。

- 多语言和方言支持:支持中英文及多种中国方言,如粤语、重庆话、北京话等。

- 低延迟交互:设计流式思考架构,低延迟实现高质量的语音对话。

四、GLM-4-Voice的技术原理

GLM-4-Voice的技术原理是其高效性能的核心。它采用了端到端建模,与传统的级联方案(ASR + LLM + TTS)不同,GLM-4-Voice在一个统一的模型中完成语音的理解和生成,避免信息损失。

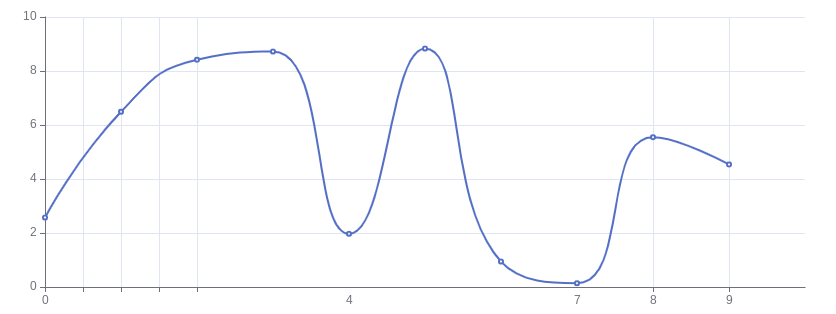

- 音频Tokenizer:用有监督训练的音频Tokenizer将连续的语音输入转化为离散的token,用12.5Hz的低码率保留语义信息和副语言特征。

- 语音解码器:基于Flow Matching模型结构的语音解码器,将离散的语音token转化为连续的语音输出,最低只需10个token开始生成,降低对话延迟。

- 预训练和对齐:GLM-4-Voice-9B在GLM-4-9B的基础上进行预训练和对齐,理解和生成离散化的语音token。预训练用大量音频和文本数据,让模型具备强大的音频理解和建模能力。

- 流式推理:支持流式推理,模型能交替输出文本和语音,用文本作为参照保证回复内容的高质量,根据用户的语音指令实时调整语音输出。

五、GLM-4-Voice的应用场景

GLM-4-Voice的情感语音模型以其先进的技术和多功能性,在多个领域都有广泛的应用潜力。以下是GLM-4-Voice的一些主要应用场景:

1、智能助手

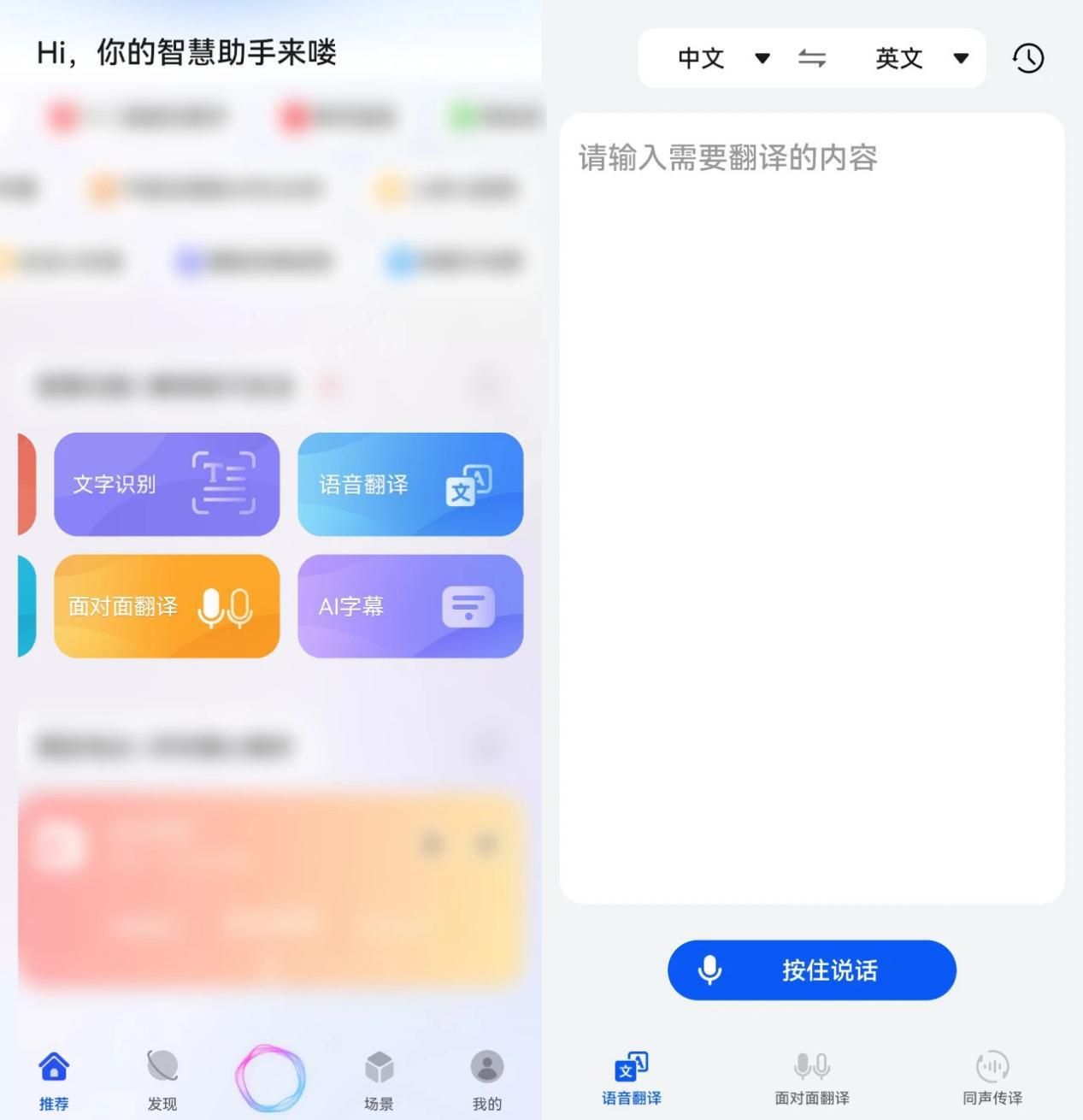

在智能手机和智能家居设备中,GLM-4-Voice可以作为智能助手,通过语音交互帮助用户完成各种日常任务。例如,用户可以要求它设置提醒、查询天气、控制家中的智能设备等。它的多语言和方言支持能力,尤其适合不同语言背景的用户。

2、客户服务

在客户服务领域,GLM-4-Voice可以作为虚拟客服,利用其自然语言理解和语音合成技术,为用户提供咨询和解决问题的服务。它的情感表达能力使得对话更加人性化,提升了客户满意度。

3、教育和学习

GLM-4-Voice可以在教育领域作为语言学习助手,帮助学生练习发音、听力和口语。它能够提供个性化的学习建议,模拟不同的情感和语调,使学习过程更加生动有趣。

4、娱乐和媒体

在娱乐行业,GLM-4-Voice可以用在语音合成,为动画、游戏、有声书等提供自然、富有表现力的语音输出。它的高表现力和情感共鸣能力,使得内容更具吸引力。

六、GLM-4-Voice体验快速开始

想要在本地快速体验GLM-4-Voice的强大功能,可以按照以下步骤进行:

1、 环境准备:确保您的计算机上安装了Python环境以及必要的依赖库。您可以通过pip命令安装所需的Python包。

2、 代码获取:访问GLM-4-Voice的GitHub仓库(https://github.com/THUDM/GLM-4-Voice),克隆代码库到本地环境。

git clone --recurse-submodules https://github.com/THUDM/GLM-4-Voice

cd GLM-4-Voice

3、 安装依赖:在项目根目录下,使用以下命令安装所有依赖:

pip install -r requirements.txt

4、 模型下载:由于Decoder模型较大,可能需要单独下载。您可以从Huggingface或其他提供模型下载的服务上获取模型文件。

git clone https://huggingface.co/THUDM/glm-4-voice-decoder

5、 启动服务:运行以下命令启动模型服务:

python model_server.py --model-path PATH_TO_YOUR_MODEL

此命令会自动下载 glm-4-voice-9b。如果网络条件不好,也手动下载之后通过 --model-path 指定本地的路径。

6、访问Demo:在另一个终端窗口中,启动Web Demo服务:

python web_demo.py

服务启动后,您可以通过浏览器访问http://127.0.0.1:8888来体验GLM-4-Voice的实时语音交互功能。此命令会自动下载 glm-4-voice-tokenizer 和 glm-4-voice-9b。如果网络条件不好,也可以手动下载之后通过 --tokenizer-path 和 --model-path 指定本地的路径。

结语

GLM-4-Voice的情感语音模型以其卓越的性能和广泛的应用前景,为人工智能领域带来了新的可能性。它不仅提升了人机交互的自然度和效率,还为各种行业提供了创新的解决方案。随着技术的不断进步,我们有理由相信,GLM-4-Voice将在智能语音交互的新时代中扮演着越来越重要的角色。

相关资料

官网地址:https://zhipuai.cn/news/141?tab=1

github地址:https://github.com/THUDM/GLM-4-Voice

🎯🔖更多专栏系列文章:AI大模型提示工程完全指南、AI大模型探索之路(零基础入门)、AI大模型预训练微调进阶、AI大模型开源精选实践、AI大模型RAG应用探索实践🔥🔥🔥 其他专栏可以查看博客主页📑

😎 作者介绍:我是寻道AI小兵,资深程序老猿,从业10年+、互联网系统架构师,目前专注于AIGC的探索。

📖 技术交流:欢迎关注【小兵的AI视界】公众号或扫描下方👇二维码,加入技术交流群,开启编程探索之旅。

💘精心准备📚500本编程经典书籍、💎AI专业教程,以及高效AI工具。等你加入,与我们一同成长,共铸辉煌未来。

如果文章内容对您有所触动,别忘了点赞、⭐关注,收藏!加入我,让我们携手同行AI的探索之旅,一起开启智能时代的大门!