文章目录

- 一、什么是Logstash、有什么用?

- 什么是 Logstash?

- Logstash 的主要特点:

- Logstash 的用途:

- 二、Logstash的安装与基本配置

- 事先要安装Java的环境?

- Logstash 安装

- Debian/Ubuntu

- Red Hat/CentOS

- macOS(使用 Homebrew)

- 配置环境变量

- 配置jvm.option的JVM堆大小

- Logstash的Pipeline

- Pipeline概念

- 具体作用

- 配置

- 具体操作

- Logstash的DSL语法

- 1. 基本结构

- 2. 输入(input)

- 3. 过滤(filter)

- 4. 输出(output)

- 5. 插件配置

- 6. 条件和逻辑

- 7. 插件参数类型

- 总结

- Logstash 基本配置

- 1. 输入(Input)

- 2. 过滤(Filter)

- 3. 输出(Output)

- 完整的 Logstash 配置示例

- 运行 Logstash

- 注意事项

- logstash命令的选项用法

- 三、Logstash的input、filter和output组件

- 从标准输入拿到标准输出

- 从标准输入拿到文件中

- 从标准输入拿到ElasticSearch中

- input中使用file的具体语法

- 基本配置

- 模式和读取

- 配置参数

- 示例配置

- 如何同时获取两个文件传到elasticsearch中的不同或是相同索引中

- 不推荐的方法

- 使用嵌入type变量的方法

- input中的file中可以使用“%{+YYYY.MM.dd}”吗?

- input中使用syslog的具体语法

- 1. 配置Logstash监听Syslog

- 2. 处理非标准Syslog格式

- 3. 处理ECS兼容性

- 4. 配置设施和严重性级别标签

- 5. 配置时区

- 6. 启动Logstash

- 7. 查看接收到的Syslog数据

- 各个组件中的codec和multiline的语法

- 1. Plain Codec

- 2. JSON and JSON Lines Codec

- 3. Multiline Codec

- multiline codec的详细使用

- 1. 基本配置

- 2. 高级配置

- 3. 使用示例

- 示例1:合并Java堆栈跟踪

- 示例2:合并C风格的行续行

- 配置参数

- filter的语法

- 基本语法

- 常见filter插件

- 复合结构

- 条件语句

- 匹配多个字段

- 缓存机制

- 插件配置

- 1. grok

- 2. mutate

- 3. date

- 4. useragent

- 5. uri_parts

- 6. multiline

- *JSON数据格式的介绍

- 什么是JSON?

- JSON的结构

- JSON的用途

- 如何使用JSON

- 在JavaScript中使用JSON

- 在Python中使用JSON

- 在Java中使用JSON

- 在其他语言中

- JSON标准格式

- JSON最佳实践

- JSON数据格式的语法

- Logstash使用filter的json对json格式的源文件的内容的json元素单独拿出来

- Logstash如何将codec合并的数据还原成单独的

- 方法1:使用`dissect`过滤器

- 方法2:使用`mutate`和`grok`过滤器

- 输出

- input或output中使用tcp或udp组件的语

- TCP作为输入(input)

- TCP作为输出(output)

- UDP作为输入(input)

- UDP作为输出(output)

- 四、Logstash获取数据到Elasticsearch

- Logstash和Elasticsearch如何协同工作

- 1. 数据采集(Data Ingestion)

- 2. 数据处理(Data Processing)

- 3. 数据输出(Data Output)

- 4. 数据存储和索引(Data Storage and Indexing)

- 5. 数据搜索和分析(Data Search and Analysis)

- 6. 可扩展性和容错性

- 7. 实时数据处理

- 总结

- logstash的输出源是elasticsearch的语法

- 一些实例——Logstash获取数据到ElasticSearch中

- 收集系统日志到es中(index名字是message_YYYY.MM.dd)

- 将日志文件格式改为json格式,传输到ElasticSearch中

- *如何将系统日志的内容格式转换为JSON格式(使用rsyslog工具)

- *如何将Nginx的日志的内容格式转换为JSON的格式

- 步骤1:配置Nginx日志格式

- 步骤2:使用Logstash解析日志

- 注意事项

- Logstash使用tcp、udp将日志补录到ElasticSearch中

- Logstash(使用syslog组件)配合Rsyslog收集HAProxy日志

- 配置rsyslog配置文件

- 配置haproxy配置文件并验证(需要另外两台web01、web02配合)

- HAProxy的日志在哪(为何不能用file模块直接拿日志文件而是借助syslog?)

- Rsyslog和HAProxy是如何连接的、如何发送到Logstash中的

- 使用Logstash的syslog组件接收Rsyslog传来的HAProxy日志到ElasticSearch中

- *五、Rsyslog和HAProxy的具体安装配置

- 什么是Rsyslog、有什么用

- Rsyslog是什么?

- Rsyslog具体有什么用?

- Rsyslog底层原理是什么?

- 详细的例子

- CentOS7上安装配置Rsyslg

- 1. 安装Rsyslog

- 2. 配置Rsyslog

- 2.1 编辑`/etc/rsyslog.conf`文件

- 2.2 配置Rsyslog服务端

- 2.3 配置Rsyslog客户端

- 3. 启动和启用Rsyslog服务

- 4. 配置防火墙

- 5. 验证配置

- Rsyslog与Logstash的对比

- Haproxy是什么?有什么用?

- HAProxy是什么?

- HAProxy有什么用?

- HAProxy的工作原理

- Haproxy的安装与配置

- 1. 安装HAProxy

- 2. 配置HAProxy

- 3. 启动HAProxy

- 4. 验证HAProxy配置

- HAProxy和Nginx的对比

- 1. 功能和用途

- 2. 性能和效率

- 3. 配置和管理

- 4. 健康检查

- 5. SSL/TLS支持

- 6. 使用场景

- *六、Nginx如何配置两个Web应用,并使它们拥有独立的日志文件

- *七、如何使用命令向tcp、udp端口中传入数据

- 向tcp端口传数据

- 1. 使用`nc`(netcat)命令

- 2. 使用`telnet`命令

- 3. 使用`openssl`命令

- 4. 使用`socat`命令

- 5. 使用`ncat`命令

- 注意事项

- 向udp端口传数据

- 1. 使用`nc`(netcat)命令

- 2. 使用`socat`命令

- 3. 使用`printf`和`nc`命令

- 注意事项

- *八、日志设施(local0-local7是个啥)

- 写在前面

- 日志设施的含义与用途

- 含义:

- 用途:

一、什么是Logstash、有什么用?

什么是 Logstash?

Logstash 是一个开源的服务器端数据处理管道,它能够同时从多个来源采集数据,转换数据,然后将数据发送到您指定的目的地。Logstash 是 Elastic Stack(以前称为 ELK Stack)的核心组件之一,与 Elasticsearch 和 Kibana 一起使用,用于构建强大的日志分析和数据可视化解决方案。

这里的“数据处理管道”的意思:

指的是该软件可以对数据进行采集、转换、处理等操作,将原始数据转换成有用的信息。管道是指数据从一个组件流向另一个组件的过程。

Logstash 的主要特点:

-

数据采集(Ingestion):

- Logstash 可以从各种来源采集数据,包括文件、数据库、消息队列(如 Kafka、RabbitMQ)和多种日志格式。

-

数据转换(Transformation):

- Logstash 具有强大的过滤器功能,可以处理和转换数据。例如,可以解析日志行、添加或删除字段、修改字段值、执行数据格式化等。

-

数据输出(Output):

- Logstash 可以将处理后的数据输出到多种目的地,包括 Elasticsearch、文件、数据库、Web 服务等。

-

可扩展性:

- Logstash 是高度可扩展的,可以处理从几百KB到几GB的数据流。

-

插件系统:

- Logstash 拥有丰富的插件生态系统,包括输入(input)插件、过滤器(filter)插件和输出(output)插件,这些插件使得与各种数据源和目的地的集成变得简单。

-

多线程和多实例:

- Logstash 可以运行在多线程模式下,以提高数据处理效率。同时,也可以运行多个 Logstash 实例来扩展处理能力。

Logstash 的用途:

-

日志聚合:

- 集中收集和管理来自服务器、应用程序和网络设备的日志数据。

-

数据转换和清洗:

- 对原始日志数据进行格式化、解析和清洗,以便于分析。

-

监控和警报:

- 与 Elasticsearch 和 Kibana 结合使用,实现实时监控和警报。

-

数据集成:

- 将来自不同来源的数据集成到一个统一的系统中,以便进行分析和报告。

-

数据迁移:

- 将数据从一个系统迁移到另一个系统,例如从传统数据库迁移到 Elasticsearch。

-

特征工程:

- 在数据进入 Elasticsearch 之前,进行特征提取和数据增强,以支持更复杂的搜索和分析。

-

错误跟踪和调试:

- 收集和分析应用程序的错误日志,帮助开发人员快速定位和解决问题。

Logstash 是处理和移动大量数据的理想工具,它能够将数据从任何来源实时转换并发送到任何目的地,非常适合构建复杂的数据处理流水线。

数据处理流程:

- 输入(Input)

- Logstash从多种数据源获取数据,这些数据源可以是文件(如日志文件)、网络(如接收网络端口传来的日志数据)、消息队列(如Kafka)等。例如,从一个不断增长的服务器日志文件中读取新的日志行。

- 它使用各种输入插件来实现这一功能,每个输入插件都针对特定类型的数据源进行了优化。

- 过滤(Filter)

- 一旦数据被输入到Logstash中,就会进入过滤阶段。在这个阶段,可以对数据进行修改、转换、删除等操作。

- 例如,可以使用grok过滤器将非结构化的日志数据解析成结构化的数据。假设日志中有一行“192.168.1.10 - [2023 - 08 - 10T12:00:00] “GET /index.html HTTP/1.1” 200 1024”,grok过滤器可以根据预定义的模式将其解析为包含IP地址、时间戳、请求方法、请求路径、HTTP版本、状态码和响应大小等字段的结构化数据。

- 还可以使用其他过滤器如mutate来修改字段的值,例如将字符串类型的数字字段转换为数值类型。

- 输出(Output)

- 经过过滤后的结构化数据会被发送到输出端。输出目标可以是Elasticsearch(用于存储和搜索数据)、文件(将处理后的数据保存到文件中)、其他消息队列等。

- 例如,将处理后的日志数据发送到Elasticsearch集群中,以便通过Kibana进行可视化和分析。

事件驱动架构:

Logstash基于事件驱动架构运行。每个进入Logstash的数据单元被视为一个事件。这些事件在输入、过滤和输出阶段依次被处理。这种架构使得Logstash能够高效地处理大量的数据,因为它可以并行处理多个事件,并且可以根据配置灵活地调整每个阶段的处理逻辑。

Pipeline:

- Logstash的Pipeline是数据处理的管道,它定义了数据从输入到输出的整个流程。一个Pipeline由输入(input)、过滤(filter)和输出(output)三个部分组成。

- 例如,一个简单的Pipeline配置可能如下:

input {file {path => "/var/log/messages"}

}

filter {grok {match => { "message" => "%{IP:client_ip} - $$ %{HTTPDATE:timestamp} $$ \"%{WORD:method} %{URIPATHPARAM:request_path} HTTP/%{NUMBER:http_version}\" %{NUMBER:status_code} %{NUMBER:response_size}" }}

}

output {elasticsearch {hosts => ["localhost:9200"]}

}

这个Pipeline从本地的“/var/log/messages”文件中读取日志数据,使用grok过滤器解析日志内容,然后将处理后的数据发送到本地的Elasticsearch实例中。

- 队列机制

- 在Pipeline的底层实现中,使用了队列来存储事件。当输入插件获取到数据后,会将数据封装成事件并放入输入队列中。

- 例如,在处理高并发的日志输入时,输入队列可以缓冲大量的日志事件,防止数据丢失或处理不及时。

- 插件体系结构

- Logstash的Pipeline依赖于其强大的插件体系。输入、过滤和输出插件都是独立开发的组件,它们通过统一的接口与Pipeline的核心逻辑进行交互。

- 对于输入插件,它负责从数据源读取数据并将其转换为事件格式放入队列。过滤插件从输入队列中获取事件,对事件进行处理后再将其放回队列(如果有多个过滤插件,事件会依次经过这些过滤插件)。输出插件从队列中获取最终处理好的事件并将其发送到目标输出端。

- 工作线程模型

- Logstash采用多线程模型来处理Pipeline中的事件。不同的阶段(输入、过滤、输出)可能会有多个工作线程同时运行。

- 例如,在输入阶段可能有多个线程同时从不同的文件或网络源读取数据,这样可以提高数据的读取速度。在过滤阶段,多个线程可以并行处理不同的事件,提高整体的处理效率。同时,为了保证数据的正确性和顺序性,在不同阶段之间会有适当的同步机制。

Logstash是一个开源的数据收集引擎,它具有实时流水线能力,可以动态统一不同来源的数据,并将数据标准化到选择的目标输出。Logstash的核心是其数据流管道(Pipeline),由三个主要组件构成:Input、Filter和Output。

-

Input(输入阶段):

- Input组件负责从各种数据源中读取数据,例如日志文件、网络端口等。每个input都有自己的codec,用于数据的编码和解码。

-

Filter(过滤器阶段):

- Filter组件对读取到的数据进行过滤和处理,可以根据需要对数据进行转换、丰富和格式化。

-

Output(输出阶段):

- Output组件将处理后的数据发送到指定的目标,如Elasticsearch、文件系统或其他数据库。

Logstash的Pipeline是Logstash中独立的运行单元,每个管道都包含两个必须的元素:输入(input)和输出(output),以及一个可选的元素过滤器(filter)。事件处理管道负责协调它们的执行。在Logstash 6.0及以后的版本中,支持Multiple Pipelines,即可以在一个Logstash实例中同时运行多个独立的数据流程。

-

数据队列(Queue):

- 数据首先被存放到内存或磁盘的中央队列中。这个队列可以配置为持久化到磁盘,以防止Logstash意外终止时数据丢失。

-

Batcher:

- Batcher的作用是批量地从队列中取数据,然后分发到不同的pipeline中。Batcher可以配置为一次取一定数量的数据,例如一百个事件。

-

工作线程(Workers):

- 每个pipeline工作线程从队列中获取一批事件,通过配置的过滤器运行这批事件,然后将过滤的事件运行到所有输出。

-

配置文件(pipelines.yml):

- 在

pipelines.yml配置文件中声明多个pipeline,实现针对不同业务场景和类型的数据流,配置不同pipeline进行数据流隔离。

- 在

通过这样的架构,Logstash能够高效地处理大量数据流,同时保持灵活性和可扩展性。每个pipeline可以独立配置和优化,以适应不同的数据处理需求。

二、Logstash的安装与基本配置

事先要安装Java的环境?

Logstash是用JRuby(Ruby语言的一个Java平台上的实现)开发的

Logstash选择使用DSL(领域特定语言),类似于Ruby的语言,主要基于以下几个原因:

-

领域表达力(Expressiveness):

- DSL针对特定领域(如日志处理)进行了定制设计,提供了更丰富、直观的表达能力。Logstash的DSL语法和关键词与日志处理领域的问题域相匹配,使得用户能够更容易地理解和使用该语言。这使得DSL能够更好地描述和解决日志处理领域的问题,提高开发效率。

-

可读性(Readability):

- 由于DSL专注于特定领域,它的语法和结构可以更贴近该领域的自然语言表达方式,使得DSL代码更易于阅读和理解。这有助于降低开发人员的认知负担,并提高代码的可维护性。

-

简洁性(Conciseness):

- DSL通常具有简洁的语法和表达方式,能够通过少量的代码实现较复杂的操作。这有助于简化开发过程,减少代码量,提高代码的可读性和可维护性。

-

可扩展性(Extensibility):

- DSL的设计使得它能够轻松扩展以适应领域需求的变化。Logstash可以根据特定领域的新需求进行定制扩展,使得它能够更好地应对变化和演化。

-

提高领域专家参与度:

- DSL的语法和结构更贴近领域专家的思维方式,使得他们能够更直接地参与到软件开发过程中。领域专家可以使用DSL编写领域特定的规则、策略和逻辑,从而更好地表达和实现他们的需求。

-

开发效率和沟通成本:

- 清晰的语义表达可以极大的提升生产效率,同时,受限的表达性也降低了犯错概率。领域专家或者产品人员,读不懂代码,但是可以理解DSL,因为DSL是通用语言,是团队内部沉淀下来的领域知识,也足够简单。所以业务方可以在没有编程基础且没有研发同学协助的前提下,自行做一些业务探索。

-

Logstash与JRuby的关系:

- Logstash是用JRuby(Ruby语言的一个Java平台上的实现)开发的,因此,使用类似Ruby的DSL可以更好地利用JRuby的特性,同时保持配置文件的简洁性和灵活性。

综上所述,Logstash使用DSL的主要原因是为了提供一种更贴近日志处理领域的、易于理解和使用的配置语言,同时保持高度的可扩展性和灵活性,以满足不同用户在日志处理方面的需求。

yum install java

Logstash 安装

Logstash 可以通过多种方式安装,包括使用包管理器、下载预编译的二进制文件或者使用 Docker。以下是使用包管理器在常见的操作系统上安装 Logstash 的基本步骤:

Debian/Ubuntu

sudo apt-get install curl

curl -L -O https://artifacts.elastic.co/downloads/logstash/logstash-oss-<version>.deb

sudo dpkg -i logstash-oss-<version>.deb

Red Hat/CentOS

sudo yum install curl

curl -L -O https://artifacts.elastic.co/downloads/logstash/logstash-oss-<version>.rpm

sudo rpm -vi logstash-oss-<version>.rpm

macOS(使用 Homebrew)

brew install logstash

请将 <version> 替换为实际的 Logstash 版本号。

配置环境变量

#已知logstash的工具库位置为:/usr/share/logstash/bin

vim /etc/profile.d/logstash.sh# 编辑logstash.shexport PATH="/usr/share/logstash/bin":$PATH

#退出编辑后,使环境变量生效

source /etc/profile

配置jvm.option的JVM堆大小

不超过物理内存的一半

Logstash的Pipeline

Logstash中的Pipeline是一个核心概念,它代表了一个完整的数据处理流程,包括输入(input)、过滤(filter)和输出(output)三个阶段。以下是关于Logstash Pipeline的概念、作用、配置和具体操作的详细说明:

Pipeline概念

Pipeline是Logstash中独立的运行单元,每个Pipeline都包含输入(input)和输出(output)两个必须的元素,以及一个可选的过滤器(filter)元素。Pipeline负责协调这三个阶段的执行,确保数据从输入源经过处理后能够输出到指定的目标。

具体作用

- 数据采集:通过输入(input)插件从各种数据源采集数据,如日志文件、网络端口等。

- 数据处理:使用过滤器(filter)插件对数据进行解析、转换和丰富,如使用Grok插件解析日志格式,或者使用Mutate插件修改字段。

- 数据输出:将处理后的数据通过输出(output)插件发送到目标位置,如Elasticsearch、文件系统等。

配置

Logstash的配置文件通常包含一个或多个Pipeline的配置。每个Pipeline的配置包括输入、过滤和输出三个部分,以及可选的编解码器(Codecs)。配置文件通常位于/etc/logstash/conf.d/目录下,而Pipeline的配置则在pipelines.yml文件中定义。

一个典型的Pipeline配置示例如下:

- pipeline.id: mainpath.config: "/etc/logstash/conf.d/*.conf"

- pipeline.id: custom-pipelinepipeline.workers: 2pipeline.batch.size: 8000pipeline.batch.delay: 10path.config: "/etc/logstash/pipeline/custom.conf"

在这个配置中,pipeline.id是Pipeline的唯一标识,path.config指定了包含该Pipeline配置文件的路径,pipeline.workers定义了处理线程的数量,pipeline.batch.size和pipeline.batch.delay定义了批处理的大小和延迟。

具体操作

- 启动Logstash:使用

logstash命令启动Logstash服务,并加载pipelines.yml中定义的Pipeline配置。 - 监控Pipeline:Logstash提供了监控API,可以通过访问

http://localhost:9600来查看Pipeline的状态和性能指标。 - 测试Pipeline:可以使用

logstash -f your-pipeline.conf -t命令来测试单个Pipeline配置文件的语法是否正确,并模拟运行Pipeline。 - 动态管理Pipeline:Logstash允许在不重启服务的情况下动态添加或修改Pipeline,这在处理大规模数据流时非常有用。

通过以上步骤,你可以配置和管理Logstash的Pipeline,实现高效的数据处理和流转。

Logstash的DSL语法

Logstash使用一种基于Ruby的DSL(Domain Specific Language,领域特定语言)来编写配置文件。这个DSL允许你定义数据流,包括输入(input)、过滤(filter)和输出(output)三个主要部分。以下是Logstash配置文件DSL的基本语法结构:

1. 基本结构

一个Logstash配置文件通常包含三个部分:

- 输入(input):定义数据来源。

- 过滤(filter):对输入的数据进行处理和转换。

- 输出(output):定义数据的目的地。

input {# 输入插件配置

}filter {# 过滤插件配置

}output {# 输出插件配置

}

2. 输入(input)

输入部分定义了数据的来源。Logstash提供了多种输入插件,例如file、syslog、http_poller等。每个插件都有其特定的配置选项。

input {file {path => "/var/log/application.log"start_position => "beginning"}

}

3. 过滤(filter)

过滤部分用于处理和转换输入的数据。Logstash提供了多种过滤插件,例如grok、date、mutate等。过滤插件可以修改、添加或删除事件字段。

filter {grok {match => { "message" => "%{COMBINEDAPACHELOG}" }}date {match => [ "timestamp", "ISO8601" ]}

}

4. 输出(output)

输出部分定义了数据的目的地。Logstash提供了多种输出插件,例如elasticsearch、file、stdout等。每个插件都有其特定的配置选项。

output {elasticsearch {hosts => ["http://localhost:9200"]index => "logstash-%{+YYYY.MM.dd}"}

}

5. 插件配置

每个插件都有其特定的配置选项,这些选项通常以键值对的形式出现。例如:

path:文件路径match:用于grok插件的正则表达式匹配hosts:Elasticsearch的主机地址列表

6. 条件和逻辑

Logstash的DSL也支持条件语句和逻辑操作,例如if语句:

filter {if [type] == "syslog" {grok {match => { "message" => "%{SYSLOGBASE}" }}}

}

7. 插件参数类型

Logstash的插件参数可以是不同的类型,包括字符串、数字、布尔值、数组等。例如:

output {stdout {codec => rubydebug}

}

在这个例子中,codec参数被设置为字符串rubydebug。

总结

Logstash的DSL提供了一种灵活的方式来定义和处理数据流。通过组合不同的插件和配置选项,你可以创建强大的数据处理管道,以满足各种数据收集、处理和输出的需求。

Logstash 基本配置

Logstash 配置文件通常以 .conf 为后缀,由三个主要部分组成:输入(input)、过滤(filter)和输出(output)。

1. 输入(Input)

输入部分定义了 Logstash 如何从数据源获取数据。例如,从文件中读取日志:

input {file {path => "/var/log/syslog"start_position => "beginning"}

}

输入部分定义了Logstash从哪里获取数据。Logstash支持多种输入插件,常见的有file、stdin、syslog等。

语法示例:

input {file {path => "/var/log/messages" # 指定日志文件路径start_position => "beginning" # 从文件开头开始读取type => "syslog" # 为事件定义类型}

}

这个例子中,Logstash将从/var/log/messages文件中读取数据,并且从文件的开始位置读取日志。

2. 过滤(Filter)

过滤部分定义了对数据进行处理的规则。例如,使用 grok 插件解析 syslog 格式:

filter {grok {match => { "message" => "%{SYSLOGBASE}" }}

}

过滤部分定义了对输入数据的处理逻辑。Logstash提供了多种过滤器插件,如grok、mutate、date等。

语法示例:

filter {grok {match => { "message" => "%{TIMESTAMP_ISO8601:timestamp} %{DATA:level} %{HOSTNAME:hostname} %{DATA:message}" }}date {match => ["timestamp", "ISO8601"] # 指定时间戳字段和格式}

}

在这个例子中,grok过滤器用于解析日志消息,并提取时间戳、日志级别、主机名和消息内容。date过滤器用于将时间戳字段转换为Logstash可以识别的日期格式。

3. 输出(Output)

输出部分定义了处理后的数据应该发送到哪里。例如,将数据发送到 Elasticsearch:

output {elasticsearch {hosts => ["http://localhost:9200"]index => "logstash-logs-%{+YYYY.MM.dd}"}

}

输出部分定义了处理后的数据发送到哪里。Logstash支持多种输出插件,常见的有elasticsearch、stdout、file等。

语法示例:

output {elasticsearch {hosts => ["localhost:9200"] # Elasticsearch服务器地址index => "logstash-%{+YYYY.MM.dd}" # 定义索引名称,包含日期}

}

这个例子中,处理后的日志数据将被发送到本地运行的Elasticsearch实例,并存储在以当天日期命名的索引中。

完整的 Logstash 配置示例

将以上三个部分组合在一起,一个完整的 Logstash 配置文件可能如下所示:

input {file {path => "/var/log/syslog"start_position => "beginning"}

}filter {grok {match => { "message" => "%{SYSLOGBASE}" }}

}output {elasticsearch {hosts => ["http://localhost:9200"]index => "logstash-logs-%{+YYYY.MM.dd}"}

}

下面是一个完整的Logstash配置文件示例,它从文件中读取日志,解析日志,并将数据输出到Elasticsearch:

input {file {path => "/var/log/access.log"start_position => "beginning"}

}filter {grok {match => { "message" => "%{COMBINEDAPACHELOG}" }}

}output {elasticsearch {hosts => ["localhost:9200"]index => "logstash-%{+YYYY.MM.dd}"}

}

这个配置文件首先从/var/log/access.log文件中读取Apache访问日志,然后使用grok过滤器解析日志格式,最后将解析后的数据输出到Elasticsearch中,索引名称包含日期。

运行 Logstash

配置好 .conf 文件后,可以通过以下命令启动 Logstash:

logstash -f /path/to/your/logstash.conf

请将 /path/to/your/logstash.conf 替换为你的配置文件的实际路径。

注意事项

- 确保 Elasticsearch 服务正在运行,并且 Logstash 有权限访问 Elasticsearch 的端口(默认为 9200)。

- 根据需要安装额外的 Logstash 插件,可以使用

logstash-plugin命令安装。 - 配置文件中的路径、端口和索引名称需要根据实际情况进行调整。

Logstash 的配置非常灵活,可以根据具体的数据源和需求进行调整。上述步骤提供了一个基本的起点,但在实际部署中可能需要更复杂的配置。

logstash命令的选项用法

三、Logstash的input、filter和output组件

从标准输入拿到标准输出

logstash -e 'input{stdin{}} output{stdout{}}'

## logstash启动后,输入要传输到标准输出的数据

从标准输入拿到文件中

# 使用绝对路径

logstash -e 'input{stdin{}} output{file{path => "/output_data/test_stdin_to_file.txt"}}'

## logstash启动成功后,输入要放在这个文件中的数据

# 使用相对路径

logstash -e 'input{stdin{}} output{file{path => "output_data/test_stdin_to_file.txt"}}'

## logstash启动成功后,输入要放在这个文件中的数据

logstash检查文件的路径中的目录不存在时,会自动创建;也要注意这里的文件的路径传入的是否为绝对路径还是相对路径

嵌入日期的文件名:

logstash -e 'input{stdin{}} output{file{path => "/tmp/test_logstash_stdin_to_file_%{+YYYY.MM.dd}"}}'

## logstash启动后,输入要传输到文件中的数据

从标准输入拿到ElasticSearch中

这里的index表示ElastsicSearch中的索引名字,且创建的(如果ElasticSearch中没有的话)索引的名字必须时小写的

logstash -e 'input{stdin{}} output{elasticsearch{hosts => ["10.0.0.81:9200"] index => "test_logstash_stdin_to_elasticsearch_%{+YYYY.MM.dd}"}}'

## logstash启动后,然后依次换行输入要在这个ElasticSearch中的索引存储的数据

Hi_eSearch_nodes_I_am_logstash

Bye_eSearch_nodes_I_am_logstash

Haha_eSearch_nodes_I_am_logstash以下是输入命令之后,通过elasticsearch-head插件来验证的效果:

input中使用file的具体语法

关于Logstash中的file输入插件的详细使用,以下是一些关键的配置选项和它们的说明:

-

基本配置:

path:指定要读取的文件路径,支持通配符匹配多个文件,必须是绝对路径。exclude:排除不想监听的文件。add_field:向事件添加自定义字段。tags:给事件添加标签,有助于后续处理。delimiter:设置新事件的标志,例如可以设置为换行符\n,用于将多行日志合并为一个事件。

-

文件发现和监控:

discover_interval:设置Logstash扫描目录发现新文件的时间间隔。stat_interval:设置Logstash检测文件是否修改的时间间隔。start_position:设置文件的起始读取位置,可以是beginning或end,默认为end,即从文件末尾开始读取。

-

文件读取和处理:

sincedb_path:设置记录文件读取位置的sincedb文件路径,允许Logstash在重启后从上次停止的位置继续读取。sincedb_write_interval:设置sincedb文件写入的时间间隔。

-

文件读取模式:

file_mode:可以设置为tail或read。tail模式会持续监控文件的新数据,而read模式会读取文件的全部内容后关闭文件。

-

文件处理完成操作:

file_completed_action:当文件被完全处理后,可以设置一个动作,例如delete、keep等。

-

文件排序和读取:

sort_field:可以设置为last_modified或path,用来决定是根据文件的最后修改时间还是完整路径来排序文件。sort_order:可以设置为asc或desc,用来决定文件是按升序还是降序处理。

-

文件句柄和性能:

max_open_files:设置这个输入可以同时打开的最大文件句柄数。file_chunk_count和file_chunk_size:用于控制文件的分块读取,可以用于带状或条纹读取模式。

-

兼容性与ECS:

ecs_compatibility:配置插件以ECS兼容方式添加元数据。

这些是file输入插件的主要配置选项,可以根据具体的日志处理需求进行调整和配置。记得在配置时,路径必须是绝对路径,并且根据你的操作系统和Elasticsearch集群的配置,可能还需要设置其他的安全和连接参数。

Logstash中的file input组件用于从文件中流式传输事件。以下是file input组件的一些具体使用语法和教程:

基本配置

最基本的配置需要指定path参数,这表示你想要监控的文件或文件目录。例如:

input {file {path => "/var/log/*.log"}

}

这里的path支持glob模式匹配,可以是一个路径或者路径数组。

"glob模式匹配"是一种文件名模式匹配的标准,它允许用户使用特定的字符来表示文件名中的任意字符或者字符序列。这种模式匹配通常用于在文件系统中搜索符合特定模式的文件或目录。在glob模式中,有几个特殊的字符:

*:代表任意数量的字符(包括零个字符)。?:代表任意单个字符。[...]:代表方括号内的任意单个字符,例如[abc]代表a、b或c中的任意一个字符。[!...]:代表不在方括号内的任意单个字符,例如[!abc]代表除了a、b、c之外的任意单个字符。{...}:代表花括号内的任意组合,例如{a,b,c}代表a、b或c。

使用glob模式匹配,用户可以快速找到符合特定模式的文件,而不需要精确地知道文件的完整名称。例如,在Unix-like系统中,使用*.txt可以匹配当前目录下所有以.txt结尾的文件。

模式和读取

file input组件有两种模式:Tail模式和Read模式。

- Tail模式:默认模式,跟踪变化的文件并随着新内容的添加而发出新内容。文件被视为无限流,EOF没有特殊意义。当文件被轮转时,如果检测到文件大小变小或为零,当前位置会被重置为零,然后继续流式传输。

- Read模式:将每个文件视为完整的内容,即有限的行流,现在EOF是重要的。EOF意味着文件可以关闭并放入“unwatched”状态,这自动释放了活动窗口中的空间。此模式还允许处理压缩文件,因为它们是内容完整的。

配置参数

以下是一些常用的配置参数:

- exclude:排除不想监听的文件,支持glob模式。

- add_field:向事件添加自定义字段。

- tags:为事件添加标签,这些标签可以在后续处理中起到标志作用。

- delimiter:事件分行的标志,对于多行事件比较有用。

- discover_interval:设置Logstash多久扫描一次目录以发现新文件。

- stat_interval:设置Logstash多久检查一次被监听文件状态(是否有更新)。

- start_position:设置Logstash从文件的什么位置开始读取数据,可以是"beginning"或"end"。

- sincedb_path:自定义sincedb文件的位置,sincedb文件用于记录每个文件的当前位置。

- sincedb_write_interval:设置Logstash多久写一次sincedb文件。

- ignore_older:设置文件最后修改时间超过这个值的文件将被忽略。

- file_completed_action:在Read模式下,当文件处理完成时执行的动作,可以是"delete"、“log"或"log_and_delete”。

- file_completed_log_path:当

file_completed_action设置为"log"或"log_and_delete"时,指定完成读取的文件路径被记录的文件。

示例配置

以下是一个更详细的配置示例:

input {file {path => ["/var/log/*.log", "/var/log/messages"]exclude => ".gz$"add_field => {"custom_field" => "custom_value"}tags => ["logstash_file"]delimiter => "\n"discover_interval => 15stat_interval => 1start_position => "beginning"sincedb_path => "/var/lib/logstash/sincedb"sincedb_write_interval => 15ignore_older => 86400}

}

这个配置监听/var/log/目录下的所有.log文件和/var/log/messages文件,排除所有以.gz结尾的文件,为每个事件添加一个自定义字段,设置事件的分隔符为换行符,并设置了其他一些参数来控制文件的发现和状态检查。

以上是file input组件的基本使用语法和教程,你可以根据具体需求调整配置参数。

如何同时获取两个文件传到elasticsearch中的不同或是相同索引中

不推荐的方法

input{file{# 第一个文件中的格式}file{# 第二个文件中的格式}

}output{elasticsearch{#保存第一个文件的索引}elasticsearch{#保存第二个文件的索引}

}

使用嵌入type变量的方法

input{file{# 第一个文件的格式#...type => "file1_part"}file{# 第二个文件的格式#...type => "file2_part"}

}output{elasticsearch{hosts => ["xxx.xxx.xxx.xxx:xx"]index => "%{type}_xxxxxxx"}

}

input中的file中可以使用“%{+YYYY.MM.dd}”吗?

在Logstash中,input插件的file类型不支持使用%{+YYYY.MM.dd}这样的日期格式占位符。这是因为LogStash::Inputs::File只在进程运行的注册阶段初始化一个FileWatch对象,所以它不能支持类似path => "/path/to/%{+yyyy/MM/dd/hh}.log"的写法。要达到类似的目的,你需要使用通配符,例如path => "/path/to/*/*/*/*.log"。

如果你需要处理具有特定日期格式的文件路径,你可以在Logstash的filter部分使用date过滤器来解析日志中的时间戳,并将其转换为@timestamp字段。这样,你就可以在输出到Elasticsearch时使用@timestamp字段来生成带有日期格式的索引名称。

例如,如果你的日志文件名包含日期,你可以这样配置Logstash:

input {file {path => ["/path/to/*/*/*/*.log"] # 使用通配符匹配文件start_position => "beginning" # 从文件开头开始读取}

}filter {grok {match => { "path" => "%{DATA:filename}" }}date {match => [ "filename", "YYYY.MM.dd", "MMM d HH:mm:ss", "ISO8601" ] # 根据实际情况选择合适的日期格式target => "@timestamp" # 将解析后的日期设置为@timestamp}

}output {elasticsearch {hosts => ["http://localhost:9200"]index => "logstash-%{+YYYY.MM.dd}" # 使用@timestamp字段中的日期来生成索引名称}

}

在这个配置中,grok过滤器用于从文件路径中提取文件名,然后date过滤器用于解析文件名中的日期。解析后的日期被设置为@timestamp字段,最后在输出到Elasticsearch时,使用@timestamp字段中的日期来生成索引名称。这样,你就可以在Elasticsearch中拥有按日期分隔的日志数据了。

在Logstash的date过滤器中,match数组中的元素是用来指定日期时间格式的。这里的"YYYY.MM.dd"、"MMM d HH:mm:ss"和"ISO8601"是三种不同的日期时间格式,它们是否都需要写取决于你的日志文件中日期时间的表现形式。

-

“YYYY.MM.dd”:如果你的日志文件名或内容中包含的日期格式是年-月-日(例如

2024.11.08),那么你需要包含这个格式。 -

“MMM d HH:mm:ss”:如果你的日志文件名或内容中包含的日期时间格式是月份缩写、日期、小时、分钟和秒(例如

Nov 8 12:00:00),那么你需要包含这个格式。 -

“ISO8601”:如果你的日志文件名或内容中包含的日期时间格式是ISO 8601标准格式(例如

2024-11-08T12:00:00Z),那么你需要包含这个格式。

你不需要在match数组中包含所有这些格式,只需要包含那些实际出现在你的日志文件中的日期时间格式。例如,如果你的日志文件名是app-2024.11.08.log,而日志内容中的日期时间是Nov 8 12:00:00,那么你的match数组应该包含这两个格式:

match => [ "filename", "YYYY.MM.dd", "MMM d HH:mm:ss" ]

如果你的日志文件中还包含了ISO 8601格式的日期时间,那么你可以添加这个格式:

match => [ "filename", "YYYY.MM.dd", "MMM d HH:mm:ss", "ISO8601" ]

但是,如果你的日志文件中没有ISO 8601格式的日期时间,那么你就不需要包含"ISO8601"这个格式。总之,match数组中的格式应该与你日志文件中实际出现的日期时间格式相匹配。

input中使用syslog的具体语法

Logstash中的input插件syslog用于从网络读取Syslog消息作为事件。以下是如何在Logstash中配置和使用syslog输入插件的具体说明:

1. 配置Logstash监听Syslog

在Logstash的配置文件中,你可以添加一个input块来配置syslog输入。以下是一个基本的配置示例:

input {syslog {port => "514" # Syslog默认端口为514}

}

这个配置将使Logstash监听在514端口上的Syslog消息。

2. 处理非标准Syslog格式

如果你的Syslog消息不符合RFC3164标准,你可以通过提供一个grok模式来解析非标准Syslog行。例如:

input {tcp {port => "8514"}

}

filter {grok {match => ["message", "%{SYSLOGLINE}"]}syslog_pri { }

}

这里使用了grok过滤器来匹配Syslog行,并使用syslog_pri过滤器来处理优先级。

3. 处理ECS兼容性

Logstash的Syslog输入插件支持Elastic Common Schema(ECS),你可以通过设置ecs_compatibility来控制插件与ECS的兼容性:

input {syslog {ecs_compatibility => "v1" # 可以设置为"disabled", "v1", 或 "v8"}

}

这将使插件使用与ECS兼容的字段名称,例如[log][syslog][priority]。

4. 配置设施和严重性级别标签

你可以使用facility_labels来覆盖RFC3164中定义的设施级别标签:

input {syslog {facility_labels => ["kernel", "user-level", ...] # 按顺序提供所有设施标签}

}

5. 配置时区

如果你需要指定一个时区用于日期解析,可以使用timezone设置:

input {syslog {timezone => "America/Los_Angeles" # 有效的时区ID}

}

6. 启动Logstash

配置完成后,你可以启动Logstash来开始接收Syslog消息。如果配置正确,Logstash将能够接收并处理来自网络设备的Syslog消息。

7. 查看接收到的Syslog数据

一旦Logstash开始接收Syslog消息,你可以在Logstash的输出(如控制台或Elasticsearch)中查看这些消息。例如,如果你使用了stdout输出,你将直接在控制台看到接收到的Syslog事件。

以上步骤提供了在Logstash中配置和使用Syslog输入的基本指南。根据你的具体需求,你可能需要调整配置参数以适应你的环境和数据格式。

Logstash中的syslog组件用于接收和处理syslog消息。以下是syslog组件的一些详细语法和配置选项:

-

输入(Input)配置:

port:指定Logstash监听的端口,用于接收syslog消息。type:为事件分配的类型。protocol:syslog服务器协议,可以是tcp、udp或ssl-tcp,默认为udp。reconnect_interval:连接失败时的重试间隔(秒)。format:syslog消息格式,可以选择rfc3164或rfc5424,默认为rfc3164。severity_label:syslog消息的严重性标签,可以使用%{foo}字符串构建新值。facility_label:syslog消息的设施标签,可以使用%{foo}字符串构建新值。host:源主机,可以使用%{foo}字符串构建新值。

-

过滤器(Filter)配置:

grok:使用正则表达式解析syslog消息。match:定义要匹配的字段和正则表达式模式。例如,{ "message" => "%{SYSLOGTIMESTAMP:syslog_timestamp} %{SYSLOGHOST:syslog_hostname} %{DATA:syslog_program}(?:\[%{POSINT:syslog_pid}\])?: %{GREEDYDATA:syslog_message}" }。

date:解析日期并将其设置为事件的时间戳。match:定义要解析的字段和日期格式。例如,[ "syslog_timestamp", "MMM d HH:mm:ss", "MMM dd HH:mm:ss" ]。

-

输出(Output)配置:

syslog:将事件输出到syslog服务器。id:为插件配置添加唯一ID。severity:syslog消息的严重性。facility:syslog消息的设施。message:syslog消息内容。protocol:输出时使用的协议。ssl_certificate_path:SSL证书路径。ssl_key_path:SSL密钥路径。ssl_key_passphrase:SSL密钥密码。ssl_verify:是否验证SSL连接。

这些是Logstash中syslog组件的一些基本配置选项。具体的配置可能会根据你的实际需求和环境有所不同。你可以根据这些选项来调整你的Logstash配置,以满足你的日志收集和处理需求。

在Logstash中,type字段用于为事件分配一个类型,这有助于后续的日志处理和分类。对于syslog组件,type字段可以设置为以下值:

-

disabled:不使用ECS兼容的字段名称(例如,使用priority表示syslog优先级)。 -

v1、v8:使用与Elastic Common Schema (ECS)兼容的字段(例如,[log][syslog][priority])。- 当Logstash提供了

pipeline.ecs_compatibility设置时,其值将用作默认值。 - 否则,默认值是

disabled。

- 当Logstash提供了

-

其他自定义类型:用户可以为syslog事件指定任何自定义的

type值,这主要用于基于类型的过滤器激活和在Kibana中搜索。

例如,如果你想要将所有syslog事件标记为system-syslog类型,可以在配置文件中这样设置:

input {syslog {port => 12525type => "system-syslog"}

}

这样,所有通过该syslog输入接收到的事件都将被标记为system-syslog类型,可以在后续的过滤器和输出中根据这个类型进行处理。

各个组件中的codec和multiline的语法

在Logstash中,codec是用于编码和解码数据的插件,它通常与input和output插件一起使用。以下是一些常见的codec的使用语法和教程:

1. Plain Codec

plain是最简单的编码插件,它直接将输入的数据作为输出,不做任何修改。例如,如果你在input中使用plain codec,它会将输入的每行数据作为一个事件的message字段。在output中使用时,它会将事件的message字段输出为原始文本。

配置示例:

input {stdin {codec => plain}

}

output {stdout {codec => plain}

}

在这个配置中,输入和输出都使用了plain codec,输入时它会读取标准输入的数据,输出时它会将事件的message字段输出到标准输出。

2. JSON and JSON Lines Codec

当处理JSON格式的数据时,可以使用json或json_lines codec。json codec期望输入是一个完整的JSON对象,而json_lines codec期望每行是一个独立的JSON对象。

配置示例(JSON):

input {stdin {codec => json}

}

output {stdout {codec => json}

}

在这个配置中,输入时它会解析标准输入中的JSON对象,输出时它会将事件序列化为JSON对象。

配置示例(JSON Lines):

input {stdin {codec => json_lines}

}

output {stdout {}

}

在这个配置中,输入时它会将每行作为一个独立的JSON对象进行解析,输出时它会简单地输出事件的message字段。

3. Multiline Codec

multiline codec用于将多行日志合并为一个事件。这在你想要将跨越多行的日志条目作为一个完整的事件处理时非常有用。

配置示例:

filter {multiline {pattern => "^\["negate => truewhat => "previous"}

}

在这个配置中,multiline filter插件会将不以[开头的行与前一行合并,直到遇到以[开头的行为止。

multiline codec的详细使用

Logstash的multiline codec插件用于处理多行日志事件,将其合并为单个事件。以下是multiline codec的一些高级使用技巧和配置选项:

1. 基本配置

multiline codec的主要配置选项包括pattern、what、negate等。以下是这些选项的基本用法:

-

pattern:指定一个正则表达式,用于识别多行事件的开始或结束。匹配到该模式的行将被视为事件的一部分。可以使用grok模式名称作为正则表达式。

input {stdin {codec => multiline {pattern => "^\\s" # 匹配以空白字符开始的行what => "previous"}} } -

what:指定匹配到

pattern时,当前行是属于前一行(previous)还是后一行(next)。previous:匹配到的行属于前一行。next:匹配到的行属于后一行。

-

negate:当设置为

true时,表示不匹配pattern的行将被合并到前一行或后一行。input {stdin {codec => multiline {pattern => "^%{TIMESTAMP_ISO8601} "negate => truewhat => "previous"}} }

2. 高级配置

除了基本配置外,multiline codec还提供了一些高级配置选项:

- max_lines:指定在触发flush操作之前,可以累积的最大行数,默认值为500。

- max_bytes:指定在触发flush操作之前,可以累积的最大字节数,默认值为“10 MiB”。

- multiline_tag:为实际包含多行的事件打上特定的标签。

- patterns_dir:指定自定义模式文件的目录,Logstash默认提供了一些模式文件,但你也可以添加额外的模式文件。

3. 使用示例

以下是一些multiline codec的实用示例:

-

合并Java堆栈跟踪:Java堆栈跟踪通常跨越多行,每行都以空白字符开始。

input {stdin {codec => multiline {pattern => "^\\s"what => "previous"}} }这将合并所有以空白字符开始的行到前一行。

-

合并C风格的行续行:C语言中使用反斜杠

\表示行续行。input {stdin {codec => multiline {pattern => "\\\\$"what => "next"}} }这将合并所有以反斜杠结束的行与下一行。

-

合并时间戳事件:某些服务的日志以时间戳开始,随后是具体活动信息。

input {file {path => "/var/log/someapp.log"codec => multiline {pattern => "^%{TIMESTAMP_ISO8601} "negate => truewhat => "previous"}} }这将合并所有不以时间戳开始的行到前一行。

通过合理配置multiline codec,Logstash可以有效地处理多行日志事件,确保日志数据的完整性和准确性。

以下是两个具体的应用示例,展示了Logstash的multiline codec在日志分析中的使用:

示例1:合并Java堆栈跟踪

Java应用程序的异常日志通常跨越多行,每行都以空白字符开始。为了将这些多行日志合并为单个事件,可以使用multiline codec如下配置:

input {stdin {codec => multiline {pattern => "^\\s" # 匹配以空白字符开始的行what => "previous" # 匹配到的行属于前一行}}

}

output {stdout {codec => rubydebug}

}

在这个配置中,任何以空白字符开始的行都会被合并到前一行,从而将整个堆栈跟踪作为一个完整的事件进行处理。这种配置对于分析Java异常日志特别有用,因为它允许你将整个异常堆栈作为一个事件来查看,而不是分散在多个事件中。

示例2:合并C风格的行续行

在C语言中,使用反斜杠\在行尾表示行续行。为了将这些行合并为单个事件,可以使用multiline codec如下配置:

input {stdin {codec => multiline {pattern => "\\\\$" # 匹配行尾的反斜杠what => "next" # 匹配到的行属于后一行}}

}

output {stdout {codec => rubydebug}

}

这个配置将任何以反斜杠结束的行与下一行合并,从而将跨行的C代码作为一个完整的事件进行处理。

这两个示例展示了如何使用Logstash的multiline codec来处理多行日志事件,使其合并为单个事件,便于后续的分析和处理。通过合理配置multiline codec,可以有效地解决多行日志事件的合并问题,提高日志分析的效率和准确性。

配置参数

- charset:设置字符编码,如

UTF-8或cp1252。 - ecs_compatibility:控制与Elastic Common Schema (ECS)的兼容性,可以设置为

disabled、v1或v8。

这些是Logstash中codec的一些基本使用语法和教程。你可以根据具体的数据格式和需求选择合适的codec插件。

filter的语法

在Logstash中,filter 插件用于在数据流经Logstash管道时对事件数据进行处理和转换。以下是filter的具体使用语法和一些常见的配置选项:

基本语法

filter {# 插件名称 { 配置选项 }plugin {option1 => value1option2 => value2}

}

常见filter插件

Logstash提供了许多内置的filter插件,以下是一些常用的:

-

grok:用于解析未结构化的日志数据,并将其转换为结构化的字段。

filter {grok {match => { "message" => "%{COMBINEDAPACHELOG}" }} } -

mutate:用于修改事件数据,如转换字段类型、删除字段、替换值等。

filter {mutate {add_field => { "new_field" => "value" }remove_field => ["field_to_remove"]replace => ["field_to_replace", "replacement_value"]} } -

date:用于解析日期字符串并将其转换为Logstash可以识别的日期类型。

filter {date {match => [ "timestamp", "ISO8601" ]} } -

useragent:用于解析用户代理字符串并提取相关信息。

filter {useragent {source => "user_agent"} } -

uri_parts:用于解析URI并提取其组成部分。

filter {uri_parts {field => "request"target => "parsed_uri"} }

复合结构

filter 块可以包含多个插件,以实现更复杂的数据处理流程。

filter {grok {match => { "message" => "%{COMBINEDAPACHELOG}" }}date {match => [ "timestamp", "ISO8601" ]}mutate {add_field => { "new_field" => "value" }remove_field => ["field_to_remove"]}

}

条件语句

可以在filter块中使用条件语句来控制插件的执行。

filter {if "some condition" {grok {match => { "message" => "%{COMBINEDAPACHELOG}" }}}

}

匹配多个字段

可以在单个插件中匹配多个字段。

filter {grok {match => ["message", "%{COMBINEDAPACHELOG}","another_field", "%{GREEDYDATA}"]}

}

缓存机制

某些filter插件(如grok)可以使用缓存机制来提高性能。

filter {grok {match => { "message" => "%{COMBINEDAPACHELOG}" }overwrite => ["message"] # 覆盖原始字段cache_size => 1000 # 缓存1000条模式}

}

插件配置

每个filter插件都可以有自己的配置选项,这些选项用于控制插件的行为。

filter {plugin {option1 => value1option2 => value2# ...}

}

filter 块是Logstash配置中的核心部分,它允许你对事件数据进行丰富的处理和转换。通过组合不同的filter插件,你可以实现复杂的数据处理逻辑,以满足各种日志分析需求。记得在实际应用中根据你的具体需求选择合适的filter插件,并合理配置它们的选项。

1. grok

作用:grok插件是Logstash中最常用的插件之一,它使用正则表达式来解析半结构化数据(如日志行)并将其转换为结构化数据。grok插件通常与Logstash的grok模式库一起使用,该库包含了许多预定义的模式,用于匹配常见的日志格式。

示例:

filter {grok {match => { "message" => "%{COMBINEDAPACHELOG}" }}

}

在这个示例中,grok插件将Apache的组合日志行解析为多个字段,如clientip、userid、timestamp等。

2. mutate

作用:mutate插件用于修改事件中的字段。它可以添加新字段、删除现有字段、修改字段名称、转换字段数据类型、替换字段值等。

示例:

filter {mutate {add_field => { "new_field" => "value" }remove_field => ["field_to_remove"]replace => ["field_to_replace", "replacement_value"]}

}

这个配置添加了一个新字段new_field,删除了field_to_remove,并替换了field_to_replace字段的值。

3. date

作用:date插件用于解析日期字符串并将其转换为Logstash可以识别的日期类型。这对于处理包含日期信息的日志文件非常有用。

示例:

filter {date {match => [ "timestamp", "ISO8601" ]}

}

在这个示例中,date插件将ISO8601格式的日期字符串解析为Logstash的日期字段。

4. useragent

作用:useragent插件用于解析用户代理(User-Agent)字符串,并提取出设备类型、操作系统、浏览器等信息。

示例:

filter {useragent {source => "user_agent"}

}

这个配置从user_agent字段中提取用户代理信息,并创建相应的字段。

5. uri_parts

作用:uri_parts插件用于解析统一资源标识符(URI)并提取其组成部分,如scheme、host、port、path、query等。

示例:

filter {uri_parts {field => "request"target => "parsed_uri"}

}

这个配置解析request字段中的URI,并将其组成部分存储在parsed_uri字段中。

6. multiline

作用:multiline插件用于合并多行日志事件为单个事件。这在处理如Java堆栈跟踪或C风格的行续行日志时非常有用。

示例:

input {file {path => "/var/log/someapp.log"codec => multiline {pattern => "^%{TIMESTAMP_ISO8601} "negate => truewhat => "previous"}}

}

这个配置将匹配特定模式的多行日志合并为一个事件。

这些插件的具体作用是帮助Logstash用户处理和转换各种类型的日志数据,使其更加结构化和易于分析。通过这些插件,Logstash能够适应不同的日志格式和数据处理需求。

*JSON数据格式的介绍

什么是JSON?

JSON(JavaScript Object Notation)是一种轻量级的数据交换格式,易于人阅读和编写,同时也易于机器解析和生成。它基于JavaScript的一个子集,但是独立于语言,可以被多种编程语言读取,包括Python、Java、C#、Ruby等。

JSON的结构

JSON数据格式由键值对组成,数据以对象或数组的形式存储。一个对象是键值对的集合,其中键是字符串,值可以是字符串、数字、对象、数组、布尔值或null。一个数组是值的有序集合,值可以是任何类型。

JSON的用途

- 数据交换:JSON因其简洁和跨平台的特性,被广泛用于网络应用之间的数据交换。

- 配置文件:许多应用程序使用JSON作为配置文件格式,因为它易于阅读和编辑。

- APIs:Web API通常使用JSON作为数据格式,因为它易于前后端开发者理解和使用。

- 存储数据:一些数据库和文件格式使用JSON来存储数据。

- 缓存:JSON可以用于缓存数据,因为它可以快速序列化和反序列化。

如何使用JSON

在JavaScript中使用JSON

// 创建一个JSON对象

var obj = {"name": "John","age": 30,"city": "New York"

};// 将对象转换为JSON字符串

var jsonString = JSON.stringify(obj);// 将JSON字符串转换回对象

var objFromJson = JSON.parse(jsonString);

在Python中使用JSON

import json# 创建一个字典

data = {"name": "John","age": 30,"city": "New York"

}# 将字典转换为JSON字符串

json_string = json.dumps(data)# 将JSON字符串转换回字典

data_from_json = json.loads(json_string)

在Java中使用JSON

import org.json.JSONObject;// 创建一个JSON对象

JSONObject obj = new JSONObject();

obj.put("name", "John");

obj.put("age", 30);

obj.put("city", "New York");// 将对象转换为JSON字符串

String jsonString = obj.toString();// 将JSON字符串转换回对象

JSONObject objFromJson = new JSONObject(jsonString);

在其他语言中

大多数现代编程语言都有处理JSON的库,你可以使用这些库来序列化(将对象转换为JSON字符串)和反序列化(将JSON字符串转换回对象)。

关于JSON的标准格式和最佳实践,以下是一些关键点:

JSON标准格式

-

基本结构:JSON基于两种结构:对象(键值对集合)和数组(值的有序列表)。对象由大括号

{}包围,数组由方括号[]包围。值可以是字符串、数字、对象、数组、布尔值或null。 -

字符串和字符问题:JSON文本必须使用UTF-8编码[RFC3629]。JSON中的字符串是Unicode字符序列,用双引号包围,并使用反斜杠转义。

-

转义序列:JSON中可以转义任何字符。如果在基本多文种平面内,可以用六字符序列表示:一个反斜杠、小写字母u,后跟四个十六进制数字编码字符的代码点。

-

JSON Schema:JSON Schema是一种基于JSON的格式,用于描述和验证JSON数据结构。它定义了数据应该包含的元素、元素的数据类型、字段是否为必填,以及某些元素可接受的值范围。

JSON最佳实践

-

保持结构清晰:使用一致的键值对,并避免不必要的数据嵌套,以保持JSON结构的清晰和组织性。

-

使用JSON Schema验证:通过JSON Schema验证可以确保代码标准化,并在早期发现不一致性,减少调试工作量。

-

使用数组处理大数据字符串:对于大数据字符串,使用数组比多个键值对更有效,数组更易于管理和理解。

-

保持Schema简单:在创建复杂的JSON Schema时,保持简单性是关键,不要过度复杂化数据表示。

-

版本控制:随着服务的增长,可能会引入不兼容的更改,导致API版本变化。因此,合理地管理API版本对于开发者来说非常重要。

-

命名约定:在定义RESTful Web Service API时,应遵循命名约定,明确区分单个元素和元素集合。

-

编码:无论是JSON还是XML,都使用UTF-8编码。

-

资源表示:发布数据时应使用对开发者友好的JSON格式,并使用众所周知的标识符来描述数据。

遵循这些标准和最佳实践可以帮助确保JSON数据的一致性、可读性和有效性,同时也便于在不同的系统和应用程序之间进行数据交换。

JSON数据格式的语法

JSON(JavaScript Object Notation)是一种轻量级的数据交换格式,易于人阅读和编写,同时也易于机器解析和生成。它基于JavaScript的一个子集,但JSON是独立于语言的文本格式,许多编程语言都支持JSON格式的数据交换。以下是JSON的基本语法:

-

数据类型:

- 对象:由花括号

{}包围,包含一系列键值对(key-value pairs)。例如:{"key": "value"} - 数组:由方括号

[]包围,包含一系列值。例如:["value1", "value2"] - 字符串:必须用双引号

"包围。例如:"Hello, World!" - 数字:表示为标准的数字格式,包括整数和浮点数。例如:

123或3.14 - 布尔值:只有两个可能的值,

true和false。 - null:表示一个空值或不存在的值。

- 对象:由花括号

-

键值对:

- 键(key)必须是一个字符串,并且必须用双引号包围。

- 键和值之间用冒号

:分隔。 - 键值对之间用逗号

,分隔。

-

对象(Object):

- 对象是一个无序的键值对集合。

- 对象表示为

{key1: value1, key2: value2, ...}。

-

数组(Array):

- 数组是值的有序集合。

- 数组表示为

[value1, value2, ...]。

-

特殊值:

true、false和null是特殊的值,它们不使用引号。

-

嵌套:

- 对象和数组可以相互嵌套,也可以嵌套在对象内部。

-

空白符:

- JSON允许在对象或数组中使用空白符(空格、制表符、换行符)来增强可读性,但这些空白符在解析时会被忽略。

-

注释:

- 标准JSON不支持注释,但在某些实现中,注释可能会被忽略。

JSON示例:

{"name": "John Doe","age": 30,"is_student": false,"skills": ["JavaScript", "Python", "C++"],"address": {"street": "123 Main St","city": "Anytown","state": "CA","zip": "12345"}

}

在这个示例中,我们有一个对象,包含一个字符串、一个数字、一个布尔值、一个数组和一个嵌套对象。每个键值对之间用逗号分隔,键用双引号包围,整个对象用花括号包围。数组用方括号包围,包含一系列字符串。

Logstash使用filter的json对json格式的源文件的内容的json元素单独拿出来

注:json格式的源文件的内容是存在logstash中的message变量中的

经过上面的过滤后将logstash的message的这些合并的内容就显得多余了,可使用json的remove_field一并将其删掉

input{}filter{json{source => "message"remove_field => ["message"]}}output{}

Logstash如何将codec合并的数据还原成单独的

在Logstash中,如果你想要将合并的数据(通过multiline codec合并的日志条目)还原成单独的事件,你可以使用dissect过滤器插件或者mutate和grok过滤器插件的组合来实现。以下是两种方法的示例:

方法1:使用dissect过滤器

dissect过滤器可以将一个字段的值拆分成多个字段。如果你知道合并后的日志条目的结构,你可以使用dissect来将其拆分。

filter {dissect {field => "message" # 假设合并后的数据存储在message字段target_prefix => "" # 你可以根据需要设置前缀mapping => {"%{some_field1}" => "field1""%{some_field2}" => "field2"# ... 其他字段}}

}

方法2:使用mutate和grok过滤器

如果你不熟悉合并数据的结构,或者想要更灵活地处理数据,可以使用grok过滤器来解析合并后的日志条目。

filter {# 首先,你可以使用mutate将合并后的数据移动到一个新字段mutate {copy => { "message" => "original_message" }}# 然后,使用grok解析原始日志条目grok {match => { "original_message" => "你的grok模式" }}

}

这里的“你的grok模式”应该根据你的日志格式来定义。grok模式是一种强大的模式匹配系统,可以帮助你从复杂的日志数据中提取结构化信息。

输出

在这两种方法中,你都可以添加output部分来将处理后的数据输出到你选择的目的地,比如Elasticsearch、文件或其他任何Logstash支持的输出插件。

output {elasticsearch {hosts => ["http://localhost:9200"] # Elasticsearch服务器地址index => "logstash-logs-%{+YYYY.MM.dd}" # 索引名称}

}

请注意,这些只是基本的示例,实际的配置可能会根据你的具体需求和日志格式有所不同。你可能需要调整grok模式或dissect映射以适应你的日志数据。

input或output中使用tcp或udp组件的语

在Logstash中使用TCP或UDP组件作为输入(input)或输出(output)时,你需要在配置文件中指定相应的设置。以下是具体的语法说明:

TCP作为输入(input)

input {tcp {port => YOUR_PORT # 监听的端口号,必填项host => "0.0.0.0" # 监听的地址,默认为"0.0.0.0",表示接受所有网络接口的连接mode => "server" # 模式,可以是"server"或"client",默认为"server"ssl_enable => false # 是否启用SSL,默认为falsecodec => json # 使用的编码器,默认为json# 其他可能的设置...}

}

port: 指定Logstash监听的端口号,这是必填项。host: 指定Logstash监听的网络地址,默认为"0.0.0.0",表示接受所有网络接口的连接。mode: 可以设置为"server"或"client",默认为"server"。在"server"模式下,Logstash将等待客户端连接;在"client"模式下,Logstash将主动连接到指定的服务器。ssl_enable: 是否启用SSL加密,默认为false。codec: 指定用于编码输入数据的编解码器,默认为json。

TCP作为输出(output)

output {tcp {host => "REMOTE_HOST" # 远程服务器的地址,必填项port => REMOTE_PORT # 远程服务器的端口号,必填项codec => json_lines # 使用的编码器,每条数据后加上换行符,默认为json# 其他可能的设置...}

}

host: 指定远程服务器的地址,这是必填项。port: 指定远程服务器的端口号,这是必填项。codec: 指定用于编码输出数据的编解码器,推荐使用json_lines以便每条数据后加上换行符,方便接收端处理,默认为json。

UDP作为输入(input)

input {udp {port => YOUR_PORT # 监听的端口号,必填项host => "0.0.0.0" # 监听的地址,默认为"0.0.0.0",表示接受所有网络接口的数据codec => plain # 使用的编码器,默认为plain# 其他可能的设置...}

}

port: 指定Logstash监听的端口号,这是必填项。host: 指定Logstash监听的网络地址,默认为"0.0.0.0",表示接受所有网络接口的数据。codec: 指定用于编码输入数据的编解码器,默认为plain。

UDP作为输出(output)

output {udp {host => "REMOTE_HOST" # 远程服务器的地址,必填项port => REMOTE_PORT # 远程服务器的端口号,必填项codec => plain # 使用的编码器,默认为plain# 其他可能的设置...}

}

host: 指定远程服务器的地址,这是必填项。port: 指定远程服务器的端口号,这是必填项。codec: 指定用于编码输出数据的编解码器,默认为plain。

以上是Logstash中TCP和UDP组件的基本配置语法。根据你的具体需求,可能需要调整配置选项。

四、Logstash获取数据到Elasticsearch

Logstash和Elasticsearch如何协同工作

Logstash 和 Elasticsearch 协同工作,形成了一个强大的数据处理和搜索平台。Logstash 负责数据的采集、处理和转发,而 Elasticsearch 负责数据的存储、索引和搜索。以下是它们协同工作的详细流程:

1. 数据采集(Data Ingestion)

- Logstash 输入(Inputs):Logstash 通过定义的输入插件从各种数据源采集数据。这些数据源可以是日志文件、数据库、消息队列(如 Kafka)、APIs 等。

- 数据预处理:Logstash 可以配置多个输入管道,从多个数据源同时采集数据。

2. 数据处理(Data Processing)

- Logstash 过滤器(Filters):采集到的数据通过 Logstash 的过滤器插件进行处理。过滤器可以执行多种操作,包括解析、转换数据格式、丰富数据内容、条件判断等。

- 数据清洗:过滤器可以清洗数据,比如去除不需要的字段、标准化日期格式、重命名字段等。

- 数据转换:Logstash 可以将数据从一种格式转换为另一种格式,例如,将 CSV 格式的日志转换为 JSON 格式,使其更适合 Elasticsearch 索引。

3. 数据输出(Data Output)

- Logstash 输出(Outputs):处理后的数据通过 Logstash 的输出插件发送到指定的目的地。

- 索引数据到 Elasticsearch:Logstash 将数据输出到 Elasticsearch,Elasticsearch 接收数据并将其存储在索引中。这些索引是 Elasticsearch 中存储和检索数据的基本单元。

4. 数据存储和索引(Data Storage and Indexing)

- Elasticsearch 索引:Elasticsearch 接收来自 Logstash 的数据,并根据 Logstash 配置的索引名称创建或更新索引。

- 数据模型:Elasticsearch 将数据存储在倒排索引中,这是一种优化搜索操作的数据结构。

5. 数据搜索和分析(Data Search and Analysis)

- Elasticsearch 查询:一旦数据被索引,就可以使用 Elasticsearch 的强大搜索能力来查询和分析数据。

- Kibana 可视化:通常与 Elasticsearch 一起使用的 Kibana 可以连接到 Elasticsearch 索引,并提供数据可视化、仪表板和探索工具。

6. 可扩展性和容错性

- Logstash 和 Elasticsearch 都是分布式系统:它们可以水平扩展以处理大量数据。

- 容错性:Elasticsearch 的副本分片和 Logstash 的多实例运行提供了容错性。

7. 实时数据处理

- 近实时(NRT):Logstash 和 Elasticsearch 提供近实时数据处理能力,这意味着从数据采集到数据可用于搜索和分析的时间延迟非常短。

总结

Logstash 作为数据管道,负责将数据从源头移动到 Elasticsearch,同时进行必要的数据转换和处理。Elasticsearch 则作为存储和搜索引擎,提供数据的索引、搜索和分析功能。这种协同工作模式使得 Logstash 和 Elasticsearch 成为处理和分析大规模数据集的理想组合。

logstash的输出源是elasticsearch的语法

要在Linux中使用Logstash并将输出源设置为Elasticsearch,你需要在Logstash的配置文件中设置output部分,指定Elasticsearch作为输出目的地。以下是配置Logstash输出到Elasticsearch的基本语法:

-

hosts:指定Elasticsearch服务器的地址和端口。这是一个数组,可以包含多个地址,以便于高可用配置。

hosts => ["http://localhost:9200"] -

index:定义事件写入Elasticsearch时使用的索引名称。可以使用动态字段来创建基于日期或其他字段的索引。

index => "logstash-%{+YYYY.MM.dd}"这里的

%{+YYYY.MM.dd}是一个时间戳格式,Logstash会自动将事件的时间戳格式化为年.月.日的形式,并用作索引的一部分。 -

user 和 password:如果Elasticsearch设置了访问控制,你需要提供访问Elasticsearch的用户名和密码。

user => "elastic" password => "password" -

document_type:定义Elasticsearch索引的type,如果不设置,默认为

_doc。document_type => "my_type" -

template 或 template_name:指定Elasticsearch索引模板的路径或名称,用于定义索引的设置和映射。

template => "/path/to/your/template.json" -

template_overwrite:设置为

true时,Logstash会覆盖Elasticsearch中现有的索引模板。template_overwrite => "false"

将以上配置放入Logstash的配置文件中,例如logstash.conf,然后使用以下命令启动Logstash:

bin/logstash -f logstash.conf

这样,Logstash就会将处理后的数据输出到Elasticsearch中。这是一个基本的配置,你可以根据实际需求调整配置参数。例如,如果你需要将日志数据输出到Elasticsearch,并且希望索引名称包含日志类型和日期,可以这样配置:

output {elasticsearch {hosts => ["http://localhost:9200"]index => "%{[fields][log_type]}-%{+YYYY.MM.dd}"user => "elastic"password => "password"document_type => "logs"template_overwrite => "false"}

}

这个配置会将日志数据输出到Elasticsearch,索引名称会根据log_type字段和当前日期动态生成。记得替换http://localhost:9200为你的Elasticsearch服务器的实际地址和端口,以及根据实际情况设置用户名和密码。

一些实例——Logstash获取数据到ElasticSearch中

收集系统日志到es中(index名字是message_YYYY.MM.dd)

logstash -e 'input{file{path => "/var/log/messages"}} output{elasticsearch{hosts => ["10.0.0.81:9200"] index => "message_%{+YYYY.MM.dd}"}}'

上面的写法是有缺陷的,它只能读取一行数据(详细一些的说,是只收集文件中的最新被添加的一行的数据),用下面的配置或许可以解决:

要使用Logstash收集系统日志文件(例如/var/log/messages)并将其传输到Elasticsearch中,你需要创建一个Logstash配置文件,该文件包含输入(input)、过滤(filter)和输出(output)部分。下面是一个基本的配置示例,它将从/var/log/messages文件中读取日志,并将它们传输到Elasticsearch中,索引名称为message_YYYY.MM.dd:

input {file {path => "/var/log/messages"start_position => "beginning"sincedb_path => "/dev/null"codec => multiline {pattern => "^\w\w\w \w\w\w \d{1,2} \d{2}:\d{2}:\d{2}"negate => truewhat => "previous"}}

}filter {grok {match => { "message" => "%{SYSLOGBASE}" }}date {match => [ "timestamp", "MMM d HH:mm:ss", "MMM dd HH:mm:ss" ]}

}output {elasticsearch {hosts => ["http://localhost:9200"]index => "message_%{+YYYY.MM.dd}"user => "elastic"password => "password"}

}

解释:

-

输入(Input):

file:指定要读取的文件路径。start_position:从文件的开始处读取。sincedb_path:用于记录文件读取位置的数据库文件路径,这里设置为/dev/null表示不记录。codec:使用multiline插件来处理多行日志,pattern定义了日志的开始模式。

-

过滤(Filter):

grok:解析日志行,将其转换为结构化数据。date:解析日志中的时间戳。

-

输出(Output):

elasticsearch:指定Elasticsearch的主机和端口。index:定义索引名称,使用动态日期。user和password:如果Elasticsearch设置了认证,需要提供用户名和密码。

这段代码是一个Logstash配置片段,用于处理日志文件。Logstash是一个开源的服务器端数据处理管道,可以同时从多个来源采集数据,转换数据,然后将数据发送到您指定的目的地。下面是对这段代码的解释:

-

input { file { ... } }:这部分定义了Logstash的输入源为文件。 -

path => "/var/log/messages":指定了要读取的日志文件的路径,这里是/var/log/messages。 -

start_position => "beginning":这个设置告诉Logstash从文件的开始处读取数据。 -

sincedb_path => "/dev/null":这个设置用于持久化记录文件读取的位置。/dev/null是一个特殊的设备文件,写入到它的任何内容都会被丢弃,因此这个设置实际上是告诉Logstash不要记录读取位置,每次启动都从文件的开始读取。 -

codec => multiline { ... }:这部分定义了如何解码文件中的数据。这里使用的是multiline编解码器,它允许Logstash跨多行读取数据,直到遇到匹配指定模式的行。 -

pattern => "^\w\w\w \w\w\w \d{1,2} \d{2}:\d{2}:\d{2}":这是正则表达式模式,用于匹配日志行的开始部分。它匹配三个字母(可能是日期的缩写),接着是三个字母(可能是月份的缩写),然后是一个或两位数字(日期),最后是时间(HH:mm:ss格式)。 -

negate => true:这个设置表示如果模式匹配成功,则不包括当前行,而是使用前一行。 -

what => "previous":这个设置与negate一起工作,表示当模式匹配成功时,使用匹配行之前的行。

总的来说,这段代码配置了Logstash从/var/log/messages文件的开始读取日志,使用multiline编解码器来处理跨多行的日志条目,并且使用正则表达式来确定日志条目的开始。如果正则表达式匹配成功,则使用匹配行之前的行作为日志条目的开始。

上面的做法会将整个日志文件的内容作为一条存储到Elasticsearch的索引中;

将日志文件格式改为json格式,传输到ElasticSearch中

*如何将系统日志的内容格式转换为JSON格式(使用rsyslog工具)

在CentOS 7中,要将系统日志(如存放在/var/log/messages)的存储格式改为JSON,可以通过配置rsyslog服务来实现。以下是具体的步骤和配置方法:

-

安装rsyslog服务:

如果系统中尚未安装rsyslog,可以通过以下命令安装:sudo yum install rsyslog -y -

配置rsyslog以解析和输出JSON格式的日志:

需要创建一个自定义的模板,将日志解析为JSON格式,并配置rsyslog以使用该模板。以下是一个示例配置,它定义了一个名为JsonFormat的模板,并将系统日志(/var/log/messages)以JSON格式输出到/var/log/messages_json.log文件中。创建一个新的配置文件

/etc/rsyslog.d/centos_json.conf,并添加以下内容:template(name="JsonFormat" type="list") {constant(value="{")constant(value="\"timestamp\":\"") property(name="timereported" dateFormat="rfc3339")constant(value="\",\"hostname\":\"") property(name="hostname")constant(value="\",\"syslogtag\":\"") property(name="syslogtag")constant(value="\",\"message\":\"") property(name="msg" format="json")constant(value="\"}\n") }# 过滤系统日志并使用自定义 JSON 格式 if $syslogfacility-text == 'auth' or $syslogfacility-text == 'authpriv' or $syslogfacility-text == 'cron' or $syslogfacility-text == 'daemon' or $syslogfacility-text == 'kern' then {action(type="omfile" file="/var/log/messages_json.log" template="JsonFormat") }这个配置文件定义了一个模板

JsonFormat,它将日志时间、主机名、syslog标签和消息内容格式化为JSON对象,并输出到/var/log/messages_json.log文件中。 -

重启rsyslog服务:

配置完成后,需要重启rsyslog服务以使配置生效:systemctl restart rsyslog.service -

验证配置:

检查/var/log/messages_json.log文件,确认系统日志是否已以JSON格式输出。

以上步骤展示了如何将CentOS 7中的系统日志转换为JSON格式。这种方法利用了rsyslog的强大功能,可以灵活地定义日志格式和输出目标。

rsyslog是一个高性能、安全性强、模块化设计的日志处理系统。以下是rsyslog服务的详细介绍:

-

简介:

- rsyslog,全称为“rocket-fast system for log”,是一个开源工具,广泛用于Linux系统,通过TCP/UDP协议转发或接收日志消息。它起初是一个常规的syslog服务,但已经发展成为一个多功能的日志处理工具,能够接受多种来源的输入,转换它们,并将结果输出到不同的目的地。

-

功能特点:

- rsyslog支持MariaDB/MySQL、PostgreSQL、ElasticSearch等多种数据库和日志目的地。

- 支持TCP/UDP协议传输,提供加密保护的消息中继。

- 支持精细的输出格式控制和高精确度的时间戳。

- 支持队列操作,能够在消息量巨大时保证性能。

- 支持基于任何消息部分的过滤。

-

配置文件:

- rsyslog的主要配置文件位于

/etc/rsyslog.conf,在此文件中可以定义输入模块、过滤器、动作和全局指令,以处理日志收集、过滤、路由和格式化。 - 配置文件分为几个部分,包括模块(Modules)、全局指令(Global Directives)、规则(Rules)和转发规则(Forwarding Rule)。

- rsyslog的主要配置文件位于

-

输入和输出:

- rsyslog支持多种输入源,包括文件、网络(UDP、TCP、RELp)、数据库、消息队列等。

- 支持多种输出目标,包括文件、数据库、远程服务器、消息队列等。

-

可靠性和安全性:

- 支持多种可靠的传输协议(如TCP、RELp),确保日志消息不丢失。

- 支持TLS加密传输,增强日志消息传输的安全性。

-

日志处理功能:

- 支持复杂的日志处理规则,包括条件过滤、消息修改、格式化、转发等。

-

社区支持和更新:

- rsyslog有一个活跃的社区,提供持续的更新和支持。

-

模块化:

- rsyslog是高度模块化的,可以通过加载不同的模块来扩展其功能。

-

文档和资源:

- rsyslog提供了广泛的在线文档,可以在官网找到详细的安装、配置和使用指南。

-

使用场景:

- rsyslog适用于企业级日志记录需求,也适用于小型系统。

- 它可以作为日志收集服务器,从网络中收集其他主机上的日志数据,也可以配置为客户端,过滤和发送内部日志消息到本地文件夹或远程rsyslog服务器上。

rsyslog是一个功能强大且灵活的日志服务工具,适用于需要高性能和高可靠性日志处理的各种环境。

*如何将Nginx的日志的内容格式转换为JSON的格式

如果想要改成json的格式,那么将access_log那一行改成:

access_log /var/log/nginx/access.log json;

将Nginx的日志内容转换为JSON格式通常涉及两个步骤:首先,你需要在Nginx中配置日志格式,以便输出易于解析的日志;其次,使用Logstash等工具将这些日志转换为JSON格式。以下是详细的步骤:

步骤1:配置Nginx日志格式

在Nginx中,你可以使用log_format指令自定义日志格式。你需要定义一个包含所有需要字段的格式,并将其保存为一个变量,然后在access_log指令中使用这个变量。

http {# 定义日志格式log_format json_format '{"remote_addr": "$remote_addr",''"remote_user": "$remote_user",''"time_local": "$time_local",''"request": "$request",''"status": "$status",''"body_bytes_sent": "$body_bytes_sent",''"http_referer": "$http_referer",''"http_user_agent": "$http_user_agent",''"http_x_forwarded_for": "$http_x_forwarded_for"}';server {# 应用自定义日志格式access_log /var/log/nginx/access.json json_format;}

}

这个配置定义了一个名为json_format的日志格式,它包含了一些常用的请求信息字段,并以JSON对象的形式输出。然后,在server块中,我们将access_log的格式设置为json_format,并指定日志文件的路径。

步骤2:使用Logstash解析日志

虽然Nginx可以直接输出JSON格式的日志,但这些日志并不是严格的JSON格式,因为它们是连续的JSON对象,没有被逗号分隔,也没有被大括号包围。因此,我们可以使用Logstash进一步处理这些日志。

首先,你需要安装Logstash,并创建一个配置文件,如下所示:

input {file {path => "/var/log/nginx/access.json"start_position => "beginning"sincedb_path => "/dev/null"codec => "json" # 使用json codec}

}filter {# 这里可以添加任何需要的过滤器

}output {elasticsearch {hosts => ["http://localhost:9200"]index => "nginx-logs-%{+YYYY.MM.dd}"}

}

在这个Logstash配置中,我们使用file输入插件来读取Nginx的日志文件,并指定codec为json,这样Logstash就可以将每行日志作为一个JSON对象来解析。然后,你可以将解析后的日志输出到Elasticsearch或其他目的地。

将不同web应用的Nginx访问日志改为json格式并识别出来传输到Elasticsearch的不同的索引中

注意事项

- 确保Nginx和Logstash的配置正确无误,并测试它们是否按预期工作。

- 根据你的具体需求,你可能需要调整Nginx的日志格式和Logstash的配置。

- 如果你的日志量很大,考虑使用Logstash的多行过滤器来正确地将连续的日志行组合成一个完整的JSON对象。

通过这两个步骤,你可以将Nginx的日志内容转换为JSON格式,并进一步处理和分析。

Logstash使用tcp、udp将日志补录到ElasticSearch中

input{tcp{port => "4439"type => "tcp"mode => "server"}

}output{elasticsearch{hosts => ["10.0.0.81:9200"]index => "trans_use_tcp_test_index"}

}

然后向tcp的4439端口传入数据即可

Logstash(使用syslog组件)配合Rsyslog收集HAProxy日志

## 在lb01(10.0.0.5)机器上安装(事先还要安装logstash当然还有java环境)

yum install -y rsyslog

yum isntall -y haproxy

配置rsyslog配置文件

# rsyslog configuration file# For more information see /usr/share/doc/rsyslog-*/rsyslog_conf.html

# If you experience problems, see http://www.rsyslog.com/doc/troubleshoot.html#### MODULES ##### The imjournal module bellow is now used as a message source instead of imuxsock.

$ModLoad imuxsock # provides support for local system logging (e.g. via logger command)

$ModLoad imjournal # provides access to the systemd journal

#$ModLoad imklog # reads kernel messages (the same are read from journald)

#$ModLoad immark # provides --MARK-- message capability# Provides UDP syslog reception

$ModLoad imudp

$UDPServerRun 514# Provides TCP syslog reception

$ModLoad imtcp

$InputTCPServerRun 514#### GLOBAL DIRECTIVES ##### Where to place auxiliary files

$WorkDirectory /var/lib/rsyslog# Use default timestamp format

$ActionFileDefaultTemplate RSYSLOG_TraditionalFileFormat# File syncing capability is disabled by default. This feature is usually not required,

# not useful and an extreme performance hit

#$ActionFileEnableSync on# Include all config files in /etc/rsyslog.d/

$IncludeConfig /etc/rsyslog.d/*.conf# Turn off message reception via local log socket;

# local messages are retrieved through imjournal now.

$OmitLocalLogging on# File to store the position in the journal

$IMJournalStateFile imjournal.state#### RULES ##### Log all kernel messages to the console.

# Logging much else clutters up the screen.

#kern.* /dev/console# Log anything (except mail) of level info or higher.

# Don't log private authentication messages!

*.info;mail.none;authpriv.none;cron.none /var/log/messages# The authpriv file has restricted access.

authpriv.* /var/log/secure# Log all the mail messages in one place.

mail.* -/var/log/maillog# Log cron stuff

cron.* /var/log/cron# Everybody gets emergency messages

*.emerg :omusrmsg:*# Save news errors of level crit and higher in a special file.

uucp,news.crit /var/log/spooler# Save boot messages also to boot.log

local6.* /var/log/boot.log# ### begin forwarding rule ###

# The statement between the begin ... end define a SINGLE forwarding

# rule. They belong together, do NOT split them. If you create multiple

# forwarding rules, duplicate the whole block!

# Remote Logging (we use TCP for reliable delivery)

#

# An on-disk queue is created for this action. If the remote host is

# down, messages are spooled to disk and sent when it is up again.

#$ActionQueueFileName fwdRule1 # unique name prefix for spool files

#$ActionQueueMaxDiskSpace 1g # 1gb space limit (use as much as possible)

#$ActionQueueSaveOnShutdown on # save messages to disk on shutdown

#$ActionQueueType LinkedList # run asynchronously

#$ActionResumeRetryCount -1 # infinite retries if host is down

# remote host is: name/ip:port, e.g. 192.168.0.1:514, port optional

#*.* @@remote-host:514

# ### end of the forwarding rule ###

local6.* @@10.0.0.5:2222

解释:

这段内容是rsyslog的配置文件的一部分,rsyslog是一个开源的日志系统,用于Linux系统上日志消息的接收、处理和转发。下面是对这段配置文件的解释:

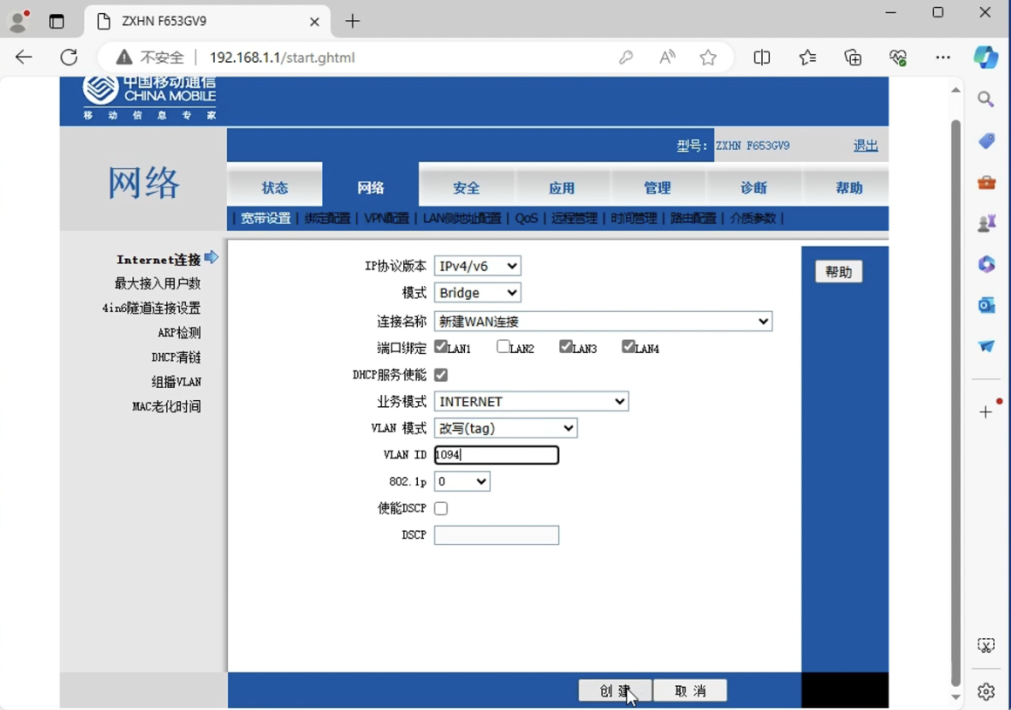

-

模块(MODULES):

$ModLoad imuxsock:加载imuxsock模块,提供对本地系统日志的支持(例如通过logger命令)。$ModLoad imjournal:加载imjournal模块,提供对systemd日志的访问。#$ModLoad imklog:注释掉的行,如果启用,会读取内核消息(这些消息也可以从journald读取)。#$ModLoad immark:注释掉的行,提供--MARK--消息能力。$ModLoad imudp和$UDPServerRun 514:加载imudp模块并运行UDP服务器,监听514端口,用于接收UDP syslog消息。$ModLoad imtcp和$InputTCPServerRun 514:加载imtcp模块并运行TCP服务器,监听514端口,用于接收TCP syslog消息。

-

全局指令(GLOBAL DIRECTIVES):

$WorkDirectory /var/lib/rsyslog:设置辅助文件存放的位置。$ActionFileDefaultTemplate RSYSLOG_TraditionalFileFormat:使用默认的时间戳格式。#$ActionFileEnableSync on:注释掉的行,禁用文件同步能力,这个特性通常不需要,没有用处,并且会严重影响性能。$IncludeConfig /etc/rsyslog.d/*.conf:包含/etc/rsyslog.d/目录下的所有配置文件。$OmitLocalLogging on:关闭通过本地日志套接字接收消息;现在通过imjournal获取本地消息。$IMJournalStateFile imjournal.state:设置存储日志位置的文件。

-

规则(RULES):

#kern.* /dev/console:注释掉的行,如果启用,会将所有内核消息记录到控制台。*.info;mail.none;authpriv.none;cron.none /var/log/messages:记录除了邮件之外的所有信息级别或更高级别的消息,不记录私密认证消息。authpriv.* /var/log/secure:记录所有authpriv级别的消息,这些消息有受限的访问权限。mail.* -/var/log/maillog:记录所有邮件消息。cron.* /var/log/cron:记录所有cron任务的消息。*.emerg :omusrmsg:*:所有用户都会收到紧急消息。uucp,news.crit /var/log/spooler:记录新闻错误,级别为临界及以上。local6.* /var/log/boot.log:记录本地6的消息,也保存到boot.log。

-

日志转发规则(LOGGING FORWARDING RULE):

- 这部分定义了一个日志转发规则,使用TCP进行可靠的日志消息传输。

#$ActionQueueFileName fwdRule1:设置磁盘队列的唯一名称前缀。#$ActionQueueMaxDiskSpace 1g:设置磁盘空间限制为1GB。#$ActionQueueSaveOnShutdown on:在关闭时保存消息到磁盘。#$ActionQueueType LinkedList:异步运行。#$ActionResumeRetryCount -1:如果远程主机宕机,无限次重试。local6.* @@10.0.0.5:2222:将local6的日志消息转发到IP地址为10.0.0.5,端口为2222的远程主机。

这个配置文件控制着rsyslog的行为,包括日志消息的来源、处理和存储位置,以及如何将日志消息转发到远程服务器。

配置haproxy配置文件并验证(需要另外两台web01、web02配合)

vim /etc/haproxy/haproxy.cfg

范例:

global

maxconn 100000

chroot /var/lib/haproxy

uid 99

gid 99

daemon

nbproc 1

pidfile /var/run/haproxy.pid

log 127.0.0.1 local7 infodefaults

option http-keep-alive

option forwardfor

maxconn 100000

mode http

timeout connect 300000ms

timeout client 300000ms

timeout server 300000mslisten statsmode httpbind 0.0.0.0:9999stats enablelog globalstats uri /haproxy-statusstats auth haadmin:123456#frontend web_port

frontend web_portbind 0.0.0.0:80mode httpoption httploglog globaloption forwardfor

###################ACL Setting##########################

###不能写IP acl pc hdr_dom(host) -i 10.0.0.5:80

####要写域名才行acl pc hdr_dom(host) -i test.haproxyweb1.com

# acl mobile hdr_dom(host) -i m.elk.com

###################USE ACL##############################use_backend pc_host if pc

# use_backend mobile_host if mobile

########################################################backend pc_hostmode httpoption httplogbalance static-rrserver web1 10.0.0.7:80 check inter 2000 rise 3 fall 2 weight 1server web2 10.0.0.8:80 check inter 2000 rise 3 fall 2 weight 1#backend mobile_host

# mode http

# option httplog

# balance static-rr

# server web1 10.0.0.8:80 check inter 2000 rise 3 fall 2 weight 1

# server web2 10.0.0.7:80 check inter 2000 rise 3 fall 2 weight 1

解释:

这段配置是用于HAProxy(一个高性能的TCP/HTTP负载均衡器)的配置文件。下面是对这些配置项的解释:

Global 部分:

global:这是全局配置部分,影响整个HAProxy实例。maxconn 100000:设置全局最大连接数为100000。chroot /var/lib/haproxy:改变HAProxy的运行目录到/var/lib/haproxy,增加安全性。uid 99和gid 99:设置HAProxy运行的用户ID和组ID。daemon:让HAProxy在后台运行。nbproc 1:指定HAProxy进程的数量,这里设置为1。pidfile /var/run/haproxy.pid:指定进程ID文件的位置。log 127.0.0.1 local7 info:设置日志服务器的IP地址和日志级别。

Defaults 部分:

defaults:这是默认配置部分,为所有前端和后端提供默认设置。option http-keep-alive:保持HTTP连接活跃。option forwardfor:添加HTTP头X-Forwarded-For,用于记录原始客户端IP。maxconn 100000:设置默认的最大连接数。mode http:设置默认的工作模式为HTTP。timeout connect 300000ms、timeout client 300000ms、timeout server 300000ms:设置连接超时、客户端超时和服务器超时的时间。

Listen stats 部分:

listen stats:定义一个名为stats的监听器,用于提供HAProxy的统计信息。mode http:设置监听器的工作模式为HTTP。bind 0.0.0.0:9999:绑定到所有IP的9999端口。stats enable:启用统计页面。log global:使用全局日志设置。stats uri /haproxy-status:设置访问统计页面的URI。stats auth haadmin:123456:设置访问统计页面的用户名和密码。

Frontend web_port 部分:

frontend web_port:定义一个名为web_port的前端,用于接收客户端请求。bind 0.0.0.0:80:绑定到所有IP的80端口。mode http:设置前端的工作模式为HTTP。option httplog:启用HTTP日志记录。log global:使用全局日志设置。option forwardfor:添加HTTP头X-Forwarded-For。

ACL Setting 部分:

acl pc hdr_dom(host) -i test.haproxyweb1.com:定义一个访问控制列表(ACL),如果请求的主机头是test.haproxyweb1.com,则匹配此ACL。use_backend pc_host if pc:如果请求匹配ACLpc,则将请求转发到名为pc_host的后端。

Backend pc_host 部分:

backend pc_host:定义一个名为pc_host的后端,用于处理匹配到的请求。mode http:设置后端的工作模式为HTTP。option httplog:启用HTTP日志记录。balance static-rr:设置负载均衡算法为静态轮询。server web1 10.0.0.7:80 check inter 2000 rise 3 fall 2 weight 1和server web2 10.0.0.8:80 check inter 2000 rise 3 fall 2 weight 1:定义两个服务器,分别位于10.0.0.7:80和10.0.0.8:80,设置健康检查间隔、上升和下降阈值以及权重。

注释掉的部分(以#开头)是被禁用的配置项,可以根据需要取消注释来启用。

#---------------------------------------------------------------------

# Example configuration for a possible web application. See the

# full configuration options online.

#

# http://haproxy.1wt.eu/download/1.4/doc/configuration.txt

#

#---------------------------------------------------------------------#---------------------------------------------------------------------

# Global settings

#---------------------------------------------------------------------

global# to have these messages end up in /var/log/haproxy.log you will# need to:## 1) configure syslog to accept network log events. This is done# by adding the '-r' option to the SYSLOGD_OPTIONS in# /etc/sysconfig/syslog## 2) configure local2 events to go to the /var/log/haproxy.log# file. A line like the following can be added to# /etc/sysconfig/syslog## local2.* /var/log/haproxy.log#log 127.0.0.1 local2chroot /var/lib/haproxypidfile /var/run/haproxy.pidmaxconn 4000user haproxygroup haproxydaemon# turn on stats unix socketstats socket /var/lib/haproxy/stats#---------------------------------------------------------------------

# common defaults that all the 'listen' and 'backend' sections will

# use if not designated in their block

#---------------------------------------------------------------------

defaultsmode httplog globaloption httplogoption dontlognulloption http-server-closeoption forwardfor except 127.0.0.0/8option redispatchretries 3timeout http-request 10stimeout queue 1mtimeout connect 10stimeout client 1mtimeout server 1mtimeout http-keep-alive 10stimeout check 10smaxconn 3000#---------------------------------------------------------------------

# main frontend which proxys to the backends

#---------------------------------------------------------------------

frontend main *:5000acl url_static path_beg -i /static /images /javascript /stylesheetsacl url_static path_end -i .jpg .gif .png .css .jsuse_backend static if url_staticdefault_backend app#---------------------------------------------------------------------

# static backend for serving up images, stylesheets and such

#---------------------------------------------------------------------

backend staticbalance roundrobinserver static 127.0.0.1:4331 check#---------------------------------------------------------------------

# round robin balancing between the various backends

#---------------------------------------------------------------------

backend appbalance roundrobinserver app1 127.0.0.1:5001 checkserver app2 127.0.0.1:5002 checkserver app3 127.0.0.1:5003 checkserver app4 127.0.0.1:5004 check解释:

这段配置文件是用于配置HAProxy(一个高性能的TCP/HTTP负载均衡器)的示例,用于一个可能的Web应用程序。下面是对这段配置文件中的关键部分的解释:

-

全局设置(global):

log 127.0.0.1 local2:配置HAProxy将日志发送到本地的local2日志设施,这意味着日志将被发送到/var/log/haproxy.log文件。chroot /var/lib/haproxy:设置HAProxy的chroot环境,这是为了安全起见,限制HAProxy的文件系统访问。pidfile /var/run/haproxy.pid:设置HAProxy进程ID文件的位置。maxconn 4000:设置HAProxy可以同时处理的最大连接数。user haproxy和group haproxy:设置运行HAProxy的用户和组。daemon:以守护进程模式运行HAProxy。stats socket /var/lib/haproxy/stats:启用一个Unix套接字,用于统计信息。

-

默认设置(defaults):

mode http:设置默认模式为HTTP。log global:使用全局日志设置。option httplog、option dontlognull、option http-server-close等:设置一些HTTP相关的选项。option forwardfor except 127.0.0.0/8:启用X-Forwarded-For头部,除了来自本地网络的请求。retries 3:设置重试次数。timeout系列设置:设置各种超时参数。maxconn 3000:设置默认的最大连接数。

-

前端设置(frontend):

frontend main *:5000:定义一个名为main的前端,监听所有接口上的5000端口。acl url_static:定义访问控制列表(ACL),用于匹配静态资源的URL。use_backend static if url_static:如果请求匹配静态资源的URL,则使用static后端。default_backend app:默认使用app后端。

-

静态资源后端(backend static):

balance roundrobin:使用轮询算法进行负载均衡。server static 127.0.0.1:4331 check:定义一个名为static的服务器,监听在127.0.0.1的4331端口,并启用健康检查。

-

应用后端(backend app):

balance roundrobin:同样使用轮询算法。server指令定义了四个服务器,它们将被用于负载均衡。

这个配置文件展示了如何设置HAProxy来处理HTTP请求,包括如何区分静态资源和动态应用请求,并将它们分别路由到不同的后端服务器。

HAProxy的日志在哪(为何不能用file模块直接拿日志文件而是借助syslog?)

在CentOS 7中,HAProxy的日志默认情况下是输出到系统的syslog中,但为了更好的管理和监控,通常会将HAProxy的日志单独定义并保存到指定的文件中。以下是HAProxy日志保存位置的详细说明:

-

HAProxy配置文件中的日志定义:

HAProxy的配置文件通常位于/etc/haproxy/haproxy.cfg。在这个配置文件中,可以通过global部分的log指令来定义日志的输出。例如:globallog 127.0.0.1 local2 info这里

log指令指定了日志的目的地(127.0.0.1,即本地系统),使用的facility(local2),以及日志级别(info)。 -

Rsyslog配置:

为了将HAProxy的日志保存到文件,需要配置rsyslog。在/etc/rsyslog.conf文件中,可以添加以下行来定义日志文件的位置:local2.* /var/log/haproxy/haproxy.log这行配置表示所有

local2级别的日志将被保存到/var/log/haproxy/haproxy.log文件中。 -

创建日志目录和文件:

需要创建用于保存HAProxy日志的目录,并授权rsyslog服务写入日志文件:mkdir /var/log/haproxy && chmod a+w /var/log/haproxy这样,rsyslog服务就可以将HAProxy的日志写入到

/var/log/haproxy/haproxy.log文件中。 -

重启服务:

配置完成后,需要重启rsyslog和HAProxy服务以使配置生效:systemctl restart rsyslog systemctl restart haproxy这样,HAProxy的日志就会开始保存到指定的文件中。

综上所述,HAProxy在CentOS 7中的日志默认是输出到syslog,但可以通过配置rsyslog将日志保存到/var/log/haproxy/haproxy.log文件中。这样的配置有助于更好地管理和监控HAProxy的活动。

基于上述配置,要确保只有HAProxy的日志设施是local2,而其他服务的日志设施不是local2,你需要在系统日志配置文件中专门针对HAProxy进行配置。以下是一些步骤和建议:

-

配置HAProxy日志输出到

local2:

在HAProxy的配置文件(通常是/etc/haproxy/haproxy.cfg)中,设置日志输出到local2设施:globallog 127.0.0.1 local2 -

配置rsyslog接收HAProxy日志:

编辑rsyslog的配置文件(通常是/etc/rsyslog.conf或/etc/rsyslog.d/haproxy.conf),添加以下行来指定local2设施的日志应该被记录到特定的文件:local2.* /var/log/haproxy.log这样,所有发送到

local2设施的日志都会被rsyslog接收并保存到/var/log/haproxy.log文件中。 -

确保其他服务不使用

local2设施:

检查其他服务的配置文件,确保它们没有被配置为输出到local2设施。如果发现有服务使用了local2,将其更改为其他设施,例如local0到local7中的其他值。 -

重启rsyslog和HAProxy服务:

配置完成后,重启rsyslog和HAProxy服务以应用新的配置:systemctl restart rsyslog systemctl restart haproxy -

检查配置:

使用netstat命令检查rsyslog是否正在监听UDP端口514(这是 syslog 的标准端口):netstat -tulnp | grep rsyslog确保

rsyslogd正在监听UDP端口514。 -

SELinux设置(如果适用):

如果你的系统使用SELinux,你可能需要设置适当的策略来允许HAProxy连接到rsyslog。

通过以上步骤,你可以确保只有HAProxy的日志被发送到local2设施,并且被rsyslog正确记录,而其他服务的日志则不会被发送到local2设施。

Rsyslog和HAProxy是如何连接的、如何发送到Logstash中的

-

Rsyslog通过设置和HAProxy相同的日志设施(假设都为local2),那么Rsyslog将会收集local2上的所有日志信息(要确保local2是只有HAProxy才有的)

-

Rsyslog通过规定开启一个转发日志的端口(假设为2222),而Logstash的syslog负责监听收发这个2222端口的日志信息

使用Logstash的syslog组件接收Rsyslog传来的HAProxy日志到ElasticSearch中

input{syslog{type => "rsyslog_ha_log"port => "2222"}

}output{elasticsearch{hosts => ["10.0.0.81:9200"]index => "xxxx"}

}

这个port是rsyslog规定的端口,由logstash来启动这个2222的端口

*五、Rsyslog和HAProxy的具体安装配置

什么是Rsyslog、有什么用

Rsyslog是什么?

Rsyslog是一个开源的日志处理程序,它用于Linux和类Unix系统中进行日志管理。Rsyslog是syslog的增强版,提供了高性能、安全功能和模块化设计。它能够接收来自各种来源的输入,转换它们,并将结果输出到不同的目的地。Rsyslog以其高性能和模块化设计而闻名,适用于企业级日志记录需求。

Rsyslog具体有什么用?

- 日志收集:Rsyslog能够从系统内核、应用程序、服务等不同源收集系统日志。

- 过滤和处理日志:允许定义过滤规则,只记录特定类型的日志事件或将日志事件路由到不同的目标。

- 存储和传输日志:可以将日志事件存储在本地文件中,也可以将其传输到远程日志服务器或集中式日志管理系统。

- 配置灵活:提供了丰富的配置选项,可以根据需要自定义日志处理和存储方式。

- 日志转发:支持将日志消息转发到远程日志服务器,实现集中式日志管理和监控。

- 日志过滤和处理:具有强大的过滤和处理功能,可以根据日志内容、来源、级别等条件对日志进行过滤、分发和转换。

Rsyslog底层原理是什么?

Rsyslog的架构采用模块化设计,允许管理员根据需要加载不同的模块来扩展其功能。其消息流是从输入模块->预处理模块->主队列->消息处理引擎->执行队列->输出模块。Rsyslog引入了facility(设施)的概念,也就是Rsyslog服务进程所要接收日志的各代理,这些代理负责收集对应的日志信息,报给Rsyslog。Rsyslog还支持多种日志源,包括系统内核、用户级程序、系统服务(守护进程)、网络设备、应用程序等。它还提供了安全认证和加密传输等机制,确保日志数据的保密性和完整性。

详细的例子

以下是一个Rsyslog配置的例子,展示了如何配置Rsyslog从不同来源收集日志消息,并将它们存储到本地文件或转发到远程服务器:

-

安装Rsyslog:

sudo yum install rsyslog -y -

配置文件:

编辑/etc/rsyslog.conf文件,添加以下配置:$ModLoad imuxsock # provides support for local system logging (e.g. via logger command) $ModLoad imjournal # provides access to the systemd journal $ModLoad immark # provides --MARK-- message capability $ModLoad imudp $UDPServerRun 514 $ModLoad imtcp $InputTCPServerRun 514 $WorkDirectory /var/lib/rsyslog $AllowedSender tcp, 192.168.30.0/24 $ActionFileDefaultTemplate RSYSLOG_TraditionalFileFormat $template Remote,"/data/log/%fromhost-ip%/%fromhost-ip%_%$YEAR%-%$MONTH%-%$DAY%.log" :fromhost-ip, !isequal, "127.0.0.1" ?Remote $IncludeConfig /etc/rsyslog.d/*.conf $OmitLocalLogging on $IMJournalStateFile imjournal.state *.info;mail.none;authpriv.none;cron.none /data/log/messages authpriv.* /var/log/secure mail.* -/var/log/maillog cron.* /var/log/cron *.emerg :omusrmsg:* uucp,news.crit /var/log/spooler local7.* /var/log/boot.log这个配置文件中包含了多个部分:

$ModLoad指令用于加载模块。$UDPServerRun和$InputTCPServerRun指令用于开启UDP和TCP监听。$template指令定义了日志文件的存储路径。:fromhost-ip, !isequal, "127.0.0.1" ?Remote是一个过滤规则,排除本地主机的日志。- 最后一部分是日志的路由规则,定义了不同日志级别的存储位置。

-

重启Rsyslog服务:

sudo systemctl restart rsyslog

这个例子展示了Rsyslog的基本配置,包括模块加载、网络监听、日志模板定义和日志路由规则设置。通过这些配置,Rsyslog可以有效地收集、处理和存储系统日志。

CentOS7上安装配置Rsyslg

在CentOS 7上安装和配置Rsyslog的详细流程如下:

1. 安装Rsyslog

CentOS 7默认安装了Rsyslog服务,如果没有安装,可以使用以下命令进行安装:

sudo yum update

sudo yum install rsyslog -y

2. 配置Rsyslog

Rsyslog的配置文件位于/etc/rsyslog.conf,以及/etc/rsyslog.d/目录下的文件。您可以编辑这些文件来调整Rsyslog的配置。

2.1 编辑/etc/rsyslog.conf文件

打开/etc/rsyslog.conf文件进行编辑:

sudo nano /etc/rsyslog.conf

2.2 配置Rsyslog服务端

如果您想要配置Rsyslog作为服务端接收远程日志,需要在配置文件中开启UDP和TCP接收:

$ModLoad imudp # 提供UDP syslog接收

$UDPServerRun 514$ModLoad imtcp # 提供TCP syslog接收

$InputTCPServerRun 514

您还可以定义日志模板和日志存放路径:

$template RemoteLogs,"/var/log/remote/%$YEAR%-%$MONTH%-%$DAY%/%fromhost-ip%.log" # 定义日志存放路径及文件名格式

*.* ?RemoteLogs # 所有服务所有级别的日志都记录

:fromhost-ip, !isequal, "127.0.0.1" ?Remote # 排除本地主机IP日志记录,只记录远程主机日志

& ~ # 忽略之前所有的日志,远程主机日志记录完之后不再继续往下记录

2.3 配置Rsyslog客户端

在客户端的/etc/rsyslog.conf文件中,您可以配置将日志发送到服务端:

*.* @服务端IP地址:514 # 将所有日志发送到服务端

3. 启动和启用Rsyslog服务

安装完毕后,您需要启动rsyslog服务,并设置为开机自启:

sudo systemctl start rsyslog

sudo systemctl enable rsyslog

使用以下命令检查rsyslog服务状态,确保它正在运行:

sudo systemctl status rsyslog

4. 配置防火墙

如果您的服务器使用firewalld防火墙,需要允许UDP和TCP的514端口:

sudo firewall-cmd --permanent --add-port=514/tcp

sudo firewall-cmd --permanent --add-port=514/udp

sudo firewall-cmd --reload

5. 验证配置

在服务端,您可以使用tail命令来实时查看日志文件,以验证配置是否生效:

cd /var/log/remote/

tail -f 客户端IP地址_日期.log

以上步骤提供了在CentOS 7上安装和配置Rsyslog的详细流程,包括服务端和客户端的配置示例。希望这些信息能帮助您成功安装和配置Rsyslog。

Rsyslog与Logstash的对比

Rsyslog和Logstash都是日志处理工具,但它们在多个方面有所不同。以下是它们的主要对比点:

-

灵活性和插件生态:

- Logstash:以其灵活性而闻名,拥有大量的插件,详细的文档以及直白的配置格式,使其可以在多种场景下应用。

- Rsyslog:虽然功能强大,但配置工作需要更大的代价,文档难以搜索和阅读,特别是对于那些对术语比较陌生的开发者。

-

性能和资源消耗:

- Logstash:性能以及资源消耗(默认的堆大小是1GB)是一个致命问题,尤其是在大数据量的情况下。

- Rsyslog:经测试是最快的传输工具,非常擅长处理解析多个规则,且随着规则数目的增加,它的处理速度始终是线性增长的。

-

配置灵活性:

- Logstash:配置相对简单,但功能强大,支持复杂的日志处理需求。

- Rsyslog:支持复杂的配置文件格式,允许进行精细的日志过滤、格式化和路由。

-

支持的输入和输出:

- Logstash:支持多种输入源(如文件、syslog、redis等)和输出目标(如Elasticsearch、File、Graphite等)。

- Rsyslog:支持多种输入来源(包括文件、网络、数据库等)和输出目标(包括文件、数据库、远程服务器等)。

-

可靠性:

- Logstash:作为一个数据处理管道,Logstash在处理过程中可能会引入数据丢失的风险,尤其是在高负载情况下。

- Rsyslog:支持多种可靠的传输协议(如TCP、RELp),提供可靠的日志传输机制,确保日志消息不丢失。

-

日志处理功能:

- Logstash:提供强大的插件来解析事件并将其转换为所需的结构,如Grok、Mutate、Drop等。

- Rsyslog:支持复杂的日志处理规则,包括条件过滤、消息修改、格式化、转发等。

-

安全性:

- Logstash:支持HTTP协议,但可能需要额外的安全措施来保护日志数据。

- Rsyslog:支持TLS加密传输,增强了日志消息传输的安全性。

-

社区支持和更新:

- Logstash:作为ELK栈的一部分,拥有活跃的社区支持和频繁的更新。

- Rsyslog:社区支持和开发更新较少,但仍然是Linux系统中最常用的日志处理工具之一。

-

典型应用场景:

- Logstash:适用于原型验证阶段使用,或者解析非常复杂的时候,也适合集中式处理和收集来自不同服务器的数据。

- Rsyslog:适合非常轻的应用(如应用、小VM、Docker容器),以及对性能有严格要求的场景,尤其是在有多个解析规则时。

总结来说,Logstash以其灵活性和强大的插件生态而受到欢迎,而Rsyslog则以其高性能和轻量级而著称。选择哪种工具取决于具体的使用场景和需求。

Haproxy是什么?有什么用?

HAProxy是什么?

HAProxy(High Availability Proxy)是一个开源的、高性能的、可扩展的TCP/HTTP负载均衡器。它由Willemijin Houtmans在2000年创建,并在2001年首次发布。HAProxy以其可靠性、性能和先进的功能而闻名,被广泛用于提高应用程序的可用性和性能。

HAProxy有什么用?

-

负载均衡:

- TCP负载均衡:HAProxy可以在后端服务之间分配TCP连接,例如数据库、邮件服务器等。

- HTTP负载均衡:HAProxy可以在多个Web服务器之间分配HTTP请求,提高Web应用程序的性能和可用性。

-

高可用性:

- HAProxy支持健康检查,可以自动检测并移除不健康的后端服务器,确保流量只发送到健康的服务器。

-

SSL/TLS终止:

- HAProxy可以在负载均衡器上终止SSL/TLS连接,减轻后端服务器的加密/解密负担。

-

连接管理:

- HAProxy可以管理大量并发连接,优化资源使用。

-

会话保持:

- HAProxy支持会话保持,确保来自同一客户端的请求被路由到同一后端服务器。

-

健康检查:

- HAProxy可以定期对后端服务进行健康检查,自动将不健康的服务从负载均衡池中移除。

-

动态重新配置:

- HAProxy支持动态重新配置,无需重启服务即可更新配置。

-

监控和统计:

- HAProxy提供了实时监控和统计信息,帮助管理员了解系统性能和流量模式。

-

安全性:

- HAProxy提供了一些安全功能,如防止DDoS攻击、应用层防火墙规则等。

-

多协议支持:

- HAProxy支持多种协议,包括HTTP/1.1、HTTP/2、WebSocket等。

HAProxy的工作原理

HAProxy的工作原理基于一个事件驱动的架构,它使用非阻塞I/O和多路复用技术(如epoll、kqueue)来处理连接。这种架构使得HAProxy能够高效地处理大量并发连接。

-

监听:

- HAProxy监听一个或多个前端(frontend)接口,等待客户端的连接请求。

-

处理:

- 当接收到客户端请求时,HAProxy根据配置的规则(如轮询、最少连接、源IP哈希等)将请求路由到一个后端(backend)服务器。

-

转发:

- HAProxy将客户端请求转发到选定的后端服务器,并等待服务器的响应。

-

响应:

- HAProxy将后端服务器的响应返回给客户端。

-

健康检查:

- HAProxy定期对后端服务器进行健康检查,以确保它们能够正常处理请求。

-

统计和监控:

- HAProxy提供了实时的统计和监控接口,允许管理员监控系统性能和流量。

HAProxy是一个功能强大的负载均衡器,适用于需要高性能和高可用性的应用程序。通过合理配置,HAProxy可以显著提高应用程序的可靠性和扩展性。

Haproxy的安装与配置

在CentOS 7上安装和配置HAProxy的详细流程如下:

1. 安装HAProxy

方法一:编译安装

-

安装依赖包:

sudo yum -y install make gcc pcre-devel bzip2-devel openssl-devel -

下载HAProxy源码:

wget http://www.haproxy.org/download/1.7/src/haproxy-1.7.2.tar.gz -

解压源码:

tar -xzf haproxy-1.7.2.tar.gz -

编译安装HAProxy:

cd haproxy-1.7.2 make TARGET=linux2628 USE_OPENSSL=1 USE_PCRE=1 USE_SYSTEMD=1 sudo make install PREFIX=/home/ha/haproxyTARGET参数根据当前操作系统内核版本指定,例如linux2628适用于Linux 2.6.28及以上版本。

方法二:使用IUS仓库安装

-

安装IUS仓库:

wget https://repo.ius.io/ius-release-el7.rpm sudo rpm -Uvh ius-release-el7.rpm -

安装HAProxy:

sudo yum install haproxy22

2. 配置HAProxy

-

创建配置文件目录:

sudo mkdir -p /etc/haproxy -

创建HAProxy配置文件:

sudo touch /etc/haproxy/haproxy.cfg -

配置HAProxy:

编辑/etc/haproxy/haproxy.cfg文件,配置内容如下:globallog 127.0.0.1 local2chroot /var/lib/haproxypidfile /var/run/haproxy.pidmaxconn 4000user haproxygroup haproxydaemondefaultsmode httplog globaloption httplogoption dontlognullretries 3timeout connect 5stimeout client 1mtimeout server 1mfrontend http-inbind *:80default_backend webserversbackend webserversmode httpbalance roundrobinserver web1 192.168.1.100:80 checkserver web2 192.168.1.101:80 check这里定义了全局设置、默认设置、前端和后端的配置。

3. 启动HAProxy

-

启动HAProxy服务:

sudo systemctl start haproxy -

设置HAProxy开机自启:

sudo systemctl enable haproxy

4. 验证HAProxy配置

-

检查HAProxy状态:

sudo systemctl status haproxy -

查看监听端口:

sudo ss -tlnp | grep haproxy

以上步骤提供了在CentOS 7上安装和配置HAProxy的详细流程,包括编译安装和使用IUS仓库安装两种方法,以及配置文件的详细示例。希望这些信息能帮助您成功安装和配置HAProxy。

HAProxy和Nginx的对比

HAProxy和Nginx都是流行的开源负载均衡和反向代理软件,但它们在设计、功能和性能上有一些关键的区别。以下是HAProxy和Nginx的详细对比:

1. 功能和用途

-

HAProxy:

- HAProxy专注于高性能的负载均衡,特别擅长处理TCP和HTTP流量。

- 支持第4层(TCP)和第7层(HTTP/HTTPS)的流量调度,适用于需要复杂负载均衡策略的场景。

- 提供了高级的健康检查机制,可以基于各种条件进行后端服务器的状态检测。

-

Nginx:

- Nginx最初设计为HTTP服务器和反向代理,但功能已经扩展到邮件代理、负载均衡器和API网关。

- 以其轻量级和高效的事件驱动架构而闻名,特别适合处理静态内容和高并发HTTP请求。

- 模块化设计,提供了丰富的模块,可以根据需求进行扩展,如HTTP/2、WebSocket支持等。

2. 性能和效率

-

HAProxy:

- 在处理TCP流量时表现出色,尤其是在高并发场景下。连接管理能力非常强大,能够有效减少延迟。

- 由于其队列设计和特性,HAProxy可以终止TLS并规范化HTTP和TCP流量。

-

Nginx:

- 在处理静态文件和缓存时性能出众,其事件驱动架构使其能够高效处理大规模的HTTP请求。

- 每个请求只能由单个worker处理,这可能导致CPU和网络资源的非最优使用。

3. 配置和管理

-

HAProxy:

- 配置文件功能强大但相对复杂,适合有一定经验的管理员使用。

- 提供了详细的统计和监控功能,适合需要高级流量控制和监控的场景。

-

Nginx:

- 配置文件语法简洁,易于上手。Nginx的模块化设计使得管理和扩展更加便捷。

- 易于配置,适合快速部署和简单管理。

4. 健康检查

-

HAProxy:

- 提供了高级的健康检查机制,可以基于各种条件进行后端服务器的状态检测。

-

Nginx:

- 健康检查功能较为基础,但通过第三方模块可以扩展其功能。

5. SSL/TLS支持

-

HAProxy:

- 支持SSL终止和SSL隧道,能够灵活处理加密流量。

-

Nginx:

- 在SSL处理上,Nginx表现优异,特别是结合缓存功能,可以显著提升HTTPS性能。

6. 使用场景

-

HAProxy:

- 适用于需要复杂负载均衡和高可用性的场景,尤其是在处理大量TCP连接时。

- 适合高性能TCP负载均衡,如数据库集群的流量分发。

-

Nginx:

- 适用于需要多功能服务器的场景,如同时处理静态文件、代理流量、终止SSL、负载均衡等。

- 适合高并发HTTP服务,如内容分发网络(CDN)、视频流媒体等。

总结来说,HAProxy和Nginx各有优势,选择哪个取决于具体的应用场景、性能需求和个人偏好。HAProxy更适合需要复杂负载均衡和高可用性的场景,而Nginx则以其多功能性和高效处理HTTP请求的能力而著称,适用于需要多种服务集成的场景。

*六、Nginx如何配置两个Web应用,并使它们拥有独立的日志文件

在CentOS 7上使用Nginx配置两个Web应用,并使它们拥有独立的日志文件,你需要按照以下步骤操作:

-

安装Nginx:

如果Nginx尚未安装,你可以通过以下命令来安装:sudo yum install epel-release sudo yum install nginx -

配置Nginx:

你需要为每个Web应用创建一个单独的配置文件。通常,Nginx的配置文件位于/etc/nginx/conf.d/目录下,或者你可以在/etc/nginx/sites-available/目录下创建配置文件,并在/etc/nginx/sites-enabled/目录下创建符号链接。假设你的两个Web应用分别是

app1和app2,你可以创建两个配置文件app1.conf和app2.conf。app1.conf:

server {listen 80;server_name app1.example.com;location / {root /var/www/app1;index index.html index.htm;}error_log /var/log/nginx/app1_error.log;access_log /var/log/nginx/app1_access.log; }app2.conf:

server {listen 80;server_name app2.example.com;location / {root /var/www/app2;index index.html index.htm;}error_log /var/log/nginx/app2_error.log;access_log /var/log/nginx/app2_access.log; }确保将

app1.example.com和app2.example.com替换为你的实际域名,/var/www/app1和/var/www/app2替换为实际的Web应用根目录。 -

创建日志目录:

如果日志目录不存在,你需要创建它们,并确保Nginx有权限写入日志文件:sudo mkdir -p /var/log/nginx/app1 sudo mkdir -p /var/log/nginx/app2 sudo chown -R nginx:nginx /var/log/nginx/app1 sudo chown -R nginx:nginx /var/log/nginx/app2 -

启用配置文件:

如果你使用的是sites-available和sites-enabled目录,你需要创建符号链接:sudo ln -s /etc/nginx/sites-available/app1.conf /etc/nginx/sites-enabled/ sudo ln -s /etc/nginx/sites-available/app2.conf /etc/nginx/sites-enabled/ -

检查Nginx配置:

在重启Nginx之前,检查配置文件是否有语法错误:sudo nginx -t -

重启Nginx服务:

如果配置检查无误,重启Nginx服务以应用新的配置:sudo systemctl restart nginx -

验证配置:

你可以通过访问两个Web应用的域名来验证配置是否生效。

以上步骤将为你的两个Web应用配置独立的Nginx虚拟主机和日志文件。确保在配置文件中指定正确的域名和Web应用的根目录,以及为每个应用指定独立的日志文件路径。

*七、如何使用命令向tcp、udp端口中传入数据

向tcp端口传数据

在Linux命令行中,你可以使用多种工具向指定的TCP端口发送数据。以下是一些常用的方法:

1. 使用nc(netcat)命令

nc是一个功能强大的网络工具,可以用来监听TCP或UDP端口,或者向指定的端口发送数据。

echo -e "GET / HTTP/1.1\r\nHost: example.com\r\n\r\n" | nc example.com 80

这个命令向example.com的80端口发送了一个HTTP请求。

2. 使用telnet命令

telnet通常用于建立TCP连接,但也可以用来发送数据。

echo -e "GET / HTTP/1.1\r\nHost: example.com\r\n\r\n" | telnet example.com 80

请注意,telnet可能不会在所有Linux发行版中预装,你可能需要先安装它。

3. 使用openssl命令

如果你需要向SSL/TLS端口发送数据,可以使用openssl。

echo -e "GET / HTTP/1.1\r\nHost: example.com\r\n\r\n" | openssl s_client -quiet -connect example.com:443

这个命令向example.com的443端口(HTTPS)发送了一个HTTP请求。

4. 使用socat命令

socat是一个多功能的网络工具,可以用来建立连接、端口转发等。

echo "Hello, World!" | socat STDIN TCP:example.com:80

这个命令向example.com的80端口发送了字符串"Hello, World!"。

5. 使用ncat命令

ncat是nc的一个增强版本,也可以用来发送数据。

echo "Hello, World!" | ncat example.com 80

注意事项

- 确保你有权限向目标端口发送数据,以及目标端口是开放的。

- 这些命令发送的数据是明文的,如果你需要发送敏感信息,请确保使用加密连接(如

openssl)。 - 某些命令可能需要安装额外的软件包,例如

nc、telnet、socat或ncat。 - 使用这些工具时,你可能需要根据实际情况调整发送的数据格式,以符合目标服务的协议要求。

以上是一些在Linux命令行中向指定TCP端口发送数据的方法。根据你的具体需求,选择最适合的工具和方法。

向udp端口传数据

在Linux命令行中,你可以使用nc(netcat)命令或socat命令来向指定的UDP端口发送数据。以下是使用这些工具的示例:

1. 使用nc(netcat)命令

nc是一个多功能的网络工具,可以用来发送和接收TCP和UDP数据。

echo "Hello, UDP!" | nc -u example.com 12345

这个命令向example.com的12345端口发送了一个UDP数据包,其中-u选项指定使用UDP协议。

2. 使用socat命令

socat是一个多功能的网络工具,可以用来建立连接、端口转发等。

echo "Hello, UDP!" | socat STDIN UDP4-DATAGRAM:example.com:12345

这个命令向example.com的12345端口发送了一个UDP数据包。

3. 使用printf和nc命令

如果你想要发送单个数据包,可以使用printf命令结合nc。

printf 'Hello, UDP!' | nc -u -w1 example.com 12345

这里-w1选项设置了超时时间为1秒。

注意事项

- 确保你有权限向目标端口发送数据,以及目标端口是开放的。

- UDP是一个无连接的协议,发送的数据可能不会到达目的地,或者可能在任何时候重复到达。

- 根据你的具体需求,你可能需要调整发送的数据格式,以符合目标服务的协议要求。

- 某些命令可能需要安装额外的软件包,例如

nc或socat。

以上是在Linux命令行中向指定UDP端口发送数据的一些常用方法。根据你的具体需求,选择最适合的工具和方法。

*八、日志设施(local0-local7是个啥)

写在前面

local2.* /var/log/haproxy.log

"local2日志设施"是指在Linux系统中用于日志记录的一个特定设施级别。在Linux的日志系统(syslog)中,日志消息被分为不同的优先级和设施。设施(facility)用于指定消息来源的类别,例如,是否来自系统内核、用户空间程序、邮件系统等。而优先级(priority)则用于指定消息的紧急程度,比如是否是错误、警告、信息或调试信息。