这里写自定义目录标题

- 介绍

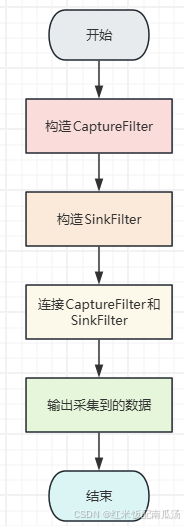

- 模型推理的输出过程方案

- 原始Token输出

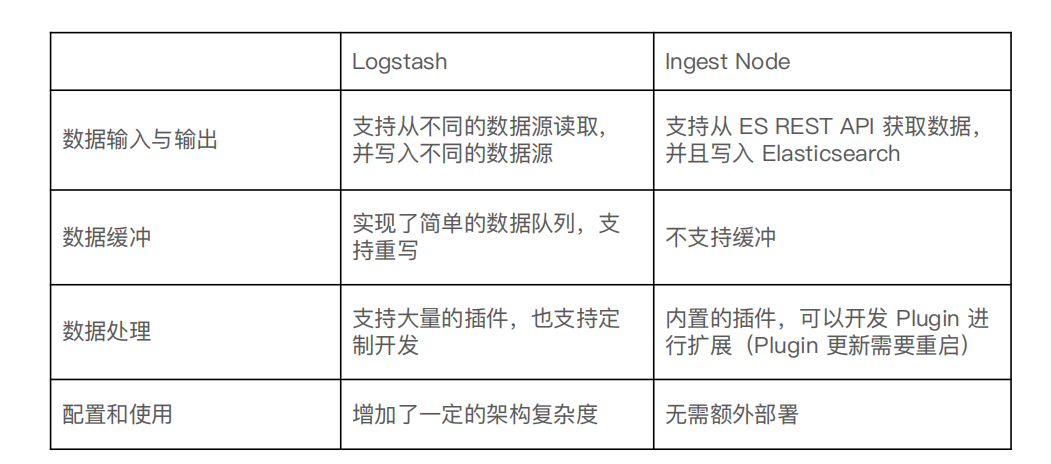

- RM输出(回归任务)

介绍

奖励函数模型 (Reward Model) 是人工智能 (AI) 中的一种方法,模型因其对给定提示的响应而获得奖励或分数。现在的文章清一色的讲解RM的训练,但是没有讲解RM是如何输出一个分数的。本文只讲RM的输出,以补充资料的缺乏。RM通常采用Llama-7B模型,本文也沿用这一模型,同时模型的推理计算过程作为已知的知识,只讲解推理最后的输出部分。本文章先介绍传统Llama模型原始Token输出过程,再讲解RM的输出。以作为对比更好的学习。

模型推理的输出过程方案

预训练语言模型(如LLaMA、GPT等)的默认任务是语言建模,它们的输出是针对每个token的概率分布(即词汇表中的每个词的概率)

注,W矩阵在llama-7b中是lm_head.weight

写在前面:回归任务就不需要原始Token输出中的logits矩阵的计算(即图中H*W+B的部分)和softmax的计算。

- 处理每个token的隐藏状态以生成全局表示

隐藏状态的介绍:

1) 平均池化(Mean Pooling)

2) 最大池化(Max Pooling)

- 回归任务输出分数:

![[ACTF2020]Upload 1--详细解析](https://i-blog.csdnimg.cn/direct/3edab97542de4610876a9b9a036b010e.png)

![[Android]相关属性功能的裁剪](https://i-blog.csdnimg.cn/direct/d5b9637d301648759e0f571432770697.png)