标题:探秘网络世界的“渔夫”:用Python编写高效网站爬虫

1. 简介

1.1. 什么是网站爬虫

想象你是一名垂钓者,而互联网则是那片广阔无垠的海洋。网站爬虫就像是你手中的渔网,只不过它不是用来捕捉鱼类,而是从这片浩瀚的信息海洋中捞取你所需的数据。简单来说,网站爬虫是一种自动化工具,通过模拟人类浏览网页的行为,访问目标网站并提取其中的数据,以便后续分析或使用。

1.2. 为什么使用Python编写爬虫

如果你是一位初涉编程的新手,Python无疑是你最佳的选择。Python语法简洁明了,易于学习,就像初春的小溪般清澈见底。更重要的是,Python拥有丰富的第三方库,如同江河中的丰富鱼群,只需轻轻一撒网,便能捕获到你所需的“数据鱼”。

1.3. 爬虫的应用场景

网站爬虫的应用场景广泛而多样,无论是市场调研、数据分析,还是学术研究、商业竞争情报收集,都离不开它的帮助。比如,你可以利用爬虫监控竞争对手的价格变动,从而调整自己的销售策略;或者通过爬虫获取社交媒体上的用户评论,进行情感分析,以改进产品或服务。

2. 准备工作

2.1. 安装所需库

在开始编写爬虫之前,我们需要准备一些必要的“钓鱼工具”,也就是Python库。这些库将帮助我们更轻松地完成爬虫任务。

2.1.1 requests

requests库就像是一把锋利的鱼叉,让你能够轻松地从网页中“抓取”数据。它是Python中最流行的HTTP库之一,支持发送各种类型的HTTP请求。

pip install requests

2.1.2 BeautifulSoup

BeautifulSoup则像是一个智能的筛网,可以过滤掉不需要的信息,只保留我们关心的内容。它是一个用于解析HTML和XML文档的库,非常适合处理网页数据。

pip install beautifulsoup4

2.1.3 re(正则表达式)

re库如同一个精准的鱼笼,能够根据特定的规则捕捉到我们想要的数据。正则表达式是一种强大的文本匹配工具,可以帮助我们在复杂的HTML中找到特定的信息。

import re

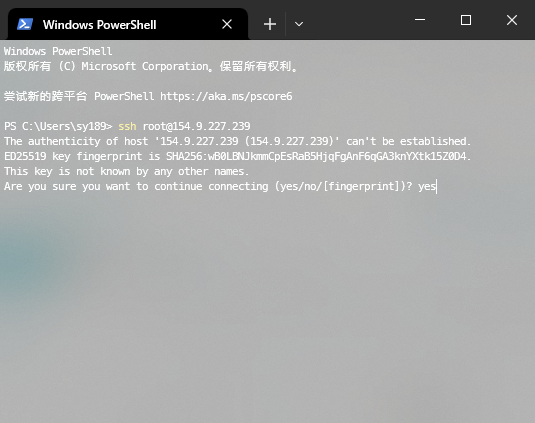

2.2. 选择目标网站

选择一个适合练手的目标网站至关重要。对于初学者来说,建议从结构简单、反爬机制较弱的网站入手,比如一些新闻网站或是博客平台。这样既能快速上手,又不至于因为频繁遇到挫折而失去信心。

2.3. 分析目标网站结构

在正式编写代码之前,我们需要对目标网站的结构有一个清晰的认识。这就好比是熟悉水域环境,知道哪里水深鱼多,哪里可能有暗流险滩。通过浏览器的开发者工具(通常按F12打开),我们可以查看网页的源代码,了解其HTML结构,从而确定需要提取的数据所在的位置。

3. 编写爬虫代码

3.1. 发送请求,获取网页内容

第一步,我们需要向目标网站发送HTTP请求,获取网页的HTML内容。这个过程就像是投下渔网,等待鱼儿上钩。

import requestsurl = 'https://example.com'

response = requests.get(url)

html_content = response.text

3.2. 使用BeautifulSoup解析网页内容,提取新闻标题和链接

接下来,我们使用BeautifulSoup来解析HTML内容,从中提取出我们需要的数据。假设我们要抓取的是一个新闻网站上的文章标题和链接。

from bs4 import BeautifulSoupsoup = BeautifulSoup(html_content, 'html.parser')

articles = soup.find_all('div', class_='article')for article in articles:title = article.find('h2').text.strip()link = article.find('a')['href']print(f'Title: {title}, Link: {link}')```

#### 3.3. 将提取到的数据保存到文件或数据库中

最后一步,我们将提取到的数据保存下来。可以选择保存为CSV文件、JSON文件,甚至直接存入数据库中,具体取决于你的需求。这里以保存为CSV文件为例:```python

import csvwith open('news_data.csv', mode='w', newline='', encoding='utf-8') as file:writer = csv.writer(file)writer.writerow(['Title', 'Link'])for article in articles:title = article.find('h2').text.strip()link = article.find('a')['href']writer.writerow([title, link])```

### 4. 异常处理与优化#### 4.1. 网络请求异常处理

在网络请求过程中,可能会遇到各种异常情况,如连接超时、服务器返回错误等。这时,我们需要添加异常处理机制,确保程序不会因为这些意外情况而中断。```python

try:response = requests.get(url, timeout=10)response.raise_for_status()except requests.exceptions.RequestException as e:print(f'Error fetching {url}: {e}')```

#### 4.2. 反爬虫策略应对

为了防止被目标网站封禁IP地址,我们可以通过设置User-Agent头、使用代理IP等方式来模拟正常的用户行为。此外,还可以在每次请求之间加入随机的延迟时间,避免过于频繁的访问。```python

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/58.0.3029.110 Safari/537.3'}proxies = {'http': 'http://10.10.1.10:3128','https': 'http://10.10.1.10:1080',}

response = requests.get(url, headers=headers, proxies=proxies)

4.3. 多线程、多进程提高爬虫效率

为了加快爬虫的速度,我们可以使用多线程或多进程技术,同时发送多个请求。Python中的threading和multiprocessing模块可以帮助我们实现这一点。不过需要注意的是,过多的并发请求可能会导致目标网站的压力过大,反而适得其反。

from concurrent.futures import ThreadPoolExecutordef fetch(url):try:response = requests.get(url, headers=headers)return response.textexcept requests.exceptions.RequestException as e:print(f'Error fetching {url}: {e}')return None

urls = ['https://example.com/page1', 'https://example.com/page2', ...]

with ThreadPoolExecutor(max_workers=5) as executor:results = list(executor.map(fetch, urls))```

#### 4.4. 设置合理的爬取间隔,避免对目标网站造成过大压力

合理设置爬取间隔不仅有助于保护目标网站的正常运行,也能减少被封禁的风险。一般来说,每次请求之间至少应间隔几秒到几十秒不等,具体取决于目标网站的负载能力和自身的需求。```python

import time

import randomtime.sleep(random.uniform(1, 3)) # 随机等待1到3秒

5. 总结与展望

5.1. 本项目实现的目标回顾

通过本次项目,我们成功编写了一个简单但功能强大的网站爬虫,能够自动从目标网站抓取新闻标题和链接,并将其保存到CSV文件中。整个过程涵盖了从环境搭建、网页解析到数据存储等多个环节,为我们提供了一个全面的爬虫开发指南。

5.2. 遇到的问题及解决方法

在实际操作中,我们可能会遇到各种各样的问题,比如目标网站的结构发生变化、反爬机制增强等。面对这些问题,我们需要保持冷静,逐一排查原因,并采取相应的解决措施。例如,如果发现某个元素无法正常提取,可以尝试调整选择器;如果遭遇IP封禁,可以考虑更换代理IP或增加请求间隔。

5.3. 对未来爬虫技术发展的展望

随着互联网技术的不断发展,网站爬虫也将面临更多的挑战和机遇。一方面,越来越多的网站开始采用更为复杂的反爬手段,如验证码识别、动态加载内容等;另一方面,人工智能和机器学习技术的进步也为爬虫技术的发展提供了新的可能性。未来,或许我们会看到更加智能、高效的爬虫工具出现,能够在保证合法合规的前提下,更好地服务于各行各业。