在 Spark 中,RDD checkpoint 是通过启动两个独立的 Job 完成的。这两个 Job 分别用于生成 checkpoint 数据和更新依赖关系。下面从源码角度深入分析这个机制。

1. 为什么需要两个 Job?

当调用 RDD.checkpoint() 后:

- 第一个 Job:将 RDD 的每个分区数据计算后,写入到指定的 checkpoint 存储位置(如 HDFS)。这个步骤的目的是将 RDD 数据物化为可靠存储,减少后续计算的成本。

- 第二个 Job:在 checkpoint 成功完成后,更新 RDD 的依赖关系,将原始的血缘依赖(lineage)替换为从 checkpoint 存储加载数据的依赖。这个步骤的目的是确保后续的计算直接基于 checkpoint 数据,而不是重新计算血缘链。

这两个 Job 是独立的,且按顺序执行,确保 checkpoint 的一致性。

2. 源码分析

以下是 Spark RDD checkpoint 的源码路径和执行过程分析。

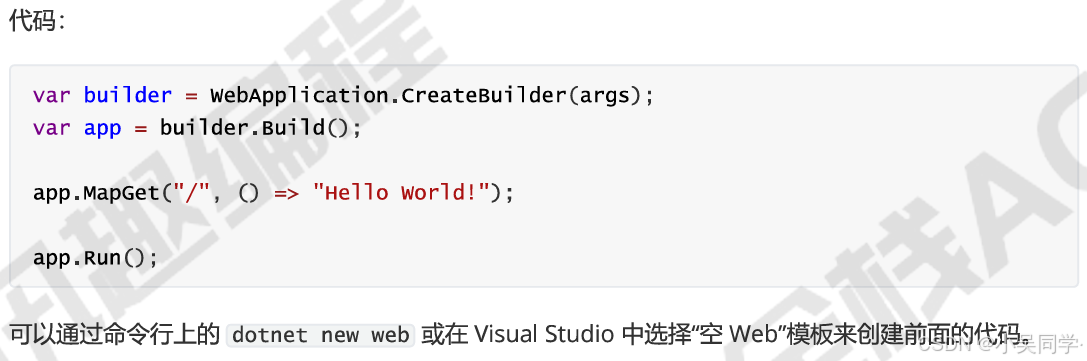

2.1 RDD.checkpoint() 的入口

调用 RDD.checkpoint() 方法时:

def checkpoint(): Unit = {if (!isCheckpointedAndMaterialized) {sc.checkpointFile[RDD类型](this)}

}

此方法会:

- 检查是否已经 checkpointed,如果是,直接返回。

- 如果没有,则调用

SparkContext的checkpointFile方法,提交一个任务将数据写入存储。

2.2 SparkContext.checkpointFile()

def checkpointFile[T: ClassTag](rdd: RDD[T]): Unit = {val cpManager = env.checkpointManagercpManager.addCheckpoint(rdd)

}

这里调用了 CheckpointManager 来处理 checkpoint 逻辑。

2.3 CheckpointManager 的作用

CheckpointManager 的核心任务是管理 checkpoint 的执行,分为以下两步:

2.3.1 第一个 Job:生成 checkpoint 数据

- 提交一个 Job,将 RDD 的每个分区数据写入存储。

代码核心逻辑:

def checkpointData[T](rdd: RDD[T]): Unit = {if (!rdd.isCheckpointed) {val newRDD = rdd.materialize() // 触发 RDD 的计算和数据写入rdd.updateCheckpointData(newRDD)}

}

关键点:

- 调用

materialize()触发 Job 提交:- 每个分区的数据会被写入到 checkpoint 目录中(例如 HDFS)。

- 使用的存储格式通常是 Sequence File。

- 数据写入存储后,生成一个新的 RDD。

2.3.2 第二个 Job:更新 RDD 的依赖关系

在 checkpoint 数据写入成功后,RDD 的依赖关系会被替换为从 checkpoint 文件加载数据的依赖。

def updateCheckpointData[T](rdd: RDD[T]): Unit = {rdd.dependencies.clear() // 清除原始的血缘依赖rdd.dependencies += new FileDependency(rdd.checkpointFile)

}

核心逻辑:

- 清除原来的 RDD 血缘关系。

- 为 RDD 添加一个新的文件依赖

FileDependency,确保后续任务直接读取 checkpoint 数据文件,而不是重新计算 lineage。

2.4 为什么需要分成两个 Job?

Spark 使用两个 Job 的原因是分离两种任务的目的:

- 第一个 Job 物化数据:确保所有 RDD 的分区数据被安全地保存到 checkpoint 目录。

- 第二个 Job 更新依赖关系:确保原 RDD 的 lineage 被替换为 checkpoint 数据的直接引用。

这种设计实现了:

- 容错性:即使第一个 Job 出现问题,原始 RDD 的血缘依赖仍然存在。

- 灵活性:两个 Job 分离后,可以分别处理物化和依赖更新的逻辑。

3. 示例说明

以下代码展示了两个 Job 的触发过程:

代码

val rdd = sc.parallelize(1 to 10).map(x => x * x)

rdd.checkpoint()// 触发 checkpoint 计算

println(rdd.collect().mkString(","))

运行过程

-

第一个 Job

- 提交一个任务,计算 RDD 的每个分区数据,并将结果写入 checkpoint 存储。

- 假设有两个分区,Job 会生成类似以下文件:

hdfs://checkpointDir/rdd_1/part-00000 hdfs://checkpointDir/rdd_1/part-00001

-

第二个 Job

- 更新 RDD 的依赖关系。

- 重新定义 RDD 的血缘链,指向 checkpoint 文件,而不是原始计算逻辑。

4. 性能与优化建议

4.1 小文件问题

如果 RDD 分区过多,checkpoint 会在存储中产生大量小文件,增加存储和读取成本。建议:

- 合理设置分区数(

coalesce()或repartition())。 - 优化存储系统(如 HDFS 的 block size)。

4.2 持久化与 checkpoint 配合

由于 checkpoint 需要在计算过程中生成数据,可以结合 persist() 使用,避免重复计算:

rdd.persist(StorageLevel.MEMORY_AND_DISK)

rdd.checkpoint()

4.3 避免不必要的 checkpoint

不要对不重要的 RDD 或生命周期较短的 RDD 设置 checkpoint,避免浪费计算资源。

5. 总结

在 Spark 中,RDD checkpoint 会启动两个 Job:

- 第一个 Job:物化 RDD 数据,将分区数据写入 checkpoint 存储。

- 第二个 Job:更新 RDD 的依赖,将 lineage 替换为对 checkpoint 文件的引用。

这种设计保证了容错性和灵活性,但也引入了一定的性能开销。合理使用 checkpoint 是优化 Spark 应用性能的重要手段。