在深度学习中,“注意力机制(Attention Mechanism)”是近年来的一个重要突破。它最初被提出用于处理自然语言处理(NLP)任务,但如今已经广泛应用于计算机视觉、强化学习和其他领域。注意力机制赋予模型一种“选择性”,使其能够专注于输入数据的某些重要部分,模拟了人类注意力的行为。

本文将深入解析注意力机制的原理、数学基础,以及其在实际中的应用,并通过代码示例帮助你更好地理解。

一、什么是注意力机制?

注意力机制的核心思想是赋予输入数据不同的权重,强调对结果最有贡献的部分,而弱化次要部分。这种机制特别适合于处理序列数据(如文本和时间序列),以及高维数据(如图像)。

一个直观类比

想象你在阅读一篇文章时,只会特别关注与你感兴趣主题相关的句子,而不会将每一句都视为同等重要。注意力机制正是这种有选择地专注于关键信息的能力。

二、注意力机制的核心公式

注意力机制的输入通常包含以下三部分:

- 查询(Query,Q):表示当前正在处理的数据,比如解码器中的当前时刻。

- 键(Key,K):表示参考数据的特征,用于匹配查询。

- 值(Value,V):表示与键对应的数据,是注意力最终返回的结果。

注意力机制通过查询与键计算相关性(类似“匹配分数”),然后对值进行加权平均,公式如下:

:计算查询与键的点积相似度。

:是缩放因子,防止点积值过大导致梯度不稳定。

- Softmax:将相似度转化为权重(概率分布)。

三、注意力机制的几种类型

1. Bahdanau Attention

Bahdanau等人提出的注意力机制用于机器翻译。它通过一个可学习的评分函数(而非点积)来计算查询和键之间的相似性:

2. Luong Attention

Luong等人提出的注意力机制更高效,使用点积或其他固定函数计算相似度,是现代注意力机制的基础。

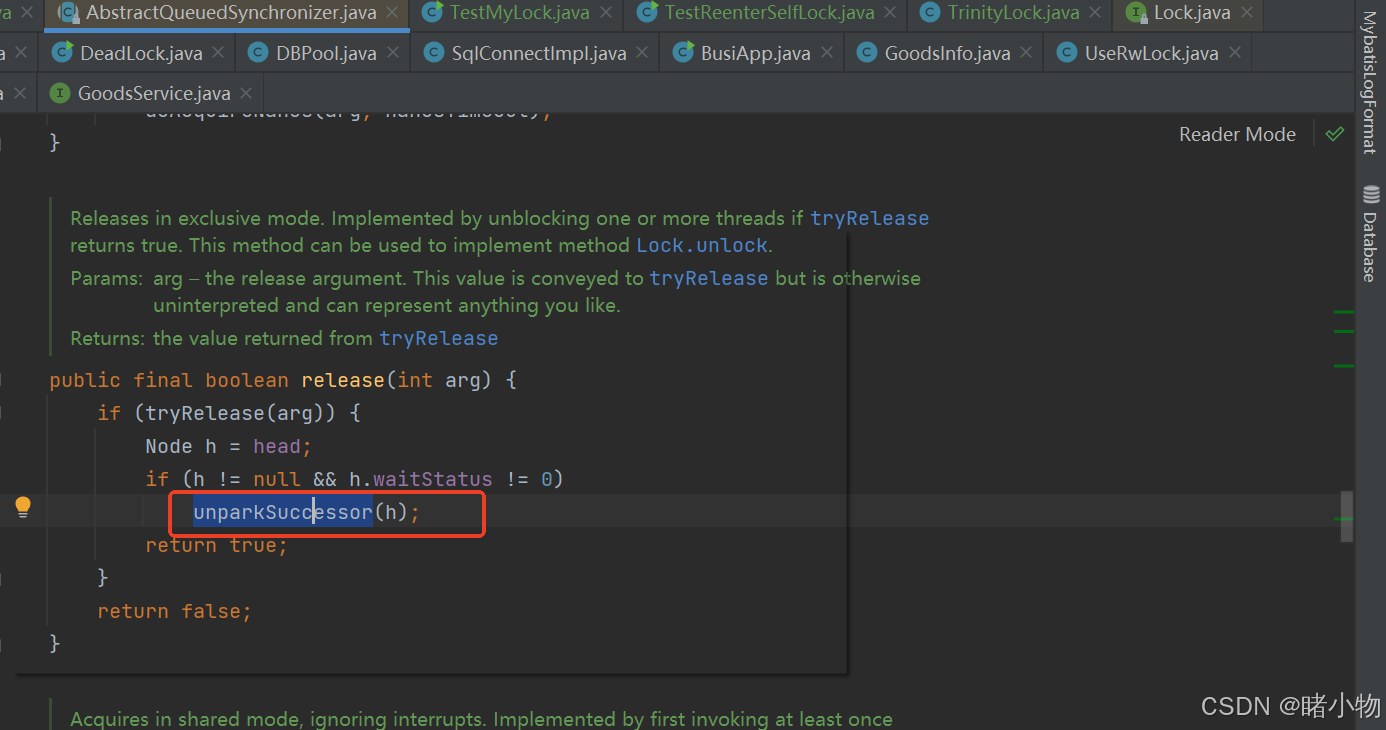

3. 自注意力(Self-Attention)

自注意力机制应用于Transformer模型,每个输入位置(如单词)与整个输入序列计算相似度,从而捕捉全局依赖关系。

四、Transformer中的注意力机制

Transformer是目前最著名的注意力机制应用框架,其核心是多头自注意力(Multi-Head Self-Attention),使模型能够同时捕捉数据的多种特征。

多头注意力公式:

其中每个头:

通过线性变换将查询、键和值投影到不同的子空间,增强模型的表达能力。

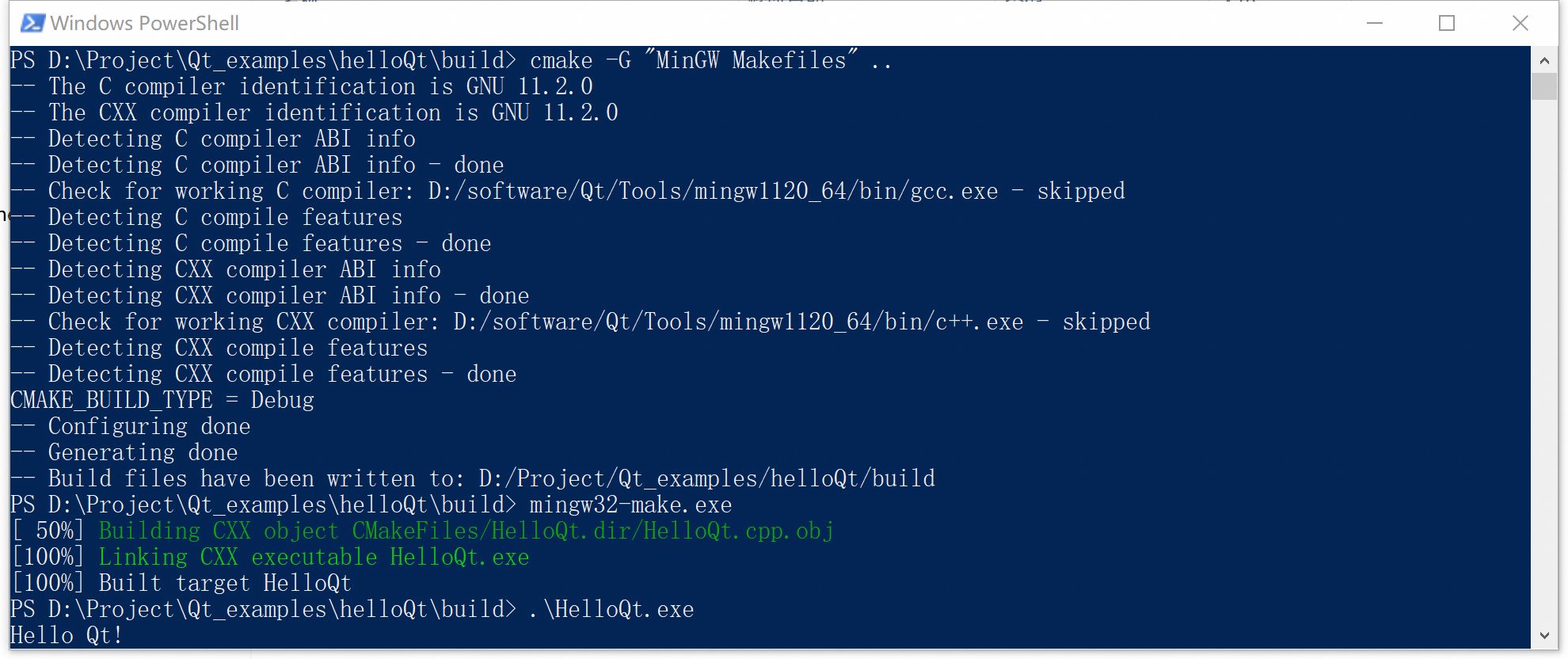

五、代码实现注意力机制

以下是一个简单的注意力机制实现:

import torch

import torch.nn.functional as Fdef scaled_dot_product_attention(query, key, value):# 点积相似度scores = torch.matmul(query, key.transpose(-2, -1)) / torch.sqrt(torch.tensor(key.size(-1), dtype=torch.float32))# Softmax 转化为权重weights = F.softmax(scores, dim=-1)# 加权值output = torch.matmul(weights, value)return output, weights# 示例数据

query = torch.tensor([[1.0, 0.0], [0.0, 1.0]]) # 2x2

key = torch.tensor([[1.0, 0.0], [0.0, 1.0]]) # 2x2

value = torch.tensor([[1.0, 2.0], [3.0, 4.0]]) # 2x2# 计算注意力

output, weights = scaled_dot_product_attention(query, key, value)

print("Attention Output:", output)

print("Attention Weights:", weights)

六、注意力机制的应用场景

1. 自然语言处理

- 在机器翻译中捕捉长距离依赖关系。

- 生成式任务(如文本摘要、对话生成)。

2. 计算机视觉

- 图像分类与目标检测(如Vision Transformer)。

- 对图像中感兴趣区域进行聚焦(如CAM方法)。

3. 推荐系统

- 分析用户行为中的重要特征。

- 提升推荐结果的个性化。

4. 强化学习

- 用于策略网络或值函数网络,捕捉状态之间的相关性。

七、注意力机制的优缺点

优点:

- 能够捕捉全局依赖关系,弥补传统RNN的不足。

- 对序列长度不敏感,可以并行计算。

- 模块化,容易嵌入其他模型架构。

缺点:

- 计算复杂度较高,尤其是对长序列。

- 依赖大量数据和算力进行训练。

八、总结

注意力机制的出现不仅解决了传统方法在处理复杂依赖关系时的瓶颈,还在多个领域引发了深远的影响。从最初的Bahdanau注意力到当前的Transformer架构,它的演进展现了技术的巨大潜力。

未来,随着计算硬件的进步和算法的优化,注意力机制将继续在更多场景中发挥重要作用。希望本文帮助你更好地理解注意力机制的本质及其实现。