摘要

这篇论文介绍了S2VNet,这是一个用于医学图像分割的通用框架,它通过切片到体积的传播(Slice-to-Volume propagation)来统一自动(AMIS)和交互式(IMIS)医学图像分割任务。S2VNet利用基于聚类的方法,通过将先前切片的聚类中心(centroids)作为后续切片的初始值,使用2D网络实现知识在不同切片间的传递。此外,S2VNet还能够处理多类交互,并且通过一种循环中心点聚合策略来提高对异常值的鲁棒性,并增强对先前切片线索的意识。

拟解决的问题:

- 现有的医学图像分割解决方案通常针对自动或交互式设置,这使得在一个任务中取得的进展难以转移到另一个任务。需要为每个任务训练单独的模型,导致训练时间和参数的重复。

- 3D网络在推理时速度慢,且在医院设备上部署困难。

- 现有交互式解决方案仅限于处理单一前景类别,而自动方法在多类别分割方面发展迅速。

创新之处:

- 统一框架:S2VNet能够在单一模型和一个训练会话中处理AMIS和IMIS。

- 切片到体积传播:通过在切片间传播聚类中心,实现了知识的有效传递。

- 多类别交互:能够同时接受多类别的用户输入,每类输入初始化一个聚类中心。

- 循环中心点聚合:通过收集历史聚类中心并将其融合为单一向量,提高了对异常值的鲁棒性。

方法

- K-Means Cross-Attention:使用可学习的嵌入作为查询,通过交叉注意力机制收集与特定对象相关的像素特征。

- 聚类传播驱动的通用分割框架:通过将聚类中心的动态演化从图像级掩码解码过程扩展到体积级。

- 交互式感知的聚类中心初始化:使用用户输入初始化聚类中心,实现用户引导的分割。

- 自适应像素特征采样:结合多轮用户输入,通过加权和的方式更新聚类中心。

- 循环中心点聚合:通过自注意力机制和前馈网络,将新聚类中心与历史聚类中心融合。

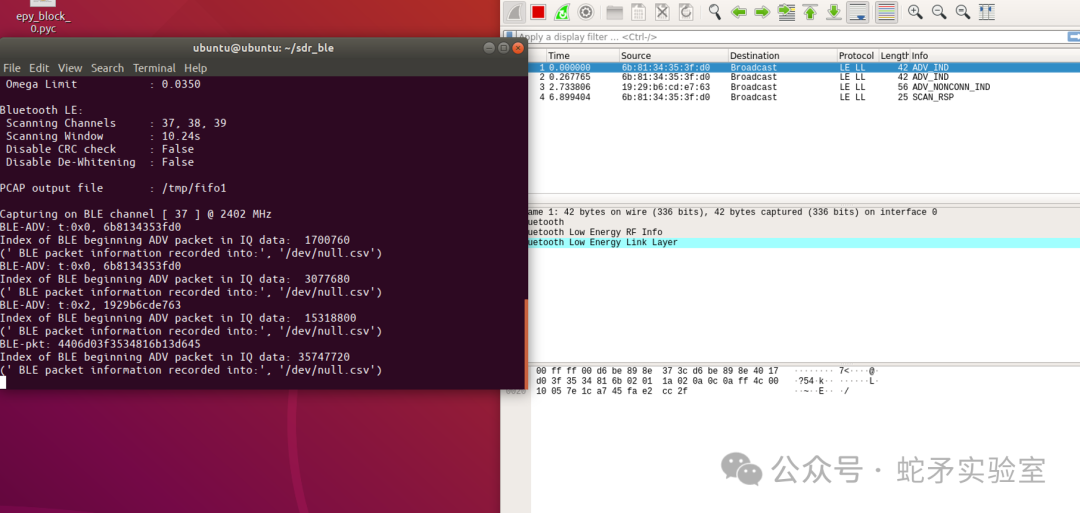

Clustering:K-Means Cross-Attention是S2VNet中的核心机制,它使用K-Means的思想来更新聚类中心(queries),并聚合与特定对象相关的像素特征。

每个像素特征被分配给最近的聚类中心。这类似于K-Means聚类中的分配步骤,其中每个数据点被分配给最近的中心。

![]()

![]()

![]()

结论

S2VNet通过聚类方法和切片到体积的传播,提供了一个灵活的体积图像分割解决方案,具有显著的速度和最先进的准确性。它不仅在多类别分割中表现出色,而且在自动和交互式设置中均实现了卓越的性能。论文还指出,尽管S2VNet在自动分割中只处理预定义的类别,未来工作将探索如何处理未定义的类别。S2VNet的快速和用户友好的特性不仅可以减轻专家的工作量,还可能有助于缓解整个医疗系统的负担。