目录

摘要

Abstract

YOLO-World

1 模型架构

1.1 Text Encoder

1.2 YOLO Backbone

2 RepVL-PAN

2.1 T-CSPLayer

2.2 I-Pooling Attention

2.3 预测

3 消融实验

3.1 预训练数据

3.2 RepVL-PAN的消融实验

3.3 文本编码器

4 效果展示

4.1 零样本

4.2 根据词汇表检测

4.3 根据参考对象检测

总结

摘要

YOLO-World通过视觉-语言建模,以及在大规模数据集上的预训练,增强了YOLO-World的开放词汇检测能力,展现出强大的零镜头能力。YOLO-World遵循标准的YOLO架构,并利用预训练的CLIP文本编码器来编码输入文本。该模型提出了可重参数化视觉-语言路径聚合网络(RepVL-PAN),以连接文本特征和图像特征,实现更好的视觉语义表示。该模型在LVIS数据集上以52.0FPS达到35.4AP,在准确性和速度方面都超过了许多最先进的方法。

Abstract

YOLO-World enhances YOLO-World's open-vocabulary detection capabilities through vision-language modeling and pre-training on large-scale datasets, demonstrating strong zero-shot capabilities. YOLO-World adheres to the standard YOLO architecture and utilizes the pre-trained CLIP text encoder to encode input text. The model introduces the Re-parameterizable Vision-Language Path Aggregation Network (RepVL-PAN) to connect text features and image features for better visual-semantic representation. Achieving 35.4 AP at 52.0 FPS on the LVIS dataset, it surpasses many state-of-the-art methods in terms of both accuracy and speed.

YOLO-World

论文链接:arxiv.org/pdf/2401.17270

开源代码地址:YOLO-World

1 模型架构

YOLO-World是由文本编码器、YOLO检测器(YOLOv8骨干网络)和RepVL-PAN组成。整体架构如下图所示:

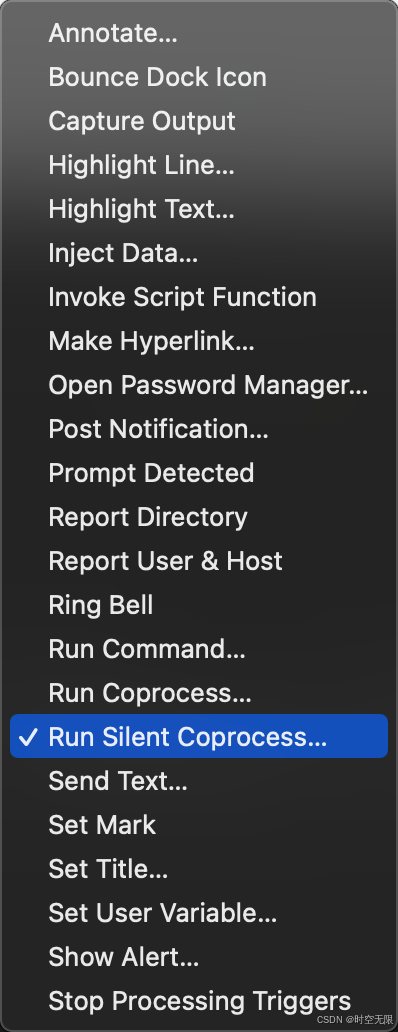

1.1 Text Encoder

文本编码器采用的是CLIP,给定文本输入Text Encoder将文本编码T转换为文本嵌入W,CLIP文本编码器能够将视觉对象与文本连接起来,提供更好的视觉语义功能。

如上图架构图中输入文本是一个完整句子时,采用n-gram算法提取名词短语后,再将其送入文本编码器。

n-gram算法:将文本拆分成若干个连续的n个词的序列,并统计这些序列在文本中出现的频率。

例如:A man and a woman are skiing with a dog.

- 1-gram是单个词,如“man”、“woman”等;

- 2-gram是相邻的两个词组成的词组,如“a man”、“a woman”等;

1.2 YOLO Backbone

YOLO-World采用的是YOLOv8的骨干网络,YOLOv8网络结构图如下所示:

上图红色框部分主要用于多尺度特征提取, 蓝色框部分就是YOLO-World架构图中Multi-scale Image Features多尺度特征输入部分,我们假设YOLO-World中特征输入也是 20x20x512 、40x40x512 、 80x80x512 ,如下图所示:

2 RepVL-PAN

了解了YOLO-World的全部输入之后,我们来看看该模型最重要的模块是如何跨模态融合文本和图像特征的。RepVL-PAN结构图如下所示:

、

、

就是上面假设的多尺度特征输入 20x20x512 、40x40x512 、 80x80x512 。通过T-CSPLayer使图像特征将文本特征融合;再通过I-Pooling Attention使文本特征又带有图像特征;反复这两个步骤,最后输出的

、

、

和文本嵌入都带有相互的信息。

2.1 T-CSPLayer

该模块会先将输入的图像特征在通道维度上做一个切分,例如 40x40x512 分为两个 40x40x256 。其中一个 40x40x256 的图像特征会先经过Dark Bottleneck做两个卷积操作,再经过Max-Sigmoid注意力更新图像上与需要预测目标最相关的区域的权重值。最后,再与另一个 40x40x256 的图像特征进行Concat,这样图像特征就融合了文本特征的信息。

Max-Sigmoid:

,

将文本特征融合到图像特征中,

作为跨模态连接的输出。图像对目标区域的权重值增大,对最后预测结果有重大影响。

2.2 I-Pooling Attention

在完成文本信息的融合之后,输出的、

、

带有文本特征信息,再通过I-Pooling Attention模块更新文本嵌入使其带有图像特征。

首先I-Pooling Attention模块会将输入的、

、

3 个尺度的图像特征进行自适应池化为 3x3 的特征图像,然后拼接为 1x27x512 的块特征。再与文本嵌入 1x3x512 进行多头自注意力技术,以更新文本特征,使其带有图像信息。

,将所有多尺度特征图像展开为27个区域,D为通道数。

因为博客开头提到有3个检测目标:man、woman、dog。假设通道数量为512,便于我们举例说明。

通过上述步骤,最终输出的、

、

拥有文本信息,同时文本嵌入也带有图像特征。

2.3 预测

在输出的、

、

后接YOLO Head预测头,输出在图像上的预测框。因为在模型训练时,并没有像传统的对象检测方法那样使用边界框和类别组成的实例注释进行训练,所以YOLO-World与输入文本特征进行对比分类。

因为输出的、

、

都带有文本特征,将其传入Text Contrastive Haed模块会得到每个预测框的Object Embedding。将此Embedding与输入文本的Image-aware Embedding进行匹配,即架构图中Region-Text Matching部分,选择匹配度最高的作为该预测框的类别。如下图所示:

3 消融实验

3.1 预训练数据

如上表,作者评估了使用不同数据预训练YOLO-World的性能。与在Objects365上训练的基线相比,添加GQA可以显著提高性能,在LVIS上获得了8.4 AP的增益。这种改进可以归因于GQA数据集提供的更丰富的文本信息,这可以增强模型识别大词汇量对象的能力。添加部分CC3M样本可以进一步带来0.5 AP的增益,以及在稀有对象上获得1.3 AP。上表表明,添加更多数据可以有效地提高在大词汇量场景中的检测能力。此外,随着数据量的增加,性能持续提高,突出了利用更大更多样化的数据集进行训练的好处。

3.2 RepVL-PAN的消融实验

上表展示了YOLO-World提出的RepVL-PAN的有效性,包括文本引导的CSPLayers和图像池化注意力,用于零样本LVIS检测。

作者采用了两种设置:

- 在O365上预训练和

- 在O365和GQA上预训练。

与仅包含类别注释的O365相比,GQA包含了丰富的文本,特别是名词短语的形式。如上表所示,提出的RepVL-PAN将YOLOv8-PAN在LVIS上提高了1.1 AP,并且在LVIS的稀有类别方面改进显著,这些类别难以检测和识别。此外,当YOLO-World使用GQA数据集进行预训练时,改进变得更加显著,实验表明提出的RepVL-PAN在丰富的文本信息下工作得更好。

3.3 文本编码器

上表中比较了使用不同文本编码器的性能,即BERT-base和CLIP-base。作者在预训练期间利用两种设置,即冻结和微调,微调文本编码器的学习率是基础学习率的0.01倍。

上表所示,CLIP文本编码器比BERT在LVIS的稀有类别上获得了更好的结果,因为这是用图像-文本对预训练的,具有更好的视觉中心嵌入能力。在预训练期间微调BERT带来了显著的改进(+3.7 AP),而微调CLIP导致了严重的性能下降。作者将这种下降归因于在O365上微调可能会降低预训练CLIP的泛化能力,O365仅包含365个类别,缺乏丰富的文本信息。

4 效果展示

4.1 零样本

4.2 根据词汇表检测

4.3 根据参考对象检测

总结

YOLO-World是一个实时开放词汇检测器,提高了实际应用中的效率和开放词汇能力。该论文将流行的YOLOs重塑为一种视觉语言YOLO架构,用于开放词汇预训练和检测,并提出了RepVL-PAN,它将视觉和语言信息与网络连接,并可以重参数化以实现高效部署。并且进一步提出了有效的预训练方案,结合检测、基础和图像-文本数据,赋予YOLO-World强大的开放词汇检测能力。实验证明YOLO-World在速度和开放词汇性能方面的优越性,并表明视觉-语言预训练对小型模型的有效性,这对未来的研究方向具有启发性。

论文核心部分: