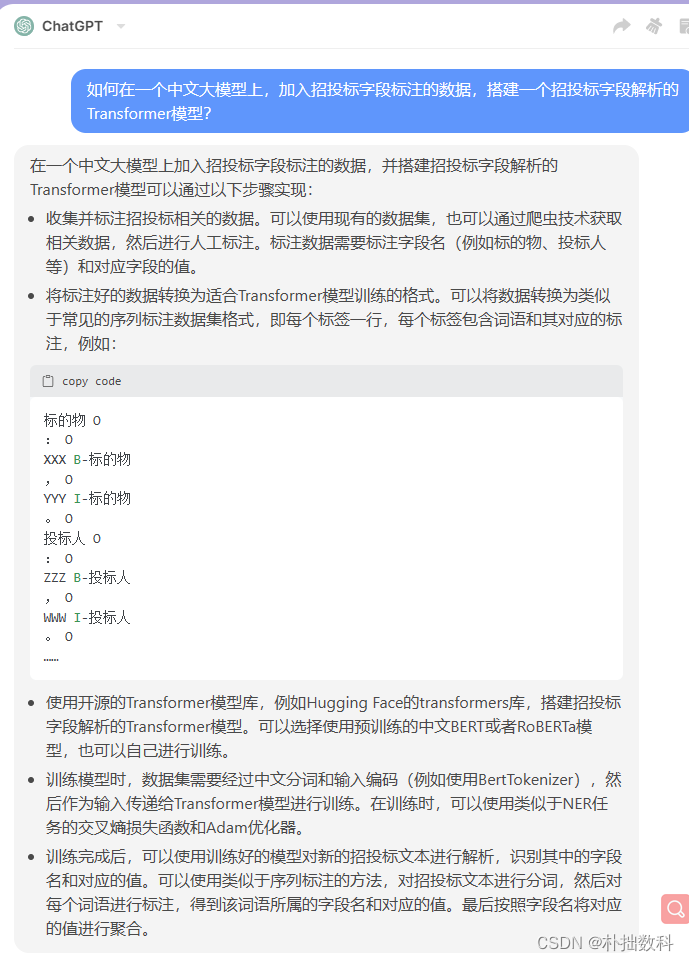

ChatGPT方案1

在一个中文大模型上加入招投标字段标注的数据,并搭建招投标字段解析的Transformer模型可以通过以下步骤实现:

-

收集并标注招投标相关的数据。可以使用现有的数据集,也可以通过爬虫技术获取相关数据,然后进行人工标注。标注数据需要标注字段名(例如标的物、投标人等)和对应字段的值。

-

将标注好的数据转换为适合Transformer模型训练的格式。可以将数据转换为类似于常见的序列标注数据集格式,即每个标签一行,每个标签包含词语和其对应的标注,例如:

标的物 O

: O

XXX B-标的物

, O

YYY I-标的物

。 O

投标人 O

: O

ZZZ B-投标人

, O

WWW I-投标人

。 O

……

-

使用开源的Transformer模型库,例如Hugging Face的transformers库,搭建招投标字段解析的Transformer模型。可以选择使用预训练的中文BERT或者RoBERTa模型,也可以自己进行训练。

-

训练模型时,数据集需要经过中文分词和输入编码(例如使用BertTokenizer),然后作为输入传递给Transformer模型进行训练。在训练时,可以使用类似于NER任务的交叉熵损失函数和Adam优化器。

-

训练完成后,可以使用训练好的模型对新的招投标文本进行解析,识别其中的字段名和对应的值。可以使用类似于序列标注的方法,对招投标文本进行分词,然后对每个词语进行标注,得到该词语所属的字段名和对应的值。最后按照字段名将对应的值进行聚合。

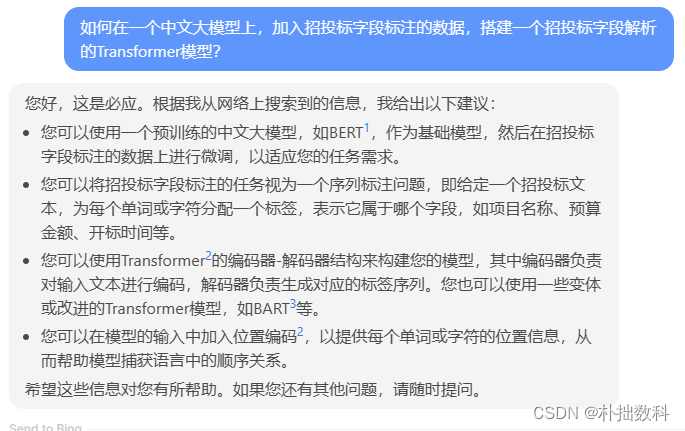

Bing 方案2

您好,这是必应。根据我从网络上搜索到的信息,我给出以下建议:

- 您可以使用一个预训练的中文大模型,如BERT1,作为基础模型,然后在招投标字段标注的数据上进行微调,以适应您的任务需求。

- 您可以将招投标字段标注的任务视为一个序列标注问题,即给定一个招投标文本,为每个单词或字符分配一个标签,表示它属于哪个字段,如项目名称、预算金额、开标时间等。

- 您可以使用Transformer2的编码器-解码器结构来构建您的模型,其中编码器负责对输入文本进行编码,解码器负责生成对应的标签序列。您也可以使用一些变体或改进的Transformer模型,如BART3等。

- 您可以在模型的输入中加入位置编码2,以提供每个单词或字符的位置信息,从而帮助模型捕获语言中的顺序关系。

希望这些信息对您有所帮助。如果您还有其他问题,请随时提问。

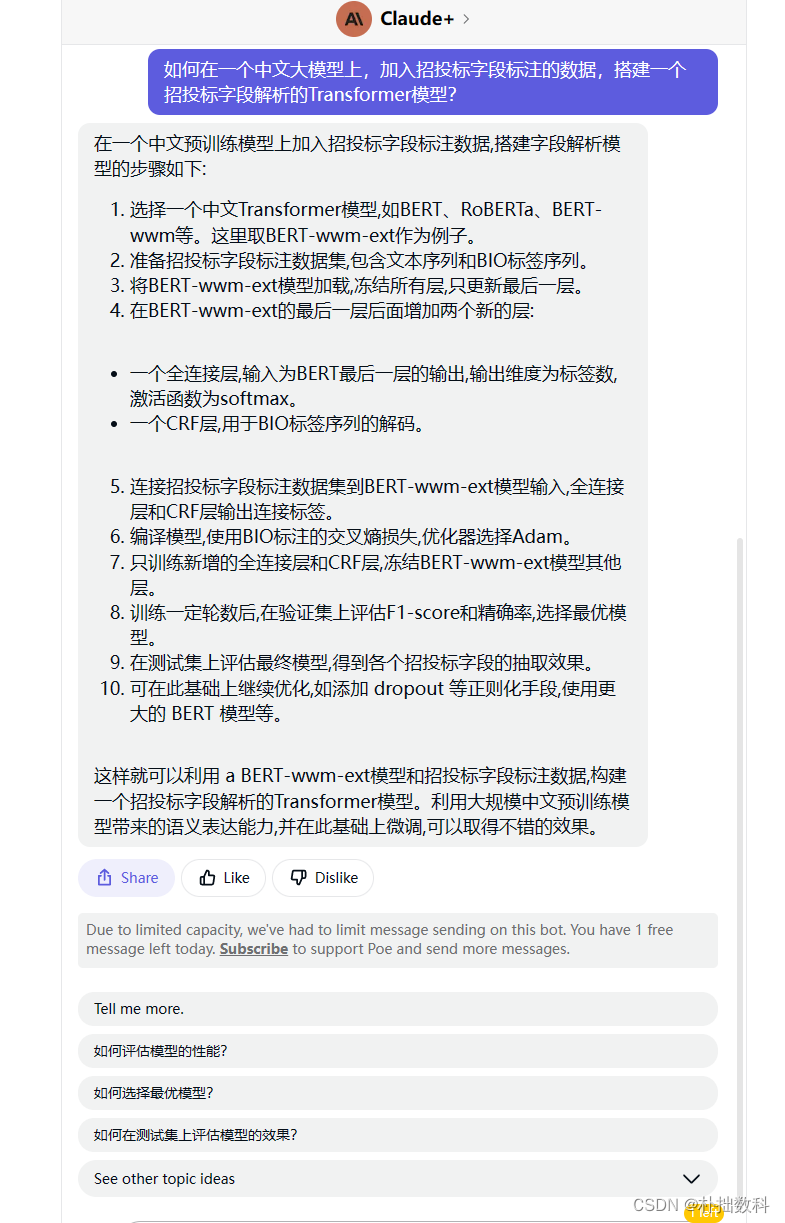

Claude+ 方案3

在一个中文预训练模型上加入招投标字段标注数据,搭建字段解析模型的步骤如下:

选择一个中文Transformer模型,如BERT、RoBERTa、BERT-wwm等。这里取BERT-wwm-ext作为例子。

准备招投标字段标注数据集,包含文本序列和BIO标签序列。

将BERT-wwm-ext模型加载,冻结所有层,只更新最后一层。

在BERT-wwm-ext的最后一层后面增加两个新的层:

一个全连接层,输入为BERT最后一层的输出,输出维度为标签数,激活函数为softmax。

一个CRF层,用于BIO标签序列的解码。

连接招投标字段标注数据集到BERT-wwm-ext模型输入,全连接层和CRF层输出连接标签。

编译模型,使用BIO标注的交叉熵损失,优化器选择Adam。

只训练新增的全连接层和CRF层,冻结BERT-wwm-ext模型其他层。

训练一定轮数后,在验证集上评估F1-score和精确率,选择最优模型。

在测试集上评估最终模型,得到各个招投标字段的抽取效果。

可在此基础上继续优化,如添加 dropout 等正则化手段,使用更大的 BERT 模型等。

这样就可以利用 a BERT-wwm-ext模型和招投标字段标注数据,构建一个招投标字段解析的Transformer模型。利用大规模中文预训练模型带来的语义表达能力,并在此基础上微调,可以取得不错的效果。

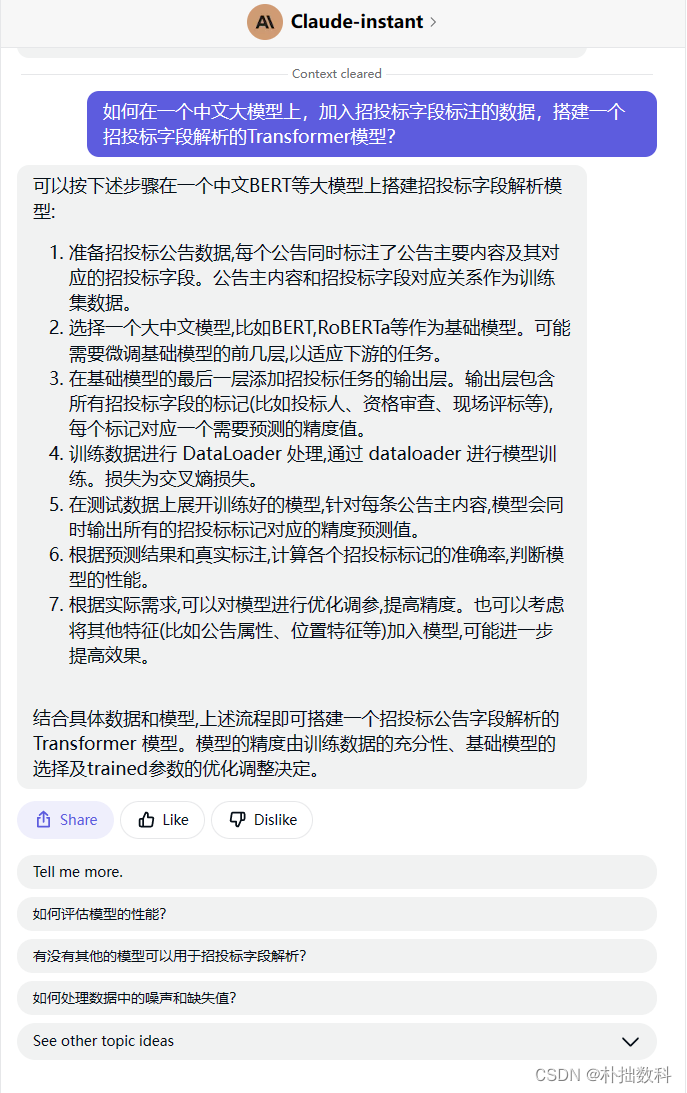

Claude-instant 方案4

可以按下述步骤在一个中文BERT等大模型上搭建招投标字段解析模型:

准备招投标公告数据,每个公告同时标注了公告主要内容及其对应的招投标字段。公告主内容和招投标字段对应关系作为训练集数据。

选择一个大中文模型,比如BERT,RoBERTa等作为基础模型。可能需要微调基础模型的前几层,以适应下游的任务。

在基础模型的最后一层添加招投标任务的输出层。输出层包含所有招投标字段的标记(比如投标人、资格审查、现场评标等),每个标记对应一个需要预测的精度值。

训练数据进行 DataLoader 处理,通过 dataloader 进行模型训练。损失为交叉熵损失。

在测试数据上展开训练好的模型,针对每条公告主内容,模型会同时输出所有的招投标标记对应的精度预测值。

根据预测结果和真实标注,计算各个招投标标记的准确率,判断模型的性能。

根据实际需求,可以对模型进行优化调参,提高精度。也可以考虑将其他特征(比如公告属性、位置特征等)加入模型,可能进一步提高效果。

结合具体数据和模型,上述流程即可搭建一个招投标公告字段解析的 Transformer 模型。模型的精度由训练数据的充分性、基础模型的选择及trained参数的优化调整决定。

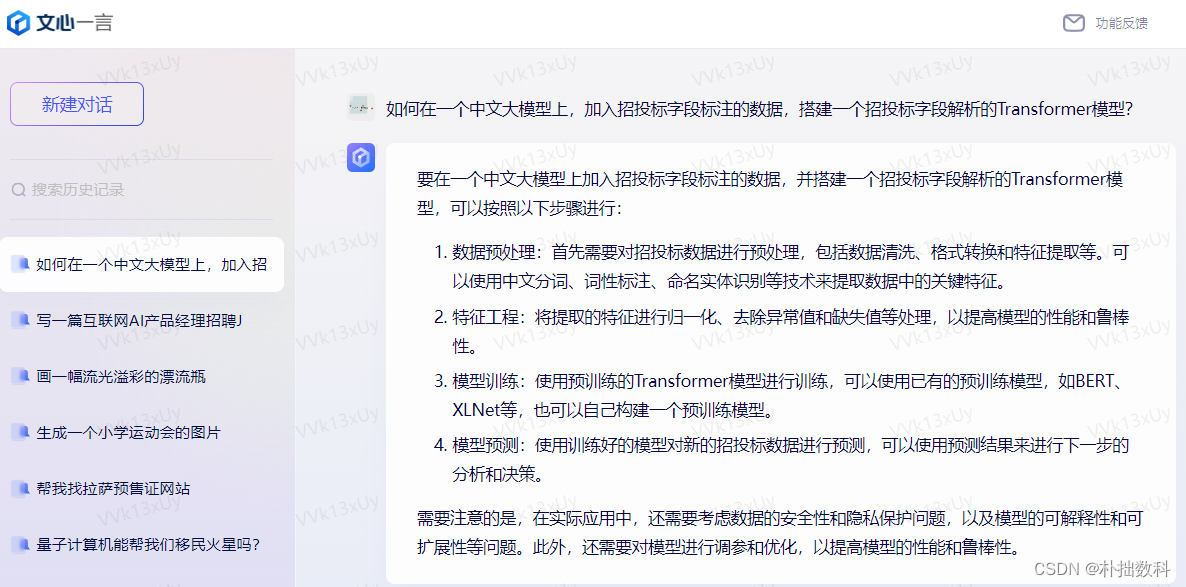

文心一言方案5

要在一个中文大模型上加入招投标字段标注的数据,并搭建一个招投标字段解析的Transformer模型,可以按照以下步骤进行:

数据预处理:首先需要对招投标数据进行预处理,包括数据清洗、格式转换和特征提取等。可以使用中文分词、词性标注、命名实体识别等技术来提取数据中的关键特征。

特征工程:将提取的特征进行归一化、去除异常值和缺失值等处理,以提高模型的性能和鲁棒性。

模型训练:使用预训练的Transformer模型进行训练,可以使用已有的预训练模型,如BERT、XLNet等,也可以自己构建一个预训练模型。

模型预测:使用训练好的模型对新的招投标数据进行预测,可以使用预测结果来进行下一步的分析和决策。

需要注意的是,在实际应用中,还需要考虑数据的安全性和隐私保护问题,以及模型的可解释性和可扩展性等问题。此外,还需要对模型进行调参和优化,以提高模型的性能和鲁棒性。

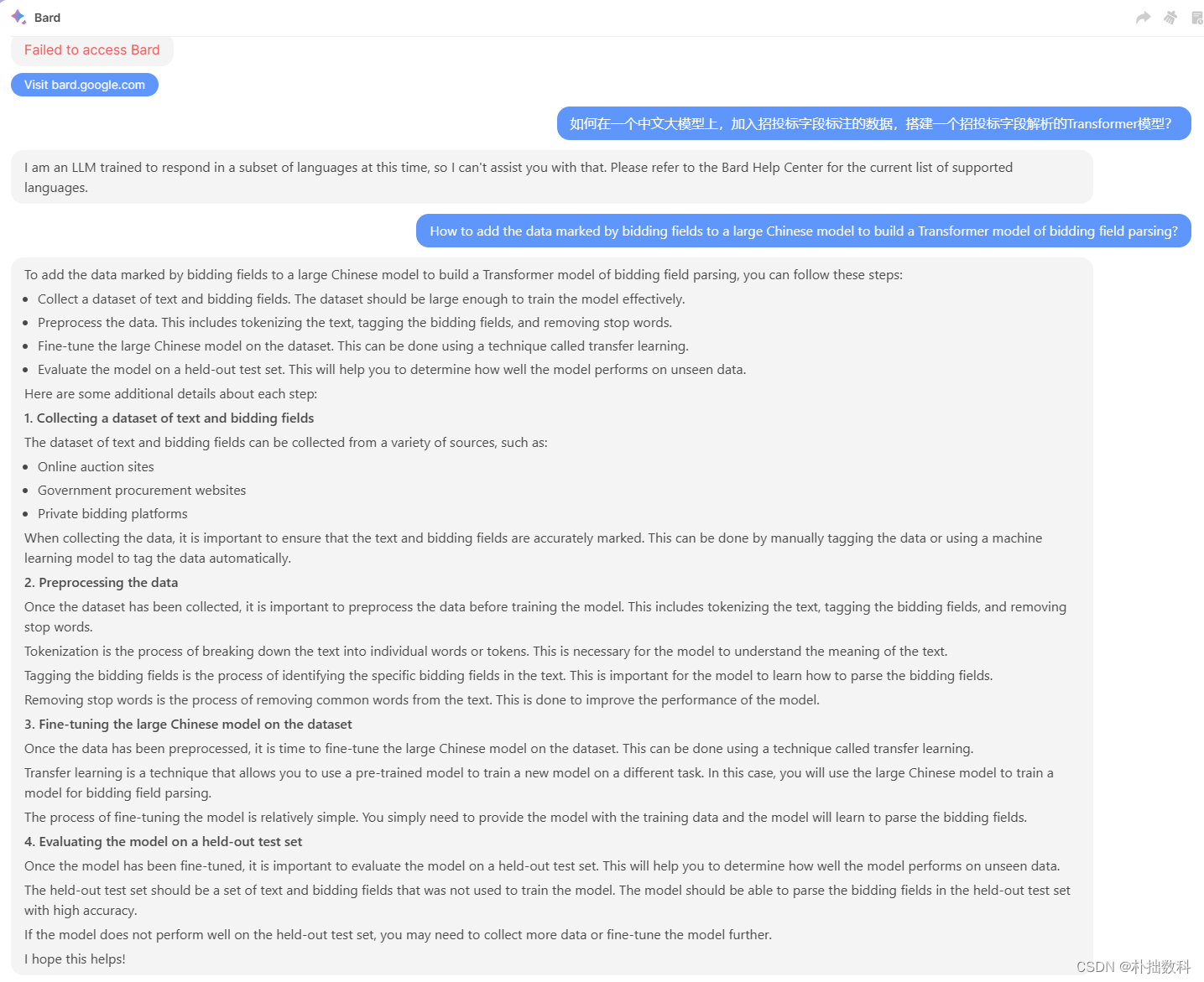

Bard 方案6

将投标字段标记的数据添加到大型中文模型中,构建投标字段解析的Transformer模型,可以按照以下步骤进行:

收集文本和投标字段的数据集。数据集应该足够大,以便有效地训练模型。

预处理数据。这包括标记文本、标记投标字段和删除停止词。

对数据集上的大型中文模型进行微调。这可以通过一种叫做迁移学习的技术来实现。

在固定测试集上评估模型。这将帮助您确定模型在未见过的数据上的表现。

以下是关于每一步的一些额外细节:

- 收集文本和投标字段的数据集

文本和竞价字段的数据集可以从各种来源收集,例如:

在线拍卖网站

政府采购网站

私人招标平台

在收集数据时,重要的是要确保文本和投标字段被准确标记。这可以通过手动标记数据或使用机器学习模型自动标记数据来完成。

- 数据预处理

一旦收集了数据集,在训练模型之前对数据进行预处理是很重要的。这包括标记文本、标记投标字段和删除停止词。

标记化是将文本分解为单个单词或标记的过程。这对于模型理解文本的含义是必要的。

标记投标字段是在文本中识别特定投标字段的过程。这对于模型学习如何解析竞标字段非常重要。

删除停止词是从文本中删除常用词的过程。这样做是为了提高模型的性能。

3.在数据集上对大型中文模型进行微调

数据经过预处理后,是时候对数据集上的大型中文模型进行微调了。这可以通过一种叫做迁移学习的技术来实现。

迁移学习是一种技术,它允许你使用一个预先训练好的模型来训练一个不同任务的新模型。在本例中,您将使用大型中文模型来训练用于竞标字段解析的模型。

对模型进行微调的过程相对简单。您只需要向模型提供训练数据,模型将学习解析竞标字段。

- 在固定测试集上评估模型

一旦对模型进行了微调,在一个固定测试集上评估模型是很重要的。这将帮助您确定模型在未见过的数据上的表现。

hold -out测试集应该是一组未用于训练模型的文本和竞标字段。该模型应该能够以较高的准确率解析出hold out测试集中的投标字段。

如果模型在持久化测试集中表现不佳,则可能需要收集更多数据或进一步微调模型。

我希望这对你有帮助!