yolov4算法及其改进

- 1、yolov4介绍

- 2、mosaic与mish激活函数

- 2.1、mosaic数据增强

- 2.2、Mish激活函数

- 3、backbone网络框架的改进

- 4、PAN-FPN的介绍

- 5、样本匹配和损失函数

- 5.1、样本匹配

- 5.2、YOLOV4损失函数

- 5.2.1、GIOU loss

- 5.2.2、DIOU loss

- 5.2.3、CIOU Loss

1、yolov4介绍

改进点:

- 输入端改进:Mosaic数据增加

- 主干网络:CSPDarkNet53

- Neck:SPP、PANet

- 损失函数:CIOU

- 激活函数:Mish激活函数

- 样本匹配:增加了匹配样本的数量

2、mosaic与mish激活函数

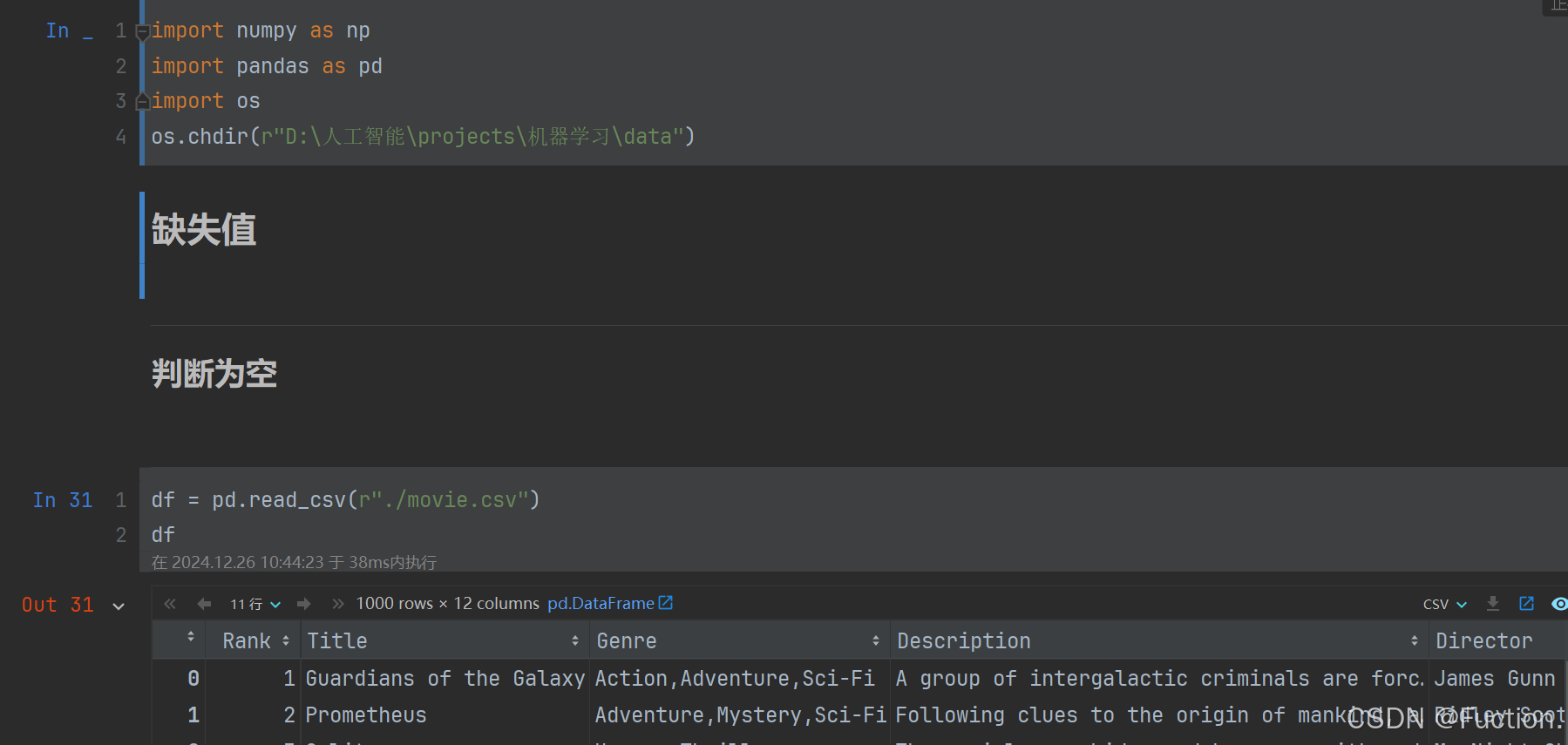

2.1、mosaic数据增强

数据增强步骤:

- 首先随机取4张图片

- 分别对4张图片进行数据增广操作,并分别粘贴至与最终输出图像大小相等的掩模的对应位置

- 进行图片的组合和框的组合

优点:

- 丰富数据集:使用4张图片,随机缩放,随机分布进行拼接,大大丰富了目标检测的数据集,增加了很多小目标,让网络模型对小目标的稳健性变的更好

- 减少GPU使用:mosaic增强训练时,可以在单图像尺度的情况下直接计算4张图片的数据,使得mini-batch size并不需要很大,即使用1个GPU就可以达到比较好的收敛效果

2.2、Mish激活函数

mish激活函数是自带正则的非单调激活函数,平滑的激活函数可以让模型获得更好的非线性,从而得到更好的准确性和泛化,Mish激活函数的数学表达式如上式。

首先函数和relu一样都是无正向边界的,可以避免梯度饱和,其次,mish函数时光滑的,并且在绝对值较小的负值区域允许一些负值。

注意,mish激活函数的计算复杂度比relu要高,在计算资源不足的情况下,可以考虑使用leakyrelu激活函数代替mish激活函数。

3、backbone网络框架的改进

CSPNet的概念:通过分割梯度流,使梯度流在不同路径中传播,这种传播的梯度信息更加丰富,此外,CSPnet可以打打减少计算量,提高推理速度以及精度

CSPNet的主要目的:可以实现更丰富的梯度组合,同时减少计算量。

实现方法:将基础层的特征层分割成两部分,然后通过提出的跨阶段分层结构进行合并来实现

基于CSPNet的目标检测器主要有以下3个优势:

1、增强学习能力:

2、移除计算瓶颈:

3、降低内存消耗:

transition层的含义和densenet类似,是一个1*1的卷积层而不是使用average pool

CSPNet设计了两种变体来展示这种梯度流截断如上图C、D

fusion first方式:先将2部分进行concat,然后进行输入到transion层,采用这种方式,可以使得大量梯度信息被重用,有利于网络学习

fusion last方式:先将部分特征输入transition层,然后再进行concat,这样梯度信息将被截断,损失了部分梯度重用,但是由于transition的输入维度比图c少,因此可以减少计算量

图b结合了图c和图d,提升了学习能力的同时也提高了一下计算复杂度

注:图中fusion last和fusion first位置互换

CSPDarkNet结合fusion last和fusion first的设计思想,设计了CSPResBlock,用于构建CSPDarkNet

CSPResBlock的基本组件Conv+bn+mish的形式,其中也包含了Resnet吸取的残差结构的思想,但是为了减低重复的梯度学习,设计者有使用了另一个shortcut和conv+bn+mish结合的形式,对特征进了一次提取,以增加梯度的丰富性。

由于跨越的卷积层比较多,大大降低了梯度学习的重复性,同时,在block的最后使用了concat进行特征融合,也大大增加了特征的鲁棒性,从而很大程度提升了模型的性能。

注:图中fusion last和fusion first位置互换

这里的CSPDarkNet53对于每一个stage的配置通darknet53一样,分别是1,2,8,8,4,依次对应下采样倍数为:2、4、8、16、32。

SPP

yolov4使用了spp的思想,在backbone尾部使用了spp结构实现了局部特征和全局特征的融合,扩大了感受野,丰富最终特征图的表达能力,进而提高map。

spp模块的特点如下:

1、由于对输入图像的不同纵横比和不同尺寸,spp同样可以处理,所以提高了图像的尺度不变和降低了过拟合

2、实验表明训练图像尺寸的多样性比单一尺寸的训练图像更容易使得网络收敛

3、spp对于特定的cnn网络设计和结构都是独立的(只要把spp放在最后一层卷积层后面,对网络的结构是没有影响的,它只是替换了原来的pooling层)

4、不仅可以用于图像分类而且可以用来目标检测

4、PAN-FPN的介绍

FPN是自顶向下将高层的强语义特征传递下来,对整个特征金子塔进行增强,但是FPN只增强语义信息,对定位信息没有很好的传递,因此YOLOV4增加了PAN来增强定位信息的传递。

FPN+PAN借鉴的是PANet,主要应用于图像分割领域,如上图所示,FPN采用自顶向下,将高层的强语义特征传递下来,而PAN+FPN针对这一点,在FPN的后面添加一个自底向上的金字塔,这样的操作是对FPN的补充,将底层的强定位特征传递上去。这样不仅能增强高级语义信息,还能增强定位信息。

5、样本匹配和损失函数

5.1、样本匹配

对于YOLOV4,与YOLOV3不同,只要大于IOU阈值的anchor box,就认为正样本,原本在yolov3中被忽略的,在YOLOV4只统统被认为正样本。

GT需要利用MAX iou原则分配到不同的预测层yolo-head上去,然后在每个层上单独计算正负样本和忽略样本

5.2、YOLOV4损失函数

MSE LOSS 主要问题是导数变化不稳定,后来提出了IOU一系列函数

主要有IOU=>GIOU=>DIOU=>CIOU,IOU表达式如上图:

但是IOU存在2个问题如下图:

1、当IOU为0时,无法反应两个框距离的远近,此时损失函数不可导

2、两个预测框大小相同,2个IOU也相同,但是无法区别

5.2.1、GIOU loss

C为最大外接矩阵 ,红色区域为差集A,可以区分以下两种情况

同时也存在以下问题:

交集相同,并集也相同。

5.2.2、DIOU loss

认为好的目标框回归函数应该考虑3个重要几何因素:重叠面积,中心点距离,长宽比

DIOU loss = 1 - IOU + 欧氏距离

DIOU问题

如上图所示,预测框和真实目标框的中心点距离是相同的,但是DIOU没有引入长宽比,因此无法解决这个问题。

5.2.3、CIOU Loss

YOLOV4采用CIOU Loss做Bounding box的回归损失韩式,而分类损失和目标损失都使用的是交叉熵损失,对于回归损失,数学表达式如上。

式中d,c分别表示预测结果与标注结果中心点的欧式距离和框的对角线距离,w和h表示预测框的宽高。这样CIOU loss将目标回归函数应该考虑的3个重要几何因素都考虑了:重叠面积,中心点距离,长宽比。

对于分类和目标损失,数学表达式如下: