在现代运维场景中,随着系统复杂性和服务规模的不断增长,传统的资源调度方式已无法满足高效、动态和精准的需求。AI技术的引入为资源调度带来了新的解决方案,通过智能算法和数据驱动,实现了资源分配的自动化与优化。本文将详细探讨基于AI的运维资源调度,并通过Python代码示例展示其实际应用。

运维资源调度的挑战

-

资源分配复杂:随着云计算和分布式架构的普及,资源类型繁多,包括计算资源、存储资源和网络资源。

-

需求动态变化:业务流量的峰谷变化使得资源需求随时波动,传统静态分配方式难以适应。

-

多目标优化:需要在性能、成本和稳定性之间权衡,实现最优解。

-

故障处理:资源调度系统需具备快速响应故障的能力,避免服务中断。

基于AI的资源调度解决方案

AI在运维资源调度中的应用主要体现在以下方面:

-

预测建模:通过机器学习算法预测资源需求,提前做好资源准备。

-

智能调度算法:利用强化学习、遗传算法等优化资源分配策略。

-

自动化执行:结合智能调度器实现资源的动态分配与调整。

接下来,我们通过具体实现展示AI如何优化运维资源调度。

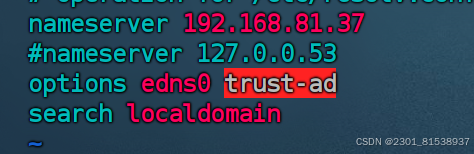

环境准备

确保已安装以下Python库:

-

NumPy:用于科学计算。

-

Pandas:用于数据处理。

-

Scikit-learn:用于机器学习。

-

TensorFlow/Keras:用于深度学习(如有需要)。

安装方式:

pip install numpy pandas scikit-learn tensorflow

资源需求预测示例

首先,我们基于历史数据预测未来资源需求。

import pandas as pd

import numpy as np

from sklearn.model_selection import train_test_split

from sklearn.ensemble import RandomForestRegressor

from sklearn.metrics import mean_squared_error# 模拟资源使用数据

data = {'cpu_usage': np.random.uniform(10, 90, 100),'memory_usage': np.random.uniform(500, 4000, 100),'disk_io': np.random.uniform(100, 1000, 100),'network_io': np.random.uniform(50, 500, 100),'future_cpu_usage': np.random.uniform(10, 90, 100) # 目标变量

}# 创建数据框

data_df = pd.DataFrame(data)# 特征和目标

X = data_df[['cpu_usage', 'memory_usage', 'disk_io', 'network_io']]

y = data_df['future_cpu_usage']# 数据拆分

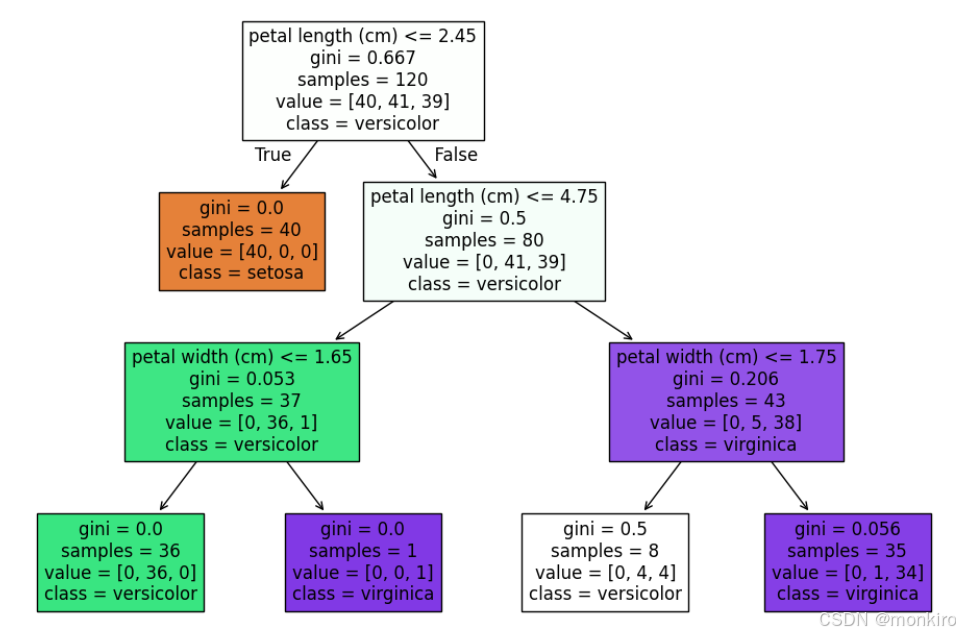

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)# 随机森林回归模型

model = RandomForestRegressor(n_estimators=100, random_state=42)

model.fit(X_train, y_train)# 预测

predictions = model.predict(X_test)

mse = mean_squared_error(y_test, predictions)

print(f'Mean Squared Error: {mse}')通过训练机器学习模型,我们能够预测未来的CPU使用率,帮助提前分配资源。

智能调度示例

利用强化学习优化资源分配策略。以下是基于Q-Learning的简单调度示例。

import numpy as np# 定义环境和动作

states = ['low_load', 'medium_load', 'high_load']

actions = ['allocate_small', 'allocate_medium', 'allocate_large']# Q表初始化

q_table = np.zeros((len(states), len(actions)))# 参数定义

learning_rate = 0.1

discount_factor = 0.9

epsilon = 0.1# 状态映射

def get_state_index(state):return states.index(state)def get_action_index(action):return actions.index(action)# Q-Learning算法

def q_learning_update(state, action, reward, next_state):state_idx = get_state_index(state)action_idx = get_action_index(action)next_state_idx = get_state_index(next_state)max_next_q = np.max(q_table[next_state_idx])q_table[state_idx, action_idx] += learning_rate * (reward + discount_factor * max_next_q - q_table[state_idx, action_idx])# 模拟调度过程

for episode in range(100):state = np.random.choice(states)for step in range(10):if np.random.uniform(0, 1) < epsilon:action = np.random.choice(actions)else:action = actions[np.argmax(q_table[get_state_index(state)])]reward = np.random.uniform(0, 1) # 模拟奖励next_state = np.random.choice(states) # 模拟下一个状态q_learning_update(state, action, reward, next_state)state = next_stateprint("Trained Q-Table:")

print(q_table)

总结

基于AI的运维资源调度将传统的手动管理方式转变为智能化、数据驱动的模式。通过需求预测与智能调度,系统可以高效地分配资源,提升性能并降低成本。

未来,随着深度学习和强化学习技术的进一步发展,资源调度将更加精准和高效,成为现代运维的核心组成部分。