往期文章:

- AI/CV面试,直达目录汇总

- 【AI面试】NMS 与 Soft NMS 的辨析

- 【AI面试】L1 loss、L2 loss和Smooth L1 Loss,L1正则化和L2正则化

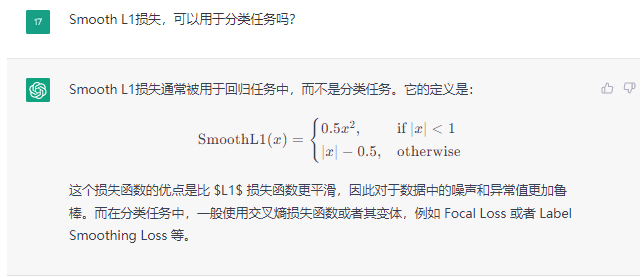

在一次询问chatGPT时候,在他的回答中,由smooth L1联想提到了Label Smoothing Loss 。我把问题贴到下面,和chatGPT的回答,供你参考。不知道你是不是也在使用chatGPT,后面针对这个思考也可以一起交流下。

原本我是想到了在faster RCNN目标检测算法中,对于目标框的位置回归部分,通常采用Smooth L1 Loss。于是我就想到,Smooth L1 Loss是否特能用于分类任务呢?当然,这里我就是脑洞一问,得知了用于分类任务中的Label Smoothing Loss。

Label Smoothing Loss和<