新型冠状病毒疫情加剧,让人闲的不行。重新打开我的简书之后,发现我在简书上也写了72篇文章了……

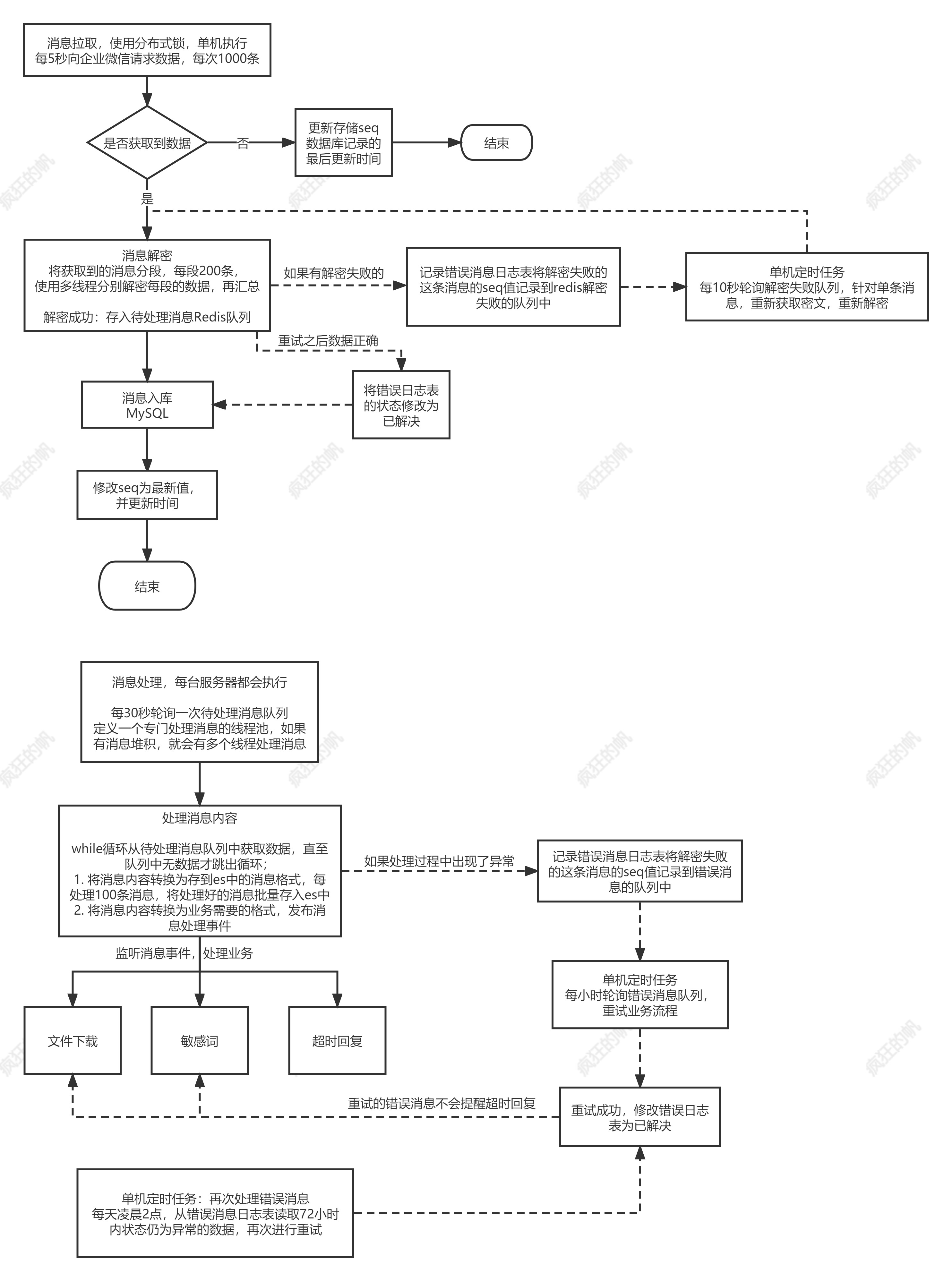

想“温故而知新”一下,但是在家总是慵懒,就算是自己写的文章也不想看。但是又十分好奇自己在过去的一年多的时间里到底写了啥,于是决定用python对自己的文章进行简单的文本分析,分析目标是:

得到每一篇文章的关键词;

使用这些关键词生成所有文本的关键词共现网络。

一、文本预处理

首先先导出并解压自己的文章,简书的导出非常方便,这也是我喜欢用简书编辑器的原因(包括本文也是用简书编辑器写的),写出来的东西都还可以是自己的。

一共有8个文件夹,由于所有文本都是使用markdown写的,所以文本预处理比较简单,仅仅需要去除特殊符号(如:#、\n等)。在对具体文本进行分析时候发现,许多文本中均出现了许多代码,并且部分文章中英文混杂。转念一想,文章以中文为主,并且代码部分与其他部分关联较小,无论是用TF-IDF方法还是TextRank都不会出现在关键词的前列,所以在预处理阶段暂时不处理这个问题。核心代码如下(其实很简单):

f = open(text_file, 'r', encoding='UTF-8')

data = f.read()

str = re.sub('[^\w]', '', data) #去除特殊符号(如:#、\n等)

二、TF-IDF模型提取关键词

在提取关键词之前,需要先对每个文本进行分词,中文分词的方法包括jieba、SnowNlp等。(引自:Jieba、NLTK等中英文分词工具进行分词)本文使用jieba分词方法。

import jieba

TF-IDF模型是最简单的提取关键词的模型,学术的解释如下。

TF-IDF(term frequency–inverse document frequency,词频-逆向文件频率)是一种用于信息检索(information retrieval)与文本挖掘(text mining)的常用加权技术。TF-IDF是一种统计方法,用以评估一字词对于一个文件集或一个语料库中的其中一份文件的重要程度。字词的重要性随着它在文件中出现的次数成正比增加,但同时会随着它在语料库中出现的频率成反比下降。(引自:关键字提取算法TF-IDF和TextRank(python3))

一个词是不是关键词,在TF-IDF模型看来,仅仅在于两个方面:1)在当前文本出现的频次高;2)在所有文本中出现的频次不能太高。基于这个思想,TF-IDF的计算方法如下:

1.计算词频(tf),等于某个词在文本中的词数除以文本的总词数。

2.计算逆向文本频率(IDF),先计算文本总数除以包含该词的文档数,为了防止分母等于0,在分母的位置加上1,在完成除法计算后取对数。

3.TF-IDF值是词频与逆向文本频率之积。

用Python计算每篇文章每个词的tf-idf值,需要先对每个文本进行分词,对每个词需要遍历所有的文本的所有词,工作量比较大。硬上的话,代码效率估计会比较低。但是!在看jieba算法的时候,惊奇的发现jieba算法已经内嵌有TF-IDF算法(当然也有TextRank算法),不用造轮子的感觉很舒服,核心代码如下。

import jieba.analyse as anls

for x, w in anls.textrank(str, topK=5, withWeight=True): # 选择输出5个关键词file_list[name][file].append([x, w])

为了看到分词效果,把结果输出到csv中。从结果看还是很不错的,比如在《人是如何废掉的》这篇文章中,把“手机”和“挫败”这两个关键词找出来了,在《人是如何好起来的》中把“自律”和“计划”找出来了。这两篇一年前写的文章对一年后的生活依然能够有很好的概括,解决措施也完全适用,果然还是知易行难。

三、关键词共现网络

关键词共现网络构造的关键是构造共词矩阵。在已经得到每一篇文章的关键词后,假如不考虑每个词的连接强度的计算方法,共词矩阵的构造非常简单,只需要将所有关键词提取出来,将每两个关键词共同出现的次数分别计算出来形成矩阵即可。

在完成共词矩阵的构造后,绘图部分同样使用Python实现,所幸在Python中也有前人做好了轮子。使用的是networkx。结果如下图。

虽然这个结果图没有Gephi、CiteSpace等软件画出的图好看,但是也着实让人兴奋了好一阵。一个个区域放大来看,确实看出了很多东西。从整体看来,我的文章还是关联度比较高的。从主要部分看,主要是两个方面的内容:学习和生活,从周围部分来看,主要是生活的内容。

1. “学习”部分

在学习这一部分,科研是大头,“教育”是一个关键的中心词,连接了“学科”、“研究生”、“研究生”、“高校”、“理论”、“经济”等方面的内容,说明我的文章都涉足过这些内容。另外,出现的“学位点”和“京津冀”也倍感亲切,这是我曾经参与过的课题,学位点项目涉及的招生规模、学位授予、产业结构,京津冀项目涉及的创新、协同、机制、区域发展等方面的内容都出现在关键词共现图上了,愈感兴奋。另外还把“北京”和“服务业”连接起来了,在图中居然能够反映第三产业对于北京的重要性,有点厉害。有意思的是,“经济”这一个连接词不仅连接了“教育”,还连接了王者荣耀(“兵线、“装备””)和之前看的《经济战争与战争经济》这本书的相关内容,不说看书,看来我对游戏的态度也是认真的(手动狗头)。

在“京津冀”关键词的右边,出现了“游戏”、“小游戏”、“弹球”、“障碍物”、“控制”、“图形化”、“代码”等词语,都是我在写毕业论文的时候思考和干活的主要方面,这也能挖出来。

此外,看到“青年教师”四个字,也想起了去年读博前看的《“青椒”的历史印痕——大学青年教师学术与生活的社会考察》这本书,以及当时深深的焦虑。

2. “生活”部分

“生活”部分比较杂,比如有探讨时间管理的。

有思考亲密关系的。

也分析过原生家庭的特征与影响。

除了主要部分外,各个分支也能够展现我的兴趣和曾经的思考方向,比如写过纪念我诺退役的文章,也曾经也研究过服装的搭配(好像也没什么卵用- -)。

曾经用CiteSpace形成的知识图谱分析过中国高等教育教育的特点,但是倍感吃力。现在通过自己文章的文本数据分析自己的过去一年的思考,还真有一种弄恍然大悟的感觉。刘则渊教授曾经说过一句话,“一图展春秋,一览无余;一图胜万言,一目了然”,今天体会到了这种感觉,酣畅淋漓。要得到知识图谱背后的“隐喻”,对所分析的数据熟悉程度要高(比如都是你自己写的- -),而且要对知识图谱所涉及的领域足够了解,不然也只是牵强附会而已。

代码如下:

文本分析部分代码

import os

import sys

import re

import jieba

import jieba.analyse as anls

import pickle

import pandas as pd

def saveResult(obj, savePath): # 保存函数with open(savePath, 'wb') as f:pickle.dump(obj, f, pickle.HIGHEST_PROTOCOL)

file_dir = 'article' # 换成自己的路径

file_list = {}

get_result = []

for filename in os.listdir(file_dir):file_list[filename] = {}

for name in file_list:file_name = file_dir + namefor file in os.listdir(file_name):file_list[name][file] = []text_file = file_name + '/' + filef = open(text_file, 'r', encoding='UTF-8')data = f.read()str = re.sub('[^\w]', '', data)keywords = ''# 使用TF-IDF算法得到关键词for x, w in anls.textrank(str, topK=5, withWeight=True):file_list[name][file].append([x, w])keywords += x + ', 'get_result.append([file, keywords])

name = ['title', 'keywords']

contents = pd.DataFrame(columns=name, data=get_result)

contents.to_csv('文章关键词.csv', encoding='utf-8')

# 把所有关键词提取出来

wordlist = []

for name in file_list:file_name = file_dir + namefor file in os.listdir(file_name):wcolunm = file_list[name][file]if wcolunm == []:continuefor i in range(len(wcolunm)):word = wcolunm[i][0]try:index = wordlist.index(word)except:wordlist.append(word)

# 构建词向量矩阵

wordMatrix = {}

for word1 in wordlist:wordMatrix[word1] = {}for word2 in wordlist:wordMatrix[word1][word2] = 0

for name in file_list:file_name = file_dir + namefor file in os.listdir(file_name):wcolunm = file_list[name][file]if wcolunm == []:continuefor i in range(len(wcolunm)):word1 = wcolunm[i][0]w1 = wcolunm[i][1]for j in range(len(wcolunm)):word2 = wcolunm[j][0]w2 = wcolunm[j][1]if j == i:wordMatrix[word1][word2] += 1else:wordMatrix[word1][word2] += w1*w2

saveResult(wordMatrix, 'wordMatrix.pkl')

print('保存成功!')

绘图部分代码

import networkx as nx

import matplotlib.pyplot as plt

import pickle

from pylab import mpl

mpl.rcParams['font.sans-serif'] = ['SimHei'] # 在plt中显示中文字符

def loadResult(savePath): # 提取函数with open(savePath, 'rb') as f:return pickle.load(f)

wordMatrix = loadResult('wordMatrix.pkl')

gList = []

for word1 in wordMatrix:for word2 in wordMatrix:if word1 != word2 and wordMatrix[word1][word2] > 0:gList.append((word1, word2, wordMatrix[word1][word2]))

G = nx.Graph()

G.add_weighted_edges_from(gList)

nx.draw(G, with_labels=True)

plt.show()

公众号近期推荐阅读:

GAN整整6年了!是时候要来捋捋了!

数百篇GAN论文已下载好!搭配一份生成对抗网络最新综述!

有点夸张、有点扭曲!速览这些GAN如何夸张漫画化人脸!

天降斯雨,于我却无!GAN用于去雨如何?

脸部转正!GAN能否让侧颜杀手、小猪佩奇真容无处遁形?

容颜渐失!GAN来预测?

弱水三千,只取你标!AL(主动学习)结合GAN如何?

异常检测,GAN如何gan ?

虚拟换衣!速览这几篇最新论文咋做的!

脸部妆容迁移!速览几篇用GAN来做的论文

【1】GAN在医学图像上的生成,今如何?

01-GAN公式简明原理之铁甲小宝篇

更多分享、长按关注本公众号: