最近在写一些算法题,有很多的List<List这种编写,想着能否自定义一下快捷键

直接在写代码输入:lli,即可看见提示

idea新增java快捷键代码片段

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如若转载,请注明出处:http://www.rhkb.cn/news/5901.html

如若内容造成侵权/违法违规/事实不符,请联系长河编程网进行投诉反馈email:809451989@qq.com,一经查实,立即删除!相关文章

vim练级攻略(精简版)

vim推荐配置:

curl -sLf https://gitee.com/HGtz2222/VimForCpp/raw/master/install.sh -o ./install.sh && bash ./install.sh

0. 规定 Ctrl-λ 等价于 <C-λ> :command 等价于 :command <回车> n 等价于 数字 blank字符 等价于 空格,tab&am…

鸿蒙参考文档和问题记录

本文用于记录鸿蒙使用过程中的问题和相关参考文档

问题记录 1. 兼容性测试套件问题 ActsStartAbilityForResultNoTargetBundleListStageTest套件测试失败:模块FreeInstall 技术资料

1. HarmonyOS应用如何打包HAP并安装到真机

HarmonyOS应用如何打包HAP并安装到真…

NewStar CTF week1 web wp

谢谢皮蛋

做这题之前需要先去学习一些数据库的知识

1 order by 2 1可以理解为输入的id,是一个占位符,按第二列排序用来测试列数,如果没有两列则会报错-1 union select 1,2 -1同样是占位符,union的作用是将注入语句合并到原始语句…

登录认证(4):令牌技术:JWT令牌

如上文所说(登录认证(1):登录的基本逻辑及实现思路登录),因为 HTTP协议是无状态的协议,我们需要使用会话跟踪技术实现同一会话中不同请求之间的数据共享,但Cookie技术和Session技术都…

2025.1.20——二、buuctf BUU UPLOAD COURSE 1 1 文件上传

题目来源:buuctf BUU UPLOAD COURSE 1 1

目录

一、打开靶机,查看信息

二、解题思路

step 1:上传一句话木马.php文件康康回显

step 2:蚁剑连接

三、小结 一、打开靶机,查看信息 这里提示到了文件会被上传到./uplo…

【玩转全栈】----Django制作部门管理页面

目录 大致效果 BootStrap BootStrap简介 BootStrap配置 BootStrap使用 基本配置 部分代码解释及注意: 用户编辑: 新添数据: 删除数据: 大致效果 我先给个大致效果,基本融合了Django、Bootstrap、css、html等等。 基于D…

新年好(Dijkstra+dfs/全排列)

1135. 新年好 - AcWing题库 思路: 1.先预处理出1,a,b,c,d,e到其他点的单源最短路,也就是进行6次Dijkstra 2.计算以1为起点的这6个数的全排列,哪种排列方式所得距离最小,也可以使用dfs

1.Dijkstradfs #define int long longusing …

Golang之Context详解

引言

之前对context的了解比较浅薄,只知道它是用来传递上下文信息的对象;

对于Context本身的存储、类型认识比较少。

最近又正好在业务代码中发现一种用法:在每个协程中都会复制一份新的局部context对象,想探究下这种写法在性能…

AIGC浪潮下,图文内容社区数据指标体系如何构建?

文章目录 01 案例:以图文内容社区为例实践数据指标体构建02 4个步骤实现数据指标体系构建1. 明确业务目标,梳理北极星指标2. 梳理业务流程,明确过程指标3. 指标下钻分级,构建多层级数据指标体系4. 添加分析维度,构建完…

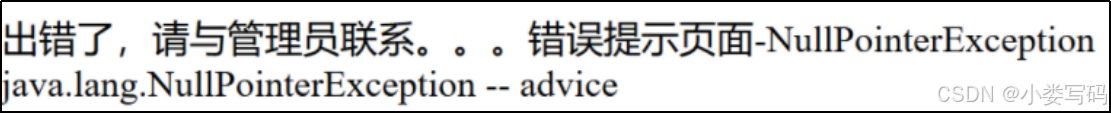

SpringBoot项目中的异常处理

定义错误页面

SpringBoot 默认的处理异常的机制:SpringBoot 默认的已经提供了一套处理异常的机制。一旦程序中出现了异常 SpringBoot 会像/error 的 url 发送请求。在 springBoot 中提供了一个叫 BasicExceptionController 来处理/error 请求,然后跳转到…

《安富莱嵌入式周报》第349期:VSCode正式支持Matlab调试,DIY录音室级麦克风,开源流体吊坠,物联网在军工领域的应用,Unicode字符压缩解压

周报汇总地址:嵌入式周报 - uCOS & uCGUI & emWin & embOS & TouchGFX & ThreadX - 硬汉嵌入式论坛 - Powered by Discuz! 视频版:

《安富莱嵌入式周报》第349期:VSCode正式支持Matlab调试,DIY录音室级麦克风…

C++priority_queue模拟实现

Cpriority_queue模拟实现 1.priority_queue基本概念2.priority_queue基本结构3.size()成员函数4.empty()成员函数5.top()成员函数6.push()成员函数7.pop()成员函数8.构造函数9.完整代码 🌟🌟hello,各位读者大大们你们好呀🌟&#…

[STM32 HAL库]串口中断编程思路

一、前言

最近在准备蓝桥杯比赛(嵌入式赛道),研究了以下串口空闲中断DMA接收不定长的数据,感觉这个方法的接收效率很高,十分好用。方法配置都成功了,但是有一个点需要进行考虑,就是一般我们需要…

我的图形布局 组织结构图布局

组织结构图布局,有的人也叫它树状布局,在图形中是经常用到的布局算法.形成类似如下图的图形布局方式 首先创建一个类,

public class TreeLayouter

{private int m_space 40;/// <summary>/// 空间间隔/// </summary>public int Space{get { return m_space; }se…

计算机网络介质访问控制全攻略:从信道划分到协议详解!!!

一、信道划分介质访问控制 介质访问控制:多个节点共享同一个“总线型”广播信道时,可能发生“信号冲突” 应该怎么控制各节点对传输介质的访问,才能减少冲突,甚至避免冲突? 时分复用(TDM) 时分复用:将时间分为等长的“…

计算机组成原理——数据表示(二)

当生活的压力和困惑缠绕在身边,我们往往需要振奋精神,勇往直前。无论在何种困境中,我们都要保持积极的态度和坚定的信念。将悲观的情绪抛之脑后,展现出坚强的意志力和无尽的活力。振奋精神意味着我们要战胜自己内心的负面情绪&…

推荐文章

- vi 是 Unix 和 Linux 系统中常用的文本编辑器

- (学习总结23)Linux 目录、通配符、重定向、管道、shell、权限与粘滞位

- [leetcode·回溯算法]回溯算法解题套路框架

- [实现Rpc] 客户端划分 | 框架设计 | common类的实现

- [央企大赛 2025] pwn

- “““【运用 R 语言里的“predict”函数针对 Cox 模型展开新数据的预测以及推理。】“““

- 《AI赋能鸿蒙Next,开启智能关卡设计新时代》

- 「 机器人 」利用数据驱动模型替代仿真器:加速策略训练并降低硬件依赖

- 【22】Word:小李-高新技术企业政策❗

- 【AI大模型】Ubuntu18.04安装deepseek-r1模型+服务器部署+内网访问

- 【deepseek实战】绿色好用,不断网

- 【DeepSeek系列专栏大纲:深入探索与实践深度学习】

![[STM32 HAL库]串口中断编程思路](https://i-blog.csdnimg.cn/direct/ba213c238ce947eb8264d9b05f2e9797.png)