在这个追求高清画质的时代,我们对渣画质的容忍度越来越低。在网络上搜索「低分辨率」、「渣画质」,会看到一大片诸如「如何补救清晰度低的照片」、「如何拯救渣画质」之类的问题。那么,将渣到马赛克级别的画面秒变高清,是一种怎样的体验?新AI 算法告诉你。

杜克大学研究人员开发了一种新的人工智能工具,称之为 PULSE(Photo Upsampling via Latent Space Exploration,通过潜在空间探索的照片上采样),这款工具可以将模糊的、无法识别的人脸图像经由计算机生成高清晰度肖像,细节更加精细。

以前的方法可以把人脸图像放大到原始分辨率的8倍,但是杜克大学团队想出了新的方法,利用少量像素即可创造出分辨率高达原始64倍的逼真面孔,合理填补出原本不存在的细纹,睫毛和须发等特征。

他们的 AI 工具会「想象」出一些原本不存在的特征,即使是原本 LR 照片中无法看到的细节,比如毛孔、细纹、睫毛、头发和胡茬等,经过其算法处理后,都能看得一清二楚。

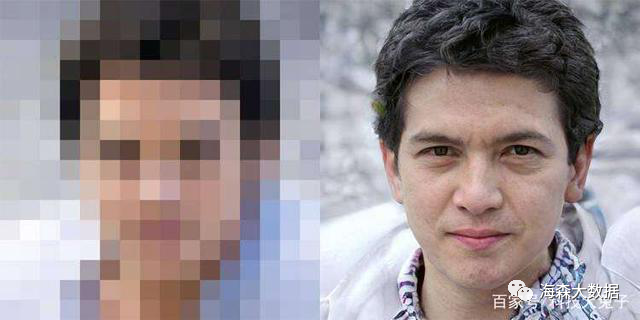

来看一个具体示例:

领导该团队的杜克大学计算机科学家辛西娅·鲁丁(Cynthia Rudin)说:「以前从来没有像现在这样,能用这么少的像素,就创造出拥有大量细节的超分辨率图像。」

在实际应用方向上,论文的共同作者 Sachit Menon 介绍称:「在这些研究中,我们只是用面部作为概念验证。

但从理论上讲,该技术是通用的,从医学、显微镜学到天文学和卫星图像,都可以通过该技术改善画质。」

打破传统操作,实现最佳效果

传统方法是在获取一幅低分辨率图像后,通过尝试使它们与计算机以前看到的高分辨率图像中的相应像素平均匹配来“猜测”需要额外的像素。由于这种平均匹配,头发和皮肤中的纹理区域可能无法从一个像素到下一个像素完美地排列,最终看起来模糊而且失真。

因此,杜克大学的研究小组想出了不同的方法,这套系统不会先获取一张低分辨率图像然后慢慢增加细节,而是会破坏人工智能生成的高分辨人像样本,在缩小到相同大小之后,尽可能寻找与输入图像相似的面孔。

研究团队主要使用了“生成式对抗网络”这种机器学习工具,这是近年来复杂分布上无监督学习最具前景的方法之一。模型通过框架中(至少)两个模块:生成模型(Generative Model)和判别模型(Discriminative Model)的互相博弈学习产生相当好的输出结果。简单来说就是一组算法产生一张图像,另外一组算法来判断这种图像是真还是假。如果判定为假,算法就会重新生成图片,一旦判定为真,开发人员就会检查结果,以确定算法是否需要调整。

这套系统可以在几秒钟内将一张16*16像素的人脸照片转换成1024*1024分辨率的图像,低分辨率图像中晚期无法辨认的细节,在新的版本中都变得清晰可见。