Kafka系列之:记录一次Kafka Topic分区扩容,但是下游flink消费者没有自动消费新的分区的解决方法

- 一、背景

- 二、解决方法

- 三、实现自动发现新的分区

一、背景

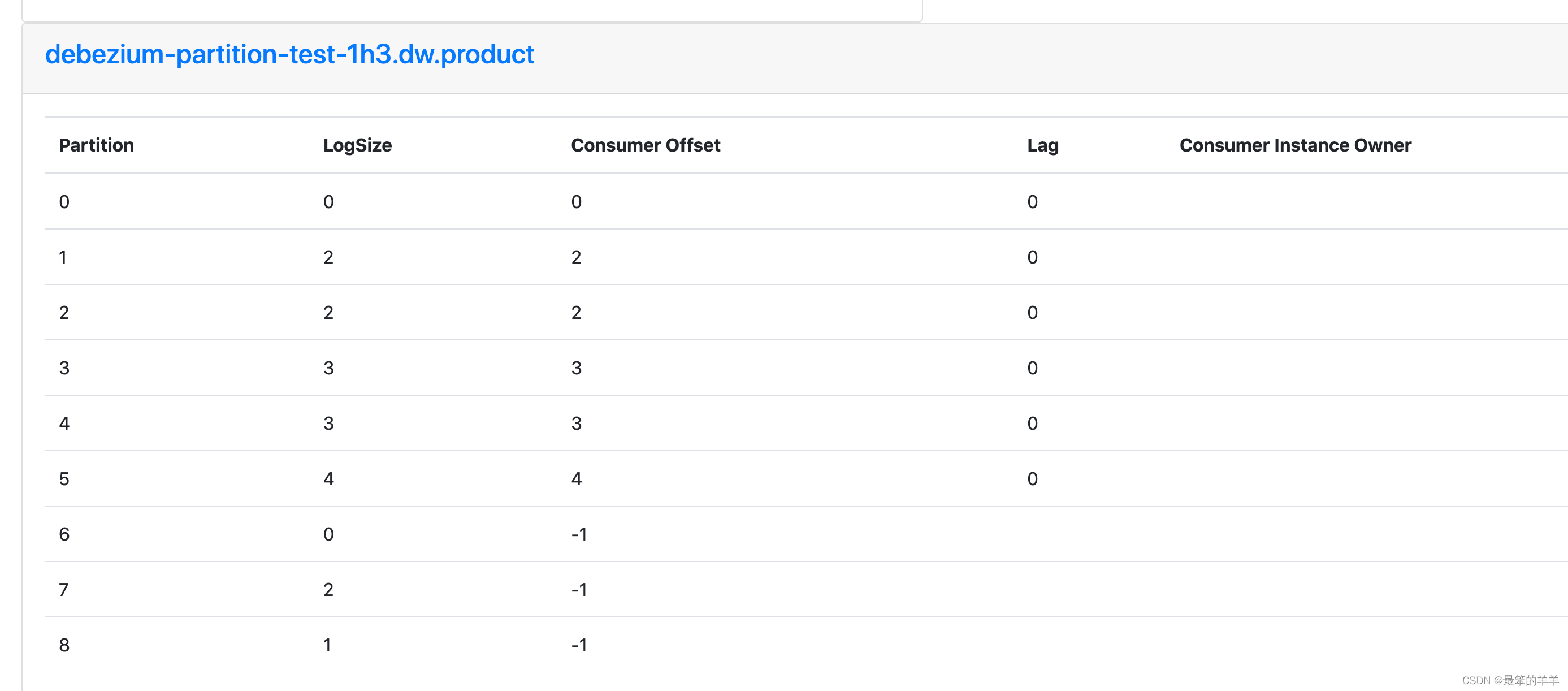

- 生产环境Kafka集群压力大,Topic读写压力大,消费的lag比较大,因此通过扩容Topic的分区,增大Topic的读写性能

- 理论上下游消费者应该能够自动消费到新的分区,例如flume消费到了新的分区,但是实际情况是存在flink消费者没有消费到新的分区

二、解决方法

出现无法消费topic新的分区这种情况,最简单的解决方法是

- 重启flink消费者程序

三、实现自动发现新的分区

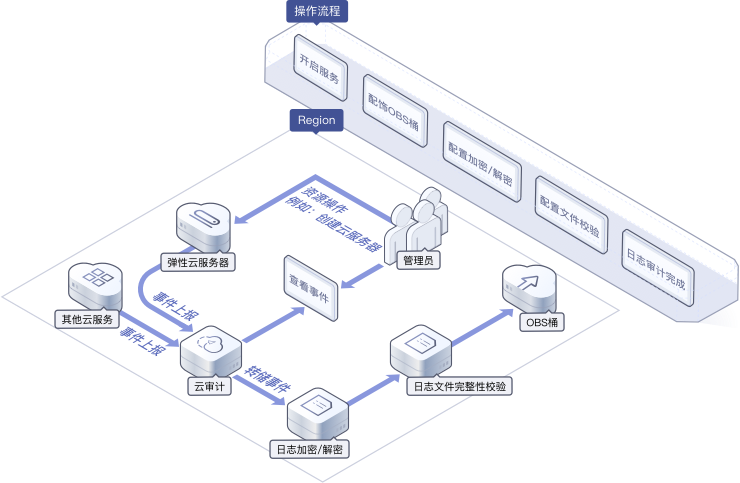

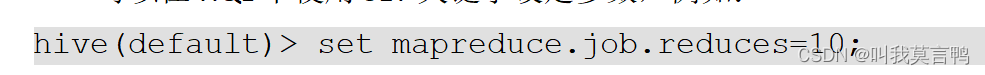

flink程序增加自动发现分区参数:

- flink.partition-discovery.interval-millis是一个配置属性,用于设置Flink作业中的分区发现间隔时间(以毫秒为单位)。

- 在Flink作业中,数据源(例如Kafka或文件系统)的分区可能会发生变化。为了及时感知分区的变化情况,并根据变化进行相应的处理,Flink提供了分区发现机制。

- f

![[Flask]SSTI1](https://img-blog.csdnimg.cn/66adca4e15724872b6c2185a4acbc41e.png)