Llama 2 with langchain项目详解(一)

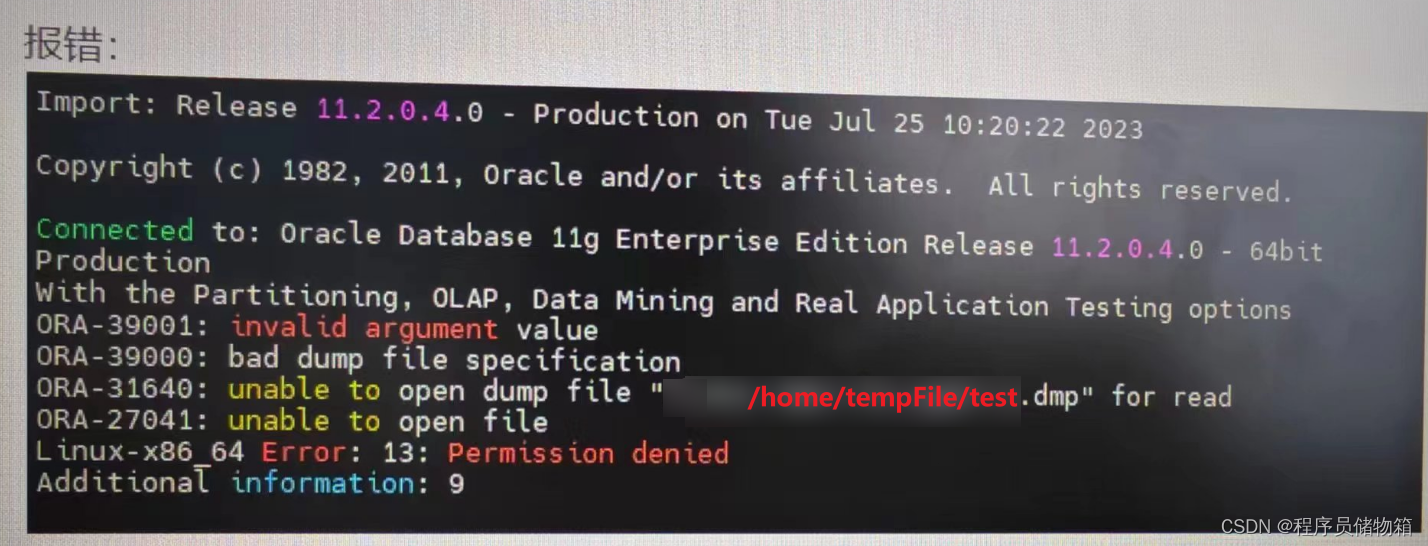

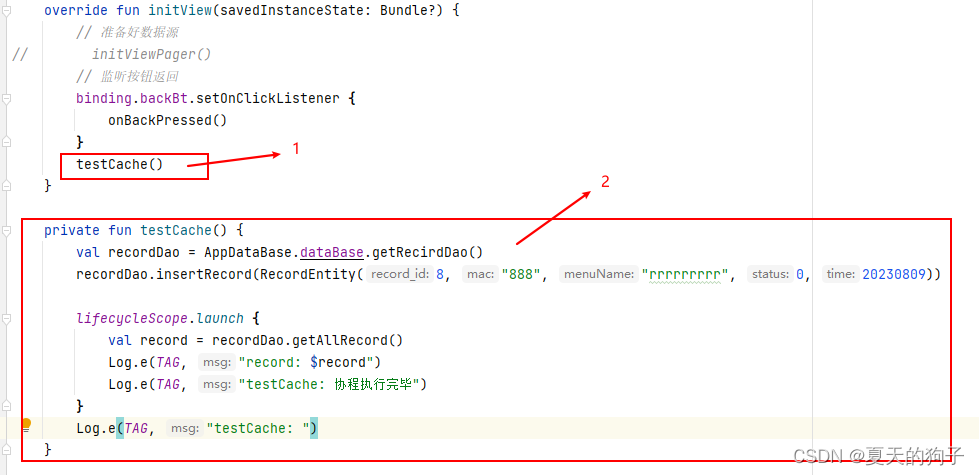

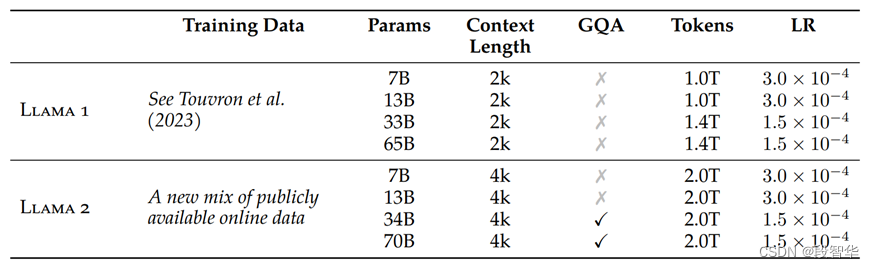

2023年2月25日,美国Meta公司发布了Llama 1开源大模型。随后,于2023年7月18日,Meta公司发布了Llama 2开源大模型,该系列包括了70亿、130亿和700亿等不同参数规模的模型。相较于Llama 1,Llama 2的训练数据增加了40%,上下文长度提升至4096,是Llama 1的两倍,并且引入了分组查询注意力机制。具体而言,Llama 2大模型在2万亿个标记上进行了训练,并使用了100万个人类标注的数据进行微调,如图17-1所示。

图17- 1 Llama 2模型和Llama 1模型的比较

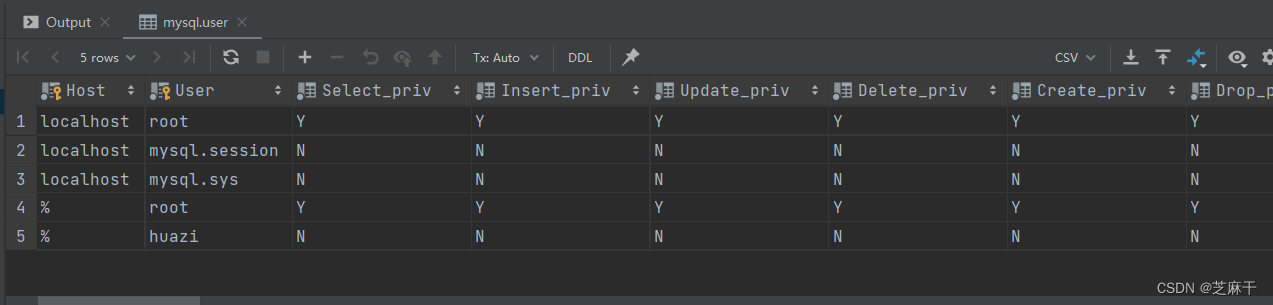

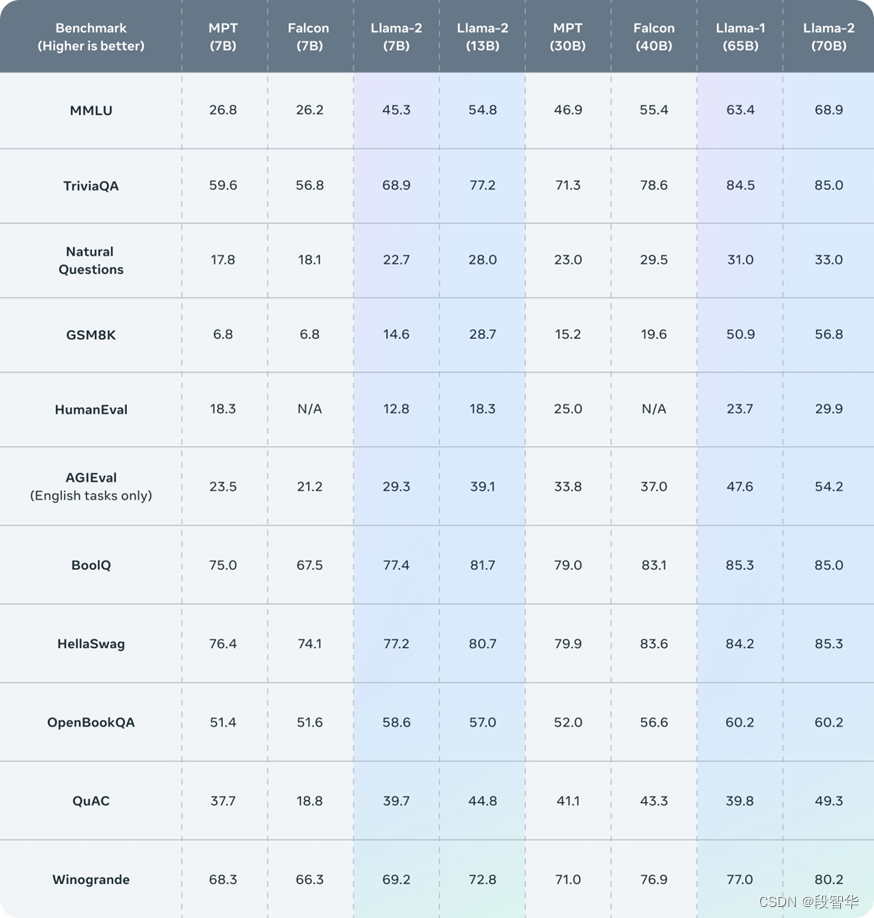

据测评结果显示,Llama 2在包括推理、编码、知识测试等许多外部基准测试中都优于其他开源语言模型,如图17-2所示。Gavin大咖微信:NLP_Matrix_Space

图17- 2 Llama 2基准测试比较

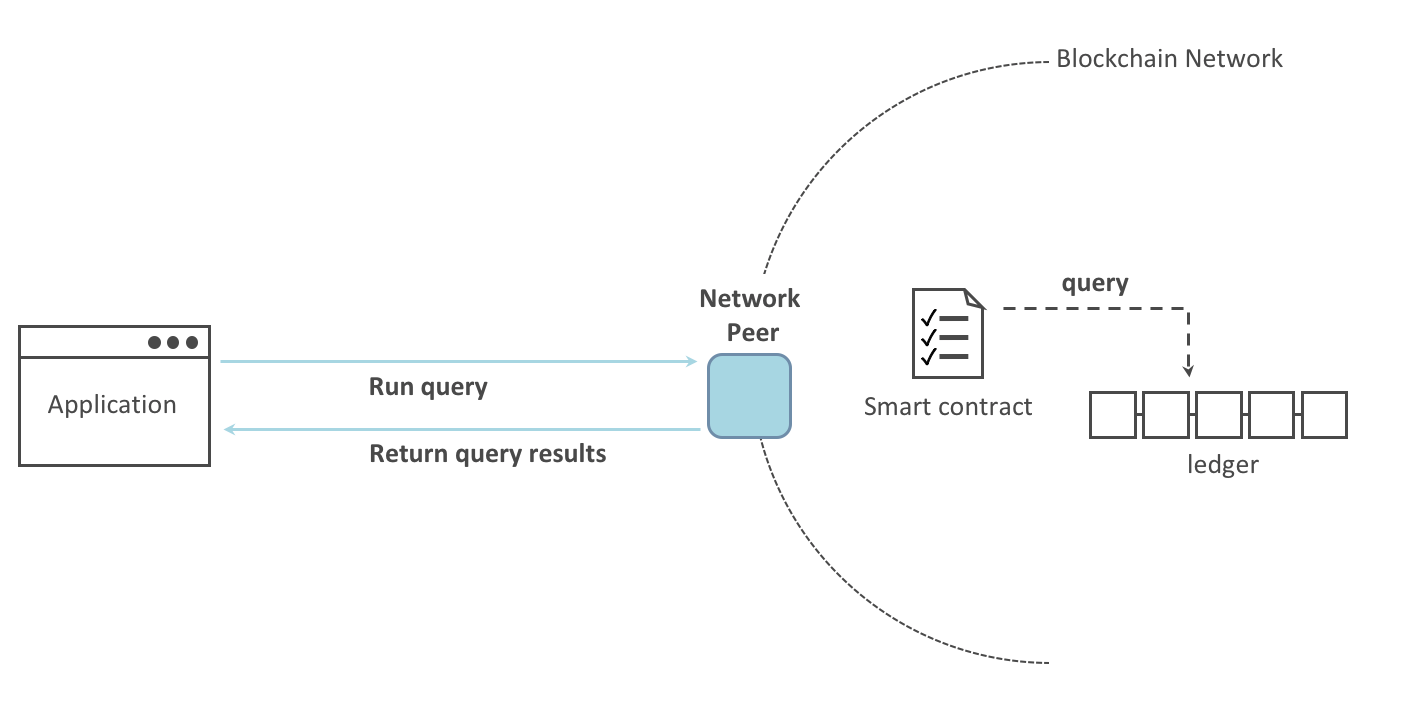

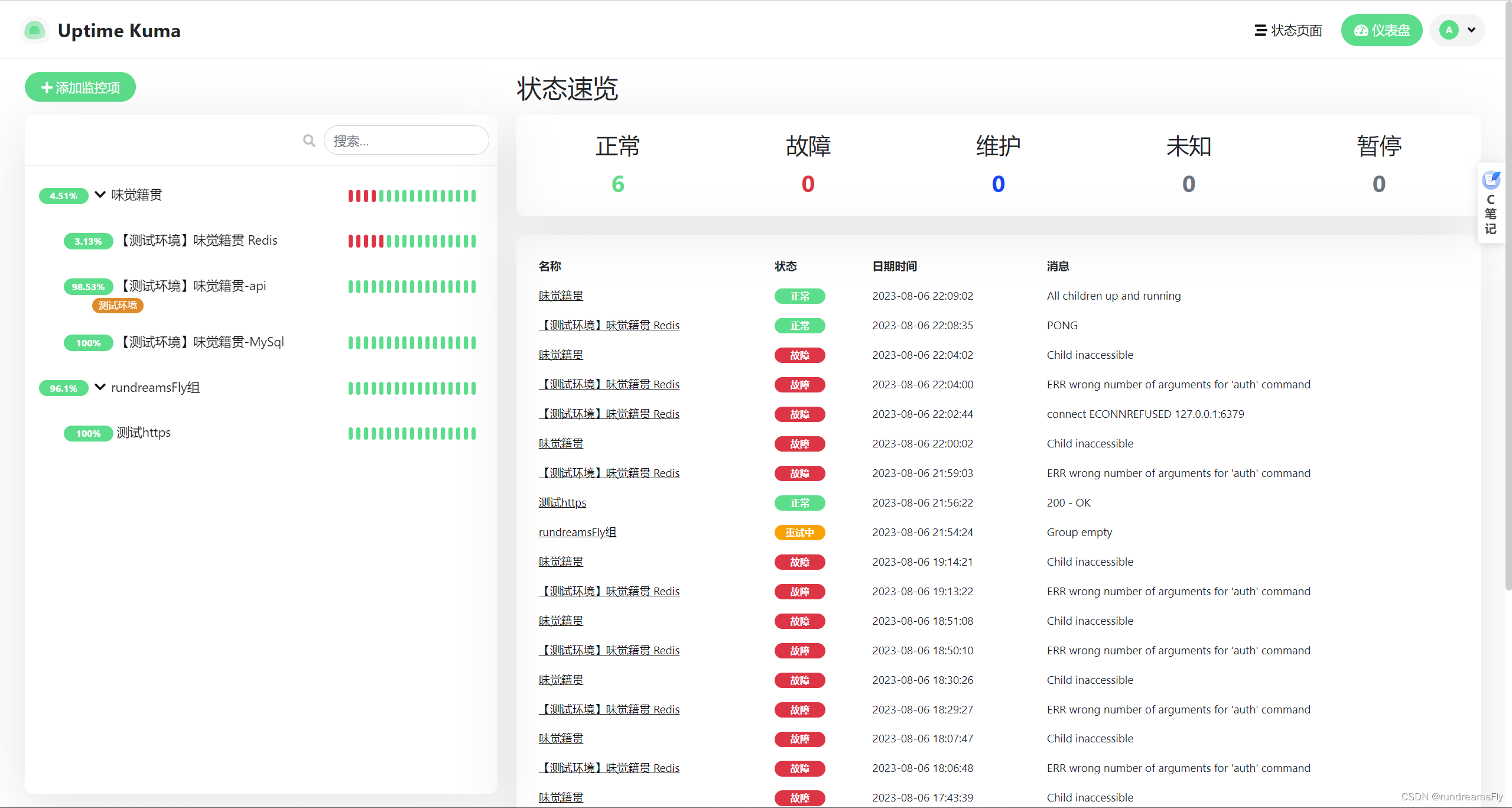

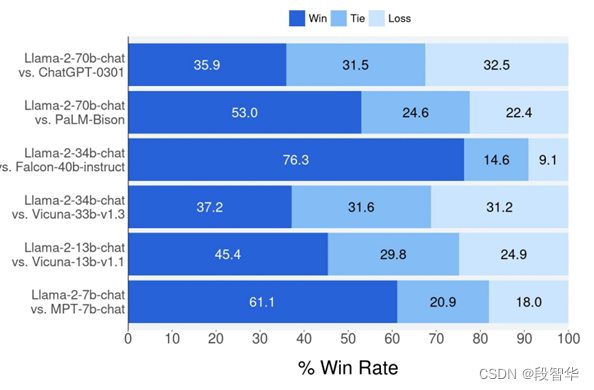

如图17-3所示,Llama 2在与同等参数量级的大模型进行比较时,在大多数情况下都取得了胜利。Gavin大咖微信:NLP_Matrix_Space

图17- 3 Llama 2与同等参数量级的大模型进行比较

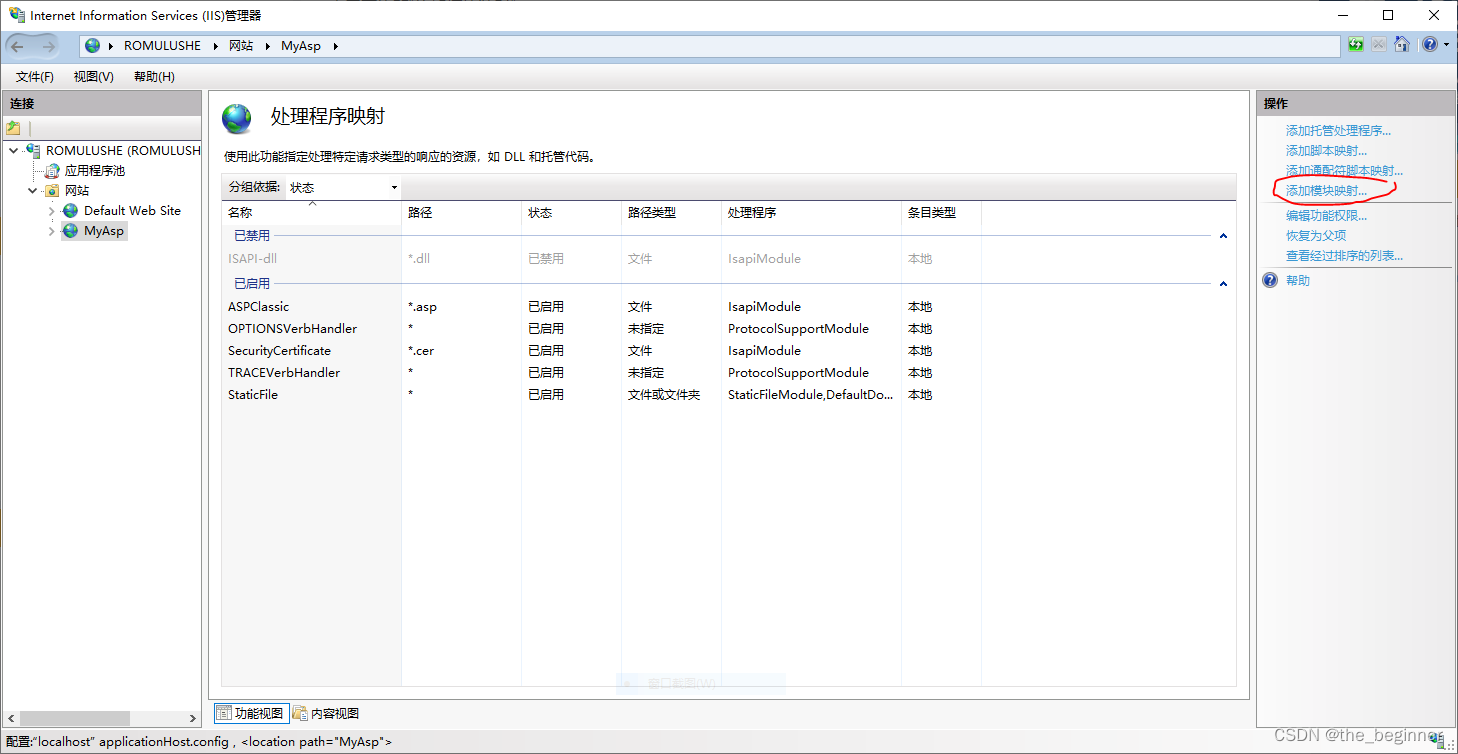

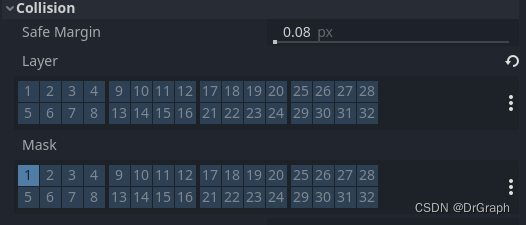

如图17-4所示&