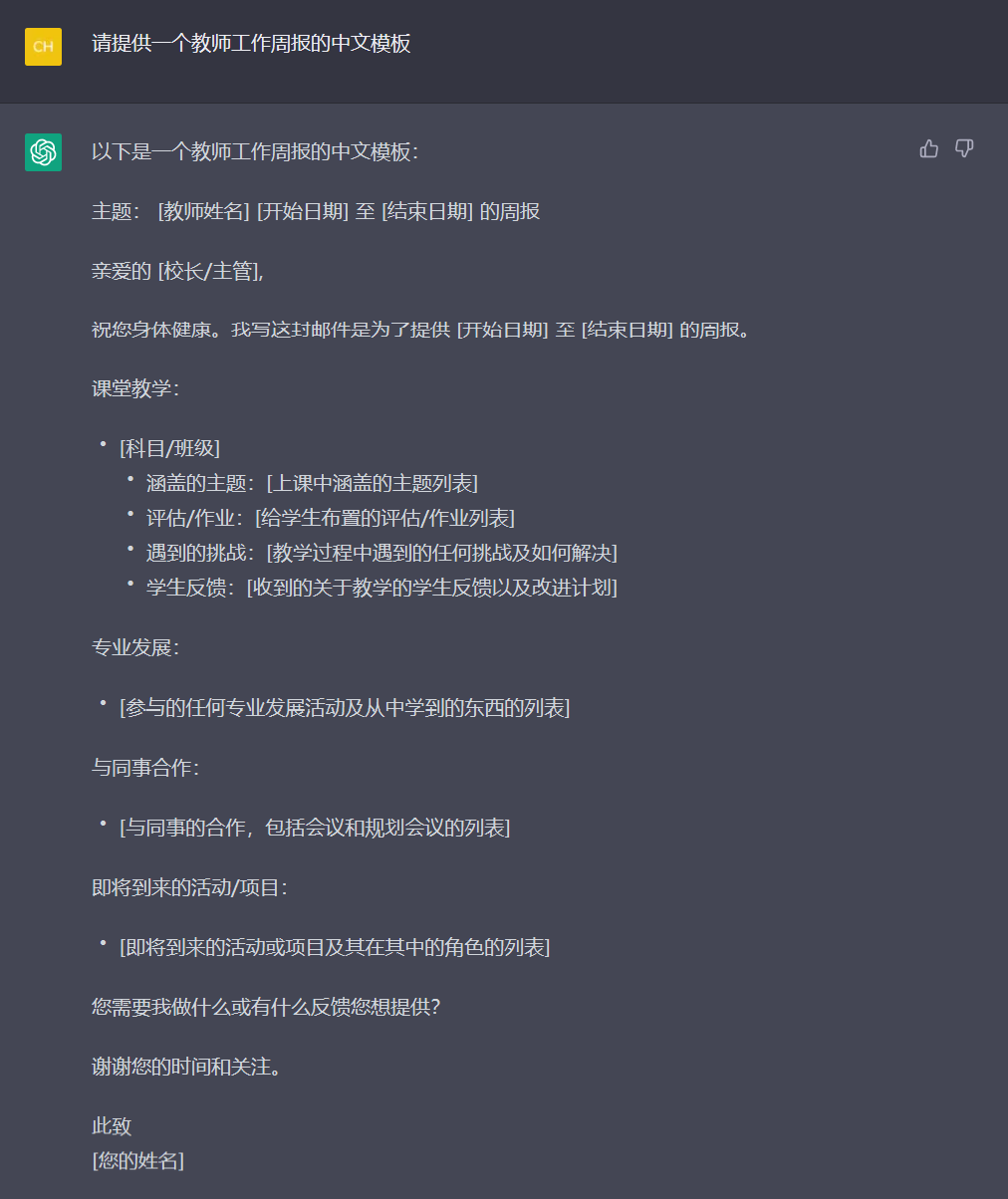

💗wei_shuo的个人主页

💫wei_shuo的学习社区

🌐Hello World !

ChatGPT无限可能性:自然语言生成的奥秘

数字化时代:跨越语言和文化障碍

冰岛是北大西洋中部的一个岛国,拥有充满活力的科技产业和蓬勃发展的旅游业。然而,虽然其大约 370,000 名公民中的大多数人会说英语或其他第二语言,但它与美国和欧洲的融合使该国的母语冰岛语处于危险之中。如今,人们越来越担心,在几代人之后,如果面对快速数字化,冰岛语不能继续作为该国的默认语言,该语言可能面临事实上的灭绝;该国总统 HE Guðni Th 的倡议下。Jóhannesson 和私营企业的帮助下,冰岛与 OpenAI 合作,使用 GPT-4 保护冰岛语——并将防御地位转化为创新机会

数字化时代:改变视觉可访问性

自 2012 年以来,Be My Eyes 一直在为超过 2.5 亿盲人或低视力人群创造技术。这家丹麦初创公司将盲人或视力低下的人与志愿者联系起来,以帮助他们完成数百项日常生活任务,例如识别产品或在机场导航;借助 GPT-4 的新视觉输入功能(在研究预览中),Be My Eyes 开始在 Be My Eyes 应用程序中开发 GPT-4 驱动的 Virtual Volunteer™,它可以产生与人类志愿者相同水平的背景和理解;GPT-4 与其他语言和机器学习模型之间的区别在于对话的能力以及该技术提供的更大程度的分析能力

数字化时代:知识库构建

借助 OpenAI 的 GPT-4,摩根士丹利正在改变其财富管理人员查找相关信息的方式;从去年开始,该公司开始探索如何利用 GPT 的嵌入和检索功能来利用其智力资本——首先是 GPT-3,现在是 GPT-4。该模型将为面向内部的聊天机器人提供支持,该机器人可以全面搜索财富管理内容;OpenAI 可能是迄今为止通过人类建议和技术的结合赋予摩根士丹利权力的最好例子——这是我们完全致力于的事情

数字化时代:视频创作

用于制作快速、高质量商业广告的简单工具;Waymark 正在完善其易于使用的视频创作平台。GPT-3 帮助他们始终如一地制作更强大、更相关的脚本;Waymark 创始人 Nathan Labenz 从未满足于基于规则的脚本编写功能的局限性,多年来一直在寻找更好的解决方案。“我们的超级用户花太多时间编辑脚本,而其他用户会完全放弃。我致力于写出正确的剧本,但这是一个巨大的挑战,”Labenz 说。“在过去的五年里,我尝试了所有可用的人工智能产品,但在 GPT-3 之前,没有发现任何可以有效总结企业在线足迹的产品,更不用说编写有效的营销文案了”

ChatGPT技术实现

- 深度学习技术:Transformer架构作为基础模型,通过多层堆叠的自注意力机制和前向神经网络,实现了对文本序列的高效编码和解码

- 预训练和微调:大规模文本数据上进行预训练,使其具备对自然语言的深刻理解。微调则是指在特定任务上对预训练模型进行微调,适应该任务的需求。ChatGPT通过微调来适应不同的对话场景,进一步提高了其对话质量

- 自适应学习率:自适应学习率的方法,根据当前的梯度大小和历史的梯度变化情况,动态地调整学习率的大小。这种技术可以有效地防止梯度爆炸或消失的问题,从而提高模型的收敛速度和性能

- 分布式训练和推理:通过分布式训练,能够高效地训练大规模的语言模型。推理则是指使用已经训练好的模型进行新数据的预测或生成。ChatGPT通过分布式推理的方式,能够快速生成高质量的自然语言对话

- 自注意力机制:自注意力机制是Transformer架构中的核心技术,它能够对输入序列的不同部分进行加权处理,从而更好地捕捉语义信息

- 上下文处理:ChatGPT能够对上下文信息进行处理,即生成回复时考虑之前的对话内容,从而生成更加连贯对话

深度学习

- 神经元实现示例代码:

import numpy as np# 定义神经元类 class Neuron:def __init__(self, input_size):# 随机初始化权重和偏差self.weights = np.random.randn(input_size)self.bias = np.random.randn()# 前向传播def forward(self, inputs):# 加权计算并通过sigmoid函数进行非线性变换z = np.dot(inputs, self.weights) + self.biasa = 1 / (1 + np.exp(-z))return a# 创建一个2个输入的神经元 neuron = Neuron(2)# 进行前向传播 inputs = np.array([1, 2]) output = neuron.forward(inputs) print(output)

- 反向传播实现示例代码:

import numpy as np# 定义神经元类 class Neuron:def __init__(self, input_size):# 随机初始化权重和偏差self.weights = np.random.randn(input_size)self.bias = np.random.randn()# 前向传播def forward(self, inputs):# 加权计算并通过sigmoid函数进行非线性变换z = np.dot(inputs, self.weights) + self.biasa = 1 / (1 + np.exp(-z))return a# 反向传播def backward(self, inputs, output, target):# 计算误差error = target - output# 计算权重和偏差的梯度d_weights = inputs * output * (1 - output) * errord_bias = output * (1 - output) * error# 更新权重和偏差self.weights += d_weightsself.bias += d_bias# 创建一个2个输入的神经元 neuron = Neuron(2)# 进行前向传播并计算误差 inputs = np.array([1, 2]) output = neuron.forward(inputs) target = 0.5 error = target - output# 进行反向传播并更新权重和偏差 neuron.backward(inputs, output, target) print(neuron.weights, neuron.bias)

- 卷积神经网络实现示例代码:

import tensorflow as tf# 加载MNIST数据集 mnist = tf.keras.datasets.mnist (x_train, y_train), (x_test, y_test) = mnist.load_data()# 对数据进行预处理 x_train = x_train.reshape(x_train.shape[0], 28, 28, 1) x_test = x_test.reshape(x_test.shape[0], 28, 28, 1) x_train, x_test = x_train / 255.0, x_test / 255.0# 定义模型 model = tf.keras.models.Sequential([tf.keras.layers.Conv2D(32, (3, 3), activation='relu', input_shape=(28, 28, 1)),tf.keras.layers.MaxPooling2D((2, 2)),tf.keras.layers.Flatten(),tf.keras.layers.Dense(

分布式训练和推理

- 分布式训练示例代码:

import torch import torch.distributed as dist import torch.nn as nn import torch.optim as optim import torch.multiprocessing as mp# 定义模型 class Model(nn.Module):def __init__(self):super(Model, self).__init__()self.fc1 = nn.Linear(10, 5)self.fc2 = nn.Linear(5, 2)def forward(self, x):x = self.fc1(x)x = torch.relu(x)x = self.fc2(x)x = torch.softmax(x, dim=1)return x# 定义训练函数 def train(rank, world_size):# 初始化进程组dist.init_process_group('gloo', rank=rank, world_size=world_size)# 加载数据并将其划分为本地批次data = torch.randn(100, 10)targets = torch.randint(0, 2, (100,))batch_size = 10local_data = [data[i:i+batch_size] for i in range(rank*10, (rank+1)*10)]local_targets = [targets[i:i+batch_size] for i in range(rank*10, (rank+1)*10)]# 构建模型和优化器model = Model()criterion = nn.CrossEntropyLoss()optimizer = optim.SGD(model.parameters(), lr=0.1)# 分布式模型和优化器model = nn.parallel.DistributedDataParallel(model)optimizer = nn.parallel.DistributedDataParallel(optimizer)# 训练模型num_epochs = 10for epoch in range(num_epochs):for i in range(len(local_data)):optimizer.zero_grad()output = model(local_data[i])loss = criterion(output, local_targets[i])loss.backward()optimizer.step()# 关闭进程组dist.destroy_process_group()# 启动多进程训练 if __name__ == '__main__':num_processes = 2mp.spawn(train, args=(num_processes,), nprocs=num_processes, join=True)

- 分布式推理示例代码:

import torch import torch.distributed as dist import torch.nn as nn import torch.optim as optim# 定义模型 class Model(nn.Module):def __init__(self):super(Model, self).__init__()self.fc1 = nn.Linear(10, 5)self.fc2 = nn.Linear(5, 2)def forward(self, x):x = self.fc1(x)x = torch.relu(x)x = self.fc2(x)x = torch.softmax(x, dim=1)return x# 加载数据 data = torch.randn(100, 10)# 初始化进程组 dist.init_process_group('gloo')# 构建模型并加载参数 model = Model() model = nn.parallel.DistributedDataParallel(model) model.load_state_dict(torch.load('model.pt'))# 进行推理 output = model(data) predictions = torch.argmax(output, dim=1)# 关闭进程组 dist.destroy_process_group()

上下文处理

- Python中NLTK库实现上下文处理的示例代码:

import nltk nltk.download('punkt')from nltk.tokenize import word_tokenize# 定义一个上下文处理函数 def context_processing(text, keyword, window_size):# 对文本进行分词tokens = word_tokenize(text.lower())# 寻找关键词在文本中的位置indices = [i for i, token in enumerate(tokens) if token == keyword]# 遍历关键词的位置,获取其前后上下文单词contexts = []for idx in indices:start = max(0, idx - window_size)end = min(len(tokens), idx + window_size + 1)context = tokens[start:idx] + tokens[idx+1:end]contexts.append(context)return contexts# 示例使用 text = "The quick brown fox jumps over the lazy dog." keyword = "fox" window_size = 2contexts = context_processing(text, keyword, window_size) print(contexts) # [['quick', 'brown', 'jumps', 'over'], ['the', 'lazy', 'dog', '.']]

🌼 结语:创作不易,如果觉得博主的文章赏心悦目,还请——

点赞👍收藏⭐️评论📝