预测知识 | 预测技术流程及模型评价

目录

- 预测知识 | 预测技术流程及模型评价

- 技术流程

- 模型评价

- 参考资料

技术流程

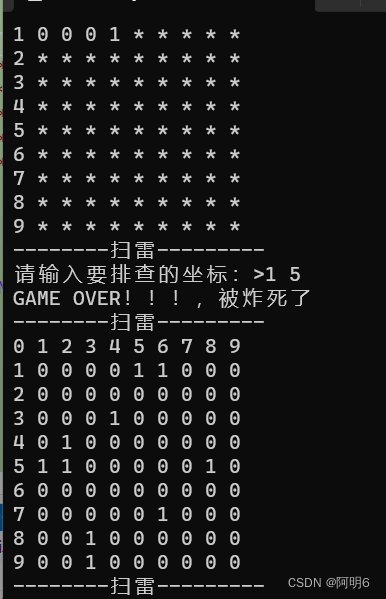

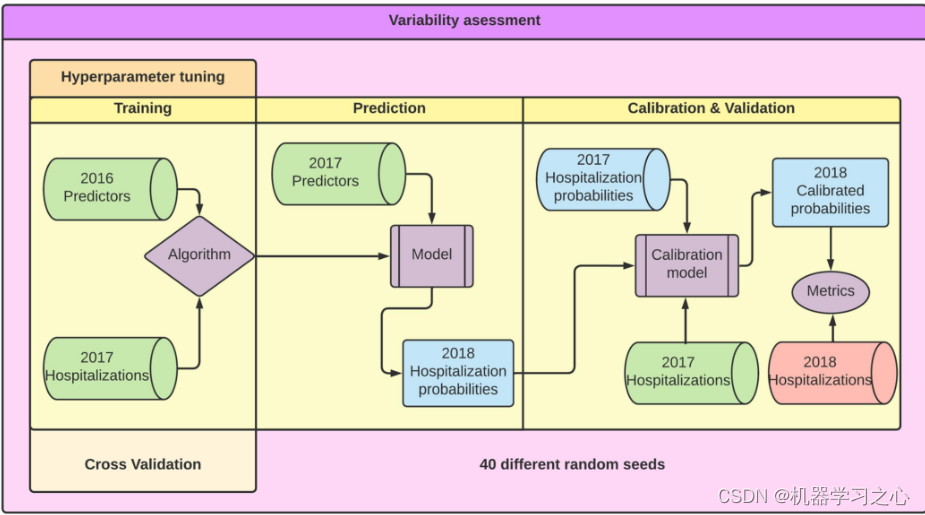

1)模型训练阶段:预测因素和结局,再加上预测模型进行模型拟合;

2)预测阶段:将预测因素代入拟合好的模型,得到预测概率;

3)校准和验证阶段:先做校准,而后做验证。校准是预测概率和真实概率进行的模型再调整,目的是使得预测概率尽可能准确。最后,将校准概率与实际住院概率进行比较,构建混淆矩阵,对模型预测效果进行评价。

模型预测出来的概率可能与真实概率相差甚多,如果任由其不管,那模型应用后会带来很多问题。如果要对其进行处理,概率校准就是最常用的方法,也就是把有偏差的概率重新"拉回"正常值或"靠近"正常值。作者指出,对于树模型(如决策树、随机森林等),其概率一般都偏差较多,即校准度很不好,此时,大多需要进行模型再校准。

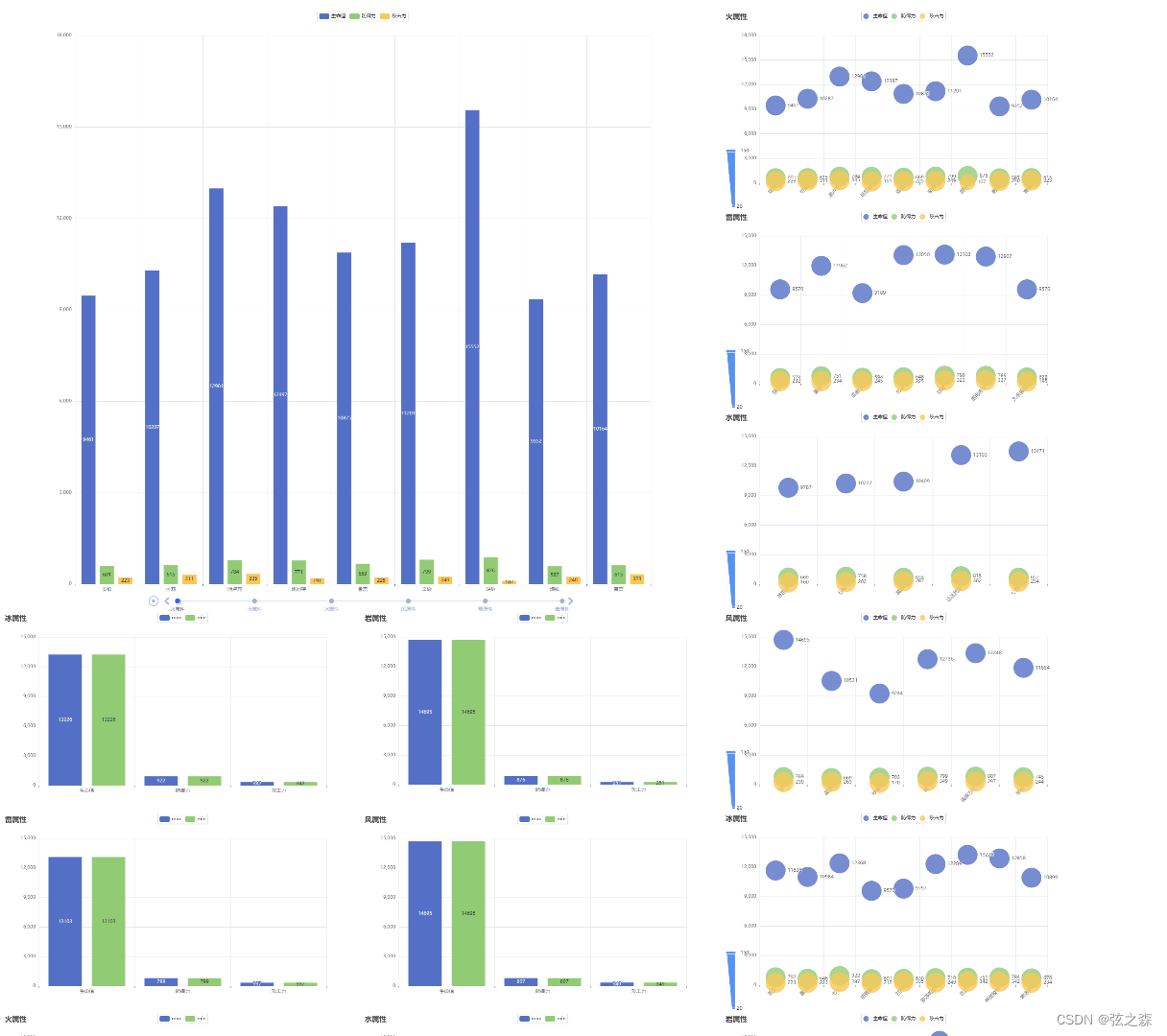

模型评价

在机器学习中,评价指标用于度量模型的性能和准确度。选择适当的评价指标取决于具体的任务和数据类型。以下是一些常见的机器学习评价指标:

准确率(Accuracy):准确率是最常用的评价指标之一,它表示模型正确预测的样本数与总样本数之间的比例。然而,准确率在处理不平衡数据集时可能会失效,因为它没有考虑到不同类别的样本分布。

精确率(Precision)和召回率(Recall):精确率和召回率通常一起使用来对二分类模型进行评估。精确率表示模型预测为正例的样本中实际为正例的比例,召回率表示模型正确预测为正例的样本占所有实际为正例的样本的比例。在某些情况下,我们需要在精确率和召回率之间进行权衡,可以使用F1分数作为综合指标,它是精确率和召回率的调和均值。

ROC曲线和AUC(Receiver Operating Characteristic Curve and Area Under the Curve):ROC曲线通过绘制模型在各个分类阈值下的真阳性率(TPR)和假阳性率(FPR)之间的关系来评估二分类模型的性能。AUC表示ROC曲线下的面积,范围在0到1之间,AUC越接近1,模型性能越好。

均方误差(Mean Squared Error,MSE):均方误差常用于回归问题的评估,计算预测值与实际值之间的平均平方差。较小的MSE值表示模型预测得更准确。

对数损失(Log Loss):对数损失用于评估概率模型的性能,它衡量模型预测的概率分布与实际标签之间的差异。对数损失越小,表示模型的预测越接近实际情况。

对于不平衡预测,模型之间的AUC差异是很小的,不具有区分价值,而PR曲线下面积(AP表示average precision,是计算PR曲线下面积的一种方式)更有助于区分。

参考资料

[1] Reference: Development and validation of predictive models for unplanned hospitalization in the Basque Country: analyzing the variability of non-deterministic algorithms