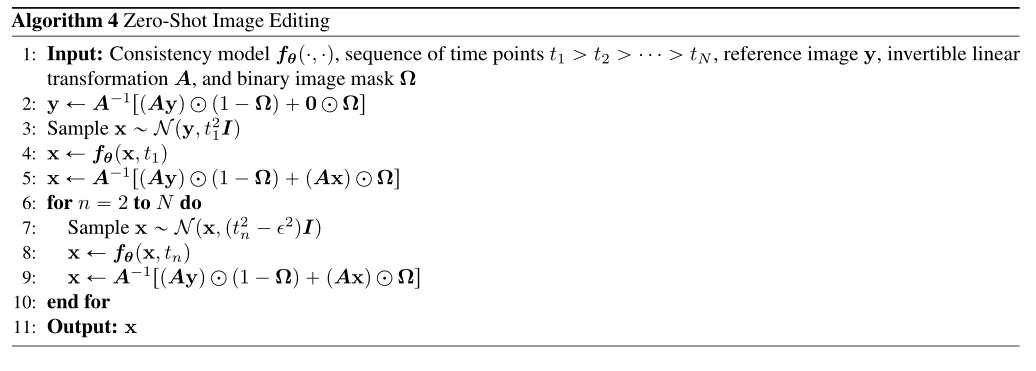

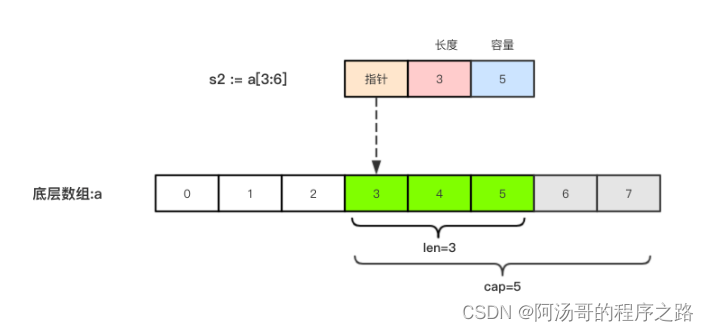

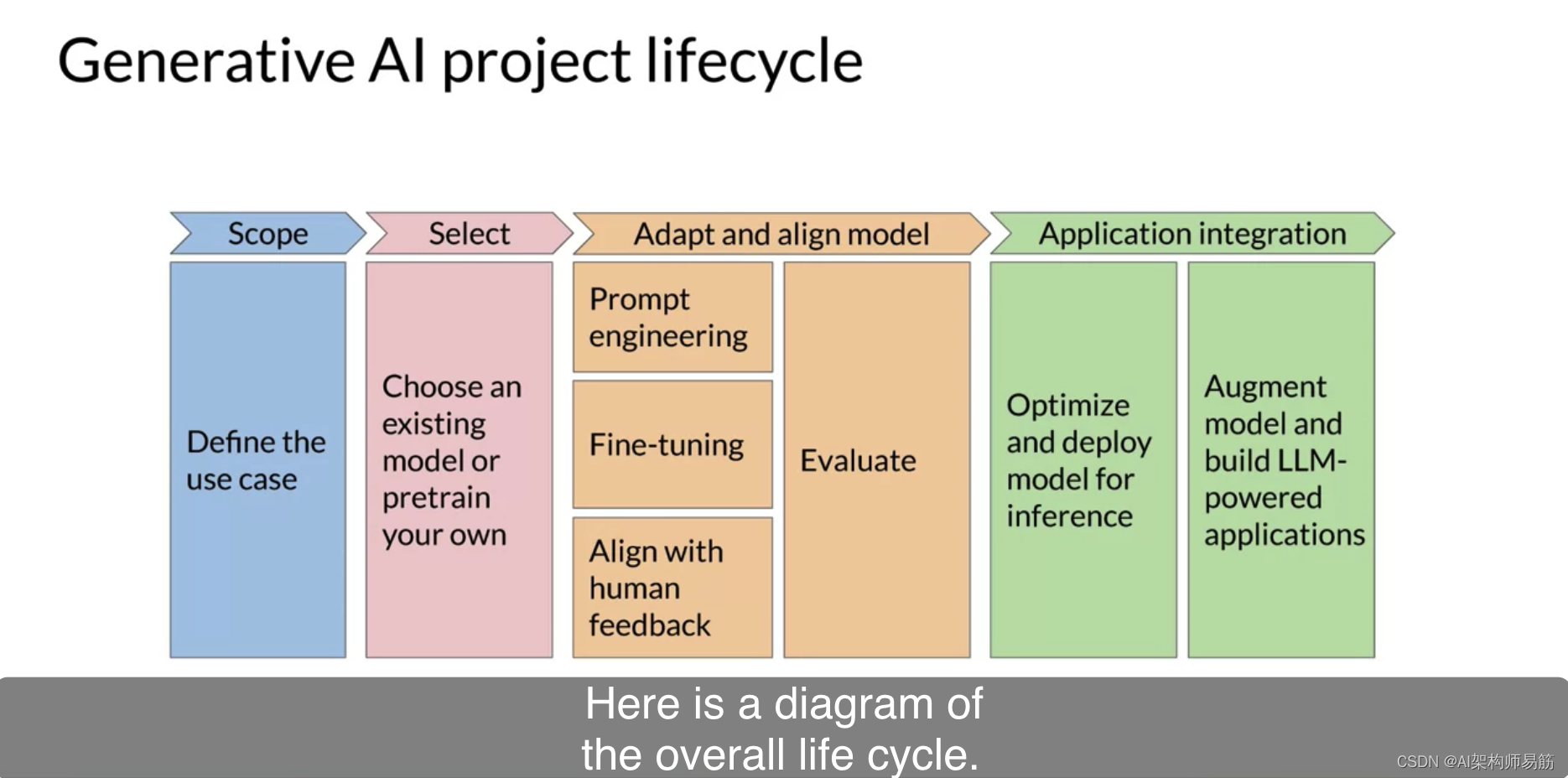

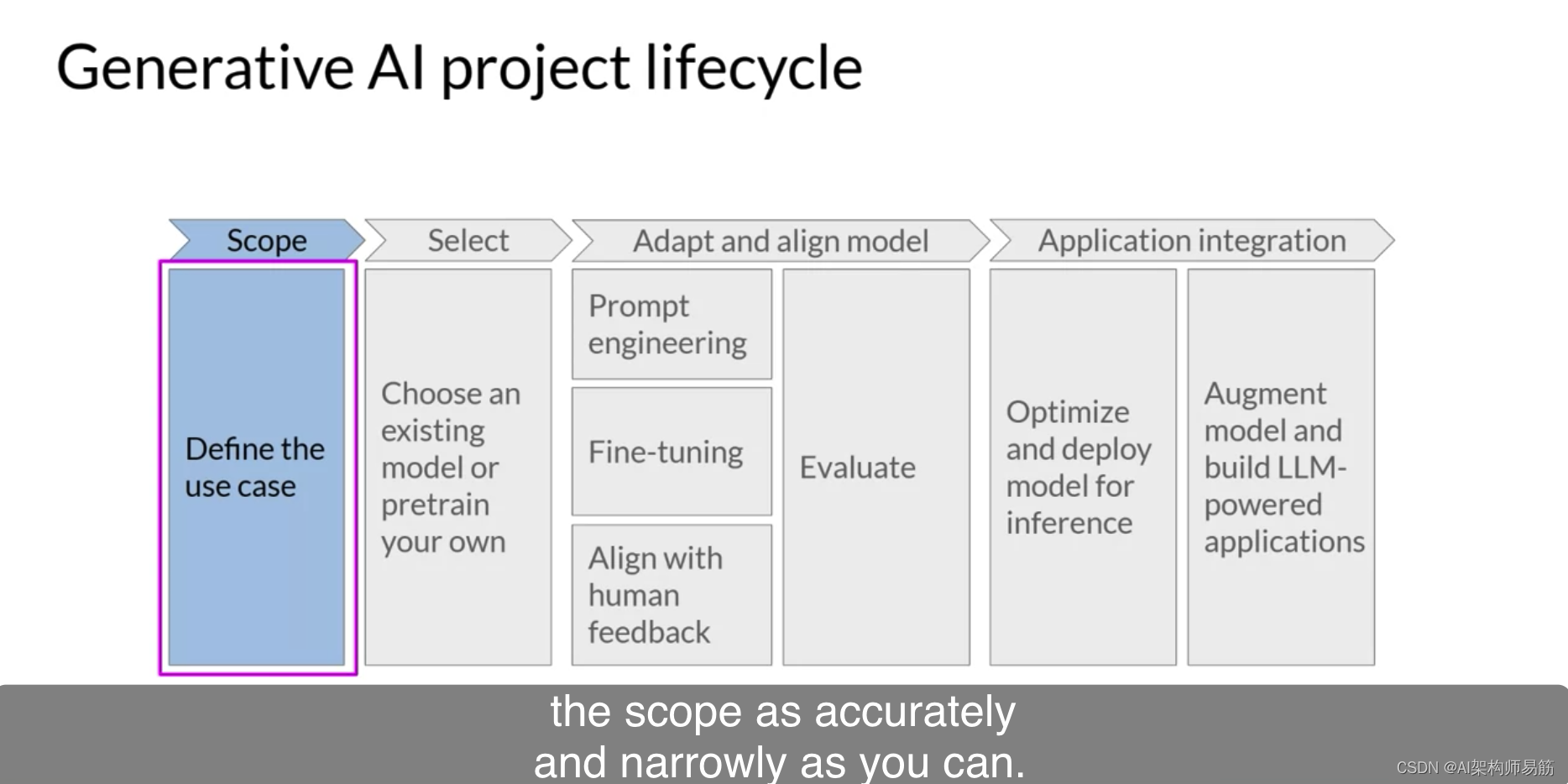

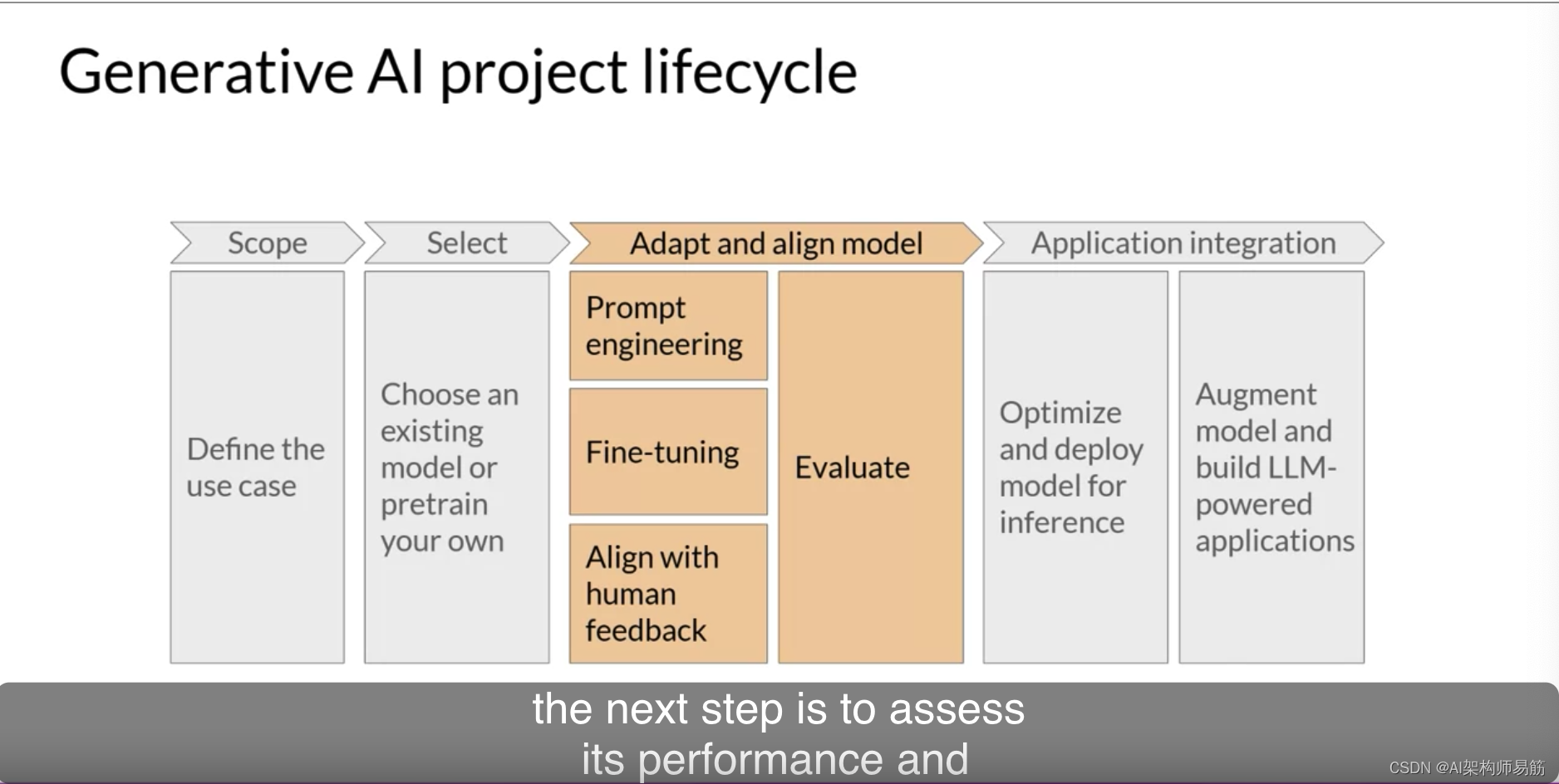

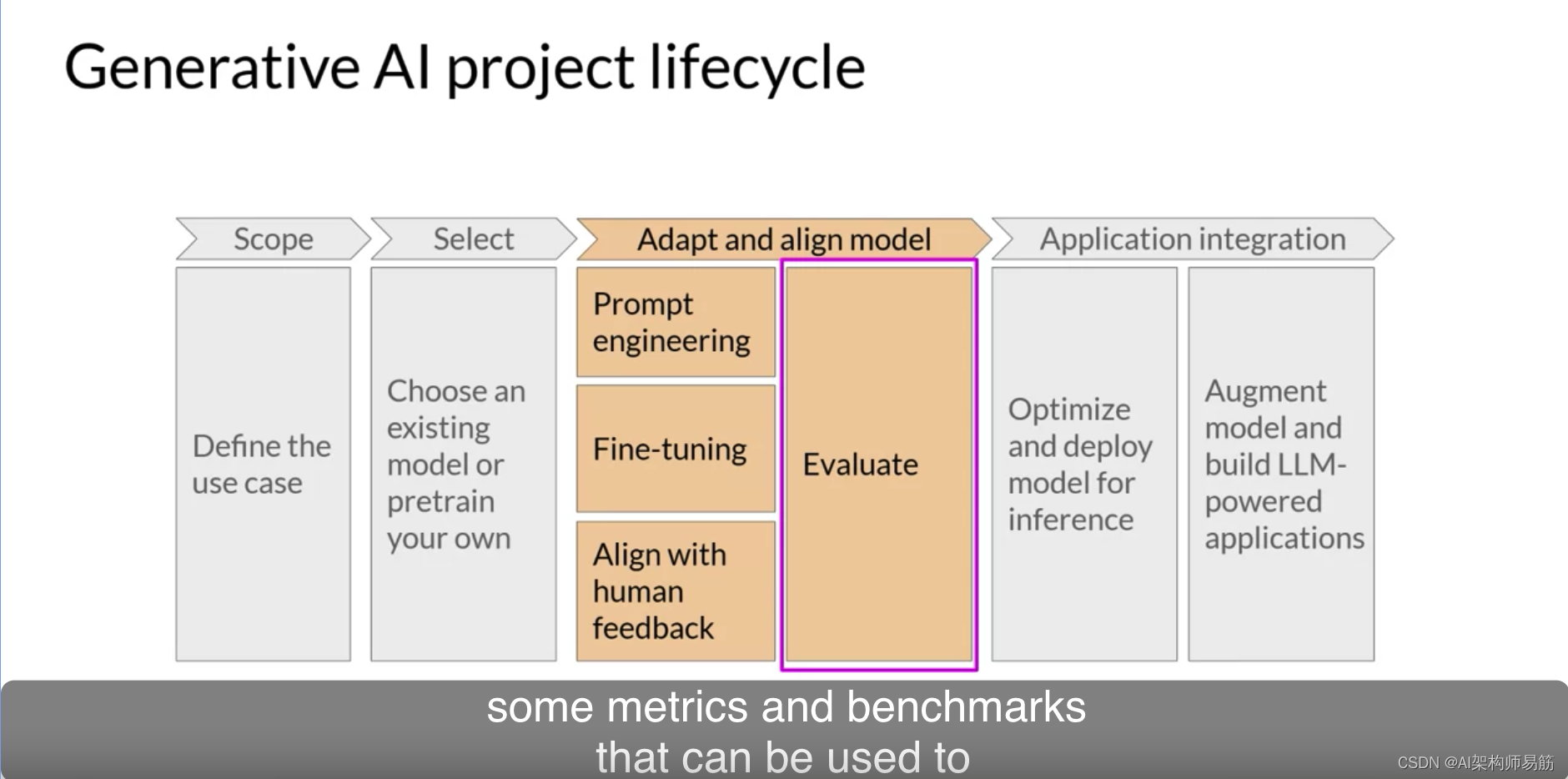

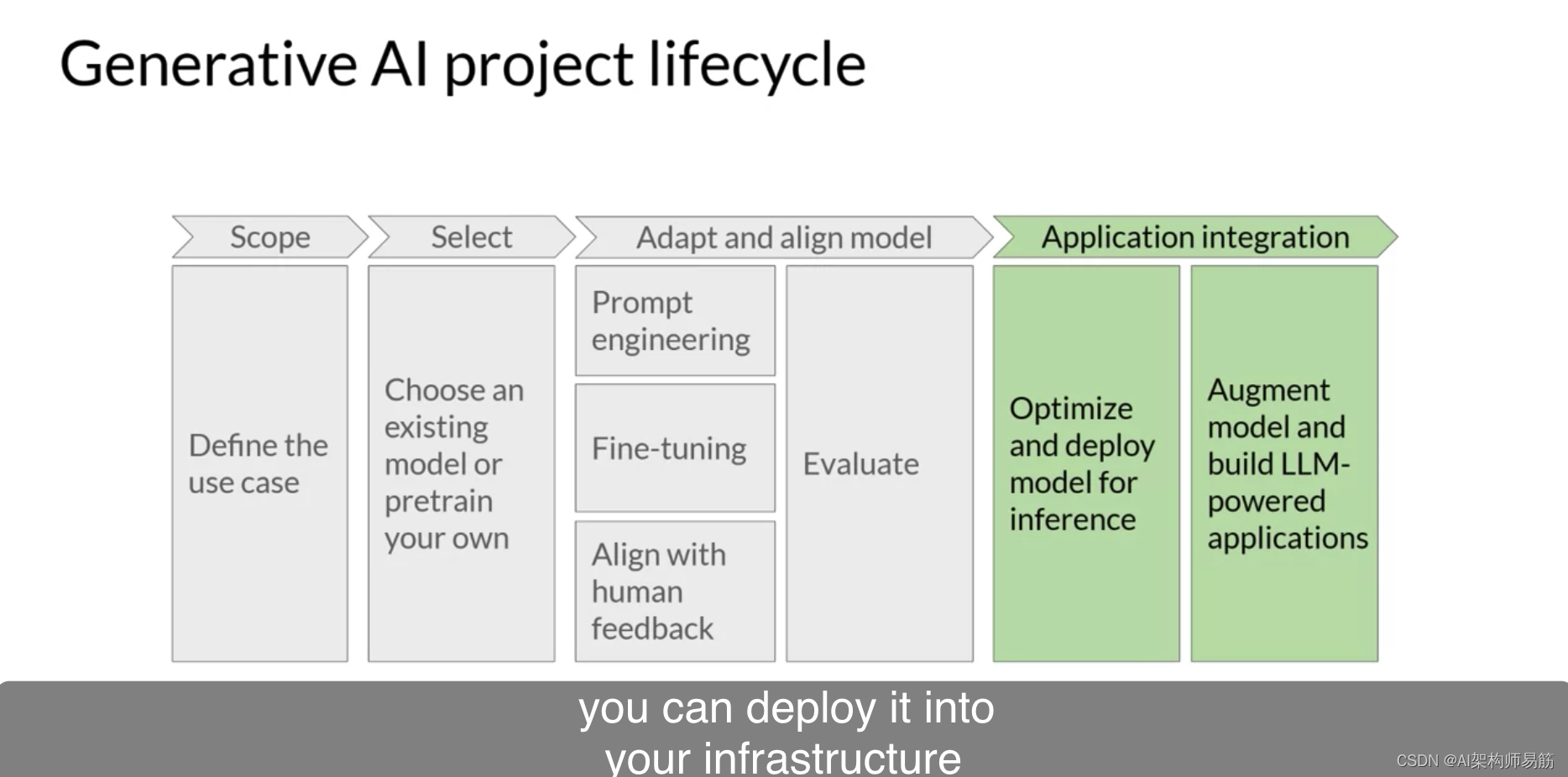

在本课程的其余部分中,您将学习开发和部署LLM驱动应用所需的技巧。在这个视频中,您将了解一个能帮助您完成此工作的生成式AI项目生命周期。此框架列出了从构思到启动项目所需的任务。到课程结束时,您应该对您需要做的重要决策、可能遇到的困难以及需要开发和部署应用程序的基础设施有一些良好的直觉。这是整个生命周期的图表。

我们将逐步讨论它。

任何项目最重要的步骤是尽可能准确和具体地定义范围。

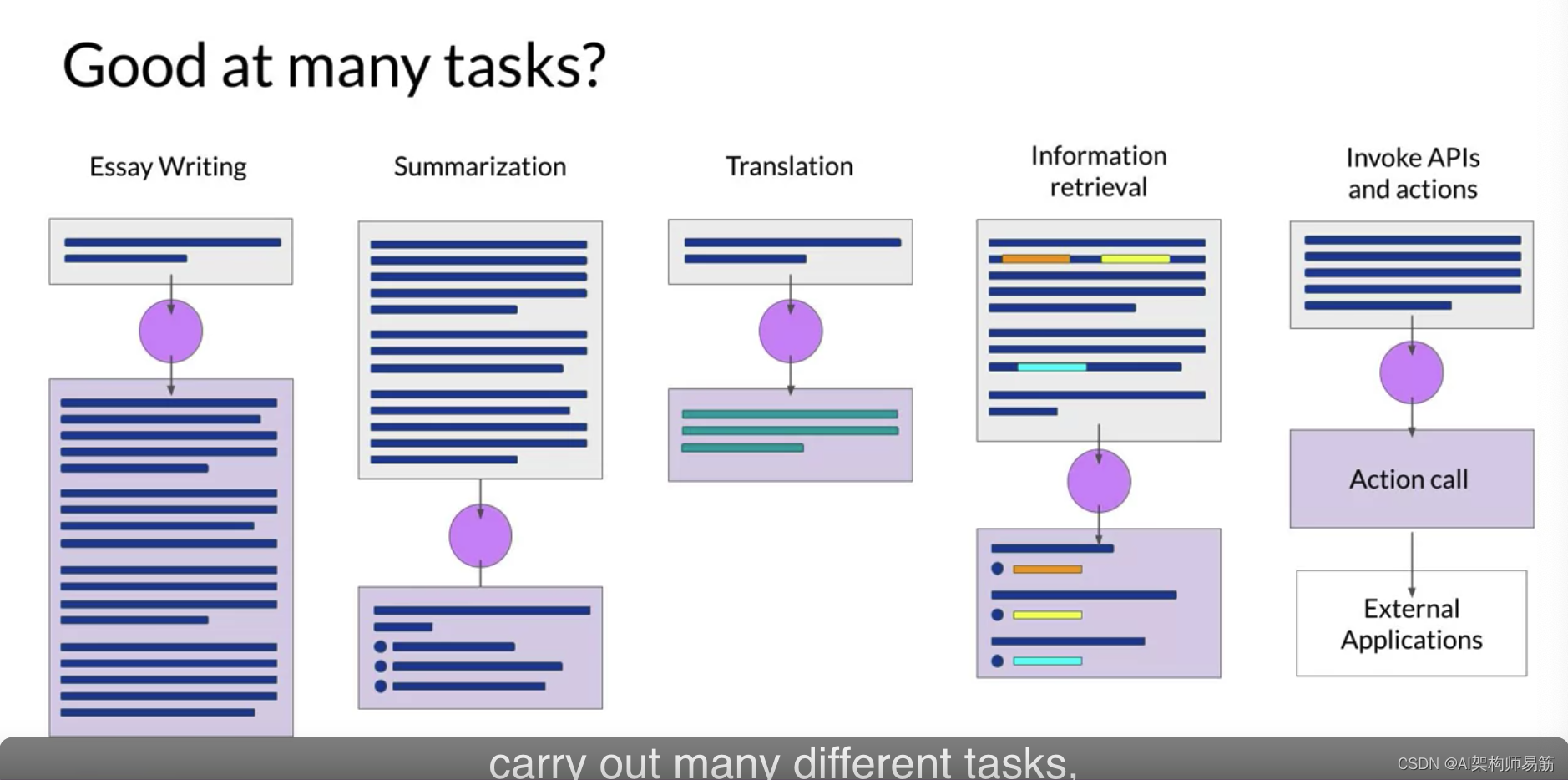

正如您在这门课程中看到的,LLMs能够执行许多任务,但它们的能力在很大程度上取决于模型的大小和架构。您应该思考LLM在您特定应用中的功能。

您是否需要模型能够执行许多不同的任务,包括长文本生成或具有高度的能力,

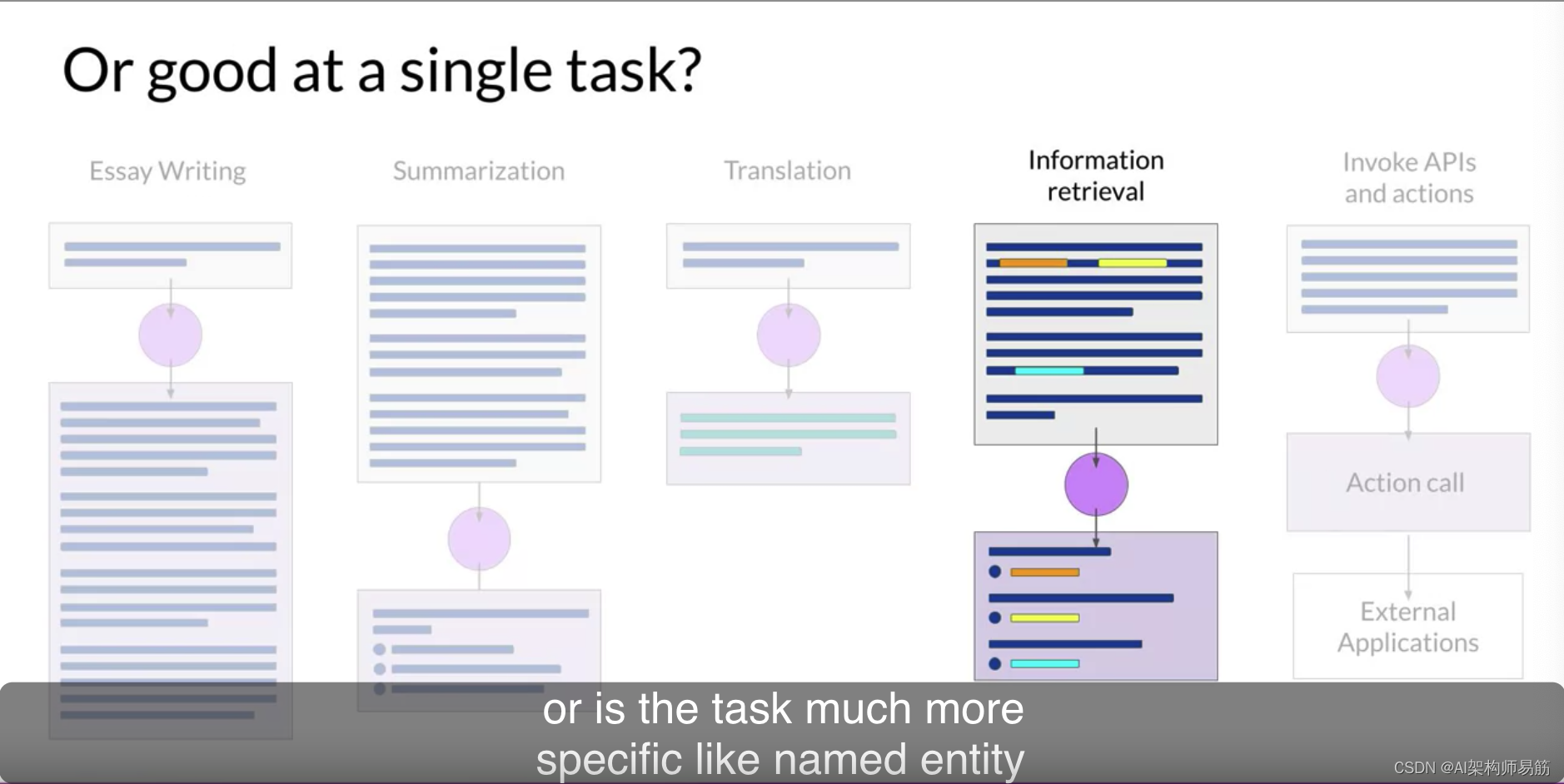

还是任务更为具体,例如命名实体识别,所以您的模型只需要擅长一件事.

正如您在课程的其余部分中所看到的,真正明确您需要模型做什么可以为您节省时间,更重要的是,计算成本。一旦您满意,并且已经足够确定了模型的要求,就可以开始开发。

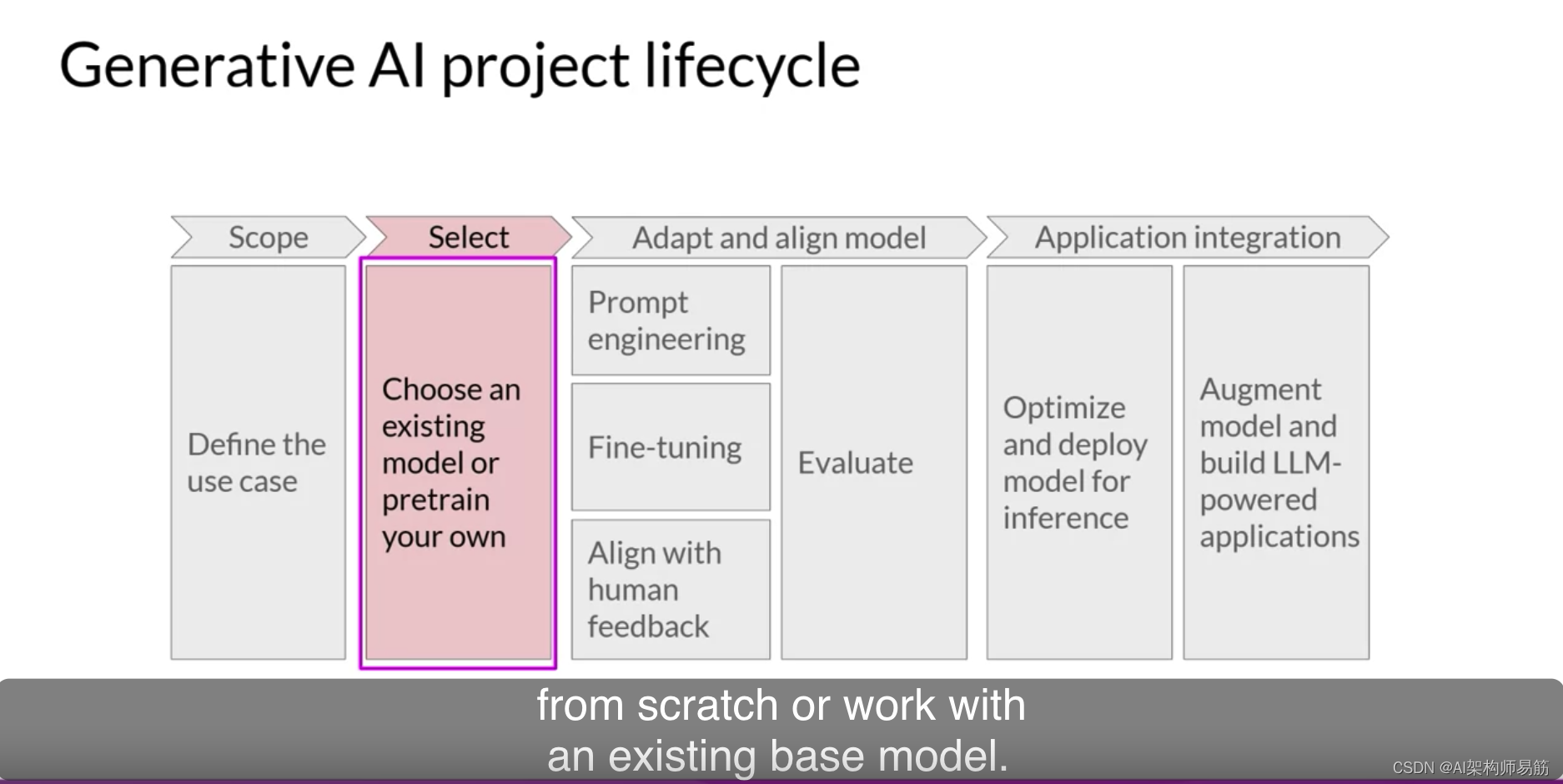

您的第一个决定将是从零开始训练自己的模型还是使用现有的基础模型。通常,您将从一个现有的模型开始,尽管在某些情况下,您可能会发现有必要从头开始训练一个模型。

您将在本周稍后了解关于此决策背后的考虑因素,以及一些经验法则,以帮助您估计训练自己的模型的可行性。

拥有了模型后,下一步是评估其性能并进行额外的训练,以满足您的应用程序的需求。

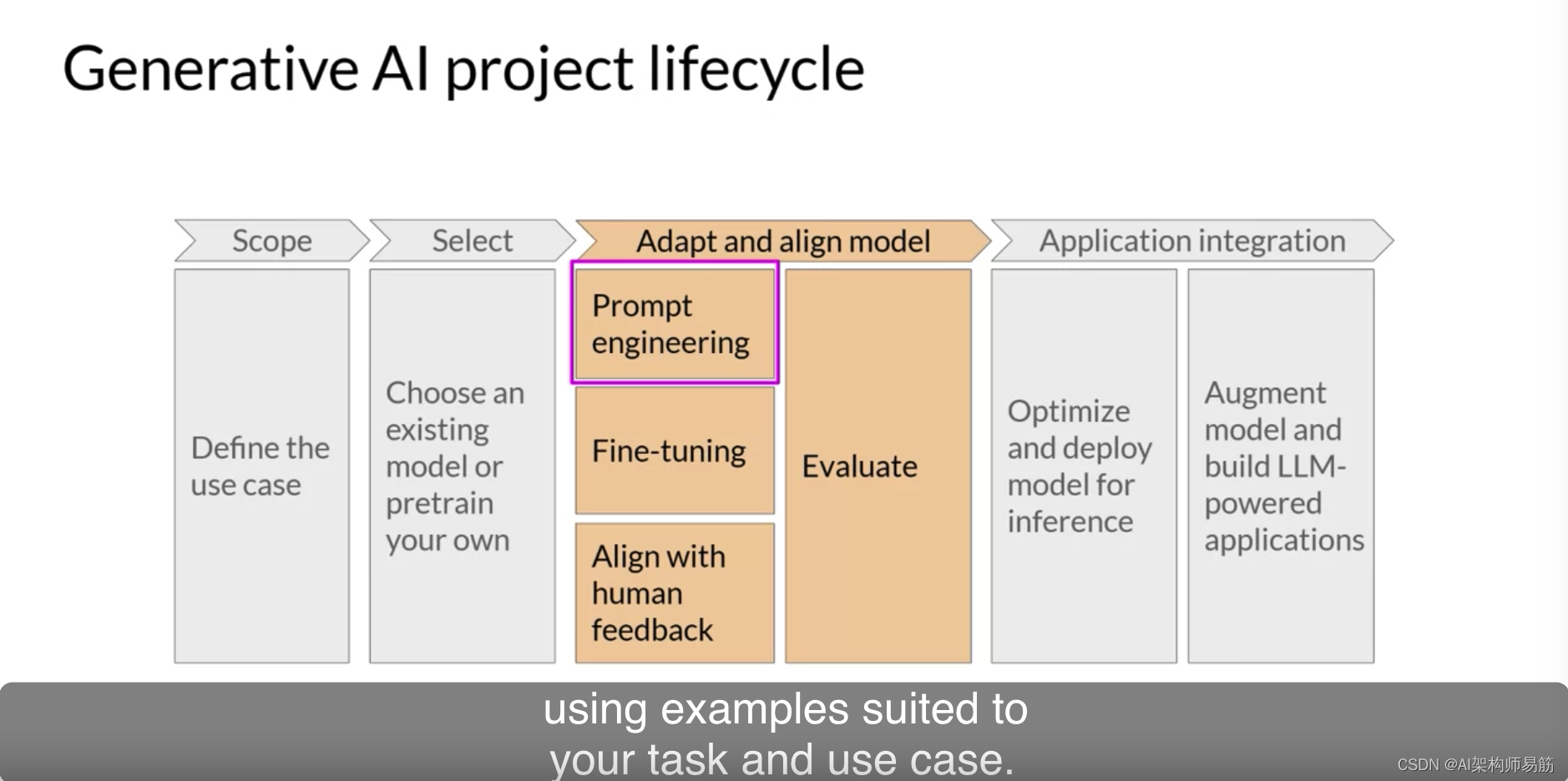

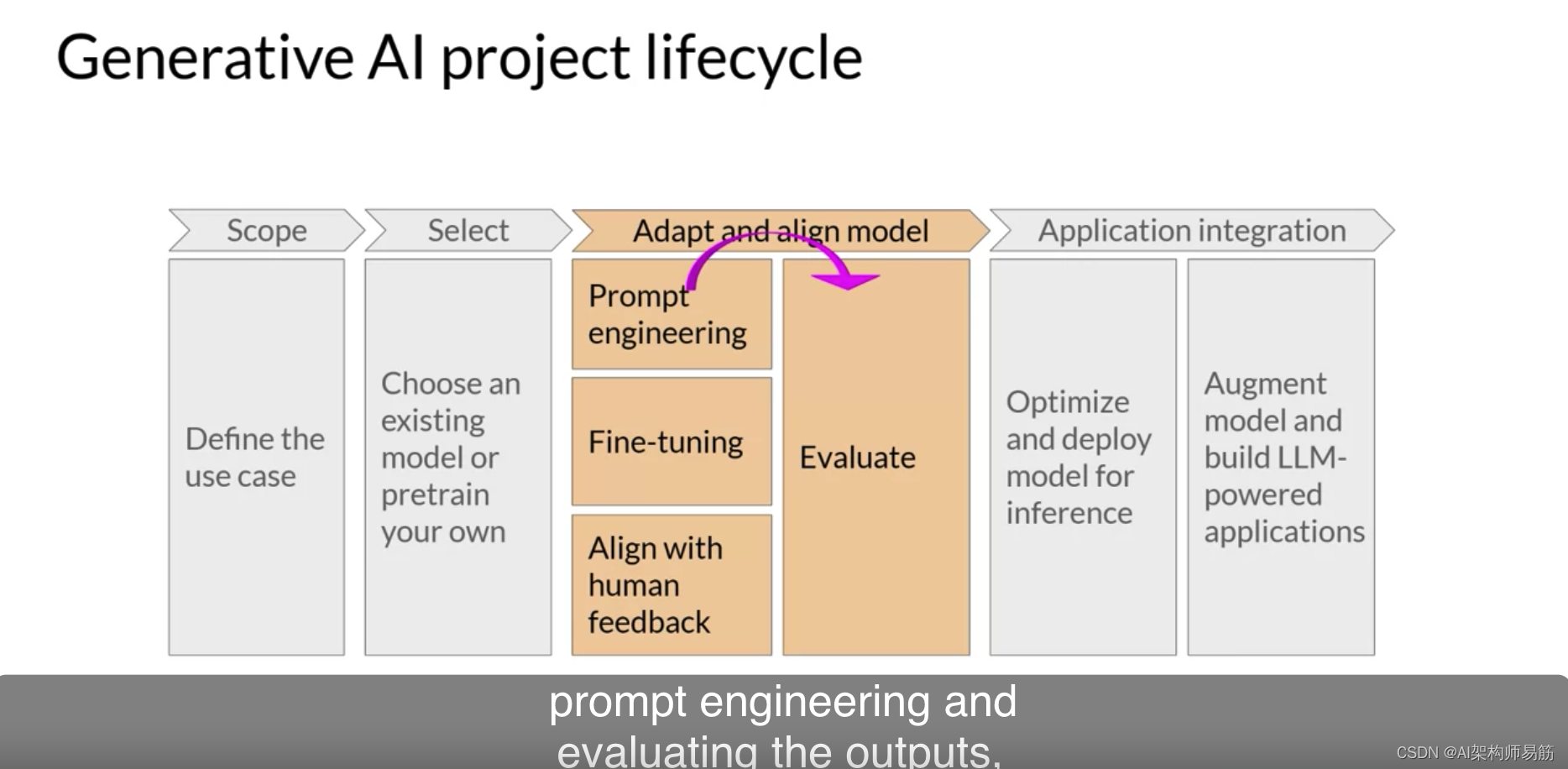

正如您本周早些时候所看到的,提示工程有时足以使您的模型表现得很好,所以您可能会首先尝试上下文学习,使用适合您的任务和用例的例子。

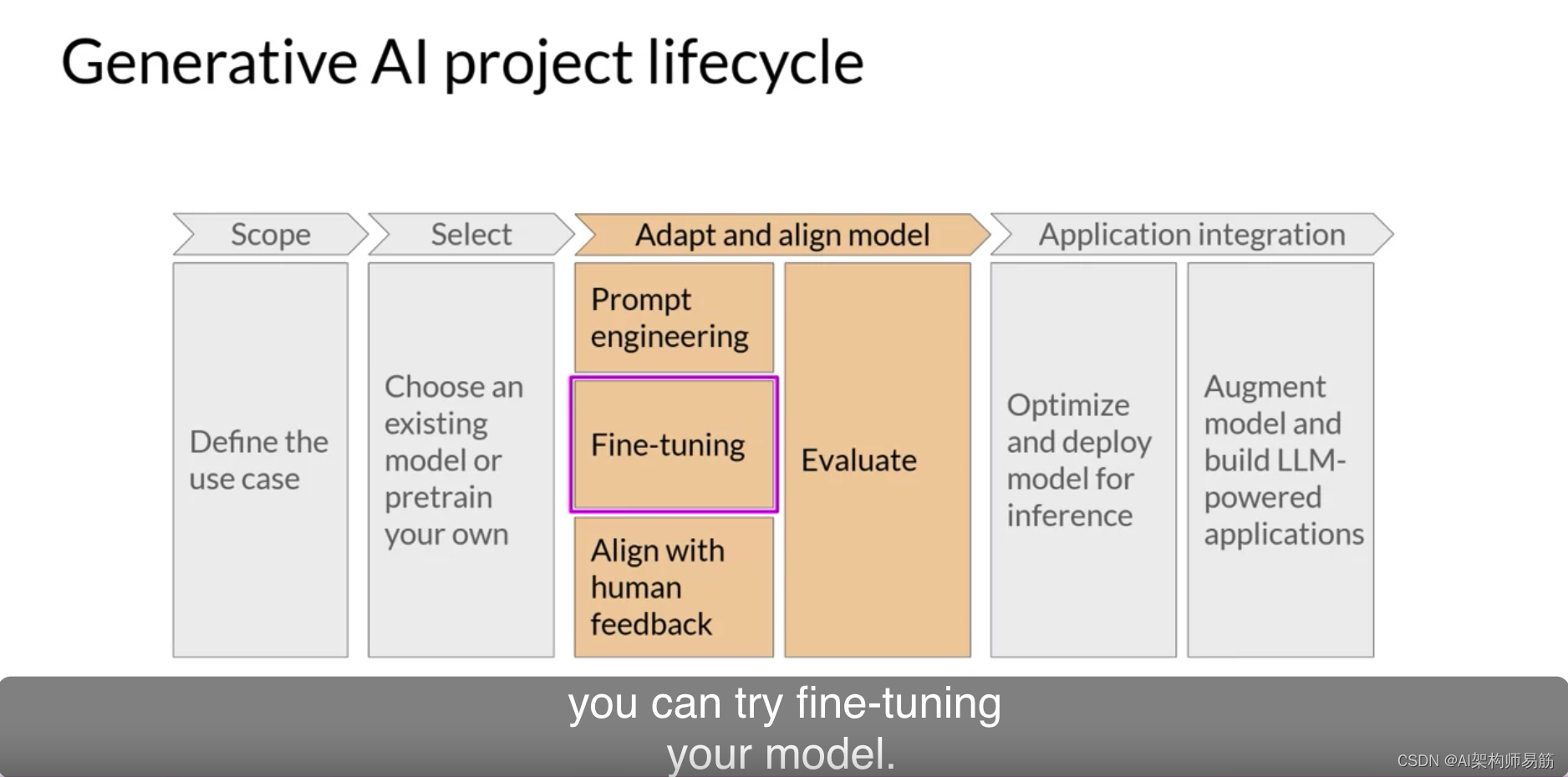

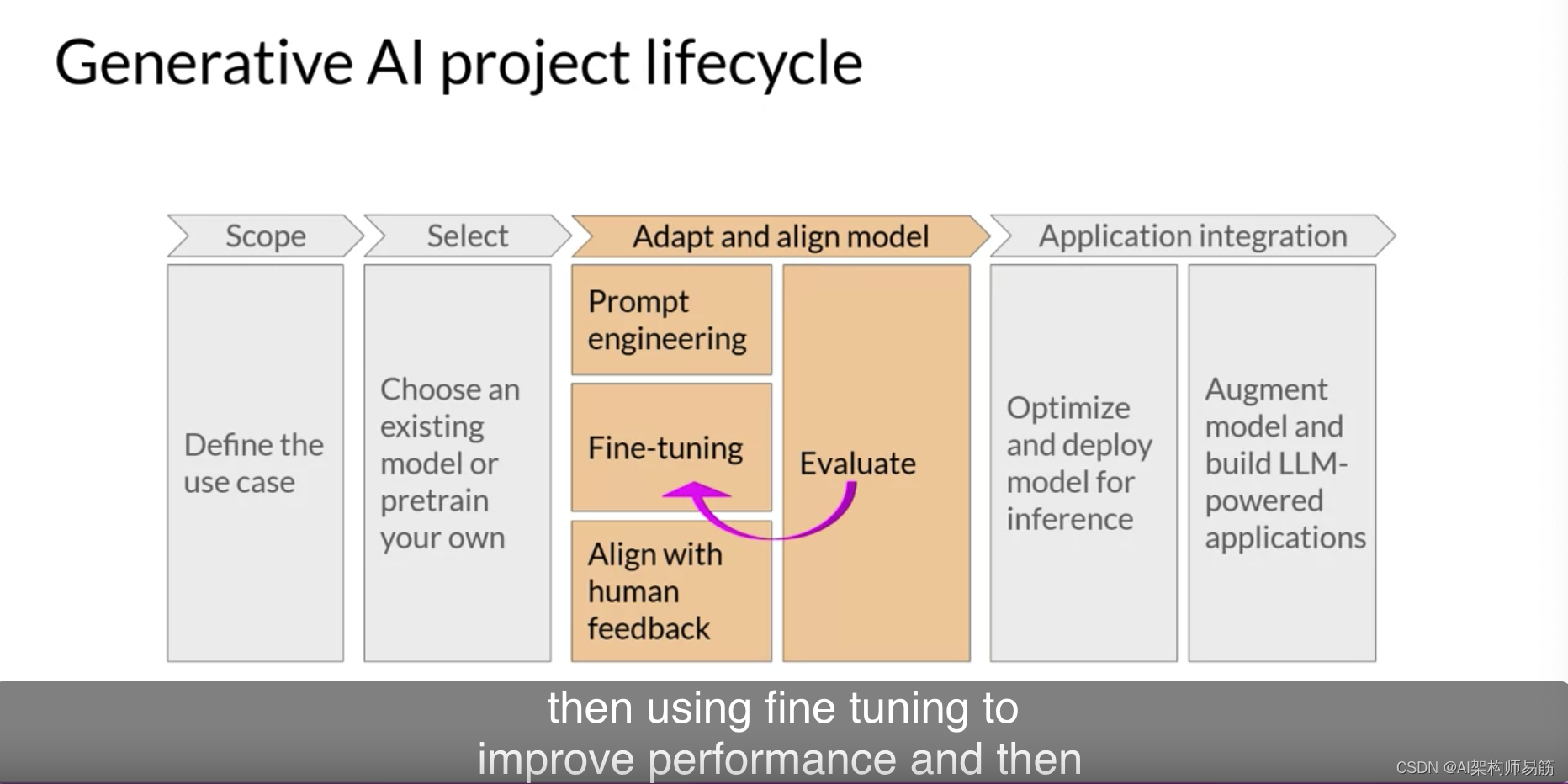

但是,仍然存在一些情况,即使在一个或几个短的推理中,模型也可能无法像您所希望的那样表现得很好,那么您可以尝试微调模型。

这种有监督的学习过程将在第2周详细介绍,您将有机会在第2周的实验室中自己尝试微调一个模型。

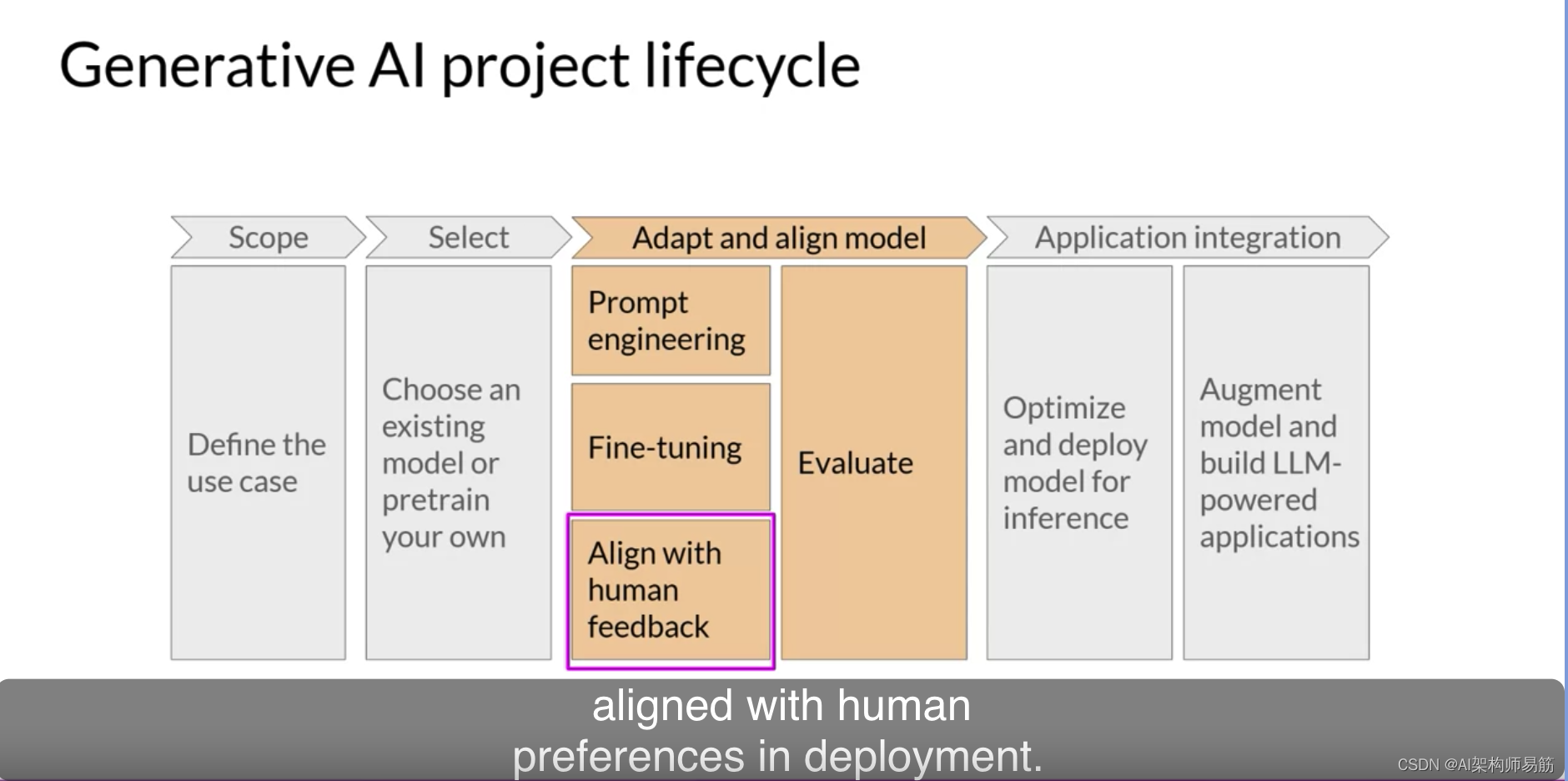

随着模型变得更加强大,确保它们在部署中表现良好并与人类的偏好一致变得越来越重要。在第3周,您将学习一种称为“与人类反馈的强化学习”的额外微调技巧,这可以帮助确保您的模型表现得很好。

所有这些技术的一个重要方面是评估。下周,您将探索一些可以用来确定模型的性能或与您的偏好有多么一致的指标和基准。

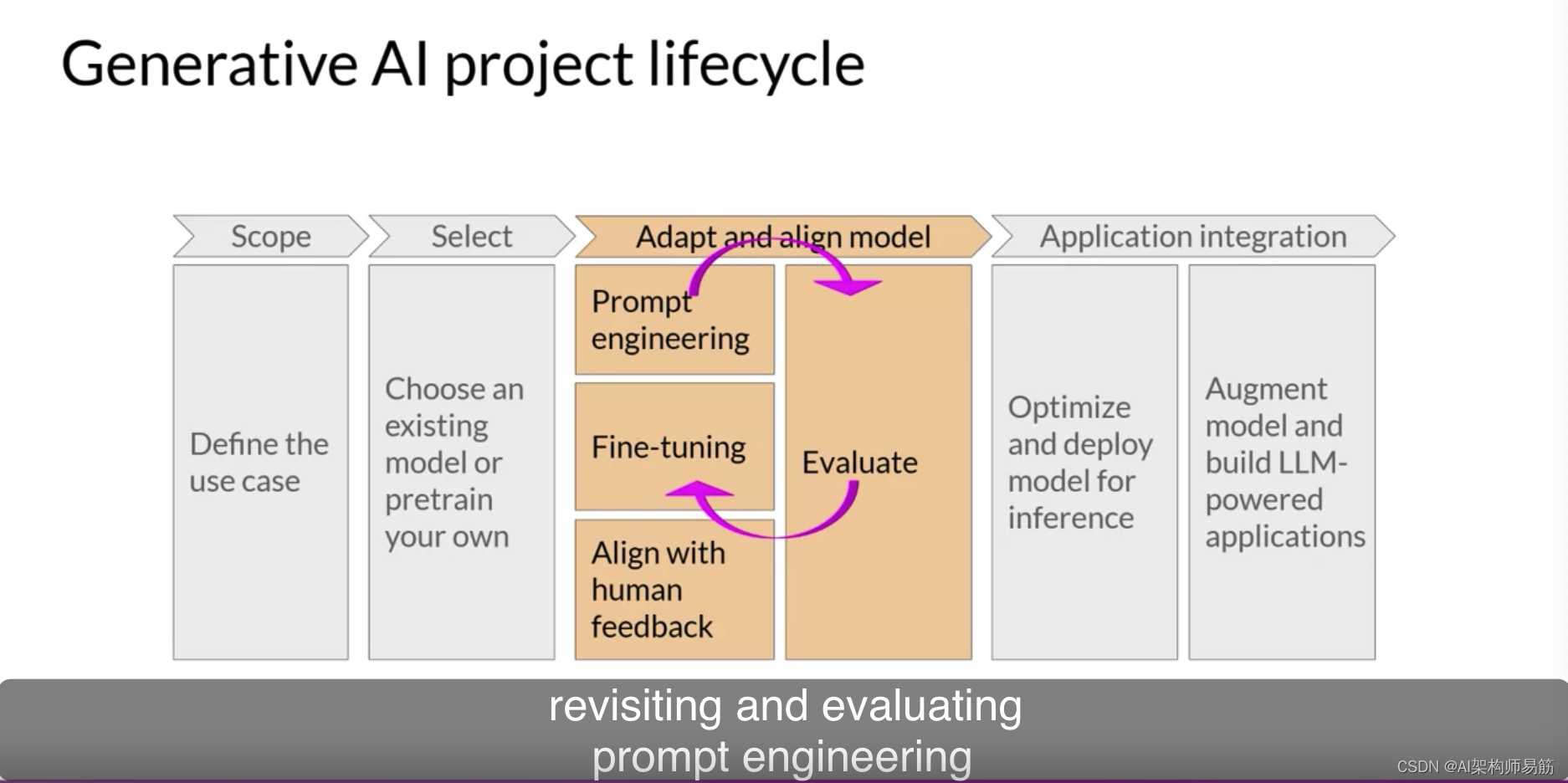

请注意,这种适应和对齐应用程序开发的阶段可能是高度迭代的。

您可能会首先尝试提示工程和评估输出,

然后使用微调来提高性能,

然后再次回顾和评估提示工程,以获得所需的性能。

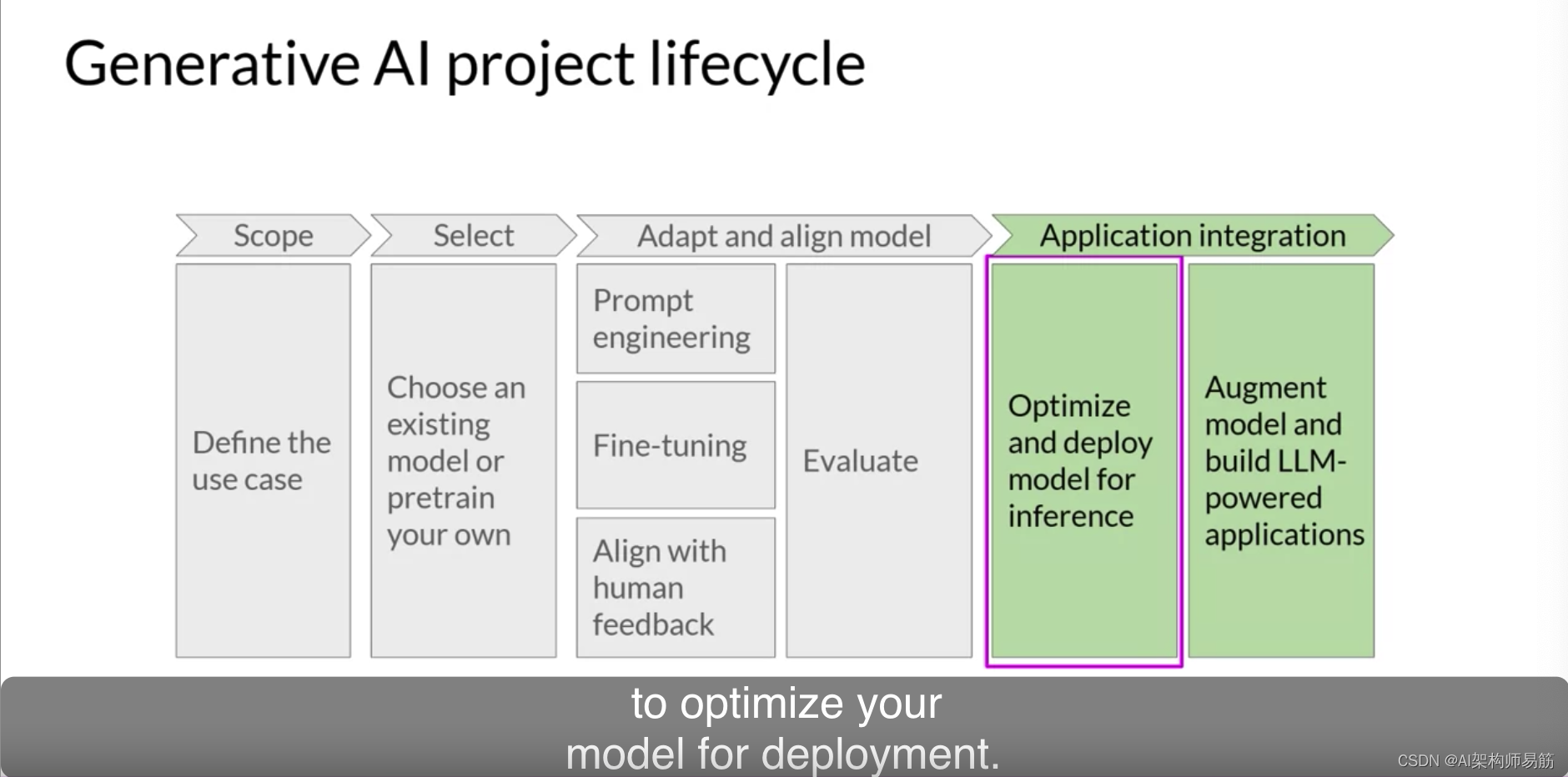

最后,当您拥有满足您的性能需求并且对齐得很好的模型时,您可以将其部署到您的基础设施中并将其与您的应用程序集成。

在此阶段,一个重要的步骤是优化模型以供部署。这可以确保您最大限度地利用您的计算资源,并为应用程序的用户提供最佳的体验。

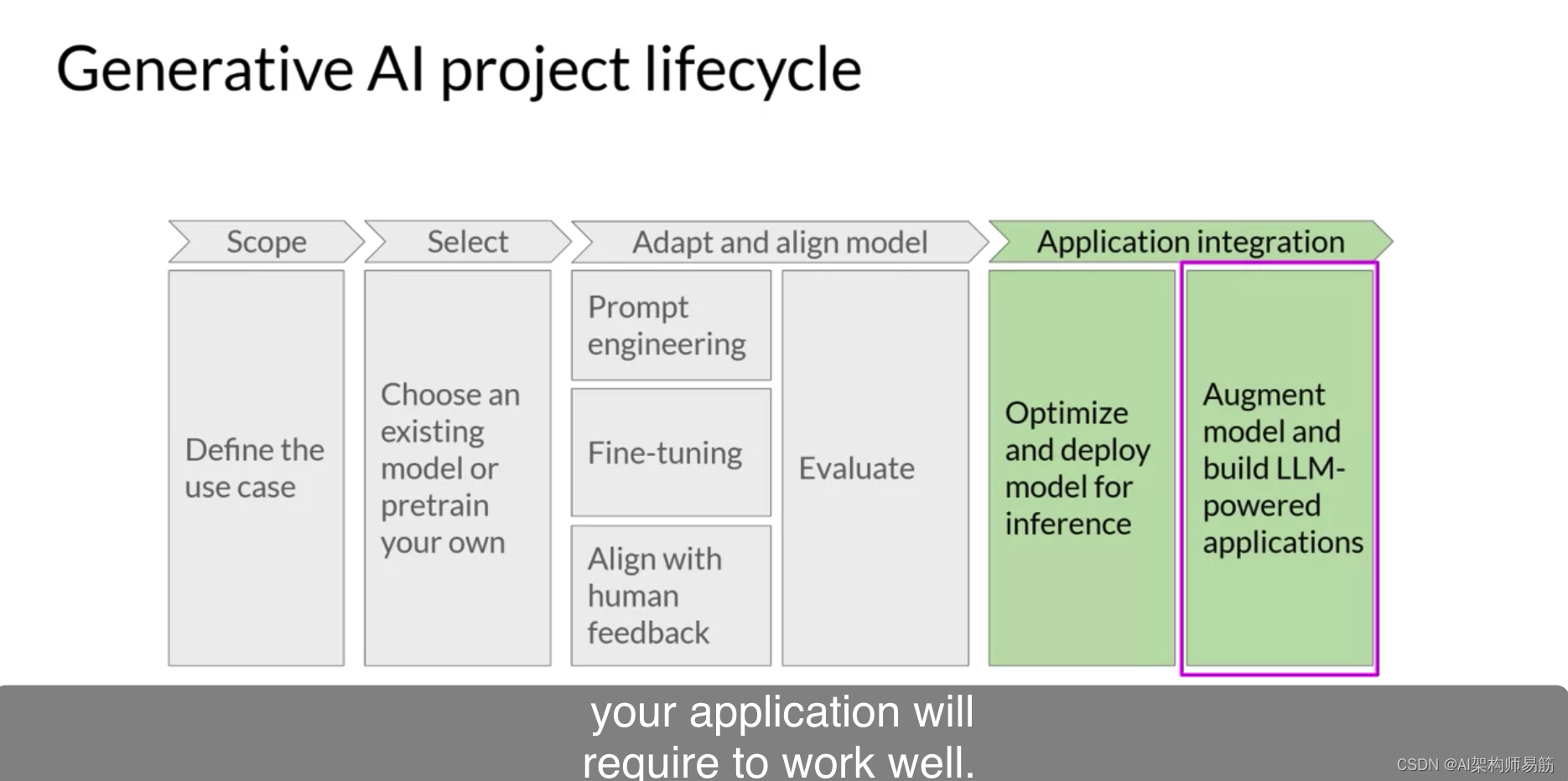

最后但同样重要的一步是考虑您的应用程序需要正常工作的任何其他基础设施。

LLM存在一些基本的局限性,仅通过培训很难克服,例如当它们不知道答案时发明信息,或者它们执行复杂的推理和数学的能力有限。

在本课程的最后部分,您将学习一些可以用来克服这些局限性的强大技巧。

我知道这里有很多事情要考虑,但是现在不用担心一次性吸收所有内容。在您探索每个阶段的详细信息时,您将在课程中一次又一次地看到这个架构。

参考

https://www.coursera.org/learn/generative-ai-with-llms/lecture/21Nwn/generative-ai-project-lifecycle