Seq2Seq模型作为从RNN演进到Transformer和Attention机制的关键中间阶段,它不仅承前启后,还为我们深入理解这些复杂的模型架构提供了重要的基础。接下来,我们将详细探讨Seq2Seq模型的原理及其在自然语言处理领域中的应用。

1. 原理及网络框架

1.1 自编码神经网络

1.2 Seq2Seq

图中展示的是一个典型的序列到序列(Seq2Seq)模型,其中包含了编码器(Encoder)和解码器(Decoder)的RNN单元。下面将详细描述每个步骤的数学过程(数学过程理解一边就可以初学不必深究)。

编码器(Encoder)

-

输入序列:假设输入序列为 x1,x2,x3,x4。

-

隐藏状态更新:

-

初始隐藏状态 h0 通常初始化为零向量或通过某种方式得到。

-

对于每个时间步 t,隐藏状态 ht 通过以下公式更新:

其中,Wh 和 Wx 是权重矩阵,bh 是偏置项,f 是激活函数(如tanh或ReLU)。

-

-

最终上下文向量:

-

最终隐藏状态 h4 可以作为上下文向量 c,也可以通过某种方式(如取最后的状态或对所有隐藏状态进行加权求和)得到。

-

解码器(Decoder)

-

初始状态:

-

解码器的初始隐藏状态 h0′ 通常设置为编码器的最终隐藏状态 h4 或上下文向量 c。

-

-

输出序列生成:

-

对于每个时间步 t,解码器生成输出 yt 和更新隐藏状态 ht′:

其中,Wh′、Wc′ 和 Wy′ 是权重矩阵,bh′ 和 by′ 是偏置项,f 和 g 是激活函数(f 通常为tanh或ReLU,g 通常为softmax)。

-

-

输出生成:

-

输出 yt 可以是词汇表中每个词的概率分布,通常通过softmax函数得到:

-

我们可以将上述过程简化为如下图所示流程,其中在输入序列的最后一个元素“C”之后,添加了一个特殊的结束标记“<EOS>”,表示输入序列的结束或输出出序列的开始标识符。当解码器生成一个特殊的结束标记“<EOS>”时,表示输出序列的结束。

2. 代码实现

通过自定义编码器、解码器输入及目标标签,深度理解输入输出出结构(下图与整体代码框架无关,仅为理解提供方便,实际代码输入输出通过 torch.randn实现,例:encoder_input_x = torch.randn(3, 5, 8) decoder_input_x = torch.randn(3, 4, 8))

编码器:3个样本,每个样本5个token,每个token对应8维的向量

解码器:3个样本,每个样本4个token(3+1), 每个token对应8维度的向量

其中,2和3分别代表开始标识和结束标识

网络执行过程与测试代码实现从这里开始

将上图Seq2Seq网络框架通过代码实现

定义编码器、解码器

实现网络执行过程

实现网络执行过程

附 可编辑代码实现:

vocab_size = 100

encoder_rnn = nn.RNN(input_size=8, hidden_size=8, batch_first=True)

decoder_rnn = nn.RNN(input_size=8, hidden_size=8, batch_first=True)

deocder_output_fc = nn.Sequential(nn.Linear(8, vocab_size)

)#定义一个简单的全连接层,它将解码器的输出维度从8转换为词汇表大小(vocab_size)# 3个样本,每个样本5个token,每个token对应8维的向量

encoder_input_x = torch.randn(3, 5, 8)

# encoder_output: [N,T,E] 每个时刻的输出特征向量

# encoder_ht: [1,N,E] 最后一个时刻提取的状态信息/特征向量

encoder_output, encoder_ht = encoder_rnn(encoder_input_x)

print(encoder_ht.shape)# 将编码器的状态转换为中间向量

c = encoder_ht

decoder_h0 = c# 调用解码器

# 3个样本,每个样本4个token(3+1), 每个token对应8维度的向量

decoder_input_x = torch.randn(3, 4, 8)

# decoder_output: [N,T,E] 每个时刻的输出特征向量

# decoder_ht: [1,N,E] 最后一个时刻提取的状态信息/特征向量

decoder_output, decoder_ht = decoder_rnn(decoder_input_x, hx=decoder_h0)print(decoder_output.shape)# 预测的置信度

z = deocder_output_fc(decoder_output) # [N,T,E] * [E,vocab_size] --> [N, T, vocab_size]print(z.shape)3.在实际应用场景中理解Seq2Seq执行过程

在左侧的图中,“小明喜欢吃苹果”这一输入序列首先通过词嵌入层被转换为向量表示。每个词被转换成一个向量后,输入到编码器中进行处理,生成一系列隐藏状态 h1、h2、h3。编码器的输出可以是最后一个隐藏状态,也可以是通过对隐藏状态进行聚合得到的上下文向量 c,例如通过取最后一个状态、平均或使用 Attention 机制得到。

解码器的初始状态通常设置为编码器的最终隐藏状态或上下文向量 c。它接收一个起始符号(如 ),并开始生成输出序列。在每一步解码过程中,解码器生成一个输出 Oi,这个输出是基于前一时刻的隐藏状态和输出。解码器的输出 Oi 通过一个 softmax 层(或其他激活函数)转换为概率分布,然后选择概率最高的词作为输出 Yi。这一过程不断重复,直到生成结束符号(如 ),从而完成整个序列的生成。

其中,argmax过程是一个多分类过程,选择概率较高的单词id作为输出

Seq2Seq的应用场景不仅涵盖了传统的机器翻译、文本摘要和对话生成,还包括了一些别出心裁的应用,如根据数学公式的图片生成LaTeX代码,以及自动生成提交信息等。自然语言生成(NLG)作为一个极具吸引力和前景的研究领域,其核心在于解决条件概率p(output|context)的建模问题,即基于给定的上下文生成相应的输出。这里的上下文可以是多种多样的,研究人员利用深度学习模型对这一条件概率进行建模,结合海量训练数据和无穷的想象力,实现了众多令人惊叹的应用。Seq2Seq框架因其简洁易用而备受青睐,相应的开源实现也层出不穷,但这并不意味着可以机械地照搬照套,而是需要针对具体问题进行具体分析。此外,如何控制生成内容,即解码部分的研究,也是当前NLG领域一个非常有趣的方向,包括如何调控生成文本的长度、多样性、信息量大小以及情感等。

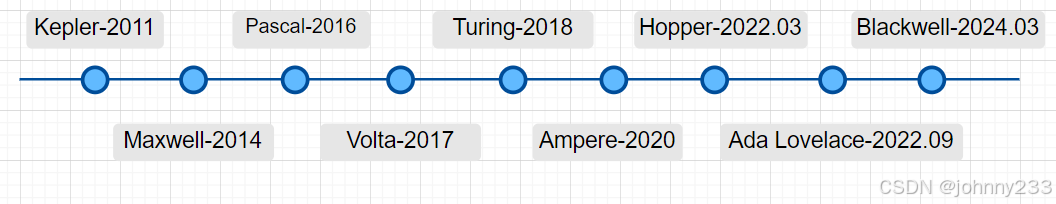

Seq2Seq向Transformer的演进

Transformer模型和传统的Seq2Seq模型,两种模型都采用编码器-解码器架构,用于将输入序列转换为输出序列。

传统Seq2Seq模型通常使用循环神经网络(RNN)或长短时记忆网络(LSTM)来处理序列数据。在处理长序列时,这些模型可能会遇到梯度消失或梯度爆炸的问题,导致难以捕捉长距离依赖关系。

Transformer模型则是将Seq2Seq中的RNN(或LSTM)替换为自注意力机制。自注意力机制允许模型在序列中的任意位置间直接建立依赖关系,不受距离限制,这使得模型能够更有效地处理长距离依赖问题。

![[EAI-027] RDT-1B,目前最大的用于机器人双臂操作的机器人基础模型](https://i-blog.csdnimg.cn/direct/ac2f27c5c0e7474e918e6b75723a1ac2.png)

![python算法和数据结构刷题[2]:链表、队列、栈](https://i-blog.csdnimg.cn/direct/34780a8f88ee40fdb0ceb39f2b996eb3.png)