https://blog.csdn.net/qq_39611230/article/details/108641842

https://blog.csdn.net/KgdYsg/article/details/118213499

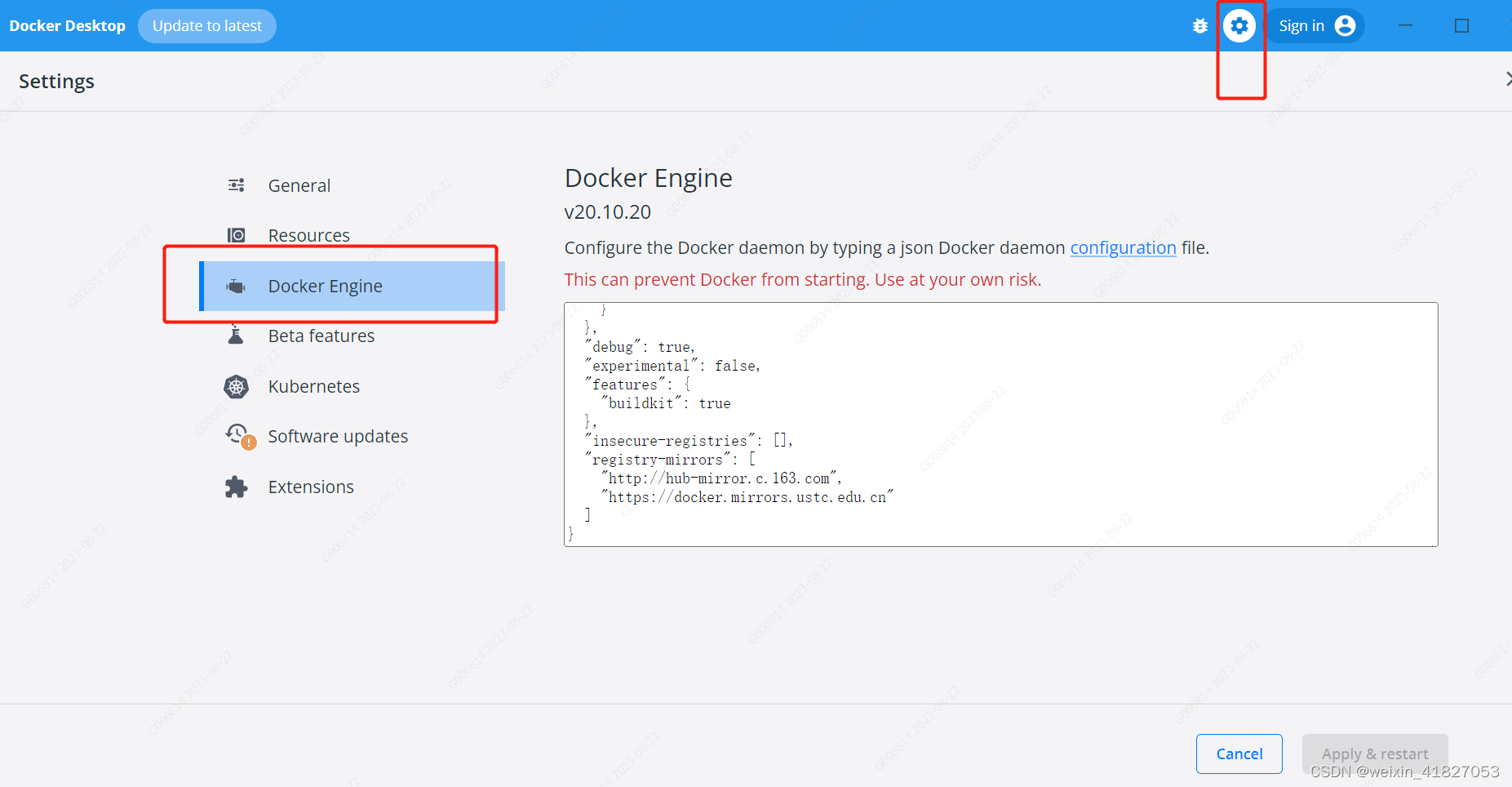

1、修改配置

{"registry-mirrors": ["https://registry.docker-cn.com","http://hub-mirror.c.163.com","https://docker.mirrors.ustc.edu.cn"],"insecure-registries": [],"debug": false,"experimental": false,"features": {"buildkit": true},"builder": {"gc": {"enabled": true,"defaultKeepStorage": "20GB"}}

}2、docker安装kafka

步骤 1:安装 Docker Desktop

如果您尚未安装 Docker Desktop,请按照 Docker 官方网站上的说明下载和安装适用于您的操作系统版本的 Docker Desktop。

步骤 2:创建 Docker Compose 文件

Docker Compose 是一个工具,用于定义和运行多个 Docker 容器的应用程序。我们将使用 Docker Compose 来创建 Kafka 容器。

在您的项目目录中,创建一个名为 docker-compose.yml 的文件,并将以下内容复制到文件中:(此处把kafka端口改成了8081,这个看自己需求修改。10.20.10.91 为本机ip)

version: '3'

services:zookeeper:image: confluentinc/cp-zookeeper:latestports:- "2181:2181"environment:ZOOKEEPER_CLIENT_PORT: 2181kafka:image: confluentinc/cp-kafka:latestports:- "8081:8081"environment:KAFKA_ADVERTISED_LISTENERS: PLAINTEXT://10.20.10.91:8081KAFKA_ZOOKEEPER_CONNECT: zookeeper:2181KAFKA_BROKER_ID: 1KAFKA_OFFSETS_TOPIC_REPLICATION_FACTOR: 1

这将创建一个包含 ZooKeeper 和 Kafka 两个服务的 Docker Compose 配置。ZooKeeper 用于协调 Kafka 集群,而 Kafka 是消息代理

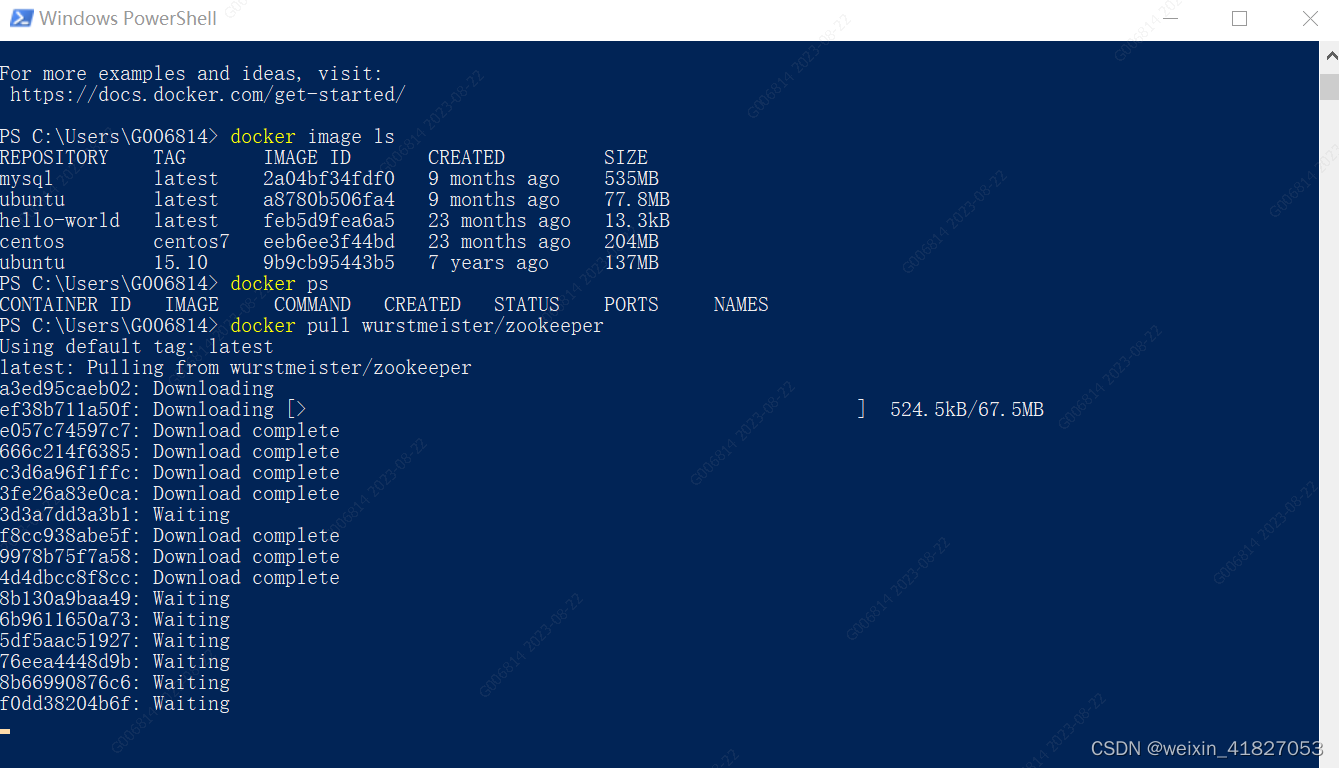

步骤 3:启动 Kafka 容器

打开终端(命令行界面)并导航到包含 docker-compose.yml 文件的目录。运行以下命令启动 Kafka 容器:

docker-compose up -d

这将从 Docker Hub 下载并启动 ZooKeeper 和 Kafka 容器。 -d 参数会使容器在后台运行。

步骤 4:验证 Kafka 是否正常运行

您可以运行以下命令来验证 Kafka 是否已经成功运行:

docker ps

您应该能够看到运行中的 confluentinc/cp-kafka 容器.

步骤 5:测试 Kafka

您可以使用 Kafka 自带的命令行工具进行测试。首先,进入 Kafka 容器的终端:

docker exec -it <kafka_container_id> /bin/bash

然后,创建一个示例的主题并发布一些消息:

# 创建名为 "test" 的主题

kafka-topics --create --topic test --bootstrap-server localhost:8081--replication-factor 1 --partitions 1# 在 "test" 主题中发布一条消息

echo "Hello, Kafka!" | kafka-console-producer --topic test --bootstrap-server localhost:8081# 从 "test" 主题中消费消息

kafka-console-consumer --topic test --from-beginning --bootstrap-server localhost:8081步骤 6:停止 Kafka 容器

当您完成测试后,可以停止 Kafka 容器:

docker-compose down

这将停止并删除与 docker-compose.yml 文件中定义的服务相关联的容器。

这只是一个简单的 Kafka 安装和测试教程。实际上,Kafka 需要更多的配置和管理,以适应不同的使用场景。如需深入了解 Kafka 的配置和使用,请查阅 Kafka 官方文档和相关资料。

![[JavaWeb]【十】web后端开发-SpringBootWeb案例(配置文件)](https://img-blog.csdnimg.cn/9b1d10ea95b44918aa745ef549aeecef.png)

![[JavaWeb]【十一】web后端开发-SpringBootWeb案例(登录)](https://img-blog.csdnimg.cn/1f1e1a0c94f54715a7406ff264e282c9.png)

![[golang gin框架] 43.Gin商城项目-微服务实战之后台Rbac微服务之管理员的增删改查以及管理员和角色关联](https://img-blog.csdnimg.cn/37c0b6e3ef20490cb9b5d14c67ec08d7.png)