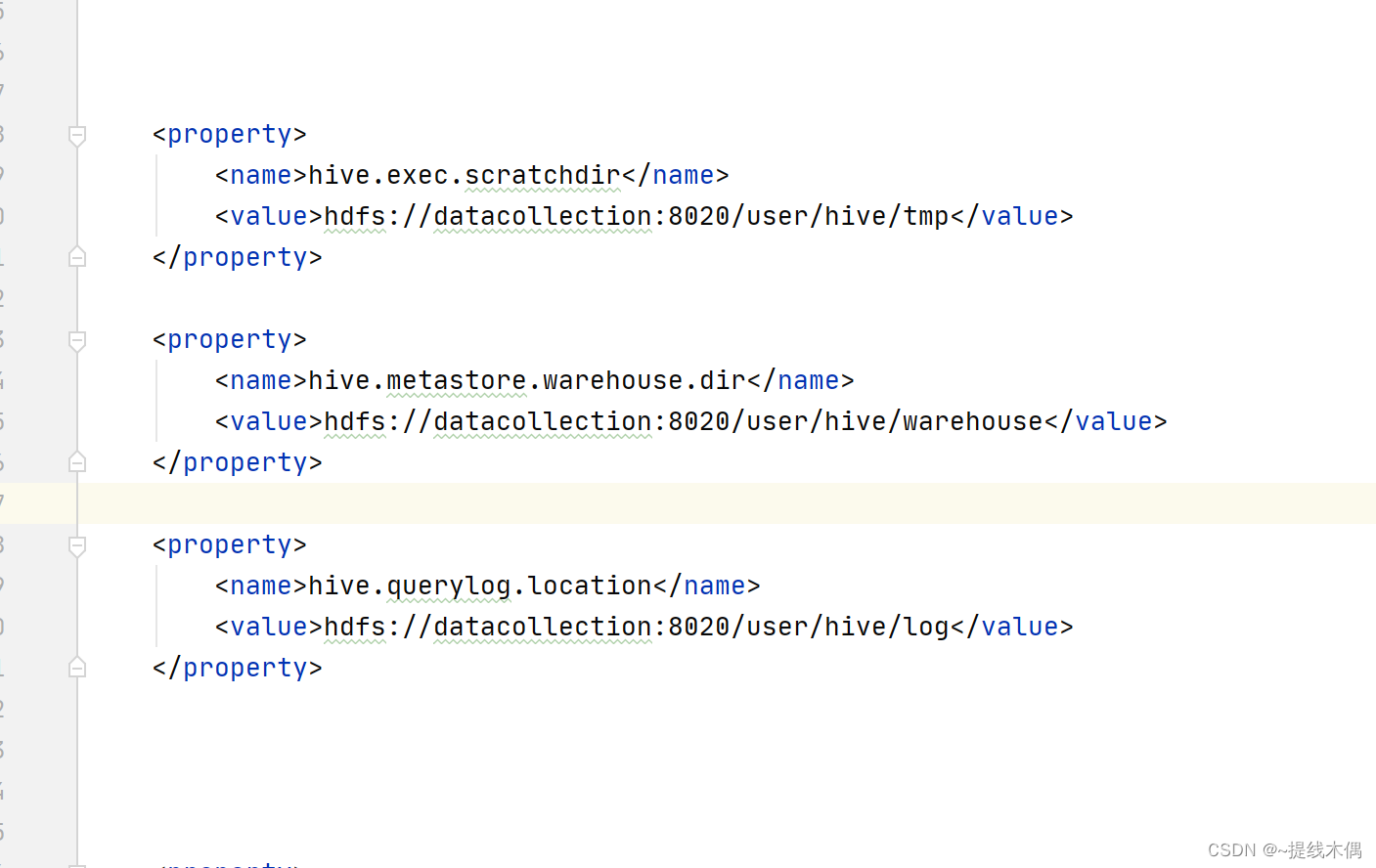

Spark整合hive的时候出错

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如若转载,请注明出处:http://www.rhkb.cn/news/110318.html

如若内容造成侵权/违法违规/事实不符,请联系长河编程网进行投诉反馈email:809451989@qq.com,一经查实,立即删除!相关文章

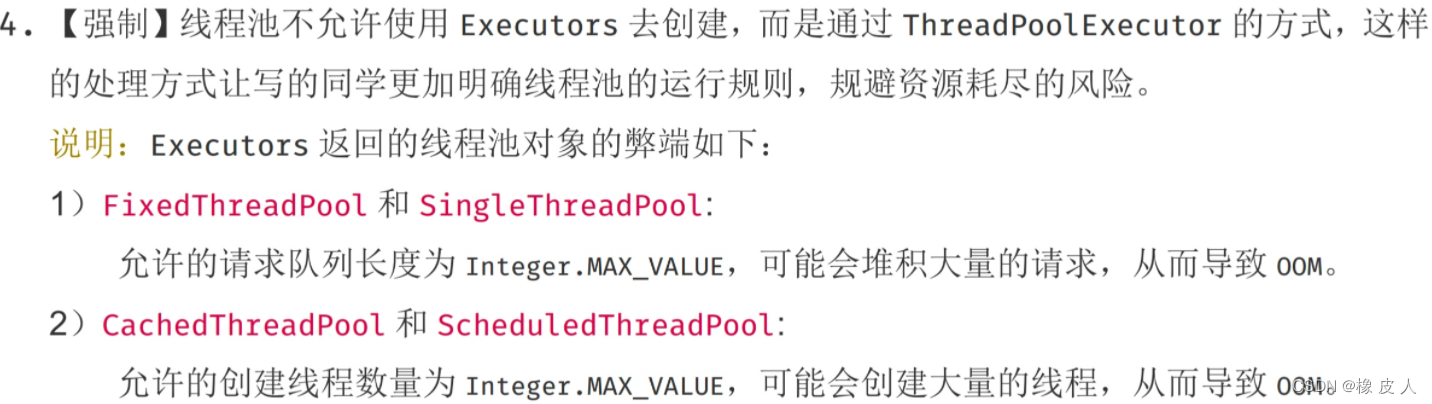

Java并发编程第6讲——线程池(万字详解)

Java中的线程池是运用场景最多的并发框架,几乎所有需要异步或并发执行任务的程序都可以使用线程池,本篇文章就详细介绍一下。

一、什么是线程池 定义:线程池是一种用于管理和重用线程的技术(池化技术),它主…

AcWing 898. 数字三角形 (每日一题)

大家好 我是寸铁 希望这篇题解对你有用,麻烦动动手指点个赞或关注,感谢您的关注

注意

像数组下标出现i-1的,在循环的时候从i1开始。

关于0x3f3f3f3f和Integer.MAX_VALUE

0x3f3f3f3f:1061109567 Integer.MAX_VALUE:2147483647 在选用Integ…

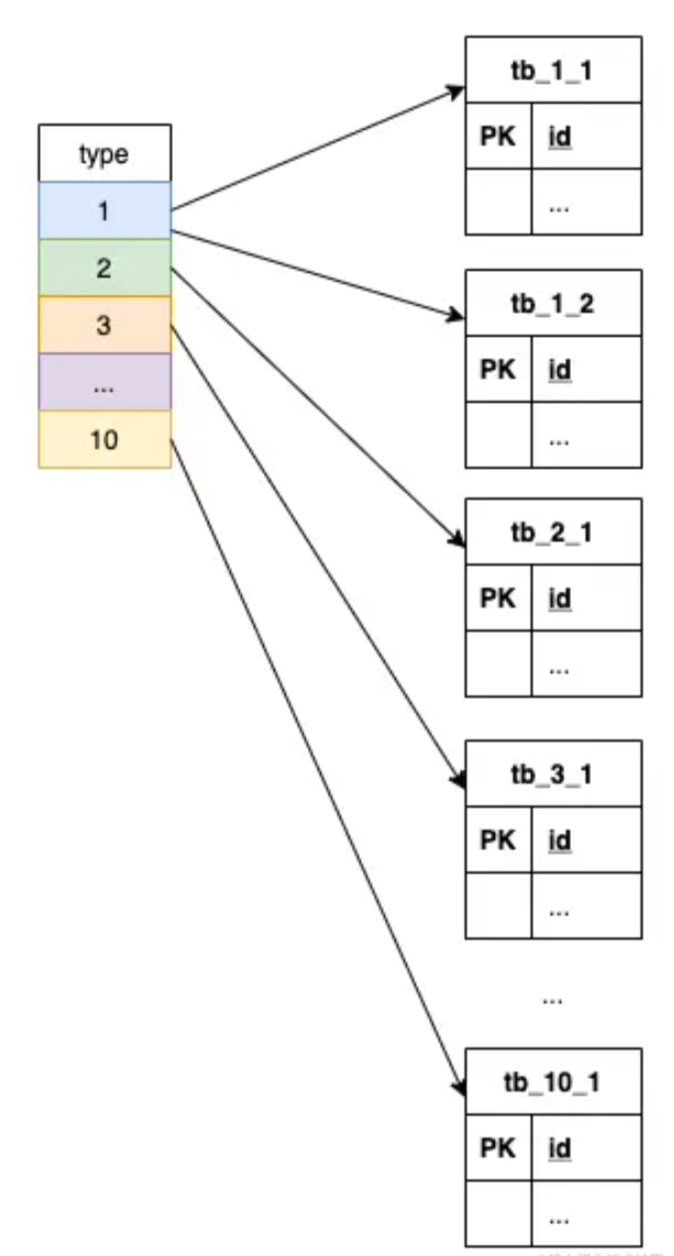

【缓存设计】记一种不错的缓存设计思路

文章目录 前言场景设计思路小结 前言

之前与同事讨论接口性能问题时听他介绍了一种缓存设计思路,觉得不错,做个记录供以后参考。

场景

假设有个以下格式的接口:

GET /api?keys{key1,key2,key3,...}&types{1,2,3,...}其中 keys 是业务…

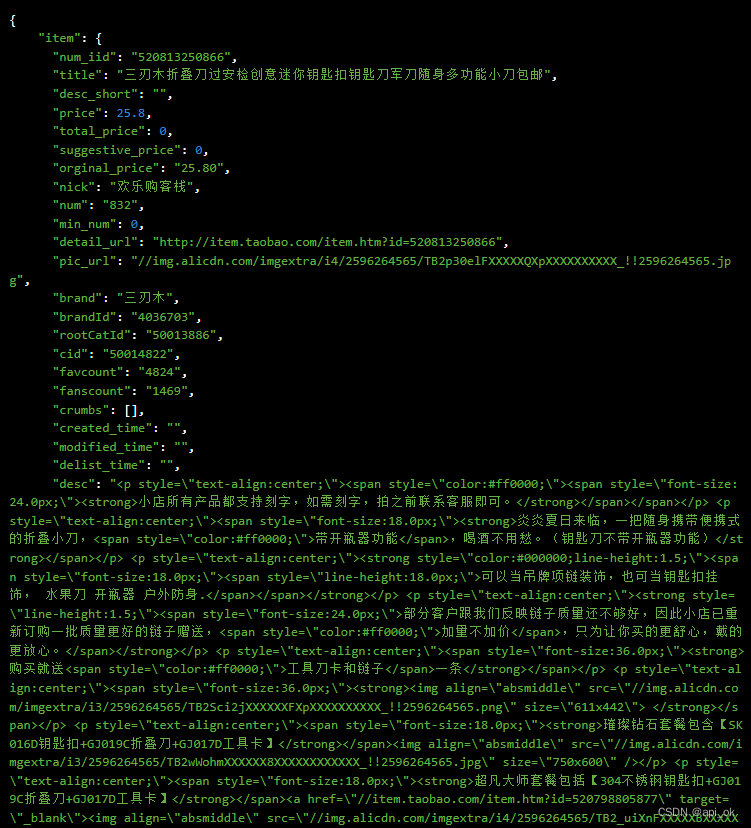

C语言“牵手”天猫商品详情数据方法,天猫商品详情API接口申请指南

天猫商城平台是阿里巴巴集团旗下的一个综合性购物网站。

天猫商城的前身是淘宝商城,于2012年1月11日上午更名。天猫是一个整合数千家品牌商、生产商,为商家和消费者之间提供一站式解决方案的B2C(Business-to-Consumer,商业零售&a…

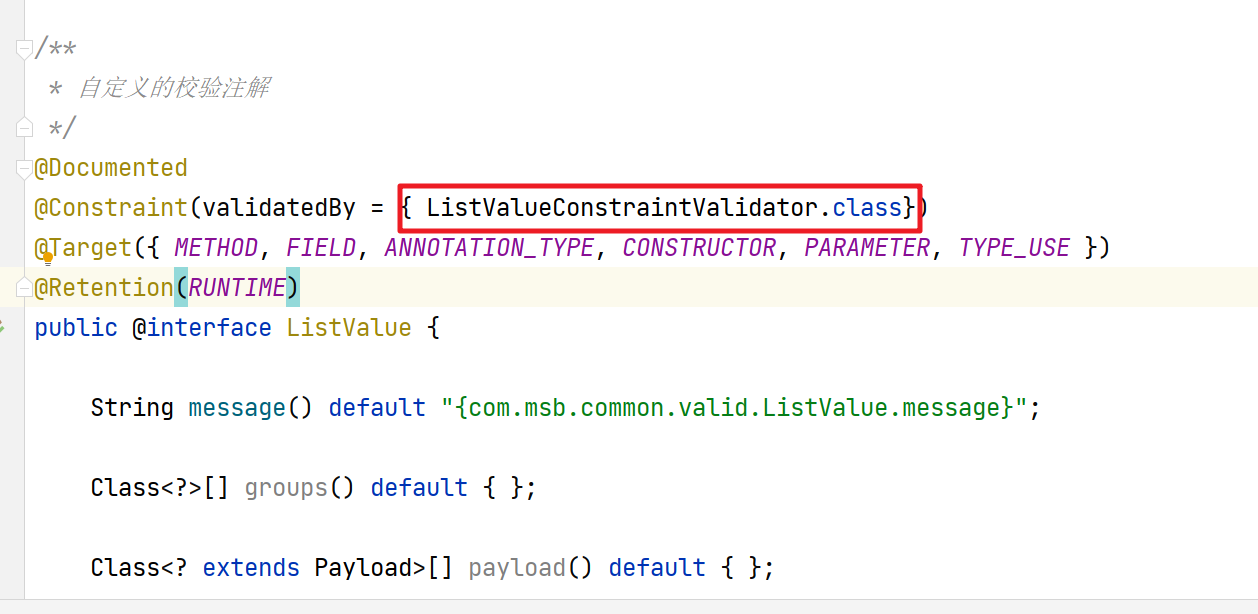

【业务功能篇78】微服务-前端后端校验- 统一异常处理-JSR-303-validation注解

5. 前端校验

我们在前端提交的表单数据,我们也是需要对提交的数据做相关的校验的

Form 组件提供了表单验证的功能,只需要通过 rules 属性传入约定的验证规则,并将 Form-Item 的 prop 属性设置为需校验的字段名即可 校验的页面效果 前端数据…

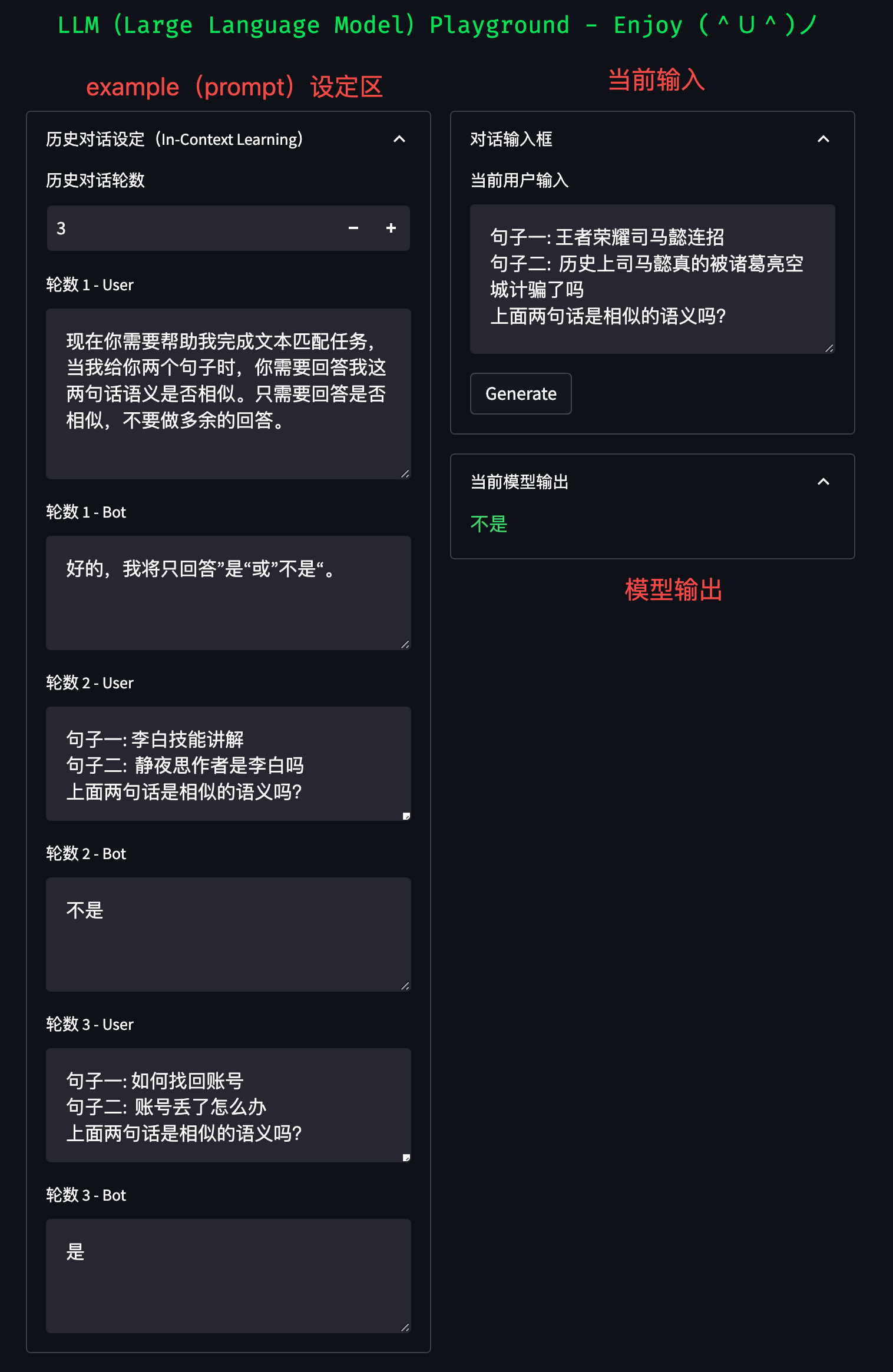

超越界限:大模型应用领域扩展,探索文本分类、文本匹配、信息抽取和性格测试等多领域应用

超越界限:大模型应用领域扩展,探索文本分类、文本匹配、信息抽取和性格测试等多领域应用

随着 ChatGPT 和 GPT-4 等强大生成模型出现,自然语言处理任务方式正在逐步发生改变。鉴于大模型强大的任务处理能力,未来我们或将不再为每…

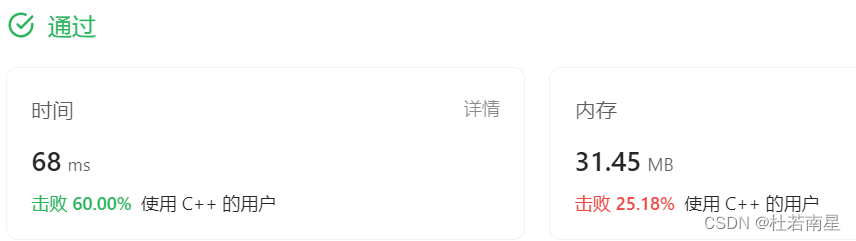

每天一道leetcode:542. 01 矩阵(图论中等广度优先遍历)

今日份题目:

给定一个由 0 和 1 组成的矩阵 mat ,请输出一个大小相同的矩阵,其中每一个格子是 mat 中对应位置元素到最近的 0 的距离。

两个相邻元素间的距离为 1 。

示例1 输入:mat [[0,0,0],[0,1,0],[0,0,0]]

输出ÿ…

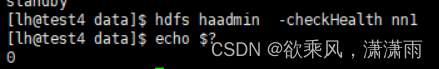

Hadoop HA模式切换

Hadoop HA模式下 主从的切换(操作命令)

YARN HA

获取所有RM节点的状态

yarn rmadmin -getAllServiceState获取 rm1 节点的状态

yarn rmadmin -getServiceState rm1手动将 rm1 的状态切换到STANDBY

yarn rmadmin -transitionToStandby rm1

##或者

y…

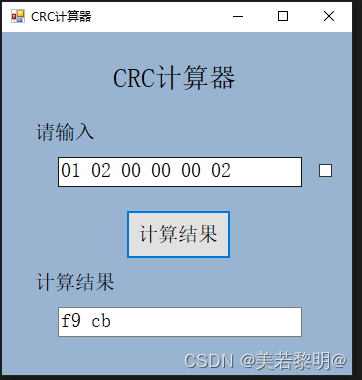

c# modbus CRC计算器(查表法)

一、简介:

本案例为crc计算器,通过查表法计算出结果

1.窗体后台源代码

using Crc;

using System;

using System.Collections.Generic;

using System.ComponentModel;

using System.Data;

using System.Drawing;

using System.Linq;

using System.Text…

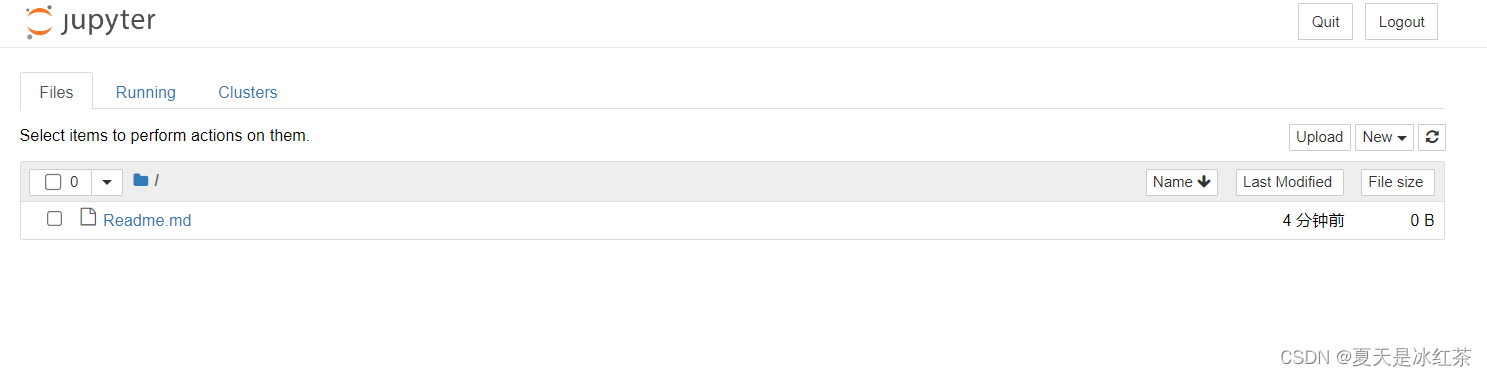

修改Jupyter Notebook默认打开路径

这里我是重新下载的anaconda,打开Jupyter之后是默认在C盘的一个路径的,现在我们就来修改一下它的一个默认打开路径,这样在我们后续学习过程中,可以将ipynb后缀的文件放在这个目录下就能查看了。 1、先打开Anaconda Prompt&#x…

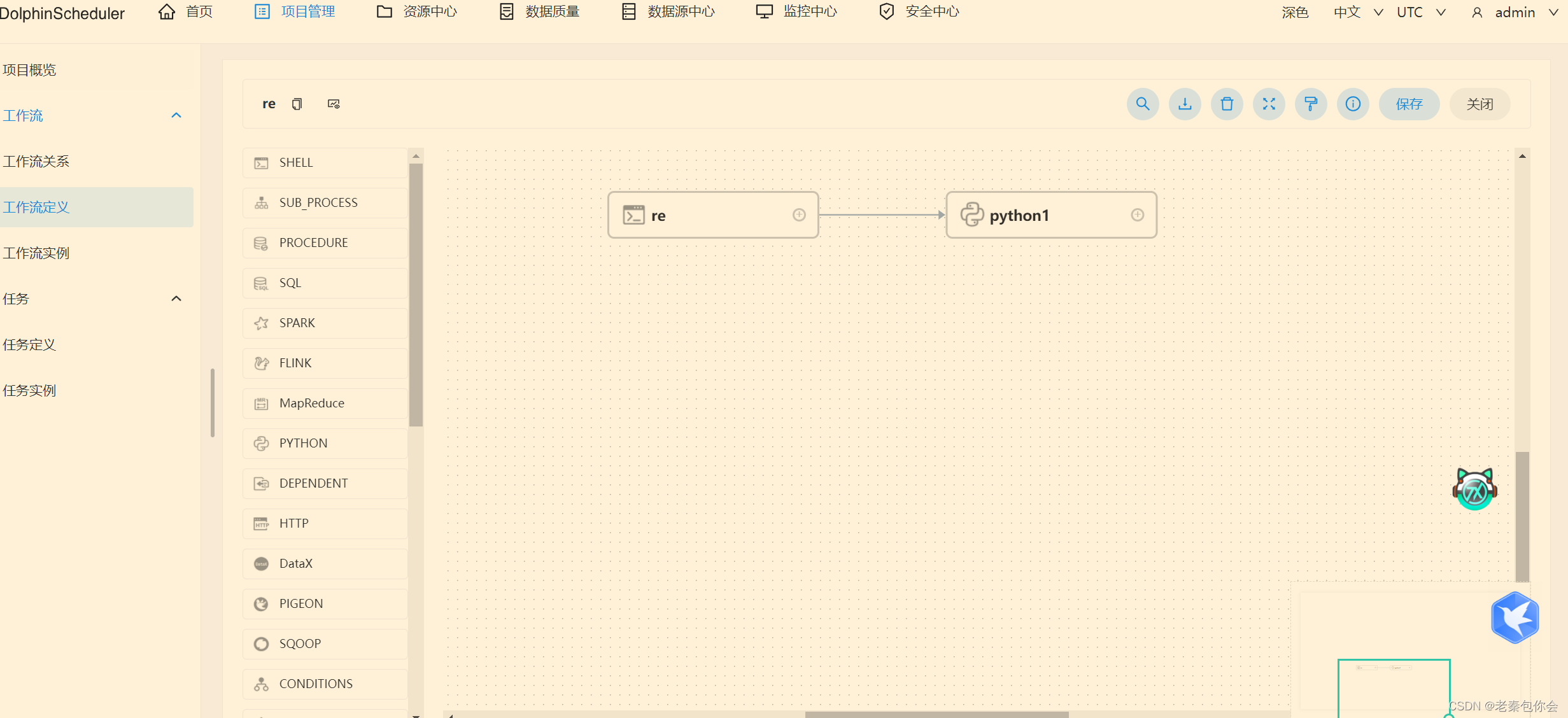

数据库第十七课-------ETL任务调度系统的安装和使用

作者前言 🎂 ✨✨✨✨✨✨🍧🍧🍧🍧🍧🍧🍧🎂 🎂 作者介绍: 🎂🎂 🎂 🎉🎉🎉…

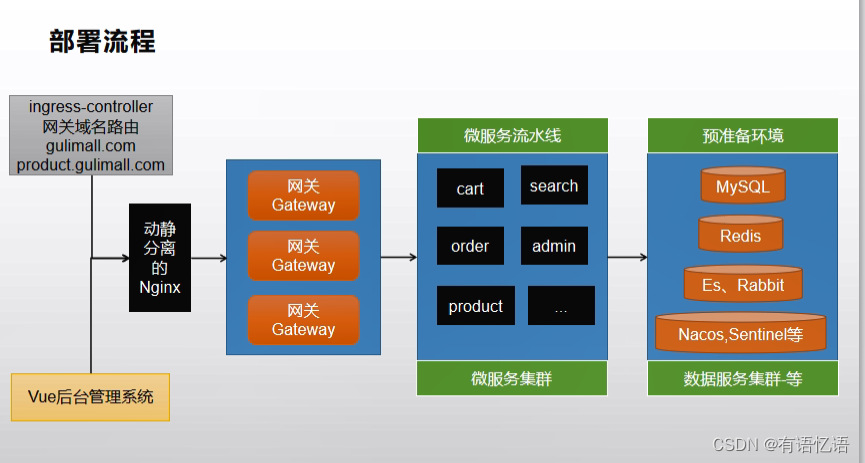

商城-学习整理-集群-K8S-集群环境部署(二十四)

目录 一、MySQL集群1、mysql集群原理2、Docker安装模拟MySQL主从复制集群1、下载mysql镜像2、创建Master实例并启动3、创建 Slave 实例并启动4、为 master 授权用户来同步数据1、进入 master 容器2、进入 mysql 内部 (mysql –uroot -p)3、查看 master 状…

脱离束缚:数字化工厂中ARM控制器的革命性应用!

近年来,中国数字经济体系已进入高速增长阶段。制造业作为中国经济高质量发展的重要支撑力量,在面临生产成本不断上涨、关键装备和核心零部件“受制于人”等挑战时,建设数字化工厂已成必然。

数字化工厂数据采集出现的问题

在数字工厂的建设…

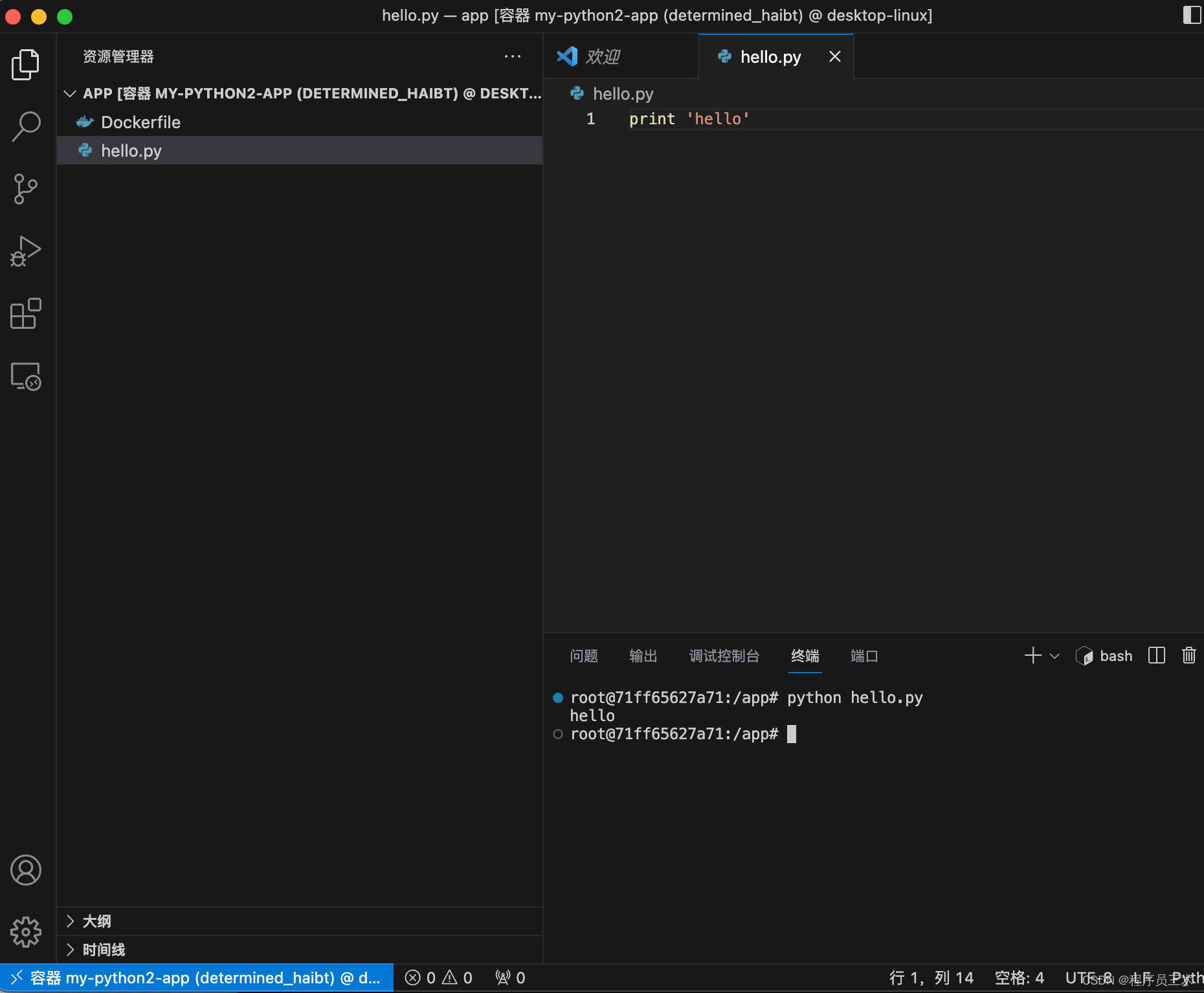

M1 Pro 利用docker 搭建pytho2的开发环境,以vscode连接开发为例

使用 M1 Pro (不支持python2的安装)开发,需要使用 Python 2.7 的环境,在使用 pyenv 安装 Python 2 时遇到了各种奇怪的问题。最终,我决定使用 Docker 搭建开发环境,并使用 VS Code 连接到本地容器。以下是详…

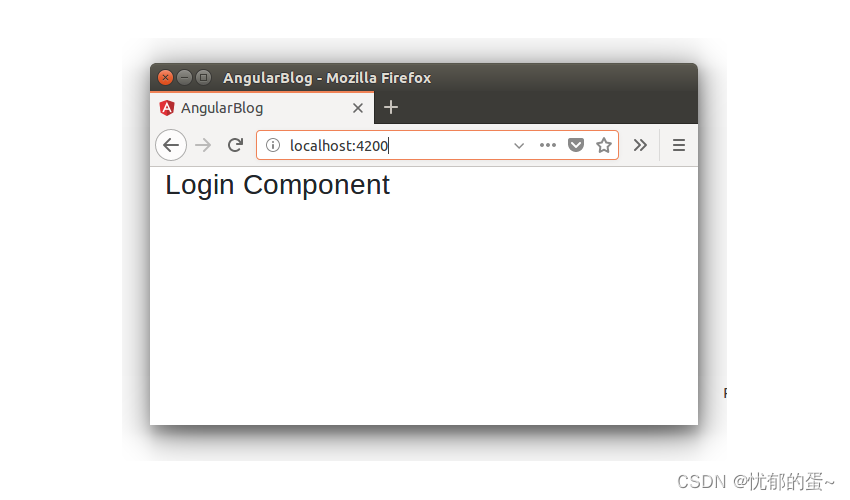

使用Angular和MongoDB来构建具有登录功能的博客应用程序

Angular 是一个一站式框架,用于使用相同的可重用代码创建移动和 Web 应用程序。使用 Angular,您可以将整个应用程序划分为可重用的组件,从而更轻松地维护和重用代码。

在本教程系列中,您将学习如何开始使用 Angular 和 MongoDB 作…

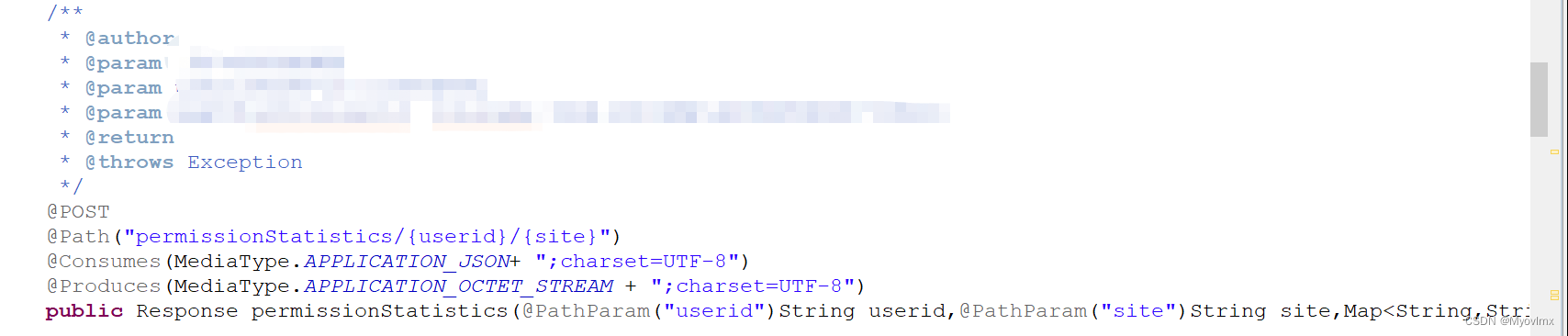

这是一条求助贴(postman测试的时候一直是404)

看到这个问题是404的时候总感觉不该求助大家,404多常见一看就是简单的路径问题,我的好像不是,我把我的问题奉上。

首先我先给出我的url

http://10.3.22.195:8080/escloud/rest/escloud_contentws/permissionStatistics/jc-haojl/sz

这是我…

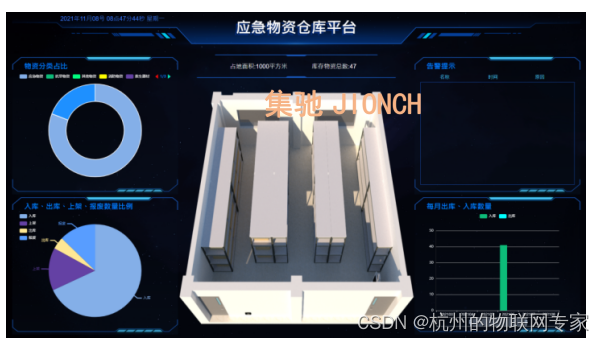

部队物资仓库管理系统|DW-S301是一套成熟系统

根据军队物资装备管理的实际需求,集驰电子设计了部队物资仓库管理系统(智装备:DW-S301)。

随着军事装备物资的使用频率与消耗数量日益增加,部队对于仓库保障工作的要求越来越高,同时也带来仓库管理工作任务…

Excel·VBA二维数组组合函数、组合求和

目录 1,二维数组组合函数举例 2,组合求和 之前的文章《ExcelVBA数组组合函数、组合求和》和《ExcelVBA数组排列函数》,都是针对一维数组的组合和排列 二维数组组合:对一个m行*n列的二维数组,每行抽取1个元素进行组合&a…