PPO算法

全称Proximal Policy Optimization,是TRPO(Trust Region Policy Optimization)算法的继承与简化,大大降低了实现难度。原论文

算法大致流程

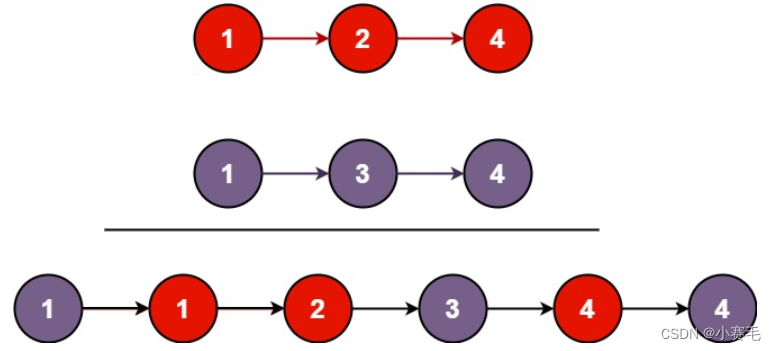

- 首先,使用已有的策略采样 N N N条轨迹,使用这些轨迹上的数据估计优势函数 A ^ t \hat{A}_t A^t,将 { s , a , r , s ′ , A ^ } \{s,a,r,s^\prime,\hat{A}\} {s,a,r,s′,A^}存入Buffer;

- 接着每次从Buffer里面随机抽样 B B B个样本,计算策略误差和值函数误差,更新两个网络参数,重复训练epochs次

- 最后清空Buffer

- 循环执行,直至达到比较好的效果

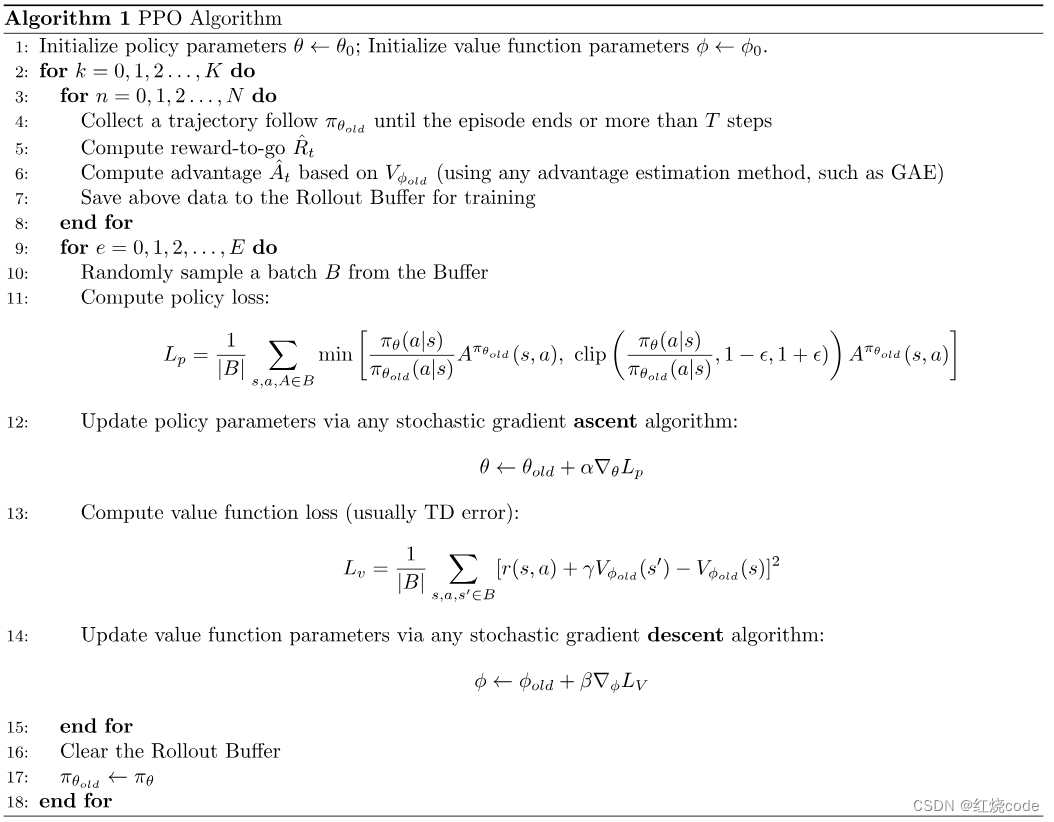

算法伪代码

C l i p \mathrm{Clip} Clip版本