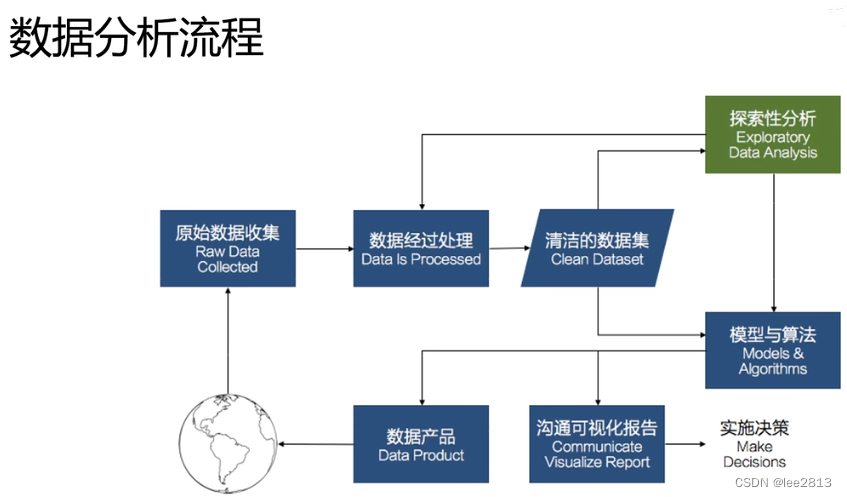

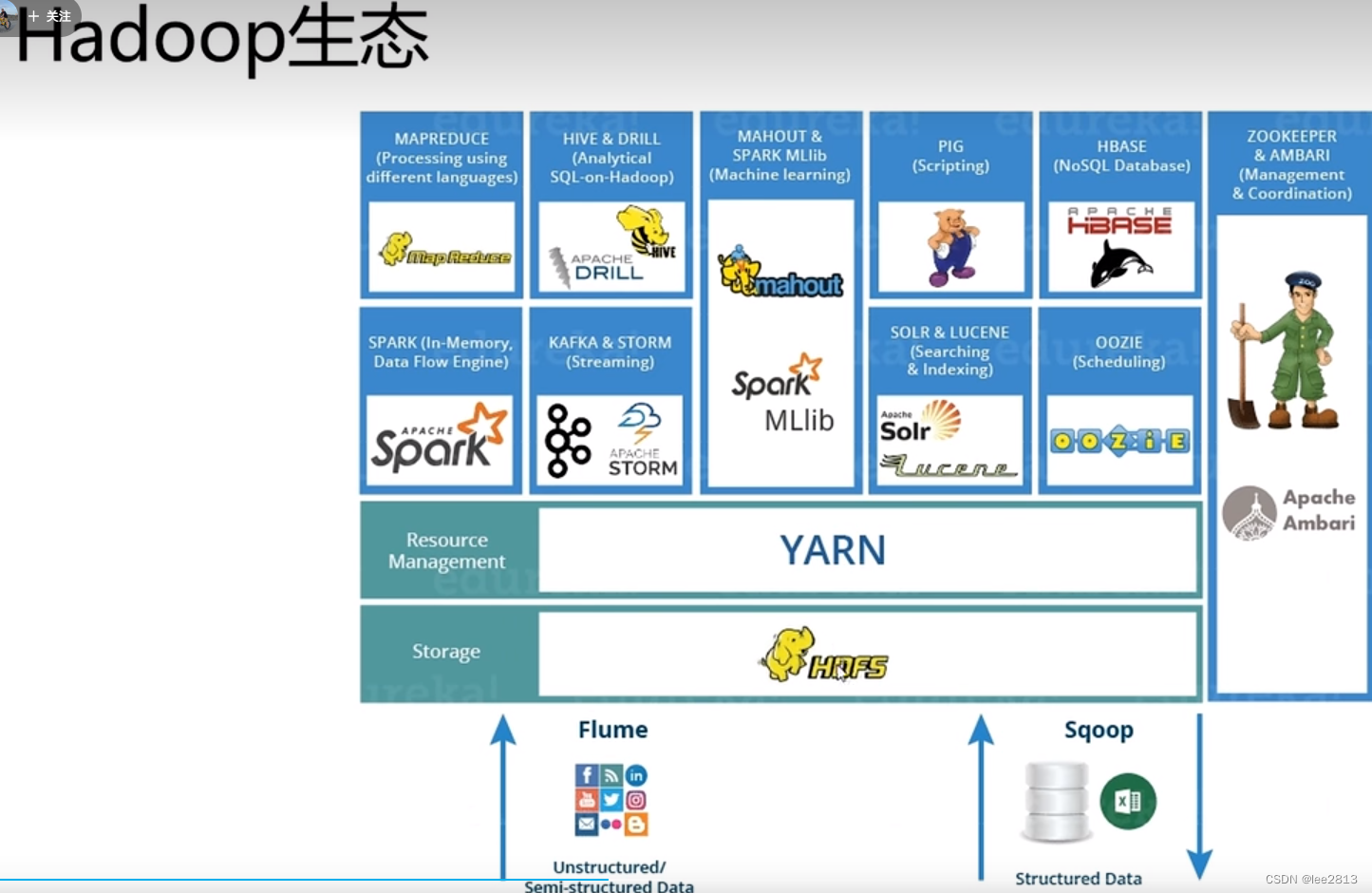

1.技术栈:Hadoop+Hive+Sqoop+Flume+Azkaban

- Flume采集Nginx web服务器上的日志,采集完成后存储到Hadoop的平台,最终存储到HDFS上,处理和分析采用Hive的方式,处理完之后利用Sqoop导出到Mysql中,最终利用一个JavaWeb的程序进行展现。

- 使用技术:

- 数据平台:Hadoop

- 数据处理分析:Hive

- 后端服务:SpringBoot + MyBatis

- 数据可视化:Vue+Echarts

- 数据迁移:Sqoop

- 日志采集:Flume

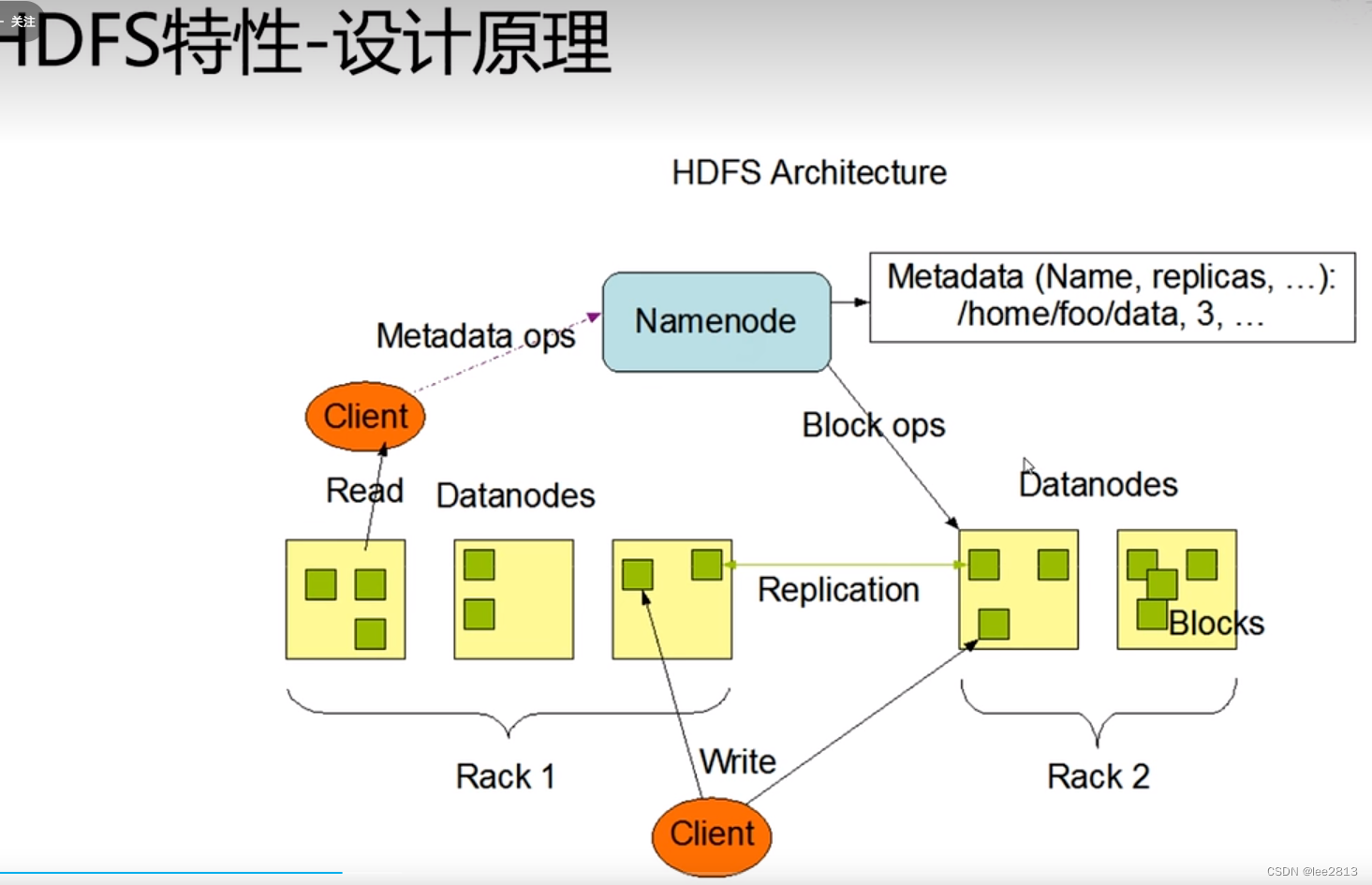

Hadoop 为用户提供了一个分布式基础架构,核心一个是HDFS分布式文件存储平台,一个是MapReduce。 - HDFS文件系统原理

- Namenode 记录原信息的路径信息

- Datanodes 存数据的

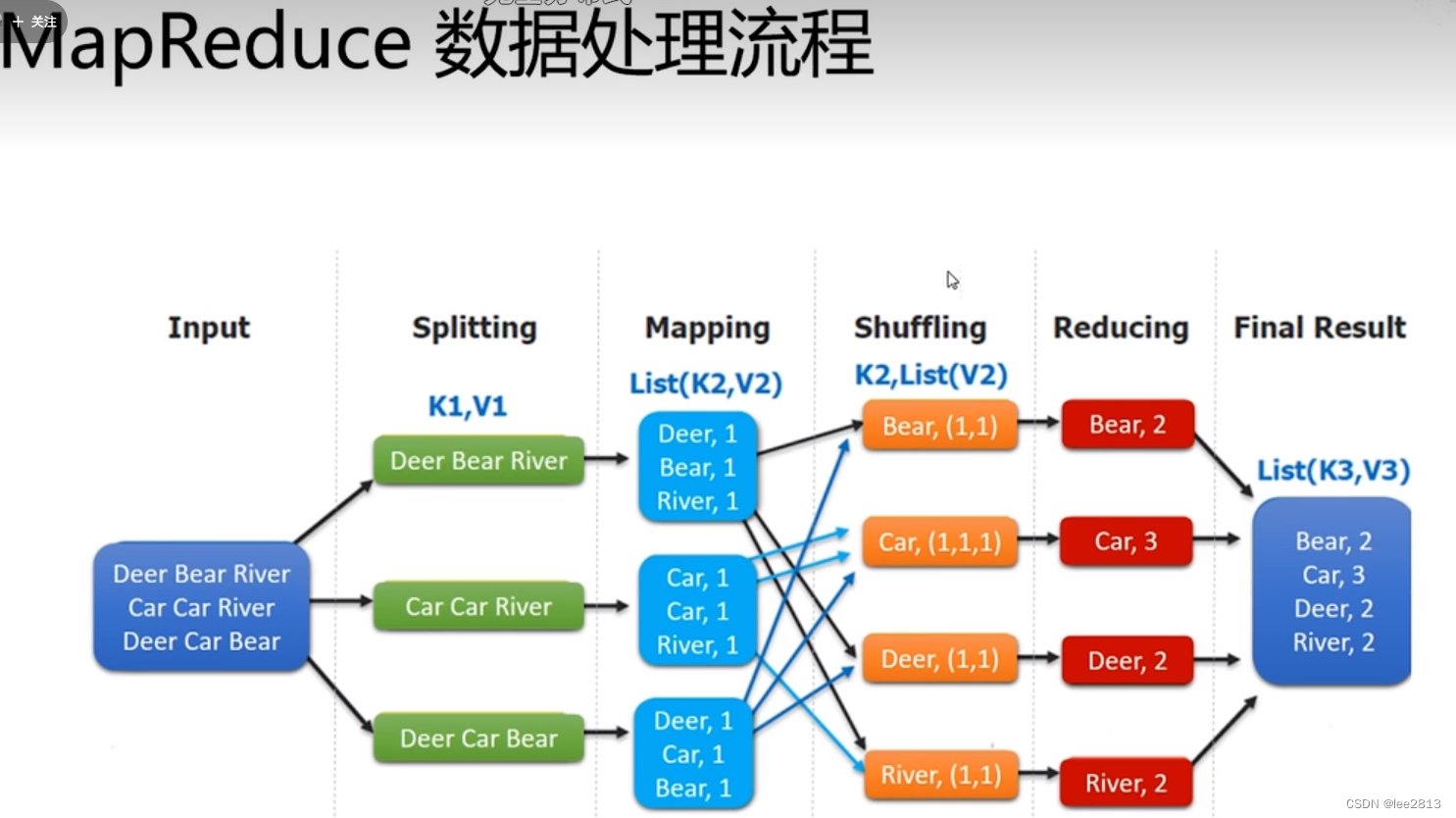

MapReduce对数据进行处理:切片,以键值对的方式来存储

- 分割

- 建立新键值对

- 合并相同的值为一个列表

- Spark 实时计算引擎

- Flume 数据采集

- Sqoop 数据传输与MySql

课程主要精力放在项目流程搭建,工具的使用,业务逻辑分析上

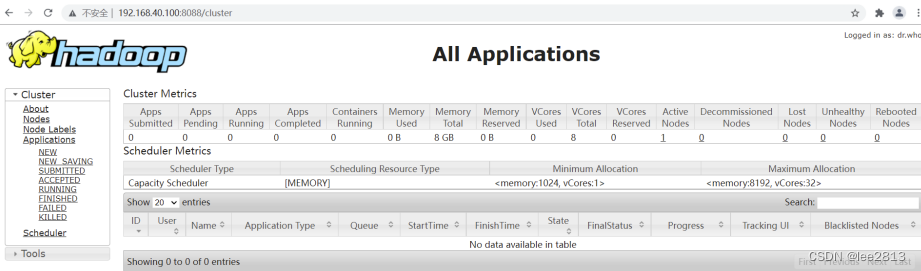

项目部署

采用伪分布式的形式,一台机器模拟多台机器,

部署完成

![[学习笔记]CS224W](https://img-blog.csdnimg.cn/768a721e1ca84f7e9b818f023b7cce74.png)