1.socket函数

int socket(int domain, int type, int protocol);

头文件:include<sys/types.h>,include<sys/socket.h>

参数

int domain

AF_INET: IPv4 Internet protocols

AF_INET6: IPv6 Internet protocols

AF_UNIX, AF_LOCAL : Local communication

- AF NETLINK:kernel user interface device

- AF_PACKET: low level packer interface

type

- SOCK_STREAM:流式接字 唯一对应TCP

- SOCK_DGRAM:数据包套接字,唯一对应UDP

- SOCK_RAM :原始套接字

protocol:

一般填0,原始套接字编程时需填充

返回值: 成功返回文件描述符,出错返回-1

socket函数对应于普通文件的打开操作。普通文件的打开操作返回一个文件描述字,而socket()用于创建 一个socket描述符 (socket descriptor),它唯一标识一个socket。这个socket描述字跟文件描述字一样,后续的操作都 有用到它,把它作为参 数,通过它来进行一些读写操作。创建socket的时候,也可以指定不同的参数创建不同的socket描述 符,socket函数的三个参数 分别为: domain:即协议域,又称为协议族(family)。常用的协议族有,AF_INET、AF_INET6、 AF_LOCAL(或称AF_UNIX, Unix域socket)、AF_ROUTE等等。协议族决定了socket的地址类型,在通信中必须采用对应的地址, 如AF_INET决定了 要用ipv4地址(32位的)与端口号(16位的)的组合、AF_UNIX决定了要用一个绝对路径名作为地址。 type:指定socket类型。常用的socket类型有,SOCK_STREAM、SOCK_DGRAM、SOCK_RAW、 SOCK_PACKET、 SOCK_SEQPACKET等等(socket的类型有哪些?)。 protocol:故名思意,就是指定协议。常用的协议有,IPPROTO_TCP、IPPTOTO_UDP、 IPPROTO_SCTP、 IPPROTO_TIPC等,它们分别对应TCP传输协议、UDP传输协议、STCP传输协议、TIPC传输协议,type 和protocol并不 是可以随意组合的,如SOCK_STREAM不可以跟IPPROTO_UDP组合。当protocol为0时,会自动选择 type类型对应的默 认协议。

2.bind绑定函数

int bind(

int sockfd,

struct sockaddr *my_addr,

int addrlen);

参数:

sockfd:通过socket()函数拿到的fd

addr:采用 struct socket的结构体地址

struct sockaddr ( //通用结构体

unsigned short sa_family; // 2个字

char sa_data[14]; // 14字节的协议地址

);

struct socket_in{ //基于socket通信结构体

sa family t sin family://两个字节

in_port_t sin_port; //两个字节

struct in_addr sin_addr;// 四个字节\

sin zero[8];//八位,填充字节,需清零

}

struct in_addr(

uint32_ts_addr; //32位网络字节序}

addrlen:地址长度

返回值:

成功返回0出错返回-1

当我们调用socket创建一个socket时,返回的socket描述字它存在于协议族(address family, AF_XXX)空间中,但没有一个 具体的地址。如果想要给它赋值一个地址,就必须调用bind()函数。通常服务器在启动的时候都会绑定 一个众所周知的地址(如 ip地址+端口号),用于提供服务,客户就可以通过它来接连服务器;而客户端就不用指定,由系统自动 分配一个端口号和自身 的ip地址组合。这就是为什么通常服务器端在listen之前会调用bind(),而客户端就不会调用,而是在 connect()时由系统随机生 成一个。当然客户端也可以在调用connect()之前bind一个地址和端口,这样就能使用特定的IP和端口来 连服务器了。

int bind(int sockfd, const struct sockaddr *addr, socklen_t addrlen)

函数的三个参数分别为:

sockfd:即socket描述字,它是通过socket()函数创建了,唯一标识一个socket。bind()函数就是将给这 个描述字绑定一 个名字。

addrlen:对应的是地址的长度。

addr:一个const struct sockaddr *指针,指向要绑定给sockfd的协议地址。

这个地址结构根据地址创 建socket时的地 址协议族的不同而不同,但最终都会强制转换后赋值给sockaddr这种类型的指针传给内核:

通用套接字 sockaddr 类型定义:

ipv4对应的是sockaddr_in类型定义:

ipv4对应的是sockaddr_in类型定义:

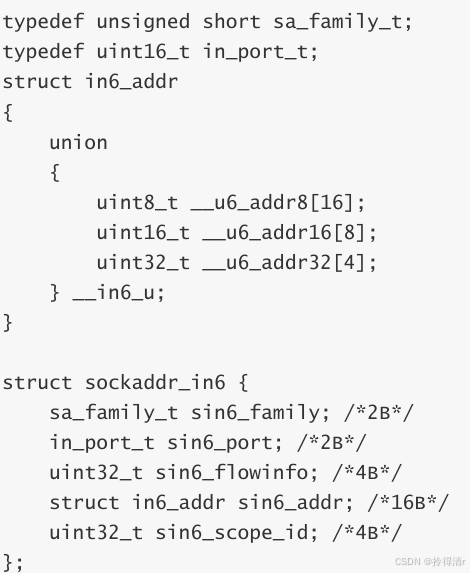

ipv6对应的sockaddr_in6类型定义:

网络字节序和主机字节序

主机字节序就是我们平常说的大端和小端模式:不同的CPU有不同的字节序类型,这些字节序是指整数 在内存中保存的顺序,

主机字节序就是我们平常说的大端和小端模式:不同的CPU有不同的字节序类型,这些字节序是指整数 在内存中保存的顺序, 这个叫做主机序。引用标准的Big-Endian和Little-Endian的定义如下: a) Little-Endian就是低位字节排放在内存的低地址端,高位字节排放在内存的高地址端。 b) Big-Endian就是高位字节排放在内存的低地址端,低位字节排放在内存的高地址端。

网络字节序:4个字节的32 bit值以下面的次序传输:首先是0~7bit,其次8~15bit,然后16~23bit, 最后是24~31bit。这 种传输次序称作大端字节序。由于TCP/IP首部中所有的二进制整数在网络中传输时都要求以这种次序, 因此它又称作网络字节 序。字节序,顾名思义字节的顺序,就是大于一个字节类型的数据在内存中的存放顺序,一个字节的数 据没有顺序的问题了。 所以: 在将一个地址绑定到socket的时候,请先将主机字节序转换成为网络字节序,再赋给socket。

serv_addr.sin_port = htons(LISTEN_PORT);

serv_addr.sin_addr.s_addr = htonl(INADDR_ANY);

这里通过调用两个函数 htons() 和 htolnl() 分别用来将 端口和IP地址转换成网络字节序,这两个函数名 中的 h表示host, n表 示network, s表示short(2字节/16位), l表示long(4字节/32位)。因为端口号是16位的,所以我们用 htons()把端口号从主机字节 序转换成网络字节序, 而IP地址是32位的,所以我们用htonl()函数把IP地址从主机字节序转换成网络字 节序。INADDR_ANY 就是指定地址为0.0.0.0的地址,这个地址事实上表示不确定地址,或“所有地址”、“任意地址”。 一般来说,在各个系统中均 定义成为0值。这里也就意味着监听所有的IP地址。

3.listen()函数

int listen(int sockfd, int backlog);

参数:

sockfd:通过socket()函数拿到的fd;

backLog:同时允许几路客户端和服务器进行正在连接的过程(正在三次握手),一般填5。

内核中服务器的套接字fd会维护2个链表

1.正在三次握手的客户端链表(数量=2*backlog+1)

2.已经建立好连接的客户端链表(已经完成三次握手分配好了的newfd)

返回值:

成功返回0

出错返回-1

listen(fd, 5);//表示系统允许11 (2*5+1)个客户端同时进行三次握手

4.accept()函数

阻塞等待客户端连接请求

int accept(int sockfd, struct sockaddr *addr, socklen_t *addrlen);

参数

sockfd:经过前面socket()创建并通过bind(),listen()设置过的fd

addr:指向存放地址信息的结构体的首地址(获取客户端IP地址和端口号)

addrlen:存放地址信息的结构体的大小

返回值

成功,返回返回已经建立连接的新的newfd

出错, 返回-1

服务器代码

#include <stdio.h>

#include <stdlib.h>

#include <string.h>

#include <unistd.h>

#include <sys/types.h>

#include<sys/socket.h>

#include <strings.h>

#include <arpa/inet.h>

#define QUIT_STR "QUIT”

#define BUFSIZE 1024

#define BACKLOG 5

#define SERV_IP 5001

#define SERV IP ADDR "192.168.182.144"

int main()

{int fd = -1;struct sockaddr_in sin;//1.socketfd = socket(AF_INET, SOCK_STREAM, 0);if(fd <0){perror(“socket");exit(1);}bzero(&sin, sizeof(sin));sin.sin family = AF_INET;sin.sin port = htons(SERV IP);sin.sin addr.s addr = inet addr(SERV IP ADDR);/*if(inet_pton(AF_INET, SERV_IP_ADDR,(votd *)&stn.sin_addr.s_addr) != 1)perror("inet_pton");exit(1);*///2.bindif(bind(fd, (struct sockaddr *)&sin, sizeof(sin)) <0){perror("bind");exit(1)}//3.listenif(listen(fd, BACKLOG) <0){perror("Listen");exit(1);}//4.acceptint newfd = -1;newfd = accept(fd, NULL, NULL);if(newfd <0){perror("accept");exit(1);}char buf[BUFSIZE];int ret = -1;//readwhile(1){do{bzero(buf, BUFSIZE);ret = read(newfd, buf, BUFSIZE-1);}while(ret <1);if(ret <0){exit(1);}if(!ret){break;}printf("receive data:%s\n", buf);if(!strncasecmp(buf, QUIT_STR, strlen(QUIT_STR))){printf("Client is exiting!\n");break;}}

close(newfd);

close(fd);

return 0;

5.客户端连接函数connect()

int connect (int[sockfd, struct sockaddr * serv_addr, int addrlen)

参数:

sockfd:通过socket()函数拿到的fd

addr:struct sockaddr的结构体变量地址

addrlen:地址长度

返回值:

成功,返回0

失败,返回-1

客户端代码

#include <stdio.h>

#include <string.h>

#include <strings.h>

#include <unistd.h>

#include <sys/types.h>

#include <sys/socket.h>

#include <arpa/inet.h>

#define QUIT_STR "QUIT"

#define BUFSIZE 1024

#define SERV_PORT 5001

#define SERV_IP_ADDR "192.168.182.144”

int main()

{int fd = -1;struct sockaddr_in sin;fd = socket(AF_INET, SOCK_STREAM, Gif(fd <0){perror("socket");exit(1);}bzero(&sin,sizeof(sin));sin.sin family = AF_INET;sin.sin port = htons(SERV_PORT);sin.sin_addr.s _addr= inet_addr(SERV_IP_ADDR);if(connect(fd, (struct sockaddr*)&sin, sizeof(sin))<0){perror("connect");exit(1);}char buf[BUFSIZE];while(1){bzero(buf, BUFSIZE);if(fgets(buf, BUFSIZE-1, stdin) == NULL){continue;}write(fd, buf, strlen(buf));if(!strncasecmp(buf, QUIT_STR, strlen(QUIT_STR))){break;}return 0;

}TCP服务获取客户端IP地址

#include <stdio.h>

#include <stdlib.h>

#include <string.h>

#include <unistd.h>

#include <sys/types.h>

#include<sys/socket.h>

#include <strings.h>

#include <arpa/inet.h>

#define QUIT_STR "QUIT”

#define BUFSIZE 1024

#define BACKLOG 5

#define SERV_IP 5001

#define SERV IP ADDR "192.168.182.144"

int main()

{int fd = -1;struct sockaddr_in sin;//1.socketfd = socket(AF_INET, SOCK_STREAM, 0);if(fd <0){perror(“socket");exit(1);}bzero(&sin, sizeof(sin));// sin.sin family = AF_INET;sin.sin port = htons(SERV IP);//sin.sin addr.s addr = inet addr(SERV IP ADDR);sin.sin addr.s addr =ADDR_ANY;/*if(inet_pton(AF_INET, SERV_IP_ADDR,(votd *)&stn.sin_addr.s_addr) != 1)perror("inet_pton");exit(1);*///2.bindif(bind(fd, (struct sockaddr *)&sin, sizeof(sin)) <0){perror("bind");exit(1);}//3.listenif(listen(fd, BACKLOG) <0){perror("Listen");exit(1);}//4.accept/*int newfd = -1;newfd = accept(fd, NULL, NULL);if(newfd <0){perror("accept");exit(1);}*/int newfd = -1;struct sockaddr _in cin;socklen_t addrlen = sizeof(cin);newfd = accept(fd, (struct sockaddr *)&cin, &addrlen);if(newfd <0){perror("accept");exit(1);}char ipv4_addr[16];if(!inet_ntop(AF_INET, (void *)&cin.sin _addr, ipv4_addr, sizeof(cin))){perror("inet_ntop");exit(1);}printf("Clint:(%s, %d)is connect!\n", ipv4 addr, ntohs(cin.sin_port));char buf[BUFSIZE];int ret = -1;//readwhile(1){do{bzero(buf, BUFSIZE);ret = read(newfd, buf, BUFSIZE-1);}while(ret <1);if(ret <0){exit(1);}if(!ret){break;}printf("receive data:%s\n", buf);if(!strncasecmp(buf, QUIT_STR, strlen(QUIT_STR))){printf("Client is exiting!\n");break;}}

close(newfd);

close(fd);

return 0;

![(脚本学习)BUU18 [CISCN2019 华北赛区 Day2 Web1]Hack World1](https://i-blog.csdnimg.cn/direct/941ce77a5cd545708dbb785d6084d381.png)