概述

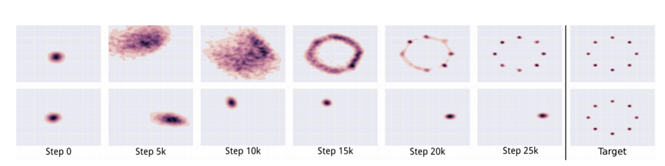

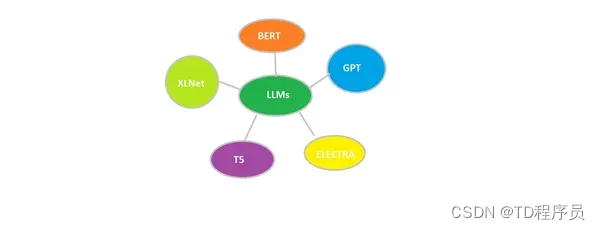

随着我们深入研究参数高效微调 (PEFT) 的世界,了解这种变革性方法背后的驱动力和方法变得至关重要。在本文中,我们将探讨 PEFT 方法如何优化大型语言模型 (LLM) 对特定任务的适应。我们将揭开 PEFT 的优点和缺点,深入研究 PEFT 技术的复杂类别,并破译两种卓越技术的内部工作原理:低秩适应(LoRA)和量化低秩适应(QLoRA)。本次旅程旨在让您全面了解这些技术,使您能够利用它们的力量来进行语言处理。

学习目标:

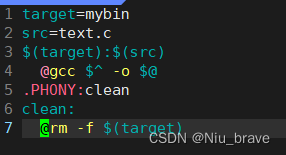

- 了解 NLP 中预训练语言模型和微调的概念。

- 探索微调大型模型时计算和内存要求带来的挑战。

- 了解参数高效微调 (PEFT) 技术