目录

1.作者提出的问题及解决方向

2.延深-用如何用强化学习对机器人进行控制

2.1思路

2.2DQN和DDPG在机器人控制中的应用

3.解决方案

3.1思路

3.2实验

3.3创新点

4.展望

1.作者提出的问题及解决方向

目的:使机械臂在非结构化环境下实现端到端的自主学习控制,

问题:基于深度强化学习算法结合视觉图像与运动学模型完成机械臂抵达目标区域任务,但稀疏奖励环境下机械臂运动控制算法存在探索效率低、学习速度慢、样本利用率低等问题。

解决:

①(解决样本利用率低)提出了一种结合重要性采样的机械臂运动控制方法,增大了有效样本的采样概率,提高了样本的利用率。

②(理论上奖励函数决定算法收敛速度和程度)提出了一种运动学奖励驱动的机械臂控制方法。基于机械臂运动学分析,通过解析法求解关节逆解值,以最小功率作为目标引导。从稀疏奖励、距离奖励和运动学奖励三个方面改进设计了奖励函数。

2.延深-用如何用强化学习对机器人进行控制

2.1思路

机械臂运动控制的策略网络本质是环境状态到机械臂动作的映射,环境状态通常包括目标物体的位置、形状大小,机械臂各关节的当前转角,以及机械臂抓手末端的空间坐标和相对姿态等,将环境状态输入到策略网络,由其决策输出机械臂各关节的应运动控制量(角度,速度,加速度,力矩等),机械臂不断重复探索-决策-执行过程,最终抵达目标区域。

2.2DQN和DDPG在机器人控制中的应用

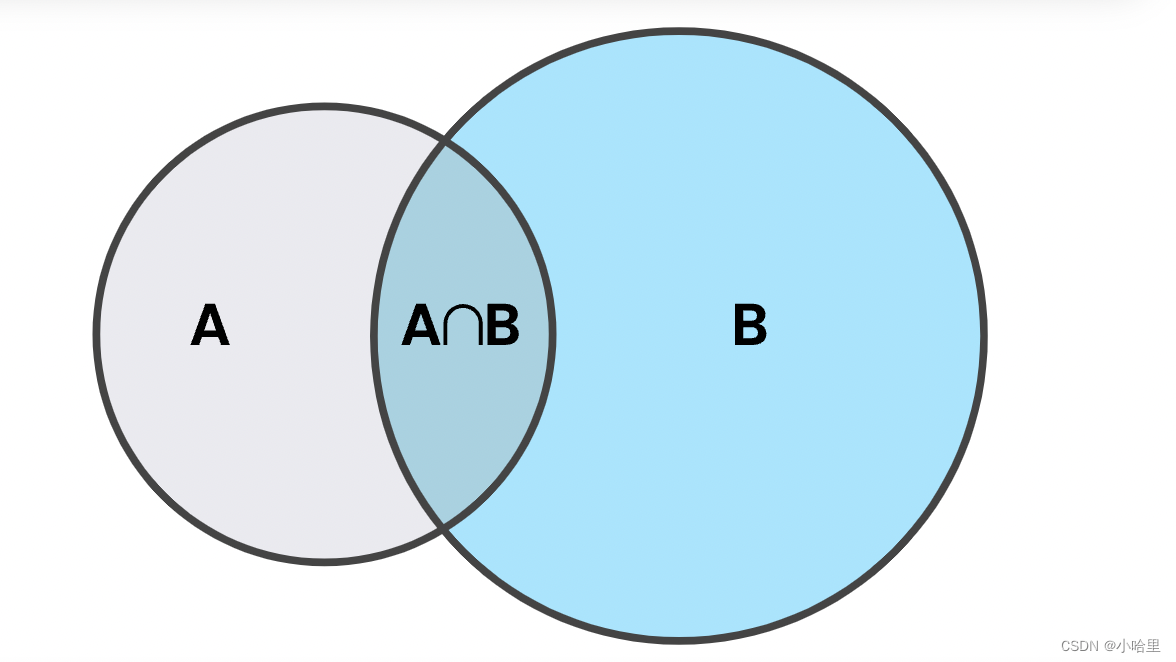

DQN:本研究机械臂控制方法基于深度确定性策略梯度算法,其以深度Q网络DQN算法为基础,引入了Actor-Critic 框架思路。DQN算法的动作空间为有限个动作构成,依靠计算每一个动作的Q值选择最大Q值对应的动作,其网络输出是离散的动作价值分布,无法处理连续控制性问题。

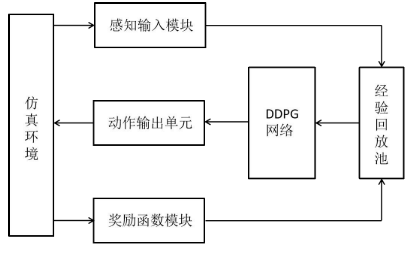

DDPG:而DDPG算法利用Actor 网络去拟合某状态下选择某动作时能获得的Q值,找到该状态下最大 Q 值对应的动作,输出的是确定性动作,因此能够用来处理连续控制性问题。Actor 网络也称为策略网络,将当前状态通过策略网络输出动作;Critic 网络对学习的策略进行评估,反过来利用策略优势训练Actor 策略网络,使累计回报价值最大。

3.解决方案

3.1思路

①重要性采样替代随机采样:传统在经验池进行数据采样用的是随机采样方法,可以保证经验池中每个样本都有同样的几率用于训练,作者认为。对于稀疏奖励环境的机械臂运动控制任务场景,获取的数据质量参差不齐,随机采样效果不佳,重要性采样给每个样本设定一个可动态更新的优先级,依照该样本的优先级占总优先级的比例确定该样本的被采样概率,效果更加。

②引入运动学逆解改进奖励函数:每次执行完动作后都要计算当前机械臂关节角相对于最终期望角度的差距。

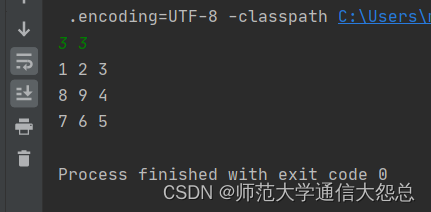

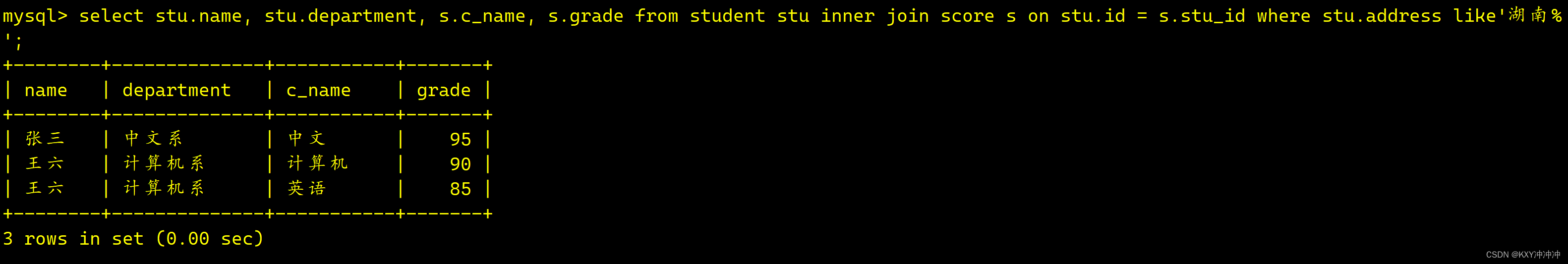

3.2实验

①在二维仿真实验中从平均奖励、平均步数和成功率三个标准分析了改进方法的效果,验证方法的可行性和有效性。

②在三维仿真环境下使用综合改进算法测试分析了随机目标模型和固定目标模型的效果。

3.3创新点

①采样:重要性采样替代随机采样

②奖励函数:引入运动学奖励(计算当前机械臂关节角相对于最终期望角度的差距,此处是因为作者认为单纯的距离无法完全涵盖探索过程),以及常用的稀疏奖励 、距离奖励、单步奖励(描述相邻两步探索相对目标的距离变化情况 )

4.展望

问题:算法探索效率低、学习速度慢、样本利用率低

①样本利用效率低:不同的应用场景可能会有更加合适的采样方法。

②学习速率慢:结合实际情况改进奖励函数